支持接入 Hive 去创建数据集。

在连接数据之前,请收集以下信息:

- 数据库所在服务器的 IP 地址和端口号;

- 数据库的用户名和密码。

2.1 从数据连接新建

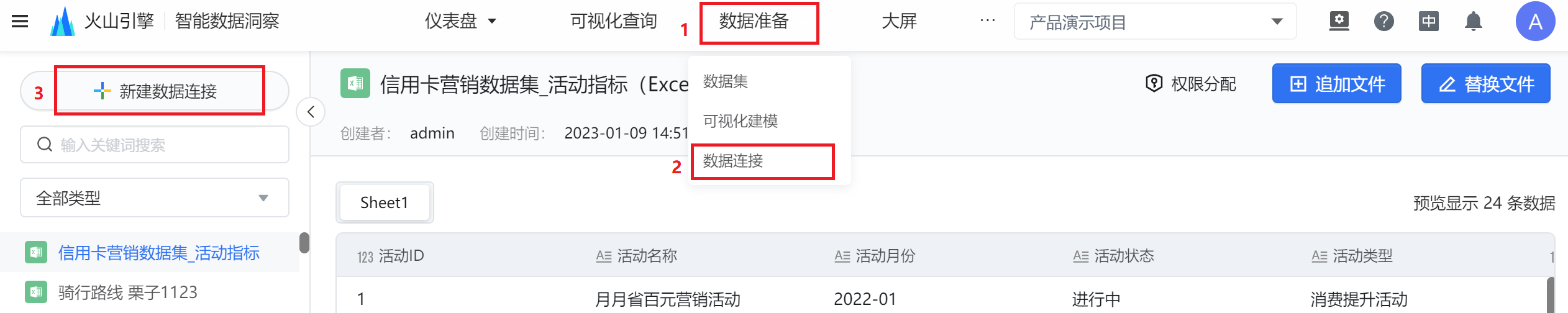

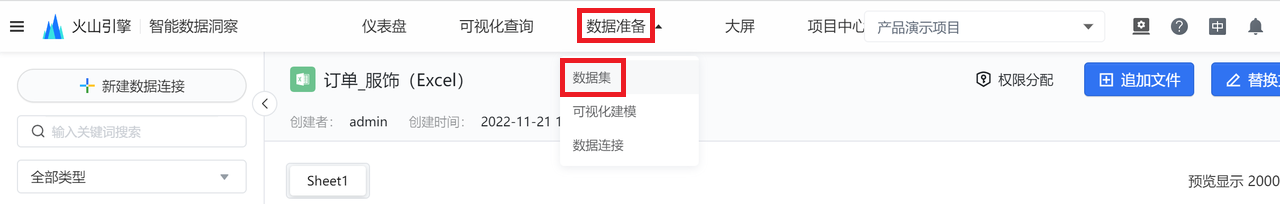

(1)进入火山引擎,点击进入到某个具体项目下,点击数据准备,在下拉列表找到数据连接,点击数据连接。

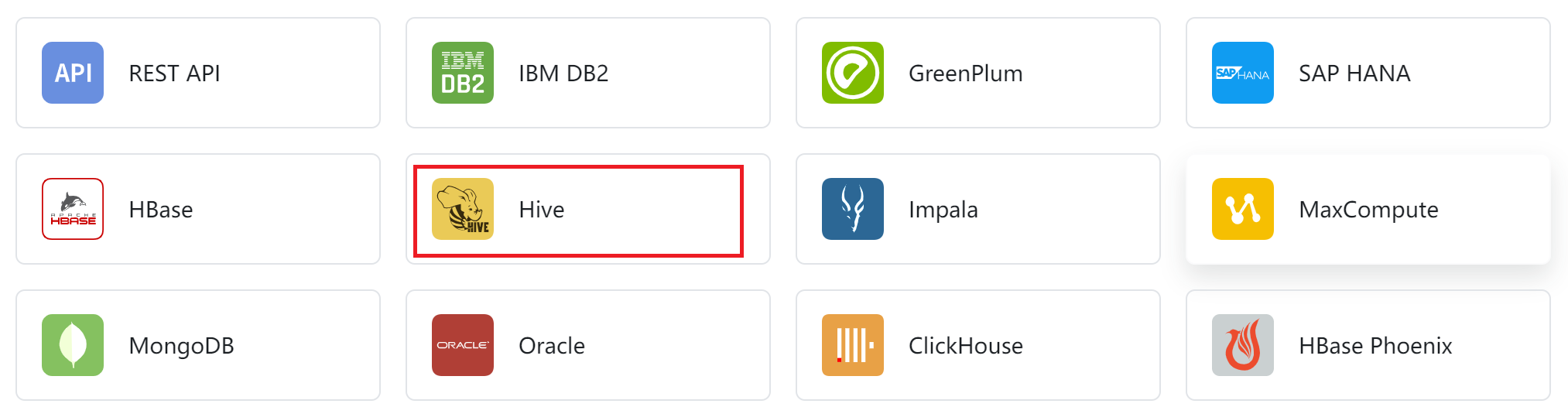

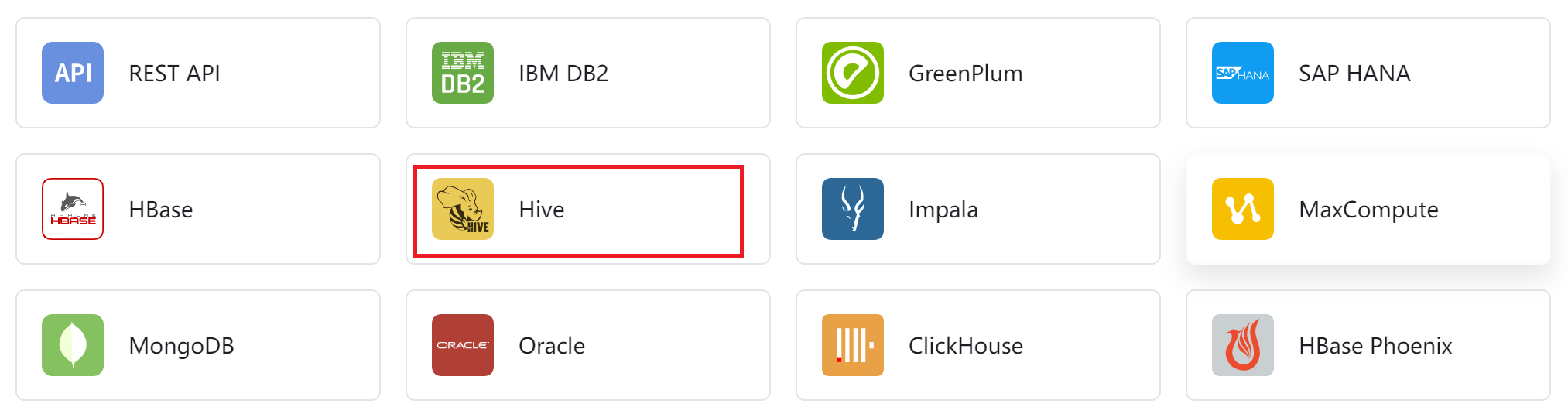

(2)在页面中选择 Hive。

(3)填写所需的基本信息,并进行测试连接,连接成功后点击保存。

(4)确认数据连接的基本信息无误后即完成数据连接。

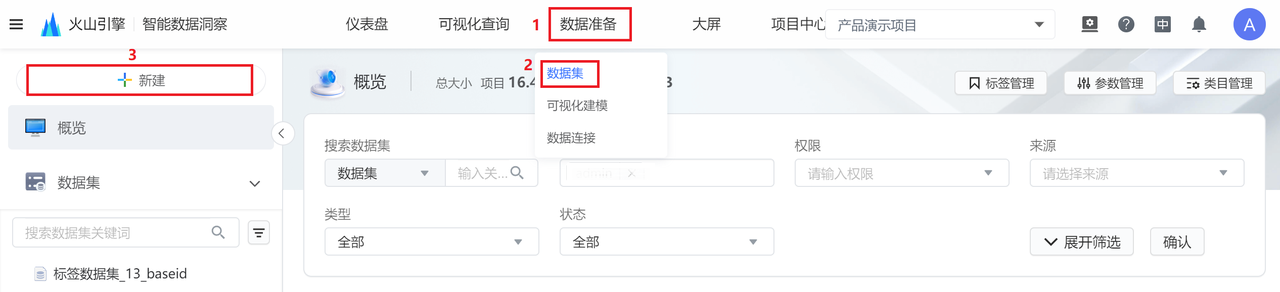

(5)可使用该连接作为数据源去创建数据集:点击数据准备-->数据集,选择左上角「新建」按钮进行数据集的新建。

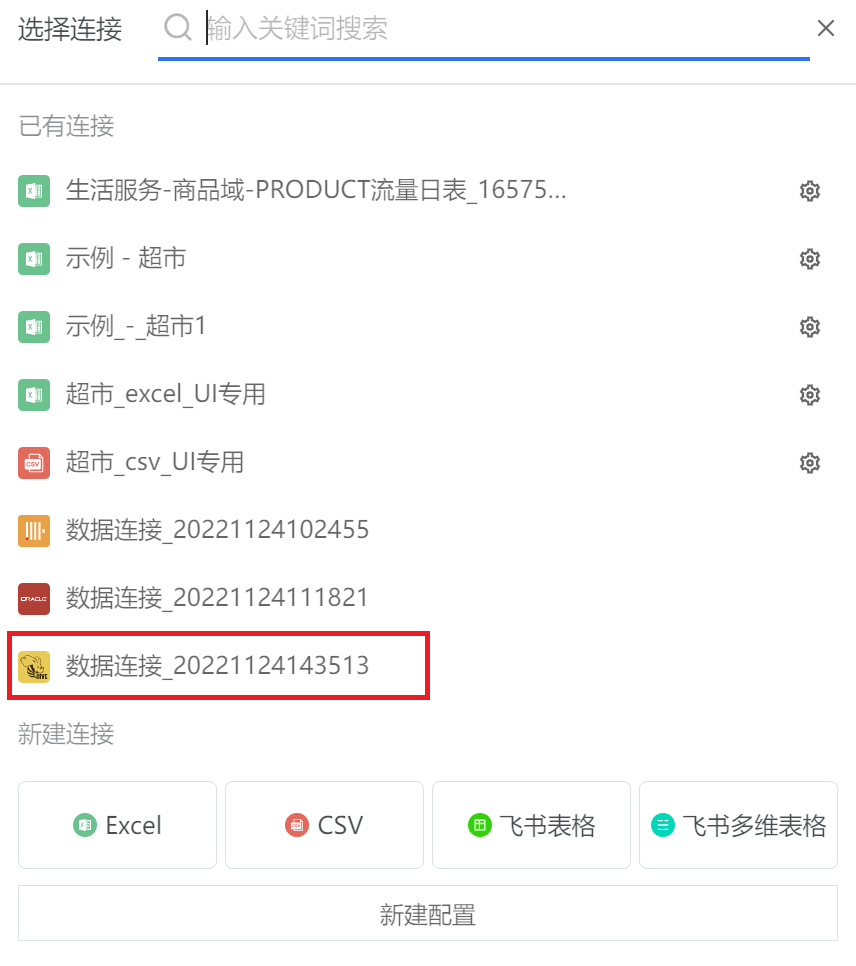

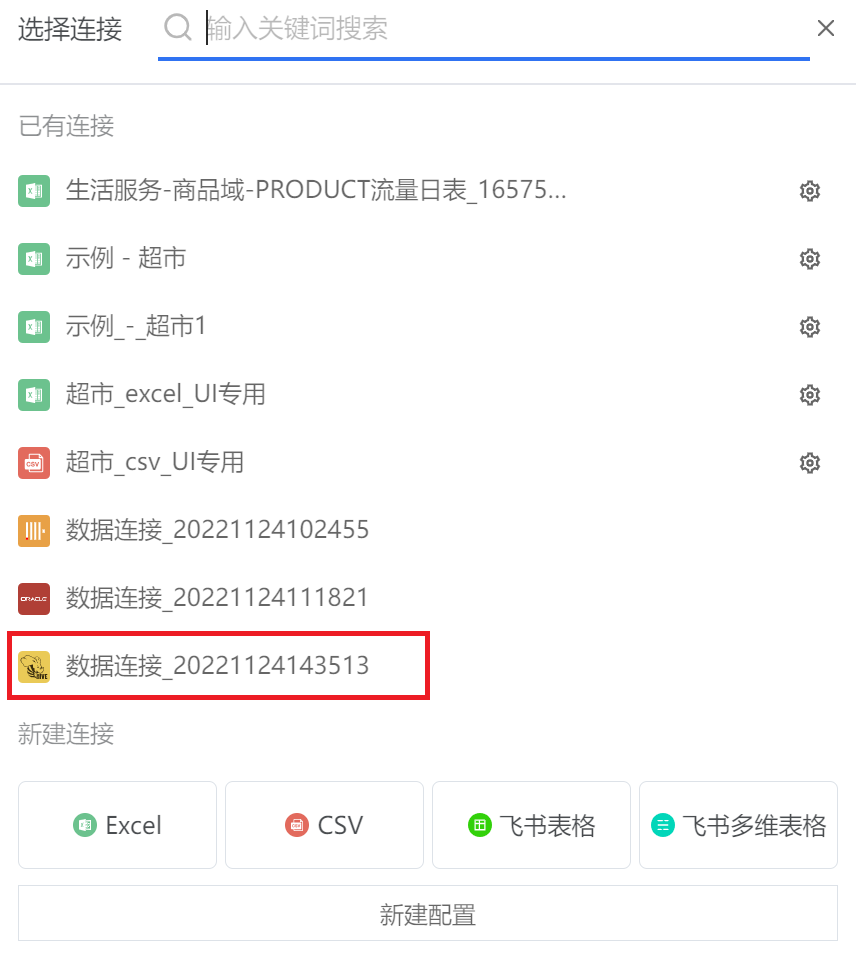

(6)搜索或下拉已有连接,选择之前新建好的数据源。

2.2 从数据集新建

(1)进入火山引擎,点击数据准备-->数据集,选择左上角「新建」按钮,新建数据集。

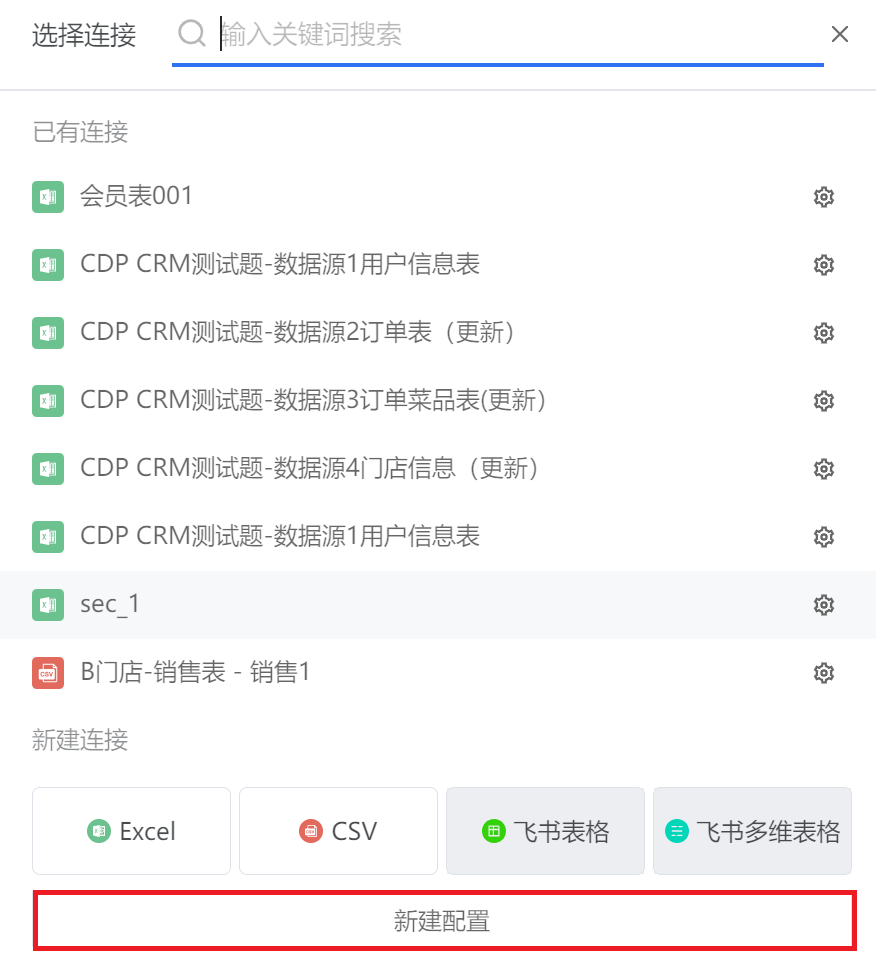

(2)选择数据连接的时候,点击新建配置。

之后的步骤与上述 2.1 的(2)、(3)步一致,在完成上传之后会停在数据集选择数据连接的弹出框中,即可直接进行下一步的数据集创建。

3.1 鉴权方式

共有两种鉴权方式:用户名和密码,Kerberos

若鉴权方式选 Kerberos

- 服务器,端口,Keytab,Krb5 用数据源方提供的。

- Principal

这边的 Principal 是指用户级别的,一般可以通过 Keytab 文件查看,命令为(以dlcdp.Keytab为例):

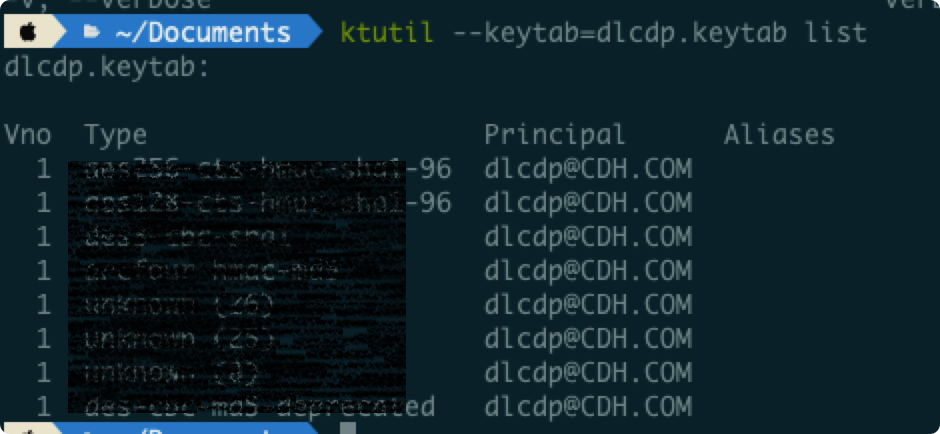

- mac:

ktutil --Keytab=dlcdp.Keytab list - linux:

klist -kt dlcdp.Keytab

mac 平台的执行结果:

上图可知,dlcdp.Keytab 这个文件对应的 Principal 是 dlcdp@CDH.COM。

3.2 连接方式

- JDBC 连接串

通过 Kerberos 方式连接 hive server2(JDBC)必须在 JDBC 连接串中指定 hive Principal,这里的 Principal 是指 hive 服务级别的,连接串的格式为:

jdbc:hive2://<host>:<port>/<db>;Principal=HivePrincipal

可以通过查看 hive-site.xml,确定 hive Principal。一般来说,Kerberos 相关的配置会是这样的:

<property> <name>hive.server2.authentication</name> <value>Kerberos</value> </property> <property> <name>hive.server2.authentication.Kerberos.Principal</name> <value>hive/_HOST@YOUR-REALM.COM</value> </property> <property> <name>hive.server2.authentication.Kerberos.Keytab</name> <value>/etc/hive/conf/hive.Keytab</value> </property>

红色高亮部分简单来说就是:hive /开头 + 机器名 + @realm。

注意_HOST 位置只能用机器名,不能用 ip

realm 在 Krb5 文件里有,具体可以参考下面示例 Krb5 文件:

因此,我们的 hive Principal 是:hive/``cdh.com@CDH.COM。

- JDBC连接方式支持读加速配置,在单表和自定义SQL的场景下,提升数据抽取性能,打平内置Hive。

特别提示:SaaS产品暂不支持JDBC连接串能力,请您使用IP/PORT方式。

3.3 读加速配置

Hive表需要抽取的数据量较大时,推荐开启读加速配置,在单表、多表JOIN和自定义SQL的场景下,可有效提升数据抽取性能,打平内置Hive。

开启读加速配置开关之前,请确认和收集以下信息:

- 确认Hive表底层文件系统为HDFS;

- 收集Hive表底层对应的HDFS NameNode的 IP 地址和端口号;

- 确认待同步的Hive表为Parquet或ORC格式存储;

- 若HDFS集群开启了Kerberos鉴权,还需要收集HDFS NameNode的Principal,并上传Keytab文件和Krb5文件。

Keytab文件路径和Principal可以在Hadoop集群的hdfs-site.xml文件中查看

<property> <name>dfs.namenode.keytab.file</name> <value>/var/security/HDFS/hdfs.keytab</value> </property> <property> <name>dfs.namenode.kerberos.principal</name> <value>nn/_HOST@BYTED.COM</value> </property>

上面的例子中,Keytab文件所在的路径为/var/security/HDFS/hdfs.keytab,HDFS NameNode的Principal的格式为nn/ + NameNode主机名 + @BYTED.COM,可到Keytab文件中搜索对应格式的Principal。

下图为整体的填写示例: