可视化建模,是本产品提供的界面化、拖拽式数据处理与建模功能,通常这一能力被称为 ETL(Extract-Transform-Load),也可称之为数据建模。可视化建模,作为数据源和可视化展示的中间环节,能够让用户在可视化查询与仪表盘制作前,对初始数据集进行拖拉拽式、低门槛、智能化的高效数据处理,使数据经过清洗、转换、装载后输出更有利于业务分析的数据集。同时,该模块还可以实现模型训练、算法预测场景能力。

*可视化建模在个人版和标准版中不可用

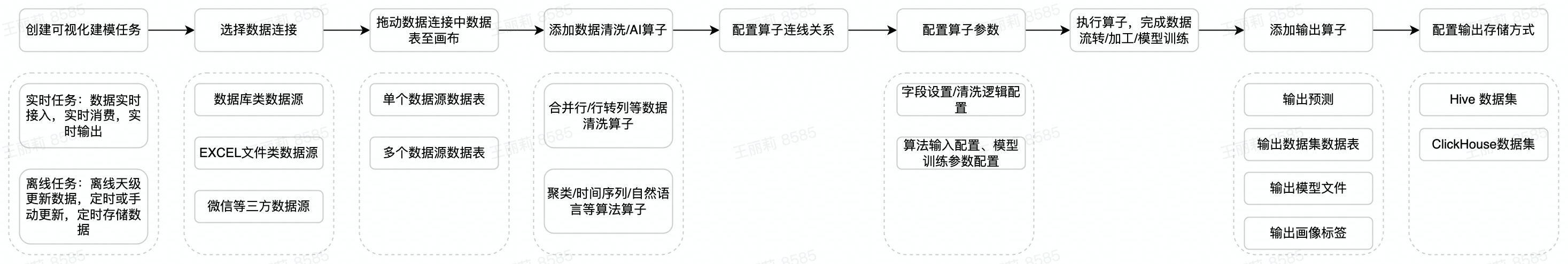

创建可视化建模任务-->选择数据连接-->添加数据算子-->配置算子连接关系-->配置算子-->执行算子-->输出算子-->设置输出算子的存储方式。完整的学习课程,请见文档学习课程。

可视化建模可以将数据开发的过程产品化、工具化、可视化,用户仅需掌握基本的数据知识,不需数据开发辅助,几步拖拽即可实现复杂数据处理,门槛低、效率高。这样的效果都是基于产品的核心功能来实现的,可视化建模的核心功能模块包含如下:

(1) 输入&输出数据集

支持抽取数据源中的数据,通过拖拽形式添加数据处理节点,将处理完成的数据输出到目标源中。支持输出内置数据源:以 Hive、ClickHouse、ByteHouse 存储的数据集。整体的流程就是,抽取数据源中的数据,通过拖拽形式添加数据处理节点,将处理完成的数据输出到目标源中,形成输出数据集。

(2)数据处理与清洗

数据清洗,通常是指发现并纠正数据文件中可识别的错误,包括检查数据一致性,处理无效值和缺失值等。我们的可视化建模支持:字段设置、筛选行、添加计算列、聚合、连接、合并、行列转置等。

(3)AI 模型构建

可视化建模封装了超过30类+常见的AI算子能力,仅需了解算法的作用并通过配置化的方式配置算法算子的输入和训练目标即可完成模型训练,根据配置的其他数据内容快速得到预测结果。

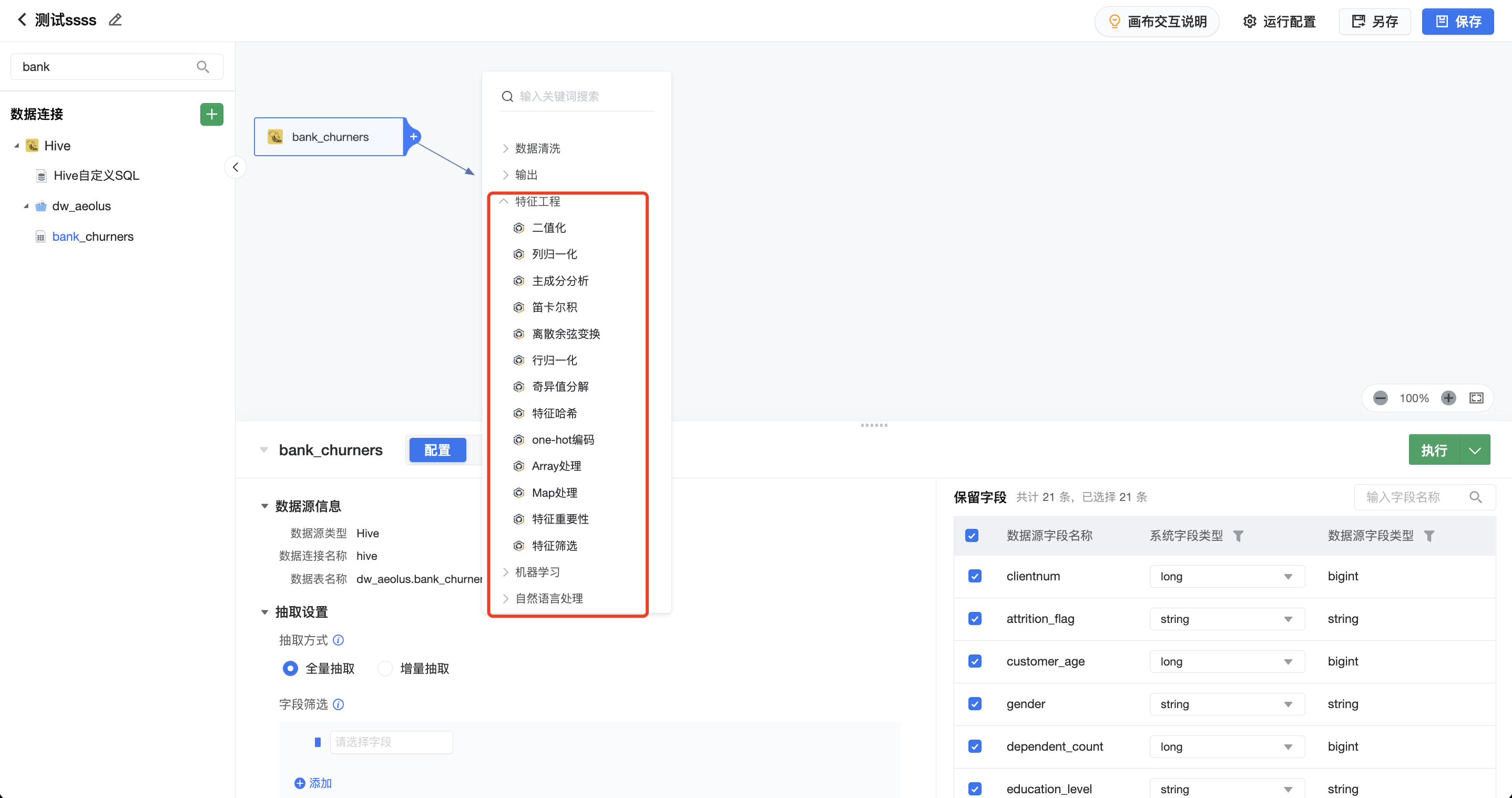

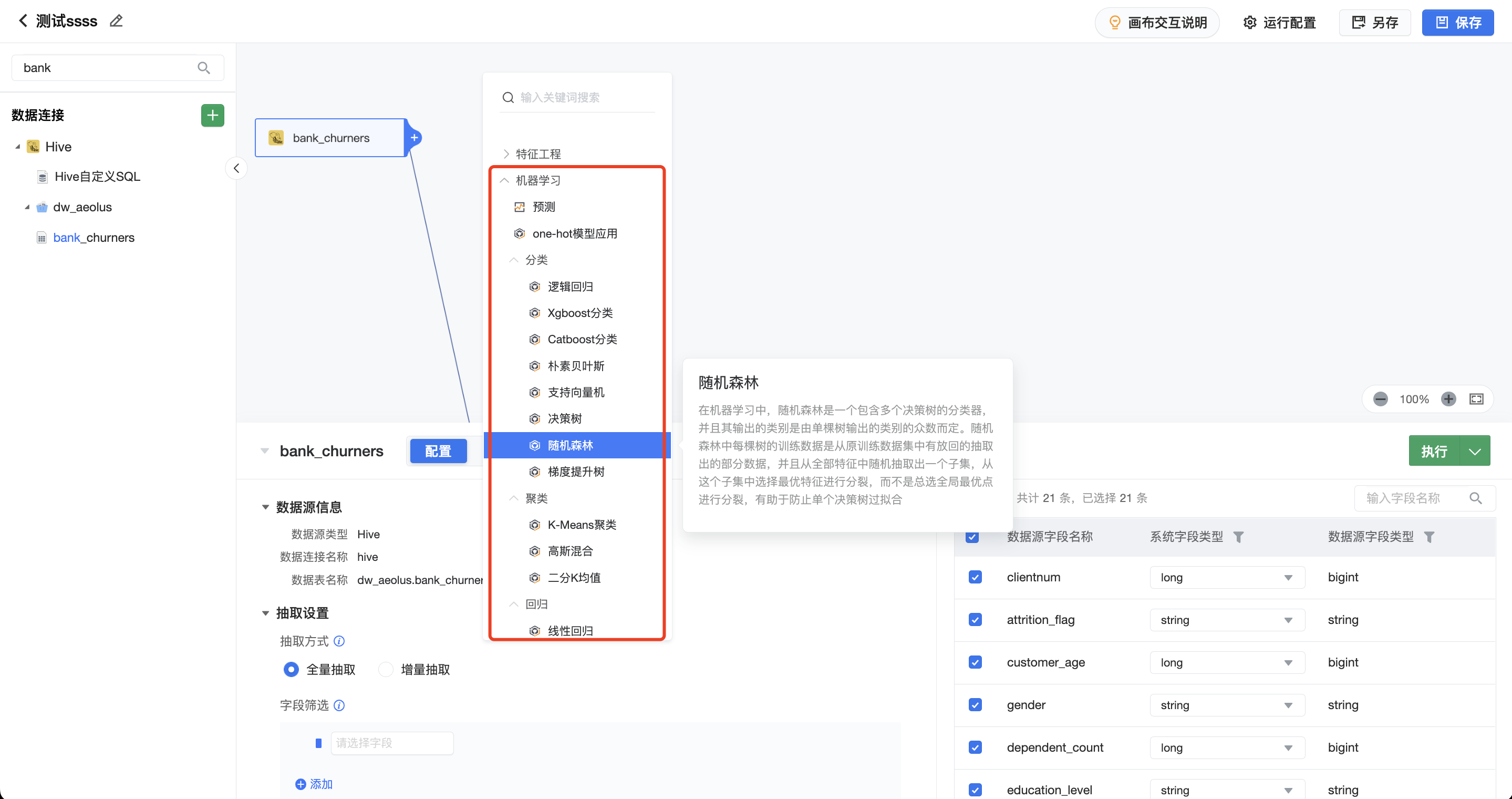

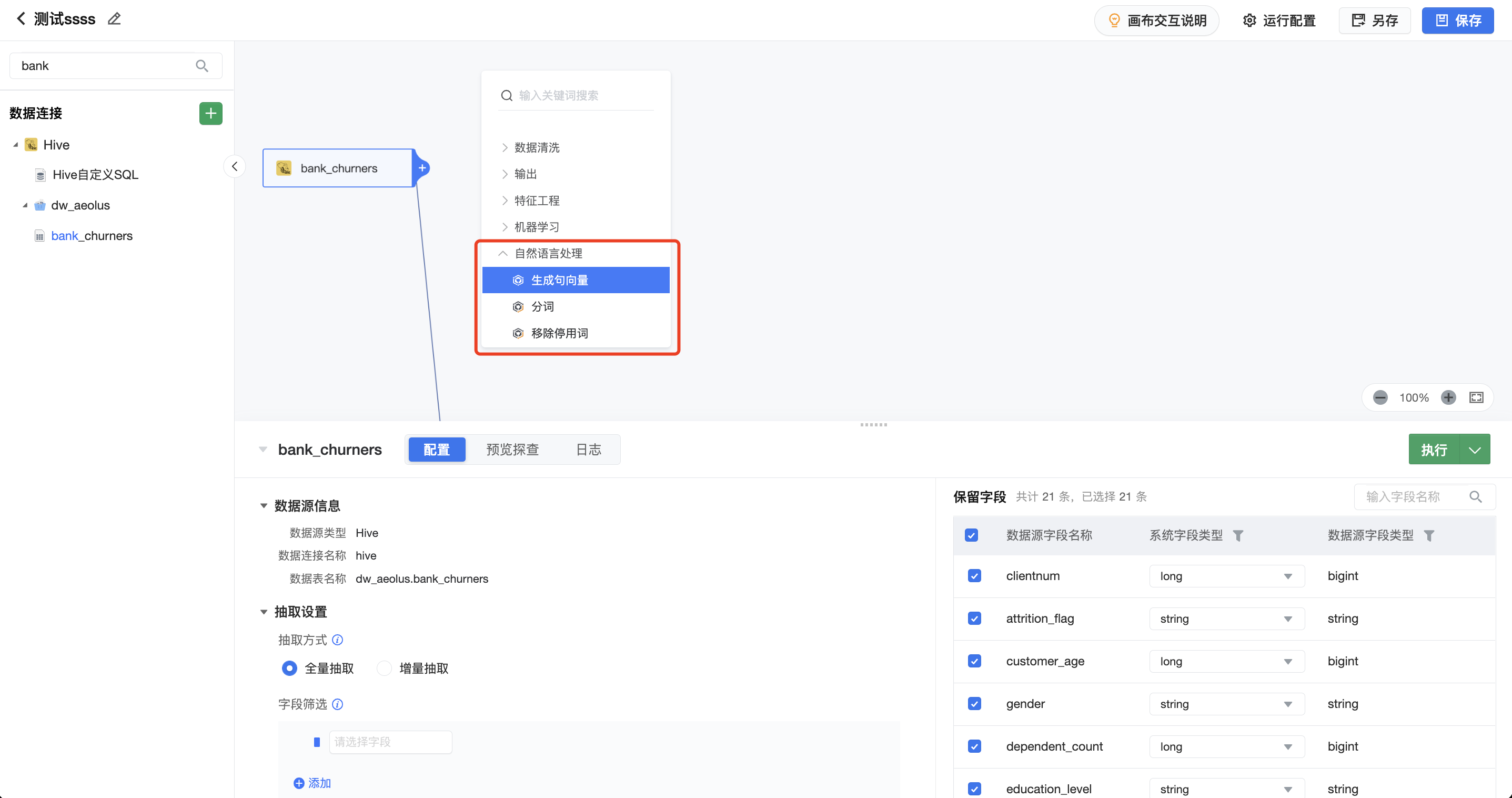

其中包含了三类:特征工程;机器学习;自然语言处理。

其中以特征工程为例,给大家进行简单的介绍:特征工程,通常指将原始数据转化成更好地表达问题本质的特征的过程,使得将这些特征运用到预测模型中能提高对不可见数据的模型预测精度。我们在完成数据输入之后,即可利用特征工程算子对输入数据进行进一步加工处理操作。

(4)任务配置与管理

对可视化建模任务的查看、操作、运行管理、状态统计与管理配置等操作。在可视化建模任务概览部分,用户可以查看项目内所有可视化建模任务的情况概览,包括任务状态统计和任务列表两部分内容。在可视化建模任务的的详情部分,可以查看到可视化建模任务的详细配置信息,包括基本信息、处理流程、输入&输出表数据预览、运行记录。

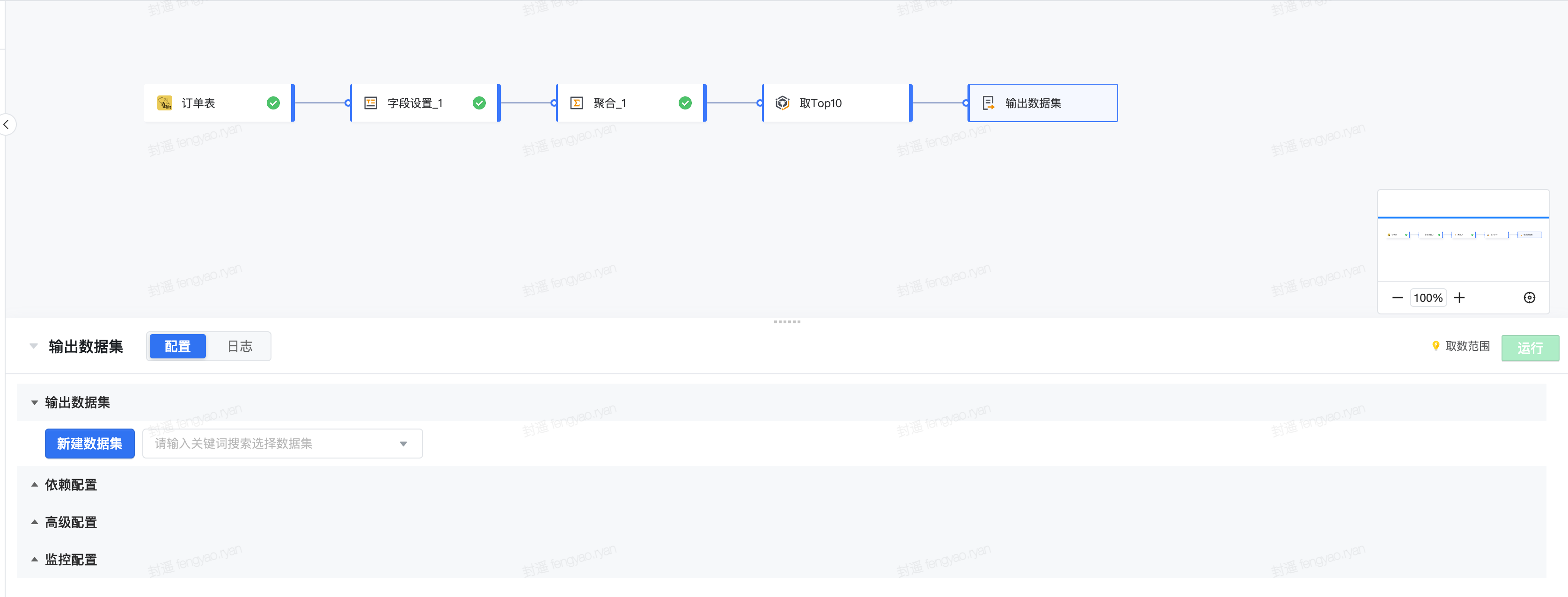

4.1 所想即所得,可视化完成数据处理过程

如想获取按照日期、城市粒度的订单数及订单金额,并获取每日 Top10 消耗金额数据的城市数据。

常规数据处理流程 | 可视化建模处理流程 |

|---|---|

|

|

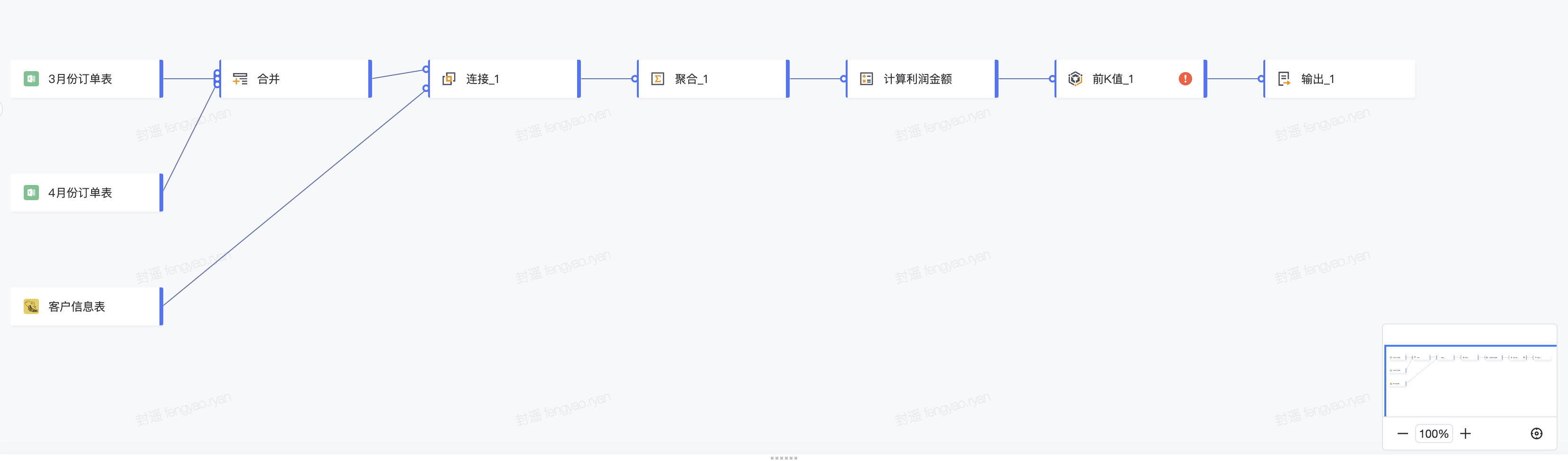

4.2 多表快速结合,轻松解决多数据关联计算

在数据处理过程中,有多个数据源需要进行组合使用,比如有两份数据量比较大的订单数据和一份客户属性信息表,需要根据账单金额和成本金额计算利润金额,然后按照利润贡献高低取 Top100 的用户订单信息。

常规数据处理流程 | 可视化建模处理流程 |

|---|---|

|

|

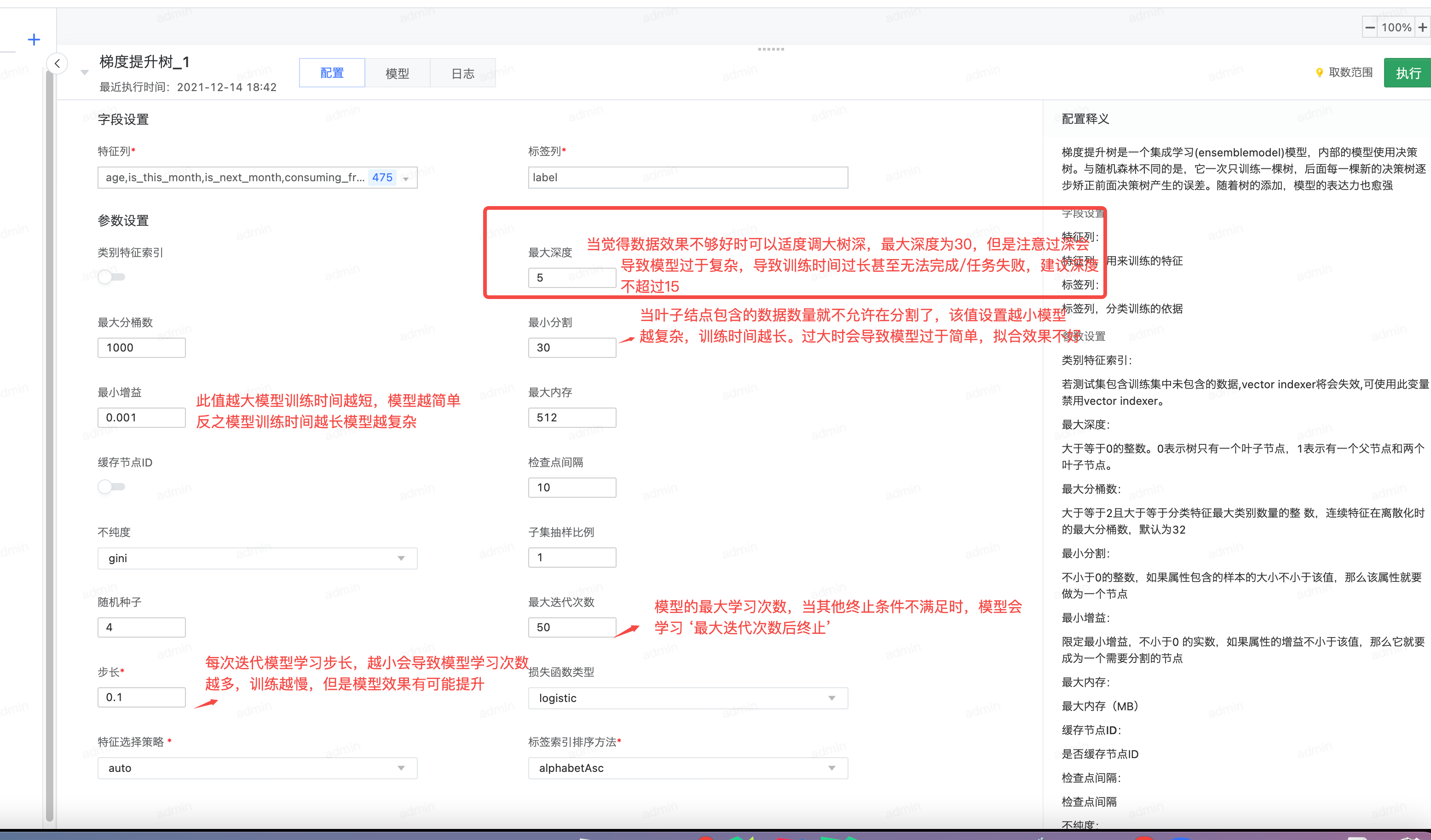

4.3 AI 数据挖掘能力无代码即可配置

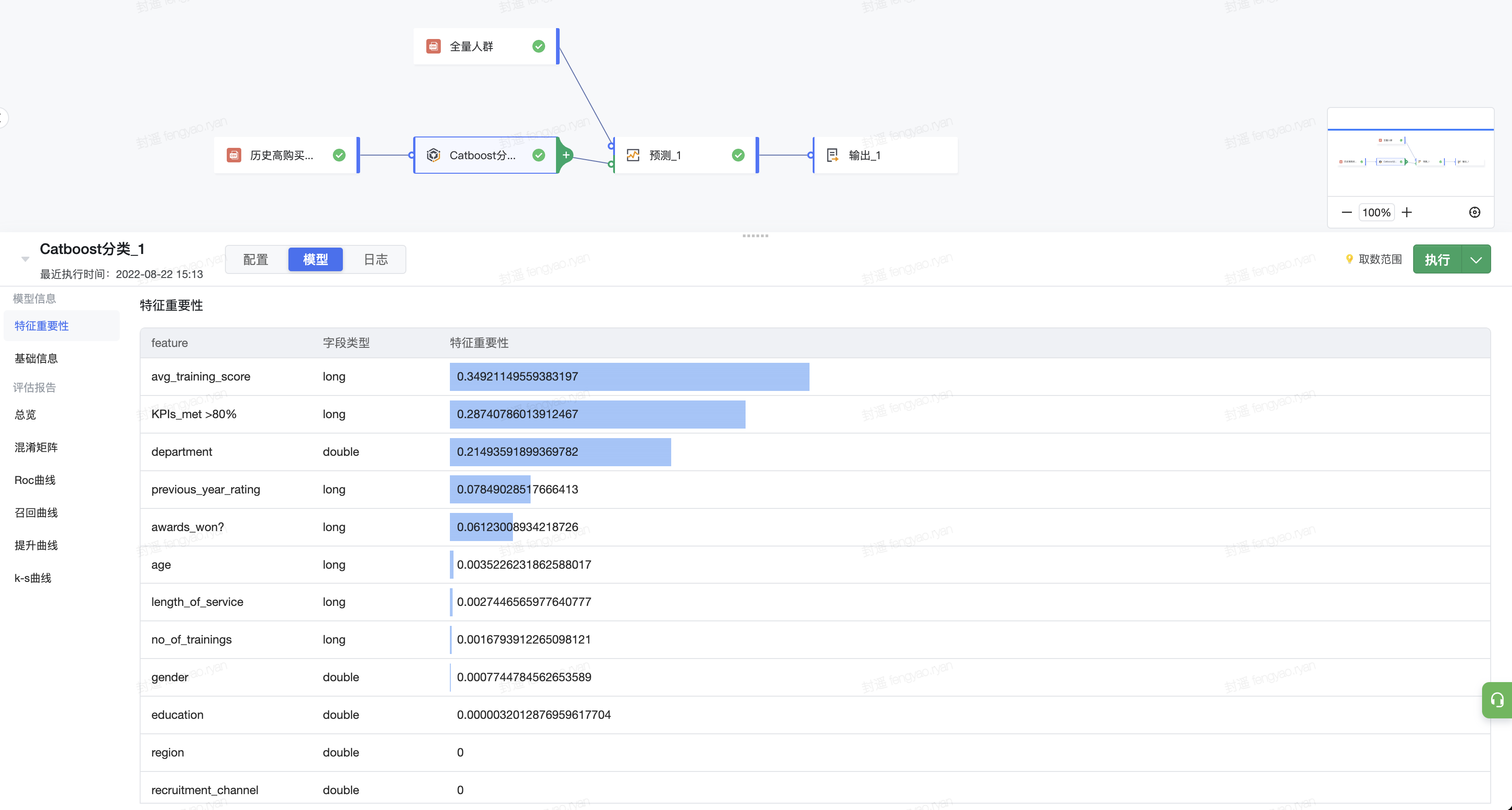

可视化建模封装了超过30类+常见的AI算子能力,仅需了解算法的作用并通过配置化的方式配置算法算子的输入和训练目标即可完成模型训练,根据配置的其他数据内容快速得到预测结果。

- 特征工程算子(13)

- 机器学习算子(22)

- 自然语言处理算子 (3)

- AI算子参数配置

- AI模型训练效果

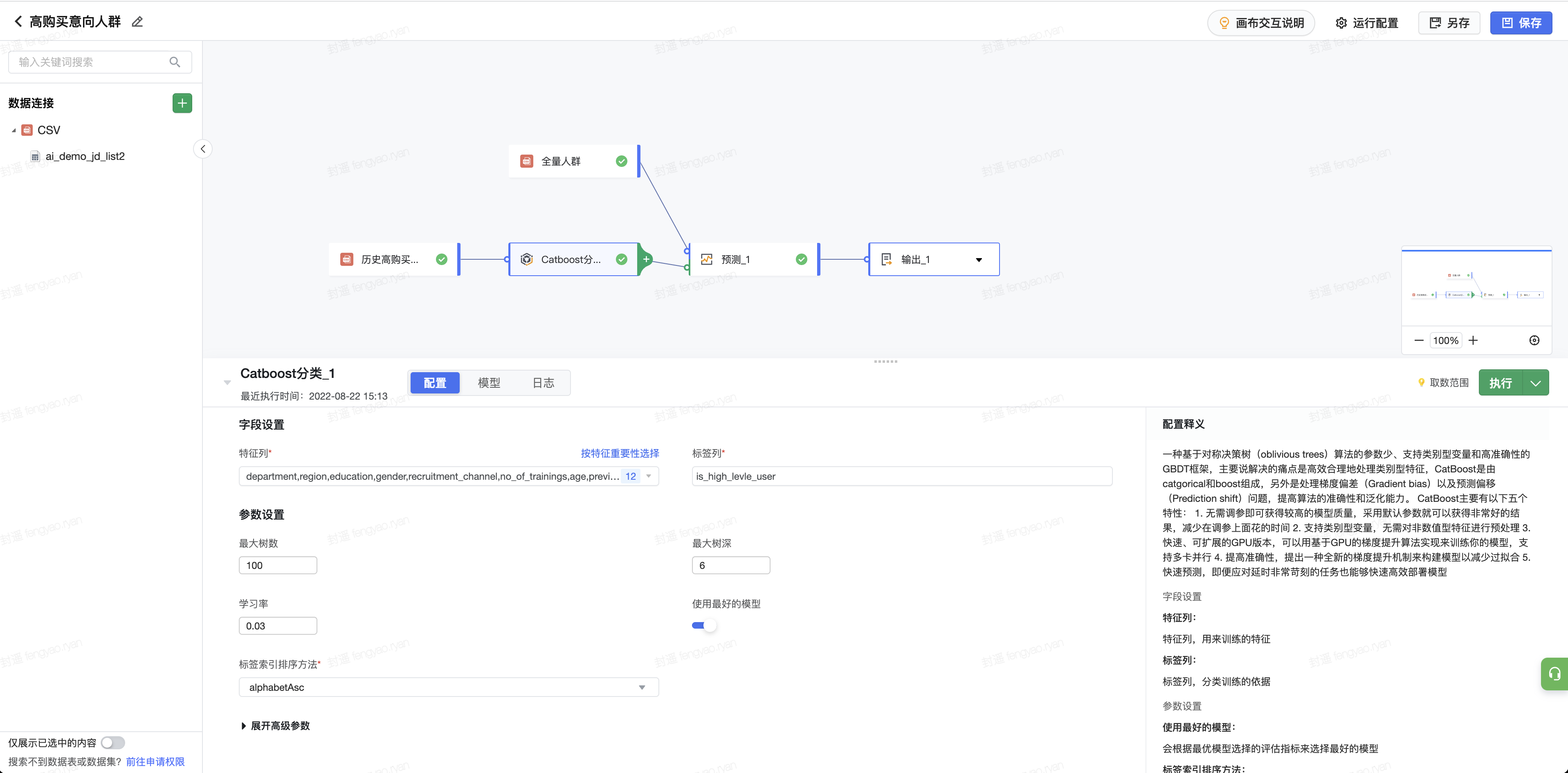

4.4 客户意向度挖掘预测

比如需要基于存量高意向客户样本做客户意向度挖掘:

(1)拖入样本数据和全部数据作为数据输入

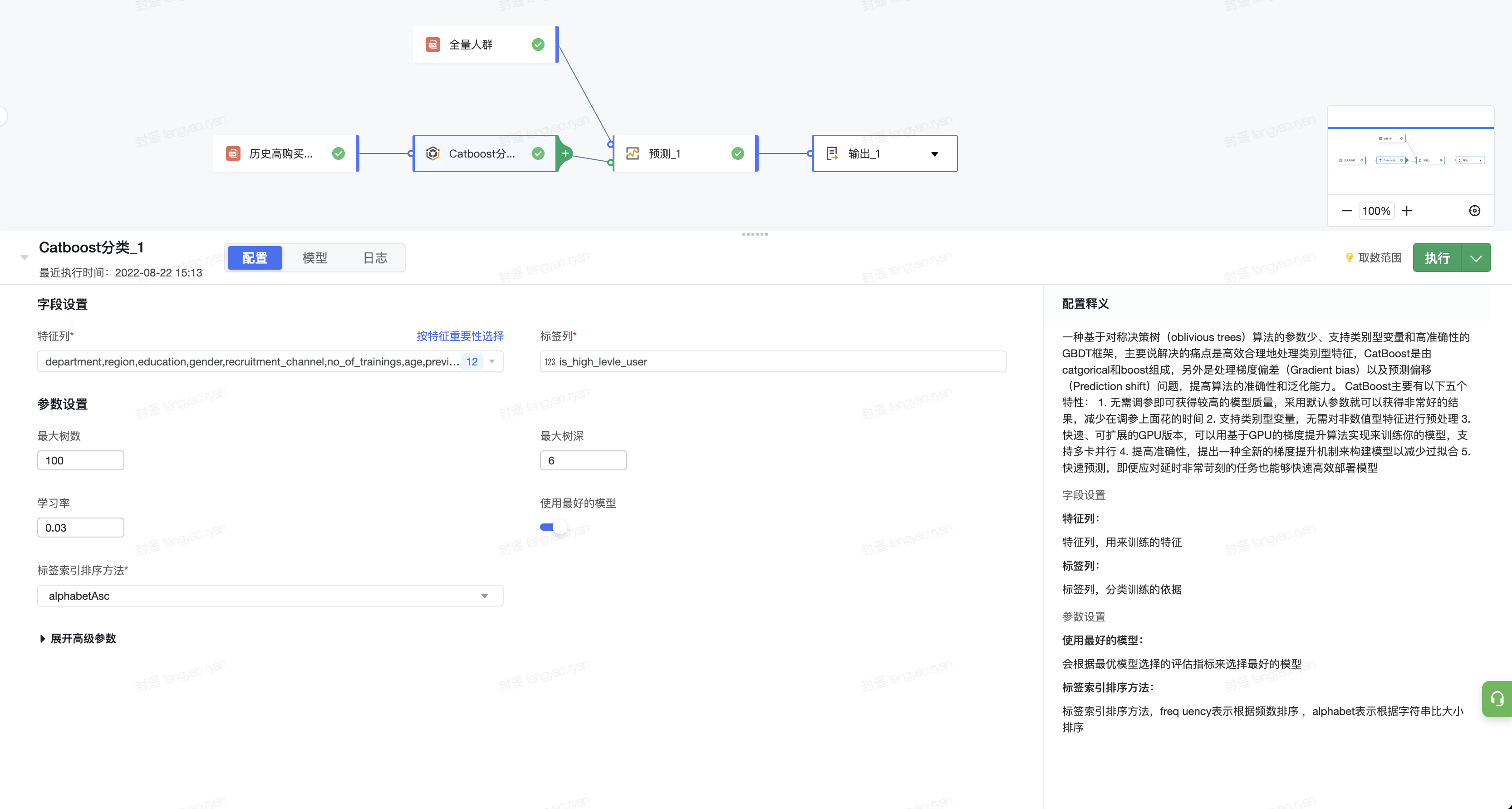

(2)拖入分类算法,如XGB算法用于模型训练

(3)拖入预测算子,搭建模型与全部数据的关系进行预测

(4)实际数据和预测结果结合输出数据集,从而分析全部用户数据的意向分布

4.5 回购预测模型搭建

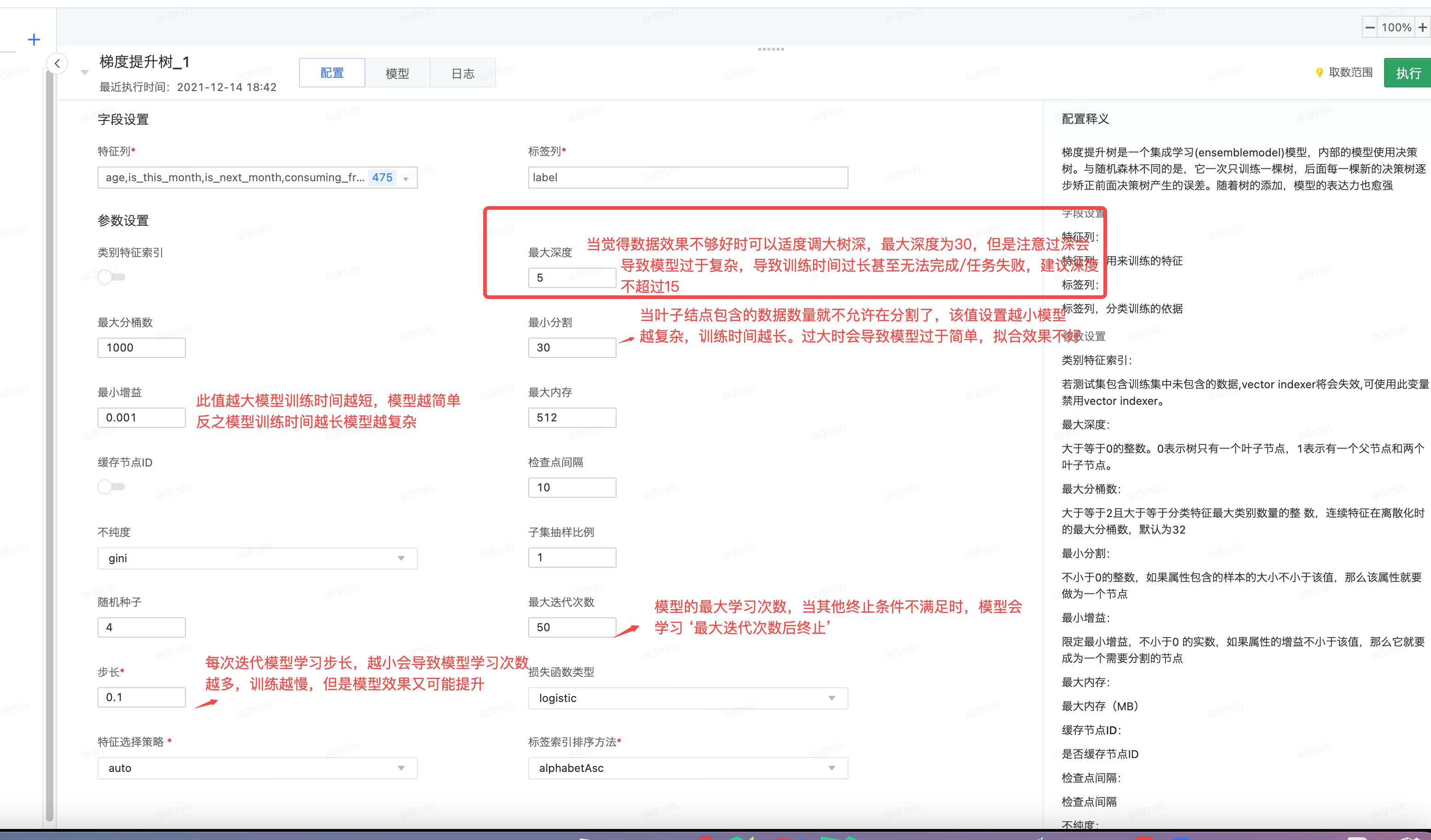

电商场景中,需要根据现有数据做用户回购模型,在模型搭建中需要经过数据清洗、格式转换之后采用梯度提升树构建预测模型,此时可以根据可视化建模构建回购模型流程:

(1)合并行:将 n 个算子(图中的长方形)输出数据表根据一致的表头合并成一张总的数据表,用户销售数据没有增删新属性时此处不用改动。

(2)缺失值替换:属性列存在空值(null)时,会影响后续模型计算,使用替换缺失值算子可以将空值替换为指定默认值,用户销售数据没有增删新属性时此处不用改动。

(3)one-hot 编码: 文本类型的属性无法直接被模型训练使用,需要 one_hot 编码成数字向量例如:

暂时无法在飞书文档外展示此内容

(4)梯度提升树:负责拟合训练数据,输出一个可以用于预测的模型(图中没有标注的参数不需要维护人员修改):

(5)聚合_1:去除预测数据中的重复项,取最大概率。

(6)提取字段:提取必要的 label 和概率值输出。