E-MapReduce

E-MapReduce

E-MapReduce

文档指南

请输入

产品动态与公告

产品动态

EMR 软件栈发行版本

版本说明(历史版本)

EMR on ECS-3.17.0及之前版本

EMR 3.x版本

EMR-3.6.X 版本说明

EMR-3.4.X 版本

EMR 2.x版本

EMR 1.x版本

EMR 1.3.x版本

产品简介

产品计费

快速入门

EMR on ECS 快速入门

EMR on VKE 快速入门

EMR on ECS 操作指南

集群管理

集群配置

集群监控

EMR on VKE 操作指南

EMR Serverless 队列操作指南

配置与管理队列

提交作业

元数据管理

Serverless Spark 作业

mGPU 作业

开发指南

EMR Serverless 实例操作指南(OLAP)

权限管理

数据湖查询(StarRocks)

性能调优

组件操作指南

Celeborn

DolphinScheduler

DolphinScheduler 对接 EMR Serverless

HBase

Hive

Iceberg

Knox

Lance

Livy

MapReduce2

OpenLDAP

Phoenix

Proton

基础使用

高阶使用

Ranger

Ray

RayCluster 使用

Spark

StarRocks

数据湖分析

最佳实践

Tez

YARN

最佳实践

EMR on ECS 最佳实践

EMR on VKE最佳实践

EMR Serverless 实例最佳实践

StarRocks

Doris

EMR Serverless 队列最佳实践

Spark

开发参考

API 参考

EMR on ECS API参考

集群管理

节点组管理

用户管理

用户组管理

应用管理

EMR on VKE API参考

SDK 参考

EMR on ECS SDK 参考

EMR Serverless SDK 参考

常见问题

- 文档首页

使用 kubectl管理作业

本章节介绍 VKE 场景下,通过 kubectl 来管理 Spark 作业,更多内容请参考:开源官网。

说明

下文中:

app_name:指SparkApplication CR Metadata中的name

app_namespace:指集群namespace,与EMR集群ID相同

app_driver_pod:指Spark 的Driver Pod名称

kubectl #

创建 SparkApplication #

编写 spark-pi-py.yaml 文件,例如:

apiVersion: "sparkoperator.k8s.io/v1beta2" kind: SparkApplication metadata: name: spark-pi spec: type: Scala sparkVersion: 3.5.1 mainClass: org.apache.spark.examples.SparkPi mainApplicationFile: "tos://xx/xx/spark-examples_2.12-3.5.1.jar" arguments: - "1000" driver: cores: 1 coreLimit: 1000m memory: 4g executor: cores: 1 coreLimit: 1000m memory: 8g memoryOverhead: 1g instances: 3

通过下述命令创建作业。

kubectl apply -f spark-pi-py.yaml -n ${app_namespace}

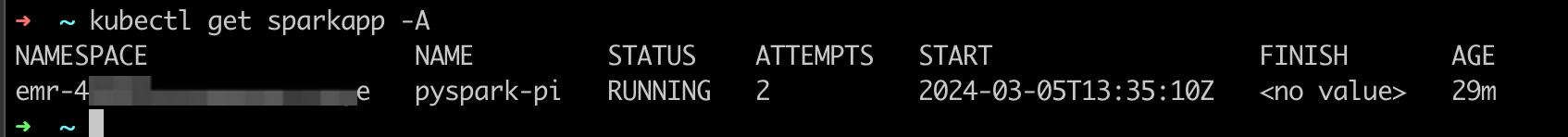

查看所有 SparkApplication #

kubectl get sparkapp -A

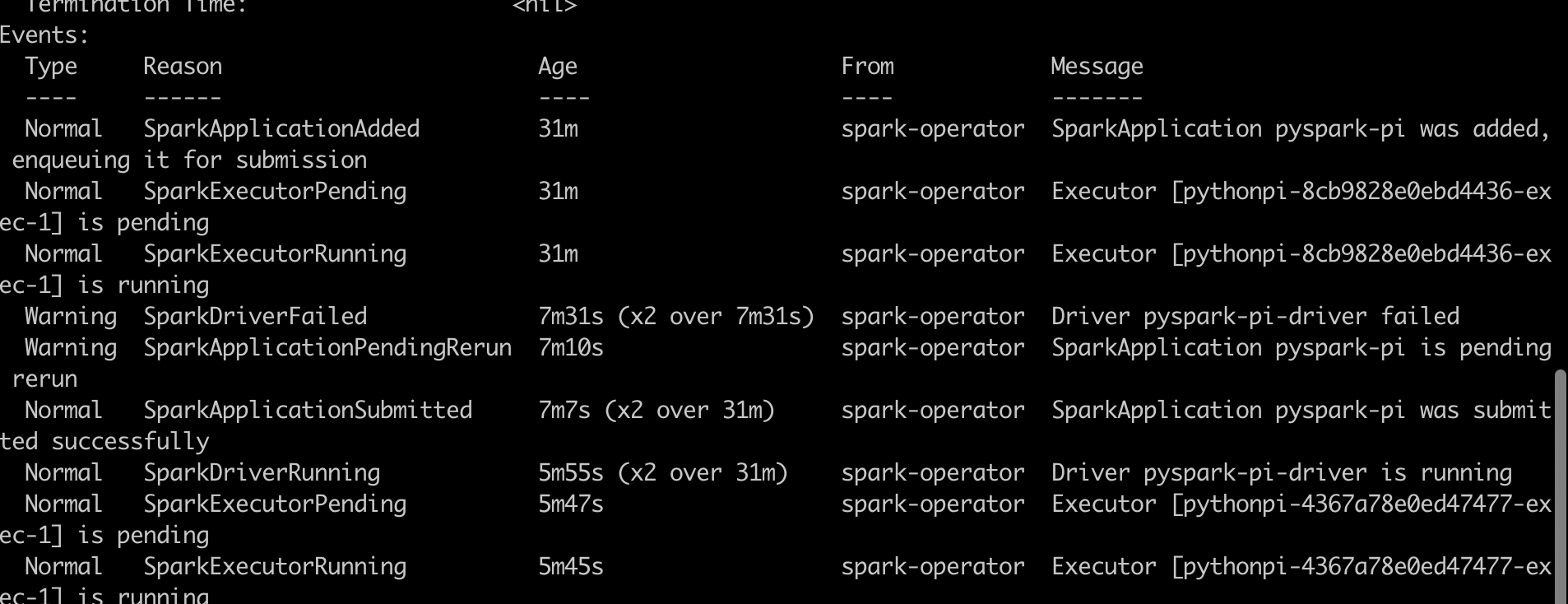

查看指定 SparkApplication 详细信息 #

kubectl describe sparkapp ${app_name} -n ${app_namespace}

修改 SparkApp 信息 #

kubectl edit sparkapp ${app_name} -n ${app_namespace}

输入命令后,会进入 vim 编辑模式,修改相应信息后,spark-operator 会根据修改内容,重新提交当前任务。

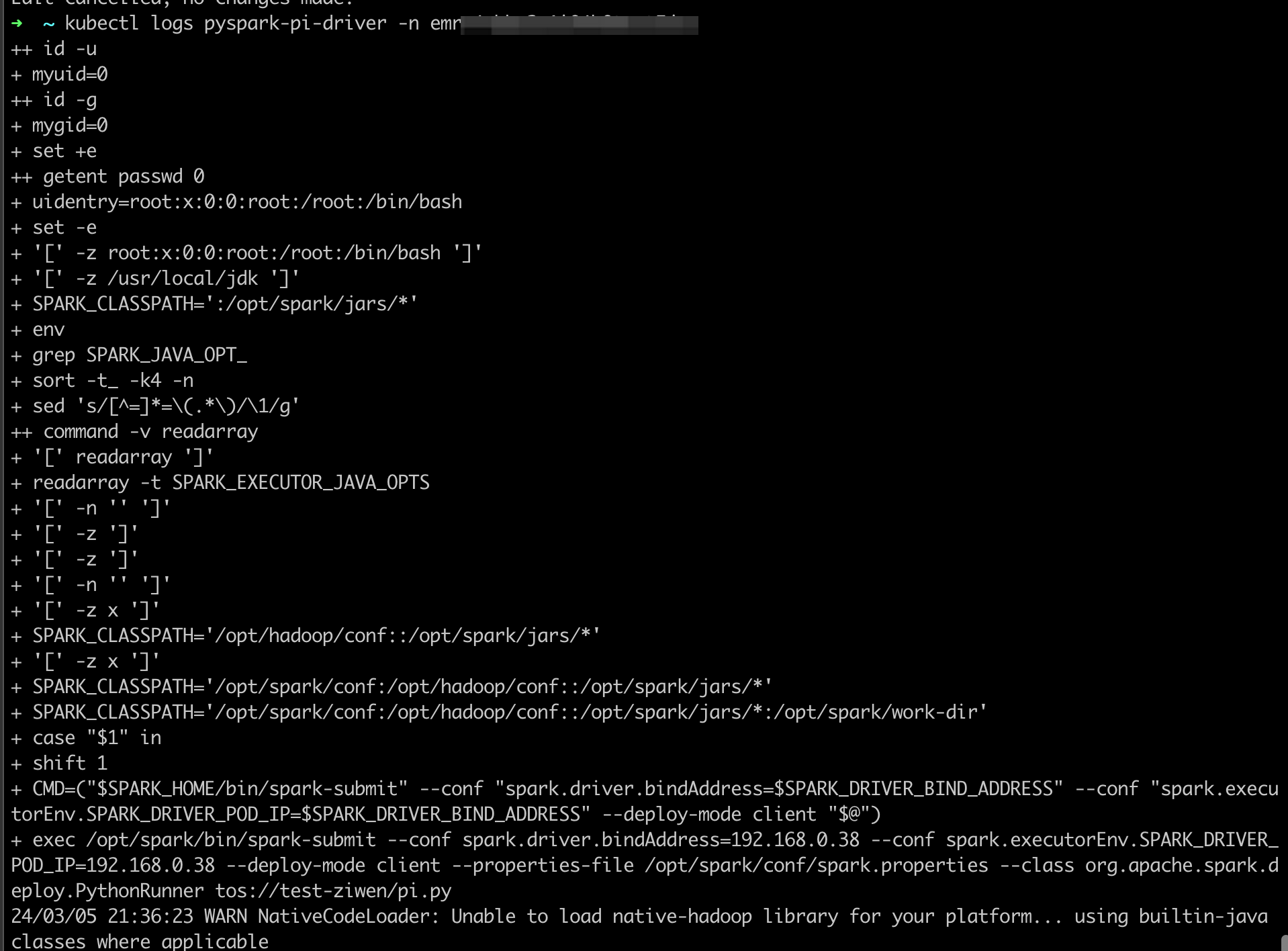

查看日志 #

kubectl logs ${app_driver_pod} -n ${app_namespace}

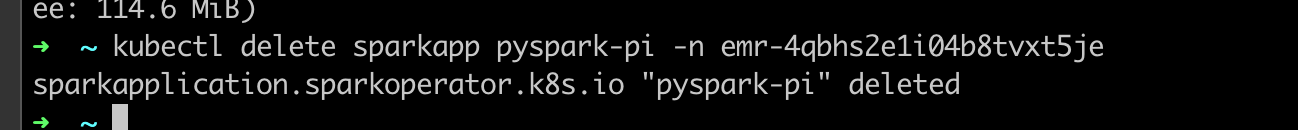

删除作业 #

kubectl delete sparkapp ${app_name} -n ${app_namespace}

#

最近更新时间:2025.05.14 15:58:56

这个页面对您有帮助吗?

有用

有用

无用

无用