本文为您演示通过 DataLeap 数据集成的方式,将 MySQL 数据库的数据,迁移至 E-MapReduce(EMR)- Doris 服务中。

1 前提条件

已开通大数据开发治理套件 Dataleap,详见:服务购买。

子账号新建数据源时,需要有项目的管理员、开发、或者复查者等编辑权限的角色,才有权限新建数据源。各角色对应权限说明,详见:管理成员。

已创建包含 Doris 服务的 EMR 集群,详见:创建集群。

修改 Doris root 用户密码,创建普通用户,创建 Doris 数据库、表,并赋权,操作详见:Doris 基础使用。

申请数据库传输服务产-数据订阅公测,申请地址:公测申请。

已创建 RDS MySQL 实例和数据库,详见 创建源RDS MySQL 实例 和 创建数据库。

2 申请数据订阅

数据库传输服务-数据订阅服务,可解析 MySQL 数据库的增量日志,并将增量数据封装同步到数据中间件,实现增量数据的订阅和消费。

完成数据库传输服务公测申请后,进入数据库传输服务产品控制台。

2.1 创建并启动订阅任务

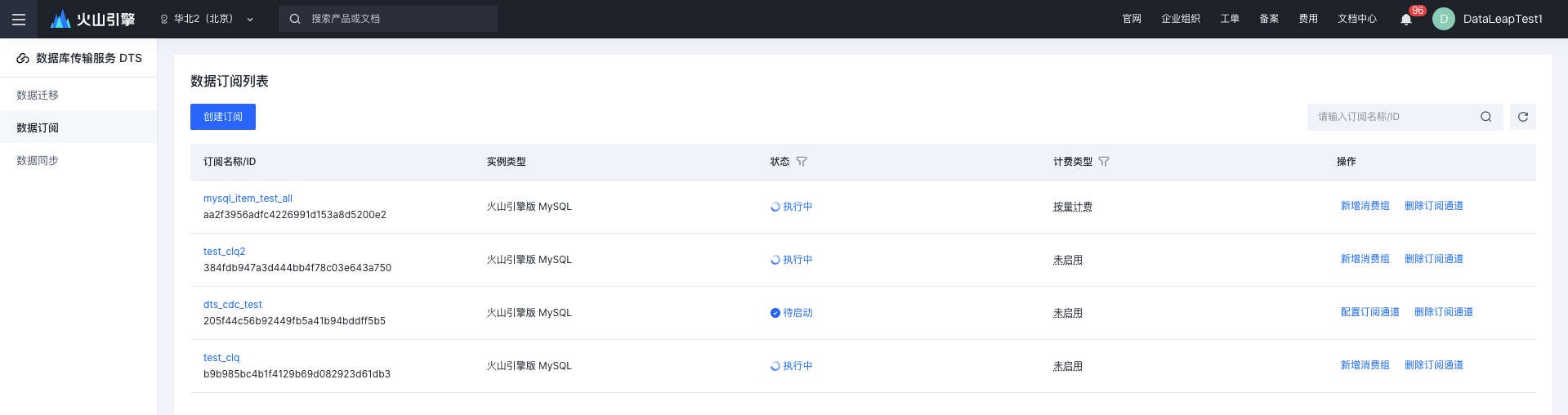

进入 数据库传输服务DTS控制台。

在左侧菜单点击 数据订阅,进入 数据订阅 界面。

点击 创建订阅 按钮,完成 源库、订阅对象 等信息的填写,以及预检查并确认订单信息。操作详见 创建并启动数据订阅任务。

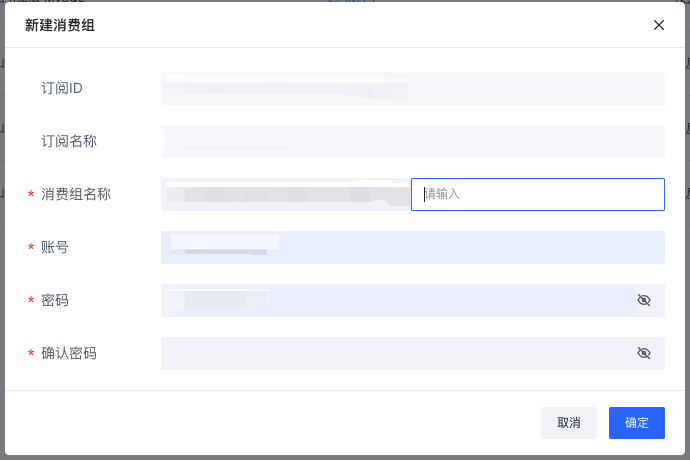

2.2 新建消费组

成功创建数据订阅任务之后,数据库的数据更新和结构更新均以消息数据的形式投递到指定的消费端,需要在DTS控制台创建消费组,供 DataLeap 数据集成进行消费。

具体操作详见:新建消费组。

2.3 网络连通性

需保证数据订阅和 Dataleap 数据集成处于同一VPC中,同时需要将网络进行手动打通,具体操作可 申请工单,联系火山引擎团队处理。

3 注册数据源

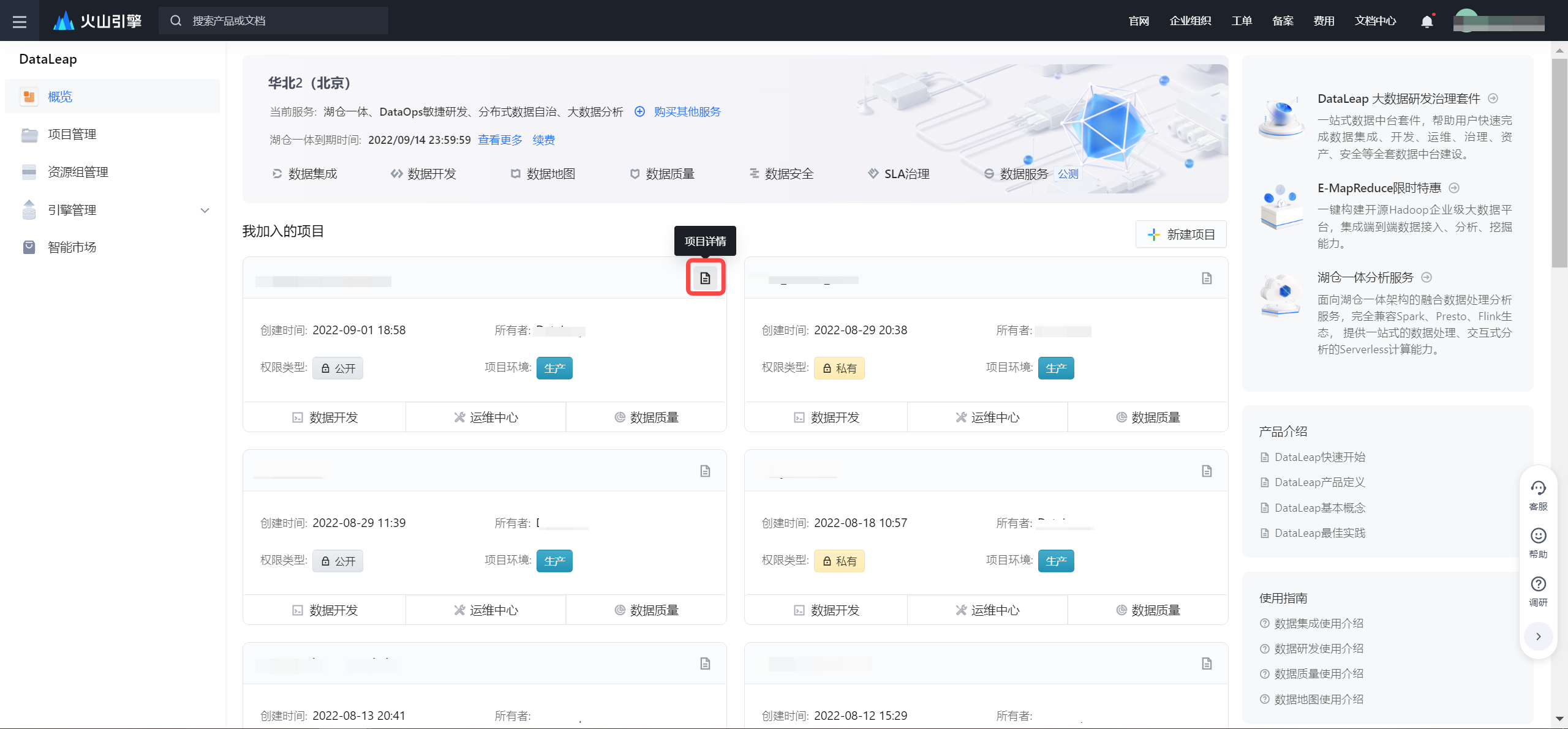

登录 DataLeap租户控制台 。

在 概览 界面,显示加入的项目中,点击 项目详情 进入对应项目控制台。

在 项目控制台 界面,左侧导航栏中,点击 数据源管理 按钮,进入 数据源管理 页面。

在 数据源管理 页面,您可以开始新增数据源。

3.1 注册 Mysql 数据源

Mysql 数据源,将火山引擎-云数据库 Mysql 版注册为数据源,同步 Mysql 中的全量、增量数据。操作详见:配置Mysql数据源。

3.2 注册 Doris 数据源

Doris 数据源,同步 EMR 集群中 Doris 组件数据库下的数据,为您提供离线、流式任务将数据写入 Doris 的能力,方便您后续配置数据集成同步任务。配置操作详见:配置Doris数据源。

4 数据集成

4.1 离线数据集成

4.1.1 创建离线数据集成任务

数据源完成创建后,您便可以开始配置相应的数据采集任务。

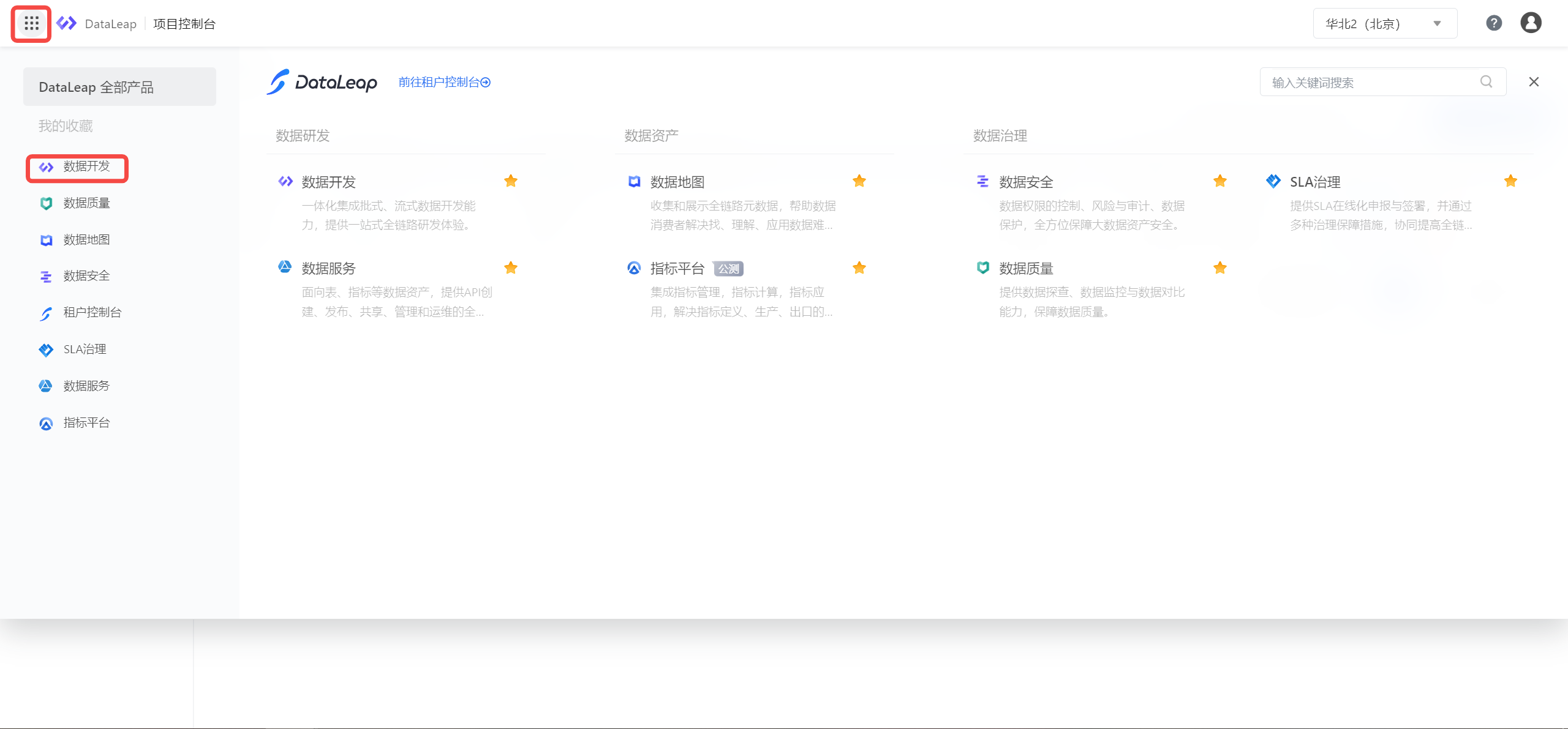

左上角 全部产品 中,进入 数据开发 界面。

在数据开发页面,点击 新建任务 按钮,进入新建任务页面。

任务类型选择 数据集成 > 离线集成 。

输入任务名称,并选择目标文件夹。

注意

任务名称只允许字符.、字母、数字、下划线、连字符、[]、【】、()、()以及中文字符,127个字符以内。

- 点击 确定 按钮,完成任务新建,进入任务配置页面。

4.1.2 配置任务参数

新建离线集成任务后,需要配置任务信息,操作步骤如下:

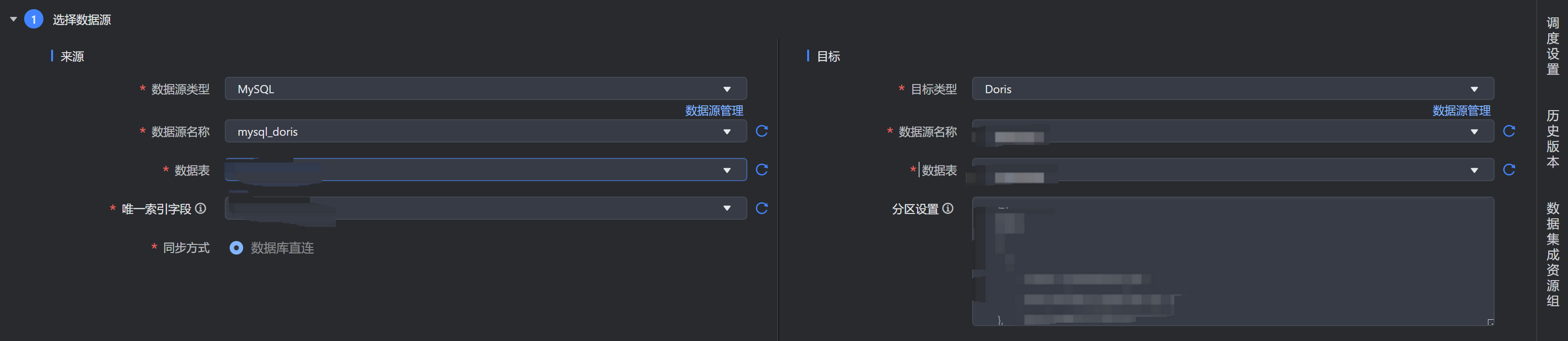

选择数据源。

配置数据来源类型-MySQL。

选择写入目标类型-Doris。

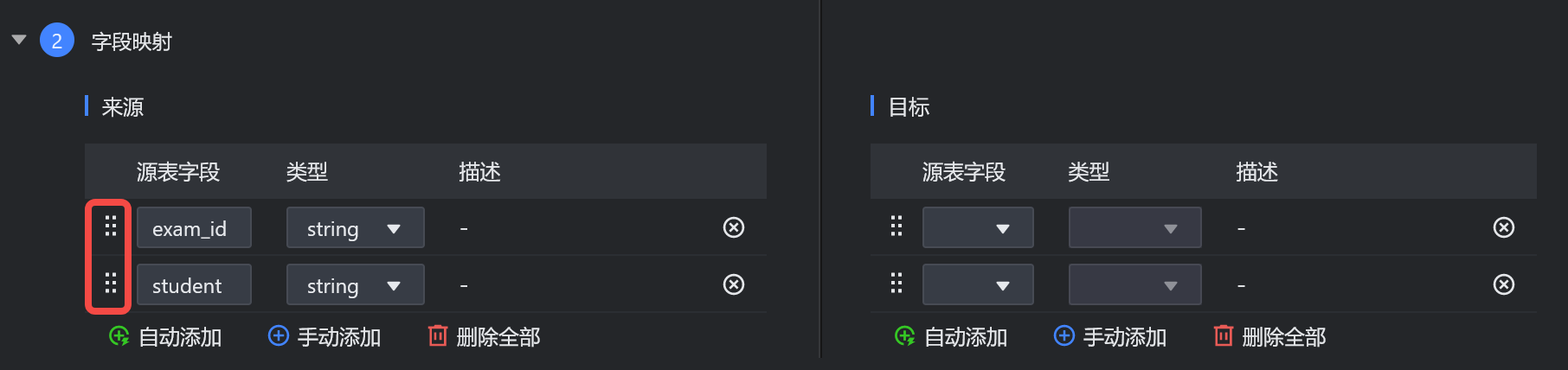

配置来源端和目标端字段的映射关系。

- 点击 自动添加,可以根据数据源 Schema 自动添加字段。

- 点击 手动添加,可以添加一条空白的字段信息,手工输入字段名、类型等。

- 点击 删除全部,可以删除全部字段信息。

通过拖拽字段左侧的按钮,可以调整字段顺序。

注意

请注意列与列之间映射的字段类型是否数据兼容。

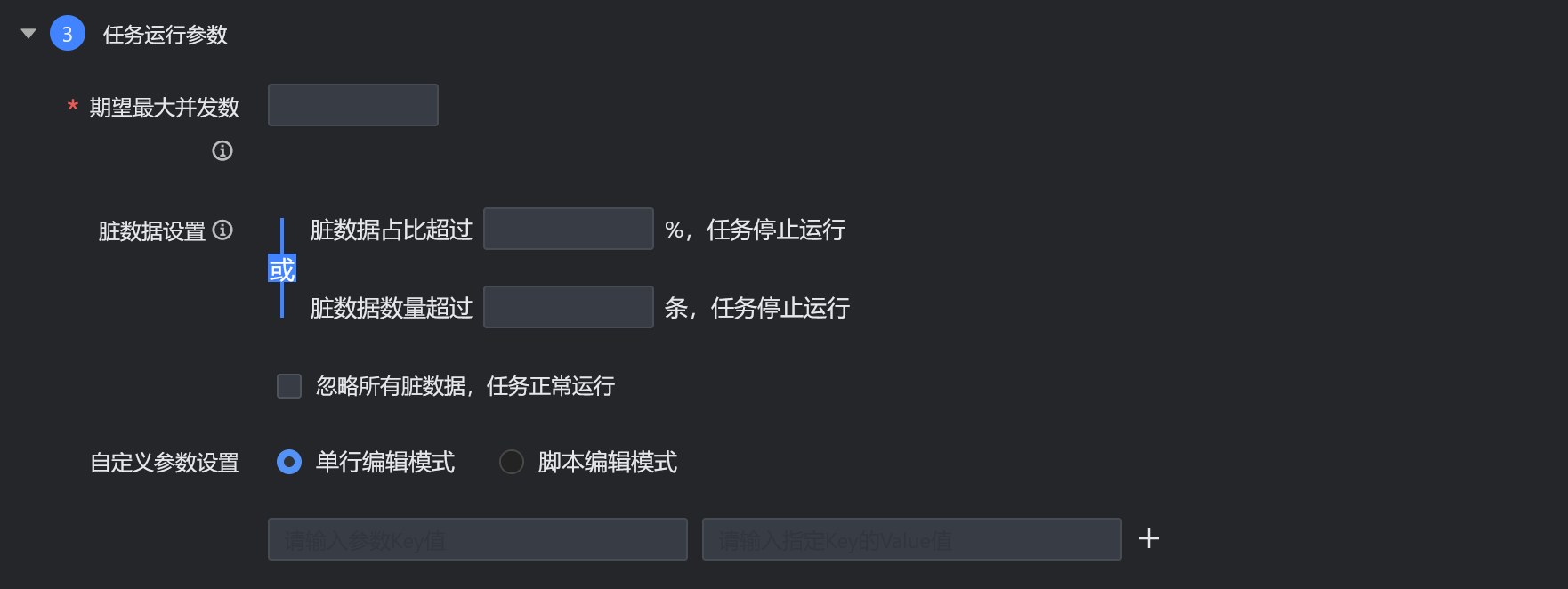

- 设置以下任务运行参数。

配置调度属性。

点击右侧的 调度设置 ,进入该任务的调度设置页面。

可以设置离线集成任务的运行周期、运行时间、调度依赖等属性。 更多说明请参见:任务调度设置

配置数据集成资源组。

点击右侧的 数据集成资源组 ,进入数据集成资源组页面。

选择数据源测试连通的数据集成资源组。 更多说明请参见:数据集成资源组

4.2 流式数据集成

4.2.1 创建流式数据集成任务

创建流式数据集成任务的步骤如下:

在数据开发页面,点击 新建任务 按钮,进入新建任务页面。

任务类型选择 数据集成 > 流式集成 。

输入任务名称,并选择目标文件夹。

注意

任务名称只允许字符.、字母、数字、下划线、连字符、[]、【】、()、()以及中文字符,127个字符以内。

- 点击 确定 按钮,完成任务新建,进入任务配置页面。

4.2.2 配置任务参数

新建流式集成任务后,需要配置任务信息,操作步骤如下:

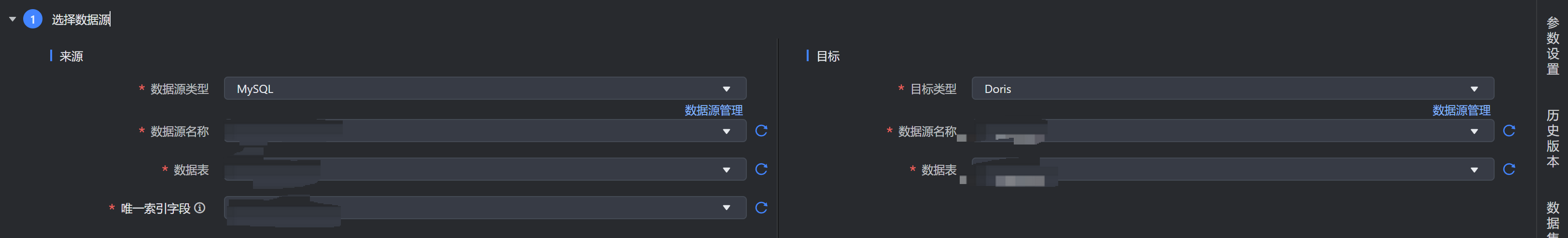

- 选择数据源。

配置数据来源类型-MySQL。

选择写入目标类型-Doris。

配置来源端和目标端字段的映射关系。

- 点击 自动添加,可以根据数据源schema自动添加字段。

- 点击 手动添加,可以添加一条空白的字段信息,手工输入字段名、类型等。

- 点击 删除全部,可以删除全部字段信息。

通过拖拽字段左侧的按钮,可以调整字段顺序。

注意

请注意列与列之间映射的字段类型是否数据兼容。

设置以下任务运行参数。

是否开启归档:选择开启归档后,可指定归档字段。

归档字段类型:支持 整型 和 字符串 两种类型。 当选择 字符串 归档字段类型时,需另外设置 归档字段格式。

归档字段:输入归档字段信息。

归档字段格式: 符合 Java Date Format 标准,例如:若日期格式为:20181017,则填写 yyyyMMdd;若日期格式为:2018-10-17,则填写 yyyy-MM-dd。

默认消费起始:当前任务启动时,对 Kafka 的默认消费位置。

高级参数:选择 是 时,需要设置参数 Key 和 value 值。支持单行编辑模式和脚本编辑模式。

设置参数。

点击右侧的 参数设置 ,进入该任务的参数设置页面。

可以设置实时任务的基础信息、资源设置、以及一些 Flink 运行参数配置。

配置数据集成资源组。

点击右侧的 数据集成资源组 ,进入数据集成资源组页面。

选择数据源连通成功的数据集成资源组。 更多说明请参见:数据集成资源组