LAS

LAS HDFS-Sensor

LAS HDFS-Sensor

任务执行前,如需要依赖上游 HDFS 数据就绪才执行当前任务时,可将 HDFS 数据依赖转化成 HDFS-sensor 任务依赖。

1 使用前提

DataLeap 项目中已绑定 LAS 引擎实例。

2 注意事项

- 当项目绑定引擎为 LAS 类型时,可见 LAS HDFS-sensor 任务。

- Sensor 任务进行数据检查时,建议不使用偏移设置,若下游依赖该 Sensor 任务所需数据分区存在偏移时,在对应任务的调度设置中,填写偏移量即可。

- Sensor 任务默认失败重试 600 次,每隔 5min 重试一次,超过 600 次后,不再重试。后续如果数据就绪,请重跑 Sensor 对应的实例。

3 新建任务

- 登录 DataLeap租户控制台 。

- 在概览界面,显示加入的项目中,单击数据开发进入对应项目。

- 在任务开发界面,左侧导航栏中,单击新建任务按钮,进入新建任务页面。

- 选择任务类型:

- 分类:数据开发

- 绑定引擎:LAS

- 关联实例:默认关联实例为 default。

- 选择任务:LAS HDFS-sensor 类型,可以实现对 HDFS 文件路径下数据的监控。

- 任务基本信息:

- 任务名称:输入任务名称,只允许字符.、字母、数字、下划线、连字符、[]、【】、()、()以及中文字符,且需要控制在127个字符以内。

- 保存至:选择任务保存目录位置。

- 任务描述:输入当前任务的描述。

4 HDFS-Sensor 任务配置

- 任务名称:新建任务时输入的任务名称。

- 描述:添加描述方便后续查看和管理,非必填。

- 责任人:任务所属责任人。

- 数据来源:

- 实时任务产出:由于 LAS 引擎暂未支持“Kafka->Hive“/“Kafka->HDFS“等流式 Dump 任务,因此该入口暂不开放。

- 自定义数据来源方式。

- 数据所属引擎:默认为任务创建时对应的 LAS 引擎及对应 default 实例。

- SUCCESS 标签地址:HDFS 数据对应的 Success 地址,Success 标签地址中输入${date}或${hour}时,系统会根据标签自动识别分区,如 lasfs:/public/tmp/task_1/${date}/${hour}/_success_file_name 通常对应小时级别任务:

- ${date} 业务时间日期,格式为:yyyymmdd,如:20150526。

- ${hour} 业务时间整点,用于小时级别任务,格式为: hh,如:02。

- 调度资源组:您可选择任务执行时,所使用的调度资源组,可选公共调度资源组或独享调度资源组。独享资源组操作详见独享调度资源组管理;

- 调度周期:选择希望 Sensor 任务执行的周期,如天级别,或小时级别;

- 执行时间:选择调度周期后,展示调度时间选择选项:

- 小时级:设置每次在某一小时的 XX 分执行,可以多选小时;

- 天级别:可设置每天 XX 时,XX 分执行。

- 检查次数:默认失败重试 600 次;

- 检查间隔:默认每隔 5 min 重试一次。

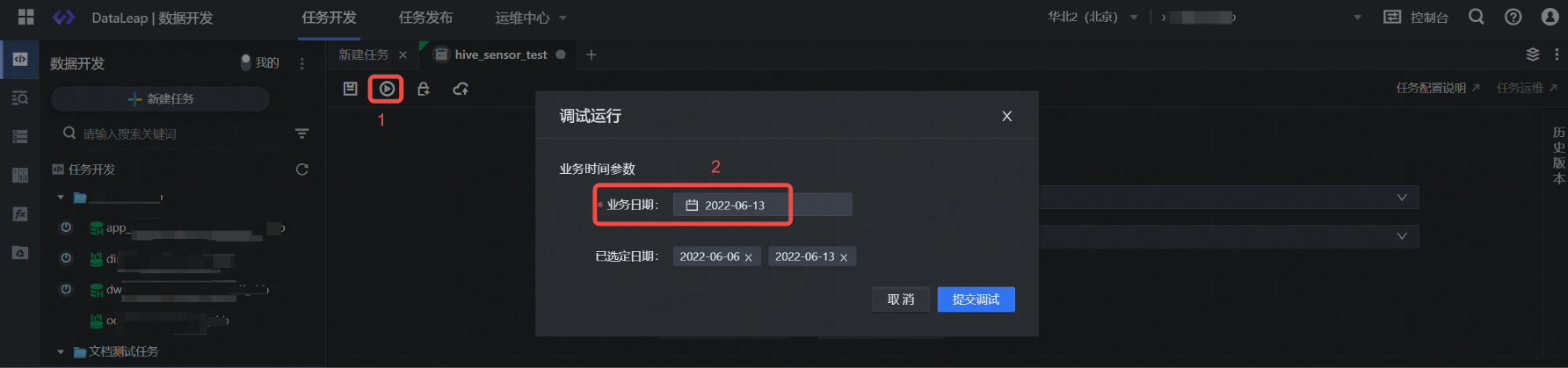

5 调试运行

任务配置完成后,您可进行以下调试操作。

- 单击上方工具栏中的调试按钮。

- 选择业务日期进行调试,检测对应文件路径下HDFS数据文件是否存在。

注意

- 调试操作,直接使用线上数据进行调试,需谨慎操作。

- 数据开发界面调试日志数据,保留 15 天,您可在 15 天内查看相应的调试日志详情。

- 本任务类型支持调试执行成功或失败后发送消息通知给调试发起人,您可根据业务情况,前往项目控制台 > 配置信息 > 消息通知设置中,选择是否开启任务调试运行成功或失败通知。默认通知方式为邮箱,调试发起人需在火山引擎“访问控制 > IAM 用户详情”中,提前绑定相应的安全邮箱信息;

6 提交上线

任务所需参数配置和调试任务成功后,将任务提交发布到运维中心离线任务运维中执行。

单击上方操作栏中的保存和提交上线按钮,在提交上线对话框中,选择回溯数据、监控设置、提交设置等参数,最后单击确认按钮,完成作业提交。 提交上线说明详见:数据开发概述---离线任务提交。

后续任务运维操作详见:离线任务运维。

最近更新时间:2025.09.29 11:59:42

这个页面对您有帮助吗?

有用

有用

无用

无用