kafka监听socket

社区干货

社区干货

Kafka@记一次修复Kafka分区所在broker宕机故障引发当前分区不可用思考过程 | 社区征文

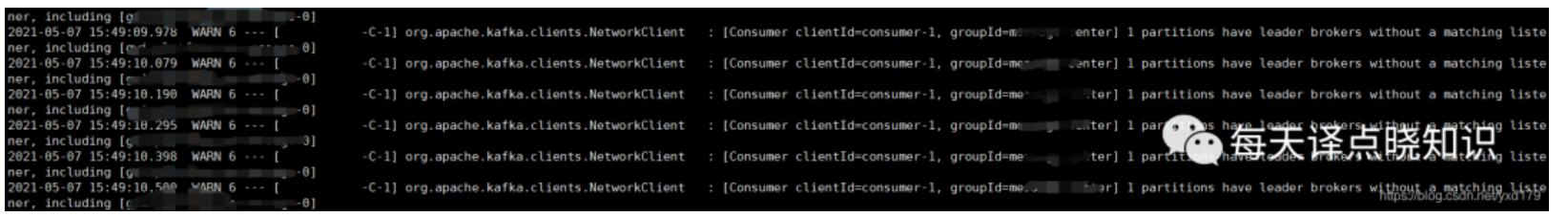

org.apache.kafka.clients.NetworkClient : [Consumer clientId=consumer-1, groupId=xxxx-center] 1 partitions have leader brokers without a matching listener, including [xxxx-xxxx-xxxx-message-0]```## 假设猜想从字面意思来看,当前分区所对应的的broker失去监听,为什么监听不到...

聊聊 Kafka:Topic 创建流程与源码分析 | 社区征文

## 一、Topic 介绍Topic(主题)类似于文件系统中的文件夹,事件就是该文件夹中的文件。Kafka 中的主题总是多生产者和多订阅者:一个主题可以有零个、一个或多个向其写入事件的生产者,以及零个、一个或多个订阅这些事件的消费者。可以根据需要随时读取主题中的事件——与传统消息传递系统不同,事件在消费后不会被删除。相反,您可以通过每个主题的配置设置来定义 Kafka 应该保留您的事件多长时间,之后旧事件将被丢弃。Kafka 的性能在...

消息队列选型之 Kafka vs RabbitMQ

在面对众多的消息队列时,我们往往会陷入选择的困境:“消息队列那么多,该怎么选啊?Kafka 和 RabbitMQ 比较好用,用哪个更好呢?”想必大家也曾有过类似的疑问。对此本文将在接下来的内容中以 Kafka 和 RabbitMQ 为例分... * **Consumer** :监听 RabbitMQ 中的(Queue)队列中的消息,然后去消费。* **Queue** :用于存储消息。* **Exchange** :生产者将消息发送到 Exchange,由交换器将消息路由到一个或者多个队列中。* **Broker** :可以...

为了使远程工作不受影响,我写了一个内部的聊天室 | 社区征文

socket通常也称作“套接字”,用于描述IP地址和端口,是一个通信链的句柄。可以用来实现不同虚拟机或不同计算机之间的通信。网络上的两个程序通过一个双线的通信连接实现数据的交换,这个连接的一端称为一个socket。... 但它的不凡之处就在于:该请求成功连接一个socket以后,将会保持这个连接的状态,而普通的get/post等请求则是随着http的断开而断开。这时候,可以调用`wx.onSocketOpen`这个API监听websocket连接打开事件:```wx.o...

特惠活动

特惠活动

kafka监听socket-优选内容

kafka监听socket-优选内容

kafka监听socket-相关内容

kafka监听socket-相关内容

实时规则引擎

1. 功能概述 系统提供实时规则引擎能力,用户可以实时监测标签、行为和分群的变化的数据,根据用户设定的筛选条件,借助实时规则引擎将符合条件的结果以kafka消息形式(行为表数据格式)形成信号自动推送给下游系统。主... 4.1.2 配置监听实时数据规则若选择通过 实时标签 配置规则:结果值:只关心当前值结果--打上xx标签值,即发信号,例如打上会员标签,立即触发信号。 前后值变化:一段时间内,由a值变为b值,即发信号(可选择是否设定明确...

查看接入点

消息队列 Kafka版实例提供专有网络 VPC 和公网访问方式,不同的网络环境对应不同的接入点。接入消息队列 Kafka版收发消息时,需要根据网络环境和认证机制选择对应的接入点。本文档介绍不同接入点的区别及查看接入点的... 降低了数据和消息被监听和窃取的可能。 Kafka 实例接入点在不同网络类型下,Kafka 实例提供以下接入点供您选择,您可以根据业务对安全性能的要求选择不同的接入方式。 网络类型 接入点类型 协议 说明 私有网络 V...

SDK更新日志

支持 Android Gradle Plugin 8 版本插件2.HTTPS 请求支持设置 SSLSocketFactory3.预置事件 Launch 和 Terminate 支持关闭4.剪切板访问代码支持插件移除 iOS: V6.16.31.不再采集 carrier 和 mcc_mnc 属性2.预置事件... 2022年10月18日 web: V5.1.3新增hash路由监听; 支持AB多链接实验回退; 支持AB跨域名存储数据; 客户端打通参数由Native变更为enable_native; 2022年10月14日 iOS: V6.13.1新增拉取DataTester实验方法,支持设置超...

SDK更新日志

支持 Android Gradle Plugin 8 版本插件2.HTTPS 请求支持设置 SSLSocketFactory3.预置事件 Launch 和 Terminate 支持关闭4.剪切板访问代码支持插件移除 iOS: V6.16.31.不再采集 carrier 和 mcc_mnc 属性2.预置事件... 2022年10月18日 web: V5.1.3新增hash路由监听; 支持AB多链接实验回退; 支持AB跨域名存储数据; 客户端打通参数由Native变更为enable_native; 2022年10月14日 iOS: V6.13.1新增拉取DataTester实验方法,支持设置超...

干货|字节跳动流式数据集成基于Flink Checkpoint两阶段提交的实践和优化(2)

> > > 字节跳动开发套件数据集成团队(DTS ,Data Transmission Service)在字节跳动内基于 Flink 实现了流批一体的数据集成服务。其中一个典型场景是 Kafka/ByteMQ/RocketMQ -> HDFS/Hive 。Kafka/ByteMQ/RocketMQ... `.SocketTimeoutException`一直删除失败。在时间点 `18:08:58`删除操作执行成功。而这个时间点也基本与我们在 HDFS trace 数据中发现删除操作的执行记录时间是对应的。通过日志我们发现建立文件以及关闭文件操...

字节跳动流式数据集成基于 Flink Checkpoint 两阶段提交的实践和优化背景

# 背景字节跳动开发套件数据集成团队(DTS ,Data Transmission Service)在字节跳动内基于 Flink 实现了流批一体的数据集成服务。其中一个典型场景是 Kafka/ByteMQ/RocketMQ -> HDFS/Hive 。Kafka/ByteMQ/RocketMQ... 但是由于`java.net``.SocketTimeoutException` 一直删除失败。在时间点`18:08:58` 删除操作执行成功。而这个时间点也基本与我们在 HDFS trace 数据中发现删除操作的执行记录时间是对应的。通过日志我们发现建立文件...

字节跳动云原生微服务多运行时架构实践

监听端口和开发的高性能组件都必须受到严格约束,这比开发一个独立的服务和进程要复杂得多。* 与业务资源存在竞争:对于业务方来说,之前在容器中看到的进程就只有自己,当引入 Sidecar 之后,容器中的资源其实不完全属... DAPR 目前会更多关注基础组件(config/cache/Kafka/……);最后,DAPR 是基于 Kubernetes 原生运维体系实现的。而 ByteRuntime 更多是关注 Sidecar 管理、运维以及如何高效开发,对 Sidecar 的接口和能力没有过多...

Java SDK

然后通过logagent监听磁盘文件,由logagent使用http接口进行上报。 KAFKA 模式 (只支持私有化):适用于同一个网络环境,部署简单,QPS高,稳定性高。由 SDK 直接通过kafka进行上报。 模式 使用场景 部署复杂性 可靠性... 单位是毫秒datarangers.sdk.httpConfig.requestTimeout=10000datarangers.sdk.httpConfig.connectTimeout=10000datarangers.sdk.httpConfig.socketTimeout=20000 单位是sdatarangers.sdk.httpConfig.keepAliveTim...

Java SDK

然后通过logagent监听磁盘文件,由logagent使用http接口进行上报。 KAFKA 模式 (只支持私有化):适用于同一个网络环境,部署简单,QPS高,稳定性高。由 SDK 直接通过kafka进行上报。 模式 使用场景 部署复杂性 可靠性... 单位是毫秒datarangers.sdk.httpConfig.requestTimeout=10000datarangers.sdk.httpConfig.connectTimeout=10000datarangers.sdk.httpConfig.socketTimeout=20000 单位是sdatarangers.sdk.httpConfig.keepAliveTim...