matlab使用cuda

社区干货

社区干货

Linux安装CUDA

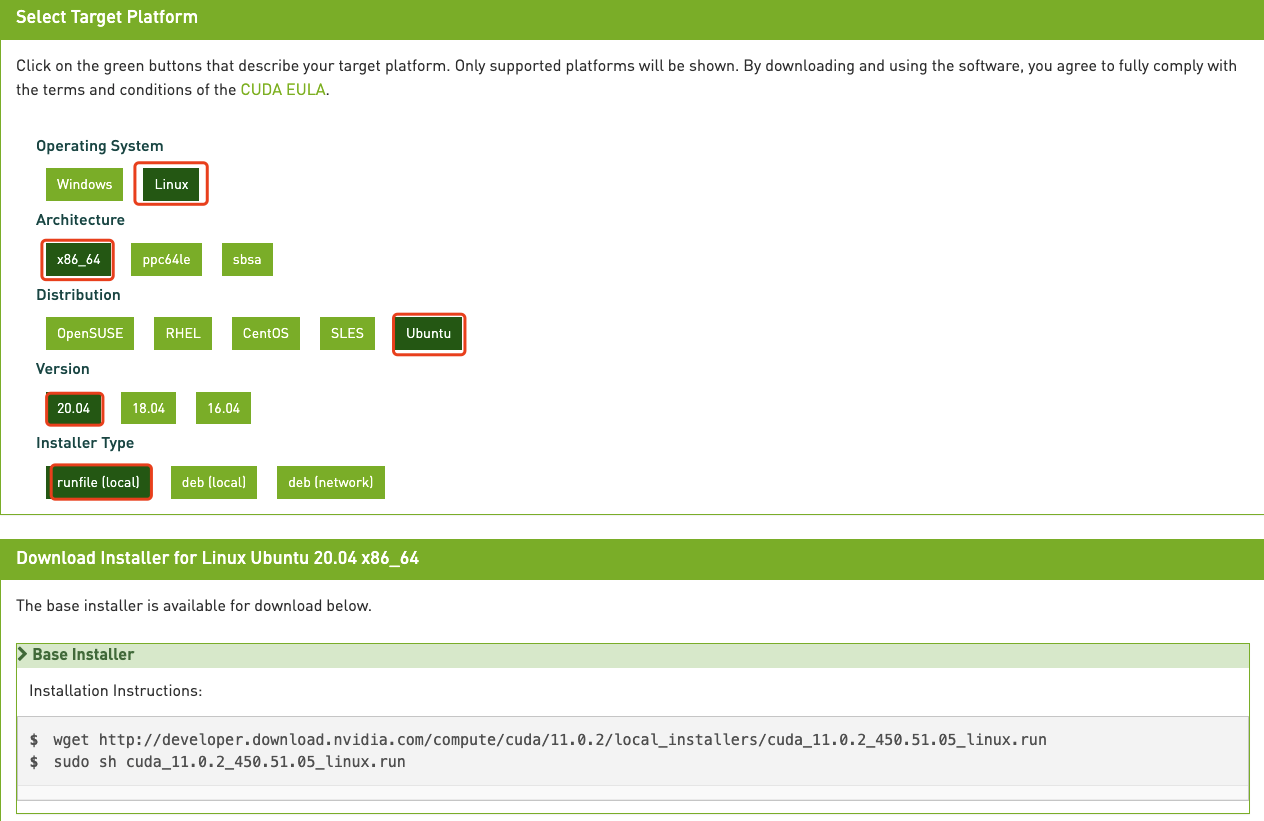

# 运行环境* CentOS* RHEL* Ubuntu* OpenSUSE# 问题描述初始创建的火山引擎实例并没有安装相关cuda软件,需要手动安装。# 解决方案1. 确认驱动版本,以及与驱动匹配的cuda版本,执行命令`nvidia-smi`显示如... 用户需要根据自身操作系统以及网络条件来选择相关配置项,生成不同的安装命令,此处演示为Ubu...

如何对 Linux 操作系统的 GPU 实例进行压测?

# 问题描述Linux 操作系统的 GPU 实例如何进行压力测试以及性能测试?# 问题分析GPU_BURN 是一款开源的软件,可以对 GPU 进行压力测试。GPU 性能测试使用 CUDA sample 自带的 deviceQuery、bandwith 稳定性测试以及性能测试。# 解决方案所有的测试均需要在 GPU 实例上面安装相对应的 cuda 版本,具体请参考如下步骤。## GPU_BURN### 安装GPU_BURN1. GPU_BURN下载以及使用方法参考文档[GPU_BURN下载以及使用方法](http://w...

如何对 Linux 操作系统的 GPU 实例进行压测?

# 问题描述Linux 操作系统的 GPU 实例如何进行压力测试以及性能测试?# 问题分析GPU_BURN 是一款开源的软件,可以对 GPU 进行压力测试。GPU 性能测试使用 CUDA sample 自带的 deviceQuery、bandwith 稳定性测试以及性能测试。# 解决方案所有的测试均需要在 GPU 实例上面安装相对应的 cuda 版本,具体请参考如下步骤。## GPU_BURN### 安装GPU_BURN1. GPU_BURN下载以及使用方法参考文档[GPU_BURN下载以及使用方法](htt...

大模型:深度学习之旅与未来趋势|社区征文

# 前言从去年chatGPT爆火,到国内千模大战,关乎大模型的热度已经沸反盈天。但大模型出现的价值、意义似乎与实际使用效果存在鲜明的对比,特别是日常工作中,最多让大模型帮助生成一些不痛不痒、凑字数的内容,难易触... device = torch.device("cuda" if torch.cuda.is_available() else "cpu") input_tensors = input_tensors.to(device) model.to(device) with torch.no_grad(): outputs = model(input_t...

特惠活动

特惠活动

matlab使用cuda-优选内容

matlab使用cuda-优选内容

matlab使用cuda-相关内容

matlab使用cuda-相关内容

新功能发布记录

如需使用“邀测”产品或功能,请联系客户经理申请。 table th:first-of-type { width: 1%;}table th:nth-of-type(2) { width: 45%;}table th:nth-of-type(3) { width: 14%;}table th:nth-of-type(4) { width: 15%;}table th:nth-of-type(5) { width: 30%;}2024年04月12日序号 功能描述 发布地域 阶段 文档 1 创建GPU云服务器时,支持后台自动安装更高版本的GPU驱动、CUDA和CUDNN库。 全部 商用 驱动安装指引 2023...

GPU-使用Llama.cpp量化Llama2模型

本文以CUDA 12.2为例。 CUDNN:深度神经网络库,用于实现高性能GPU加速。本文以8.5.0.96为例。 运行环境: Transformers:一种神经网络架构,用于语言建模、文本生成和机器翻译等任务。深度学习框架。本文以4.30.2为例。 Pytorch:开源的Python机器学习库,实现强大的GPU加速的同时还支持动态神经网络。本文以2.0.1为例。 Python:执行Llama.cpp的某些脚本所需的版本。本文以Python 3.8为例。 使用说明下载本文所需软件需要访问国...

如何对 Linux 操作系统的 GPU 实例进行压测?

# 问题描述Linux 操作系统的 GPU 实例如何进行压力测试以及性能测试?# 问题分析GPU_BURN 是一款开源的软件,可以对 GPU 进行压力测试。GPU 性能测试使用 CUDA sample 自带的 deviceQuery、bandwith 稳定性测试以及性能测试。# 解决方案所有的测试均需要在 GPU 实例上面安装相对应的 cuda 版本,具体请参考如下步骤。## GPU_BURN### 安装GPU_BURN1. GPU_BURN下载以及使用方法参考文档[GPU_BURN下载以及使用方法](http://w...

如何对 Linux 操作系统的 GPU 实例进行压测?

# 问题描述Linux 操作系统的 GPU 实例如何进行压力测试以及性能测试?# 问题分析GPU_BURN 是一款开源的软件,可以对 GPU 进行压力测试。GPU 性能测试使用 CUDA sample 自带的 deviceQuery、bandwith 稳定性测试以及性能测试。# 解决方案所有的测试均需要在 GPU 实例上面安装相对应的 cuda 版本,具体请参考如下步骤。## GPU_BURN### 安装GPU_BURN1. GPU_BURN下载以及使用方法参考文档[GPU_BURN下载以及使用方法](htt...

GPU-基于Diffusers和Gradio搭建SDXL推理应用

Diffusers Diffusers库是Hugging Face推出的一个操作扩散模型的工具箱,提供Diffusion推理训练全流程,简单方便的使用各种扩散模型生成图像、音频,也可以非常方便的使用各种噪声调度器,用于调节在模型推理中的速度... Pytorch使用CUDA进行GPU加速时,在GPU驱动已经安装的情况下,依然不能使用,很可能是版本不匹配的问题,请严格关注虚拟环境中CUDA与Pytorch的版本匹配情况。 Anaconda:获取包且对包能够进行管理的工具,包含了Conda、P...

大模型:深度学习之旅与未来趋势|社区征文

# 前言从去年chatGPT爆火,到国内千模大战,关乎大模型的热度已经沸反盈天。但大模型出现的价值、意义似乎与实际使用效果存在鲜明的对比,特别是日常工作中,最多让大模型帮助生成一些不痛不痒、凑字数的内容,难易触... device = torch.device("cuda" if torch.cuda.is_available() else "cpu") input_tensors = input_tensors.to(device) model.to(device) with torch.no_grad(): outputs = model(input_t...

GPU-部署Baichuan大语言模型

需保证CUDA版本 ≥ 11.8。 NVIDIA驱动:GPU驱动:用来驱动NVIDIA GPU卡的程序。本文以535.86.10为例。 CUDA:使GPU能够解决复杂计算问题的计算平台。本文以CUDA 12.2为例。 CUDNN:深度神经网络库,用于实现高性能GPU加... Pytorch使用CUDA进行GPU加速时,在CUDA、GPU驱动已经安装的情况下,依然不能使用,很可能是版本不匹配的问题,请严格关注以上软件的版本匹配情况。 使用说明下载本文所需软件需要访问国外网站,建议您增加网络代理(例...

火山引擎部署ChatGLM-6B实战指导

本文档在火山引擎上使用一台两卡A10或A30的 GPU云服务器,利用Conda创建虚拟环境部署ChatGLM-6B模型,并进行模型推理和精调训练的Demo实践。## 准备工作:### 创建GPU云服务器1. 进入ECS云服务器控制台界面,点击创... 操作系统镜像选择Ubuntu 带GPU驱动的镜像,火山引擎默认提供的GPU驱动版本为CUDA11.3,如果需要升级版本的话可以参考后面的步骤,配置GPU服务器。,在GPU上执行时,一个Kernel对应一个Grid,基于GPU逻辑架构分发成众多thread去并行执行。CUDA Stream流:Cuda stream是指一堆异步的cuda操作,他们按照host代码调用的顺序...