Kafka测试容器的不稳定测试

社区干货

社区干货

Kafka数据同步

已购买开通火山引擎Kafka产品3. 消息队列Kafka已绑定公网IP(可参考:https://www.volcengine.com/docs/6439/107774)4. 本地Source Kafa状态正常# 实验说明 [#](https://vsop-online.bytedance.net/doc/manage/detail/6627/detail/?DocumentID=173809#%E5%AE%9E%E9%AA%8C%E8%AF%B4%E6%98%8E)## 步骤1:**本地Kafka创建测试Topic** [#](https://vsop-online.bytedance.net/doc/manage/detail/6627/detail/?DocumentID=173809#...

如何排查消费者无法连接到Kafka问题

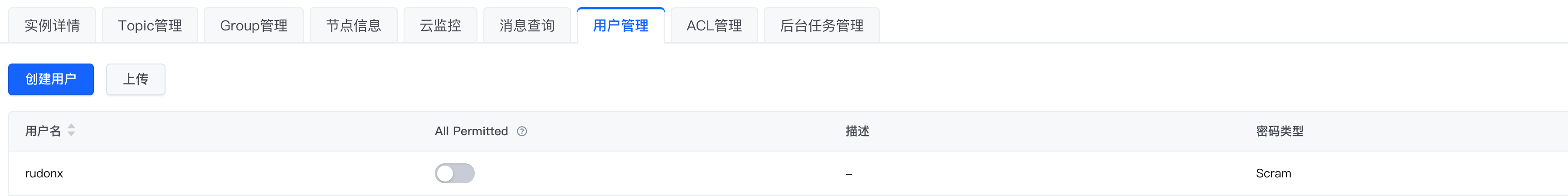

# 问题描述在开发和测试过程中,我们可能会遇到无法连接 Kafka 的情况,本文使用 kafka-console-consumer,来模拟几类常见的连接报错# 环境配置* 密码类型选择 Scram* 使用 SASL_SSL接入点,公网连接,客户端配置文件如下:```Plain Textsasl.jaas.config=org.apache.kafka.common.security.sc...

字节跳动流式数据集成基于 Flink Checkpoint 两阶段提交的实践和优化背景

在字节跳动内基于 Flink 实现了流批一体的数据集成服务。其中一个典型场景是 Kafka/ByteMQ/RocketMQ -> HDFS/Hive 。Kafka/ByteMQ/RocketMQ -> HDFS/Hive(下面均称之为 MQ dump,具体介绍可见 字节跳动基于 Flink 的 MQ-Hive 实时数据集成 ) 在数仓建设第一层,对数据的准确性和实时性要求比较高。目前字节跳动中国区 MQ dump 例行任务数巨大,日均处理流量在 PB 量级。巨大的任务量和数据量对 MQ dump 的稳定性以及准确性带来了...

如何使用iptables实现外网访问VPC内的Kafka

# 问题描述客户想通过外网地址访问 VPC 内的 Kafka 地址进行程序调试,本文展示如果使用iptables转发请求实现外网访问。# 解决方案1.创建一台与 Kafka 同 VPC 的 ECS 服务器,放开安全组 9093 端口同时绑定公网 I... 192.168.1.254 --- 指定的是 Kafka 服务所在 ECS 的机器地址--192.168.1.13 --- 指定的是配置 iptables 的 ECS 的本机的地址 ```3.本地测试访问,使用ECS的公网IP地址* 本地/etc/hosts文件配置...

特惠活动

特惠活动

Kafka测试容器的不稳定测试-优选内容

Kafka测试容器的不稳定测试-优选内容

Kafka测试容器的不稳定测试-相关内容

Kafka测试容器的不稳定测试-相关内容

Kafka订阅埋点数据(私有化)

本文档介绍了在增长分析(DataFinder)产品私有化部署场景下,开发同学如何访问Kafka Topic中的流数据,以便进一步进行数据分析和应用,比如实时推荐等。 1. 准备工作 kafka消费只支持内网环境消费,在开始之前,需要提前... \"title\":\"测试页面\",\"event_index\":1616590857270,\"url\":\"http://demo.com.cn/product/list\",\"url_path\":\"/product/list\"}", "event_name": "predefine_pageview", "session_id": "aa7b79a1-4e27-...

使用 Kafka 协议上传日志

日志服务支持通过 Kafka 协议上传日志数据到服务端,即可以使用 Kafka Producer SDK 来采集日志数据,并通过 Kafka 协议上传到日志服务。本文介绍通过 Kafka 协议将日志上传到日志服务的操作步骤。 背景信息Kafka 作... Kafka 开源 SDK:直接复制各个配置项的取值,并将其填写在 Kafka 开源 SDK 的对应参数中。完整的代码示例请参考示例代码。 Logstash:日志服务自动生成 Logstash 的 Kafka 插件配置,测试插件连通性。详细说明请参考通...

Kafka数据接入

1. 产品概述 Kafka Topic数据能够支持产品实时场景,以下将介绍如何将火山Kafka数据接入CDP。 2. 使用限制 用户需具备 项目编辑 或 权限-按内容管理-模块-数据连接-新建连接 权限,才能新建数据连接。 3. 操作步骤 1.点击 数据融合 > 数据连接 。2.在数据连接目录左上角,点击 新建数据连接 按钮,在跳转的页面选择 火山Kafka 。3. 填写所需的基本信息,并进行 测试连接 。 连接成功后点击 保存 即可。 点击 数据融合>元数据管理 。...

流式导入

ByteHouse 支持通过 Kafka 进行实时数据写入。相比通过引擎进行 Insert 数据,ByteHouse 的 Kafka 导入功能具有以下特点: 支持 at-least-once 语义,可自动切换主备写入,稳定高可用。 数据根据 Kafka Partition 自动... 进行数据源连通性测试,连通成功后,即代表数据源创建成功。 新建导入任务在对应数据源下,单击新建导入任务,进入新建导入任务配置界面,并完成以下信息配置: 参数 说明 通用信息 任务名称 填写导入任务名称信息,...

Kafka数据同步

已购买开通火山引擎Kafka产品3. 消息队列Kafka已绑定公网IP(可参考:https://www.volcengine.com/docs/6439/107774)4. 本地Source Kafa状态正常# 实验说明 [#](https://vsop-online.bytedance.net/doc/manage/detail/6627/detail/?DocumentID=173809#%E5%AE%9E%E9%AA%8C%E8%AF%B4%E6%98%8E)## 步骤1:**本地Kafka创建测试Topic** [#](https://vsop-online.bytedance.net/doc/manage/detail/6627/detail/?DocumentID=173809#...

通过 Kafka 消费火山引擎 Proto 格式的订阅数据

数据库传输服务 DTS 的数据订阅服务支持使用 Kafka 客户端消费火山引擎 Proto 格式的订阅数据。本文以订阅云数据库 MySQL 版实例为例,介绍如何使用 Go、Java 和 Python 语言消费 Canal 格式的数据。 前提条件已注册火山引擎账号并完成实名认证。账号的创建方法和实名认证,请参见如何进行账号注册和实名认证。 已安装 protoc,建议使用 protoc 3.18 或以上版本。 说明 您可以执行 protoc -version 查看 protoc 版本。 用于订阅消...

通过 Kafka 消费 Canal Proto 格式的订阅数据

数据库传输服务 DTS 的数据订阅服务支持使用 Kafka 客户端消费 Canal Proto 格式的订阅数据。本文以订阅云数据库 MySQL 版实例为例,介绍如何使用 Go、Java 和 Python 语言消费 Canal Proto 格式的数据。 前提条件已注册火山引擎账号并完成实名认证。账号的创建方法和实名认证,请参见如何进行账号注册和实名认证。 用于订阅消费数据的客户端需要指定服务端 Kafka 版本号,版本号需为 2.2.x(例如 2.2.2)。您可以在示例代码中指定 K...

如何使用Nginx代理访问VPC内的自建Kafka

前言 对于一些自建在VPC内的Kafka有暴露到外网的需求,那么我们就可以通过Nginx代理来做四层代理,转发请求。 关于实验 预计部署时间:30分钟级别:初级相关产品:同VPC内的ECS两台(1台做Nginx代理,1台做Kafka Server)受... 本实验只部署了单点的Kafka测试,如果是生产环境需要再upstream中添加多个kafka地址。 undefined stream{ upstream brokers{ server 192.168.1.254:9092; } server{ listen 9092; pr...

配置 Kafka 数据源

Kafka 数据源为您提供实时读取和离线读写 Kafka 的双向通道能力,实现不同数据源与 Kafka 数据源之间进行数据传输。本文为您介绍 DataSail 的 Kafka 数据同步的能力支持情况。 1 支持的 Kafka 版本实时读、离线读写... 4.2 新建离线任务Kafka 数据源测试连通性成功后,进入到数据开发界面,开始新建 Kafka 相关通道任务。新建任务方式详见离线数据同步、流式数据同步。 4.3 可视化配置说明任务创建成功后,您可根据实际场景,配置 Ka...