分别配置Spark和Hadoop(Spark与Hadoop的哪个版本)

社区干货

社区干货

万字长文,Spark 架构原理和 RDD 算子详解一网打进! | 社区征文

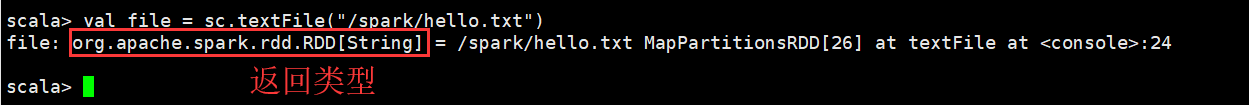

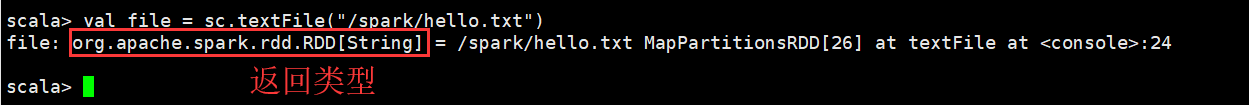

## 一、Spark 架构原理```### 3.2...

干货 |揭秘字节跳动基于 Doris 的实时数仓探索

> 火山引擎 EMR 作为一款云原生开源大数据平台产品,集成了包括 Hadoop、Spark、Flink 等引擎,并做到100%开源兼容。Doris 作为 OLAP 领域中一款极具代表性的开源组件,也被集成到了火山引擎 EMR 产品生态中。> 本文... 我们这个功能还没和社区合并,社区现在最新版本的 unique key 实现有了很大的优化,我们还是基于老版本去实现的。后续我们也计划基于新的 unique key 模型,将多流 Upsert 能力也贡献到社区中去。![picture.image]...

干货|字节跳动数据技术实战:Spark性能调优与功能升级

文章会为大家讲解字节跳动 **在Spark技术上的实践** ——LAS Spark的基本原理,分析该技术相较于社区版本如何实现性能更高、功能更多,为大家揭秘该技术做到极致优化的内幕,同时,还会为大家带来团队关于LAS Spark技... 全面覆盖Spark的各个阶段;从硬件层面探索Spark On GPU的可能性等。 **第三,LAS Spark将发力智能数仓,**主要基于智能参数配置(PBO)、智能物化列/物化视图构建、智能数据分布(LocalSort、Bucket、MergeFi...

揭秘字节跳动基于 Doris 的实时数仓探索

火山引擎 EMR 作为一款云原生开源大数据平台产品,集成了包括 Hadoop、Spark、Flink 等引擎,并做到100%开源兼容。Doris 作为 OLAP 领域中一款极具代表性的开源组件,也被集成到了火山引擎 EMR 产品生态中。本文来源... 我们这个功能还没和社区合并,社区现在最新版本的 unique key 实现有了很大的优化,我们还是基于老版本去实现的。后续我们也计划基于新的 unique key 模型,将多流 Upsert 能力也贡献到社区中去。![picture.image]...

特惠活动

特惠活动

分别配置Spark和Hadoop(Spark与Hadoop的哪个版本)-优选内容

分别配置Spark和Hadoop(Spark与Hadoop的哪个版本)-优选内容

分别配置Spark和Hadoop(Spark与Hadoop的哪个版本)-相关内容

分别配置Spark和Hadoop(Spark与Hadoop的哪个版本)-相关内容

创建集群

为您提供 Hadoop、Spark、Hive、Flink、Hudi、Iceberg 等生态组件集成和管理。详见服务开发指南。本文将为您介绍在 EMR 控制台创建集群的操作步骤和相关配置。 1 前提条件已完成IAM跨服务授权: 首次登录 EMR 详情页... 下拉选择地域和项目空间: 地域:创建的集群及相应资源均会部署在对应地域内,不可修改。 项目空间:系统已自动创建 default 的默认项目,您可通过下方路径,新建属于您的项目空间: 通过界面右上角用户 > 访问控制 > 资...

迁移指南说明

越来越多的企业发现了大数据处理和分析框架的力量,如 Apache Hadoop 和 Apache Spark,但他们也发现了这些技术的一些挑战。尤其重要的是,随着大数据行业的快速变化,许多客户需要一个安全且长期的平台来支持业务快速... 您可以结合实际业务场景进行选择: 架构重构 迁移源端 Hadoop 集群至火山 EMR 过程中,可以考虑系统重构您的大数据平台,使得迁移收益最大化。重构包括软件版本升级、替换,来获得新特性和高性能,调整作业调度、配置规...

基础使用

不同的EMR版本使用了不同的Hudi版本,具体信息如下: Hudi 版本 EMR 版本 Hudi 0.10.0 EMR 1.3.1 Hudi 0.11.1 EMR 3.0.1 ~ EMR 3.1.1EMR 2.0.1 ~ EMR 2.2.0 Hudi 0.12.2 EMR 3.2.1 ~ EMR 3.8.1EMR 2.3.1 ~ EMR 2.4.0 Hudi 0.14.1 EMR 3.9.1+ 接下来将为您介绍 Hudi 的安装,并通过 Spark SQL 快速上手 Hudi 表和通过 Flink SQL 创建 Catalog/Table 相关内容。 1 Hudi 安装Hudi 在创建 Hadoop 集群过程中作为可选组件安装,集群创...

万字长文,Spark 架构原理和 RDD 算子详解一网打进! | 社区征文

## 一、Spark 架构原理```### 3.2...

功能发布记录

发布时间 版本号 主要更新 2024 年 3 月 14 日 v 1.8.1 支持Spark Rapids,优化概览界面,提升平台稳定性。 2023 年 10 月 26 日 v 1.8.0 支持Presto on Bolt,Bytelake 升级为2.0版本,开放Managed Hive文件路径 。 2023 年 7 月 13 日 v 1.7.1 提供 Hadoop HDFS/Hive 迁移工具,Hive 内部表类型,无缝迁移。 2023 年 5 月 16 日 v 1.7.0 支持数据冷热分层(廉价冷存储)、支持数据脱敏、支持查询血缘。 2023 年 2 月 23 日 v 1.6.0 支持...

集成示例

输入对应的用户名和密码信息,确认后进入 Web UI 界面。创建用户请参阅快速开始---创建用户。 在上方导航栏中,单击资源中心按钮,进入资源文件夹管理界面。 在文件管理界面,单击上传文件按钮,从本地选择对应文件,单击确定按钮,完成资源上传。 3 数据源中心在运行 Spark SQL、Hive SQL 类型任务时,DolphinScheduler 要求在数据源中心中预先配置好数据源连接信息。这里以 EMR 3.x 版本的 Hadoop 类型集群中配置一个 Spark 数据源...

干货 |揭秘字节跳动基于 Doris 的实时数仓探索

> 火山引擎 EMR 作为一款云原生开源大数据平台产品,集成了包括 Hadoop、Spark、Flink 等引擎,并做到100%开源兼容。Doris 作为 OLAP 领域中一款极具代表性的开源组件,也被集成到了火山引擎 EMR 产品生态中。> 本文... 我们这个功能还没和社区合并,社区现在最新版本的 unique key 实现有了很大的优化,我们还是基于老版本去实现的。后续我们也计划基于新的 unique key 模型,将多流 Upsert 能力也贡献到社区中去。![picture.image]...

干货|字节跳动数据技术实战:Spark性能调优与功能升级

文章会为大家讲解字节跳动 **在Spark技术上的实践** ——LAS Spark的基本原理,分析该技术相较于社区版本如何实现性能更高、功能更多,为大家揭秘该技术做到极致优化的内幕,同时,还会为大家带来团队关于LAS Spark技... 全面覆盖Spark的各个阶段;从硬件层面探索Spark On GPU的可能性等。 **第三,LAS Spark将发力智能数仓,**主要基于智能参数配置(PBO)、智能物化列/物化视图构建、智能数据分布(LocalSort、Bucket、MergeFi...

高阶使用

1.1 集成配置本段主要介绍如何使用 Spark ThriftServer 配置连接 Hudi。 说明 目前只有EMR 2.x版本才支持Spark ThriftServer。 登录 EMR 控制台。 在左侧导航栏中,进入集群详情 > 服务列表 > Spark > 服务参数界... 1.3.1 上传数据集 通过 scp/或者其它方式上传数据集到集群 bash scp lineitem_small.tbl root@master_ip登陆集群进行上传 bash ssh master_ip export HADOOP_USER_NAME=hive hadoop fs -mkdir /user/hive/lineite...