Spark异常:作业因阶段失败而中止。造成此问题的原因是:java.lang.ArrayIndexOutOfBoundsException。

社区干货

社区干货

万字长文,Spark 架构原理和 RDD 算子详解一网打进! | 社区征文

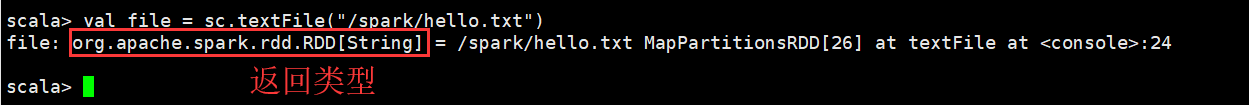

## 一、Spark 架构原理```### 3.2 通过并行化的方式创建RDD由一个已经存在的Scala集合创建。```cppscala> val array = Array(1,2...

干货|字节跳动数据技术实战:Spark性能调优与功能升级

这种场景主要是因为Spark任务的最后一个stage并行度较大导致,如下左图,InsertInto之前的最后一个Operator的并行度为7,则最终也会产出7个文件。==================================================================================================================================================解决这种问题的思路也比较简单,直接在Operator和InsertInto算子之间增加一个 Exchange算子,做一次整体Shuffle,将7个并行度...

干货|火山引擎DataTester:5个优化思路,构建高性能A/B实验平台

AND arraySetCheck(ab_version, (29282)) AND event_date >= '2021-05-10' AND event_date <= '2021-05-19' AND multiIf(se... 因为clickhouse最擅长的是单表查询和多维度分析,如果做一些轻量级聚合把结果做到单表上,性能可以极大提升。也就是把join提前到数据构建阶段,构建好的数据就是join好的数据。* 需要join的场景,则通过减小右表大小来...

Spark AQE SkewedJoin 在字节跳动的实践和优化

# 1. 概述本文将首先介绍 Spark AQE SkewedJoin 的基本原理以及字节跳动在使用 AQE SkewedJoin 的实践中遇到的一些问题;其次介绍针对遇到的问题所做的相关优化和功能增强,以及相关优化在字节跳动的收益;此外,我们... MapStatus维护了一个 Array[Long],记录了该 MapTask 中属于下游每一个 ReduceTask 的数据大小。当 Driver 收集到了所有的 MapTask 的MapStatu之后,就能够计算得到每一个 ReduceTask 的输入数据量,以及分属于每一个...

特惠活动

特惠活动

Spark异常:作业因阶段失败而中止。造成此问题的原因是:java.lang.ArrayIndexOutOfBoundsException。-优选内容

Spark异常:作业因阶段失败而中止。造成此问题的原因是:java.lang.ArrayIndexOutOfBoundsException。-优选内容

Spark异常:作业因阶段失败而中止。造成此问题的原因是:java.lang.ArrayIndexOutOfBoundsException。-相关内容

Spark异常:作业因阶段失败而中止。造成此问题的原因是:java.lang.ArrayIndexOutOfBoundsException。-相关内容

Spark批式读写Iceberg

Apache Spark 是一种用于大数据工作负载的分布式开源处理系统。本文以 Spark 3.x 操作Iceberg表为例,介绍如何通过 Spark API 以批处理的方式读写 Iceberg 表。 1 前提条件适合 E-MapReduce(EMR) 1.2.0以后的版本(包... package com.bytedanceimport org.apache.spark.SparkConfimport org.apache.spark.sql.SparkSessionobject IcebergSparkScalaExample { def main(args: Array[String]): Unit = { // 配置使用数据湖元数据。...

Spark流式读写 Iceberg

流式写入 Spark Structured Streaming 通过 DataStreamWriter 接口流式写数据到 Iceberg 表,代码如下。 val tableIdentifier: String = "iceberg.iceberg_db.streamingtable"val checkpointPath: String = "/tmp/iceberg_checkpointPath"data.writeStream .format("iceberg") .outputMode("append") .trigger(Trigger.ProcessingTime(1, TimeUnit.MINUTES)) .option("path", tableIdentifier) .option("checkpoin...

通过 Spark Streaming 消费日志

日志服务提供 Kafka 协议消费功能,您可以使用 Spark Streaming 的 spark-streaming-kafka 组件对接日志服务,通过 Spark Streaming 将日志服务中采集的日志数据消费到下游的大数据组件或者数据仓库。 场景概述Spark... []) Arrays.asList(ConsumerRecord.class).toArray());// 每隔5秒钟,sparkStreaming作业就会收集最近5秒内的数据源接收过来的数据JavaStreamingContext jssc = new JavaStreamingContext(conf, Durations.seconds(...

干货|火山引擎DataTester:5个优化思路,构建高性能A/B实验平台

AND arraySetCheck(ab_version, (29282)) AND event_date >= '2021-05-10' AND event_date <= '2021-05-19' AND multiIf(se... 因为clickhouse最擅长的是单表查询和多维度分析,如果做一些轻量级聚合把结果做到单表上,性能可以极大提升。也就是把join提前到数据构建阶段,构建好的数据就是join好的数据。* 需要join的场景,则通过减小右表大小来...

Spark AQE SkewedJoin 在字节跳动的实践和优化

# 1. 概述本文将首先介绍 Spark AQE SkewedJoin 的基本原理以及字节跳动在使用 AQE SkewedJoin 的实践中遇到的一些问题;其次介绍针对遇到的问题所做的相关优化和功能增强,以及相关优化在字节跳动的收益;此外,我们... MapStatus维护了一个 Array[Long],记录了该 MapTask 中属于下游每一个 ReduceTask 的数据大小。当 Driver 收集到了所有的 MapTask 的MapStatu之后,就能够计算得到每一个 ReduceTask 的输入数据量,以及分属于每一个...

Iceberg 基础使用(适用于EMR2.x版本)

本文介绍在 E-MapReduce(EMR) 集群2.x版本中,采用 Spark DataFrame API 方式对 Iceberg 表进行创建等操作。 1 前提条件需要在 EMR 集群上安装 Iceberg 组件。有两种方式可以安装Iceberg组件: 在创建 E-MapReduce 集... import org.apache.iceberg.catalog.TableIdentifierimport org.apache.iceberg.hive.HiveCatalogimport org.apache.iceberg.types.Typesobject IcebergSpark2ScalaExample { def main(args: Array[String]): Uni...

从ClickHouse到ByteHouse:广告业务中的人群预估实践

Spark,甚至业务方还自研过一个系统。其中 Druid、ES、Spark 均不能很好满足所有的需求。自研的系统因为可以高度的定制解决性能问题,但缺乏一定的灵活性。 因此,通过对比我们选择了 ClickHouse。原因主要有两个方面... 离散会导致慢的原因跟 RoaringBitmap64 的实现有关,RoaringBitmap64 是由一系列 RoaringBitmap32 表示,当数据比较稀疏的时候,每个 RoaringBitmap32 内部又由很多个 array container 组成。而对有序数组的交并补...

基于 Flink 构建实时数据湖的实践

上图示例中原始 Schema 是 id、name、age,在 Schema 匹配情况下的写入不会报错,所以 Row 1 可以写入;Row 2 写入时由于长度不符合,所以会报错:Index out of range;Row 3 写入时,由于数据类型不匹配,会报错:Class ca... 怎么在一个作业里写多种 Schema 数据?第一个问题的解决办法可以在 Flink CDC Connector 中可以为每条记录设置包含 Schema 信息。所以我们需要实现一个反序列化方法,输出一条记录,包含 Row 和它对应的 Schema ...

万字长文带你漫游数据结构世界|社区征文

index > size) { throw new IndexOutOfBoundsException("超出链表长度范围"); } ListNode current = new ListNode(element); if (index == 0) { if (head == nu... 栈顶元素则是最后一次放进去的元素。使用数组实现简单的栈(注意仅供参考测试,实际会有线程安全等问题):```Javaimport java.util.Arrays;public class MyStack { private T[] data; private int len...