持续交付支持通过共享 GPU 的方式部署 AI 应用,支持算力与显存的灵活调度和严格隔离,降低 GPU 使用成本。

说明

本文重点介绍创建 AI 应用中 mGPU 功能的相关操作和参数说明。创建 AI 应用的详细参数介绍和操作说明参见 创建和部署 AI 应用(自定义创建)。

功能介绍

mGPU(multi-container GPU)是火山引擎基于内核虚拟化隔离 GPU,并结合自研调度框架提供的容器共享 GPU 方案。在保证性能和故障隔离的前提下,mGPU 支持多个容器共享一张或者多张 GPU 显卡,支持算力与显存的灵活调度和严格隔离,降低 GPU 使用成本,为充分利用 GPU 硬件资源进行训练和推理提供有效保障。

使用限制

仅 ECS 部署场景支持 mGPU 功能。弹性容器 VCI 暂不支持。

前提条件

已创建 VKE 集群,具体操作可参见 创建集群。

操作步骤

第一步:为 GPU 计算型节点配置算力分配策略

- 登录 容器服务控制台。

- 在顶部导航栏中选择您业务所在的地域。

- 在左侧导航栏中选择 集群,单击目标集群名称。

- 为 mGPU 相关节点或节点池,配置算力分配策略。

- 节点池

在集群管理页面的左侧导航栏单击 节点池。

在 节点池 页面,找到已完成 mGPU 相关配置的节点池,单击对应 操作 列下的 编辑。

注意

您也可以在满足配置 mGPU 算力分配策略环境要求(Kubernetes 版本、mgpu 组件版本等)的集群中,创建新的 mGPU 相关 GPU 计算型节点池,同时配置算力分配策略。此时无需重启节点。详细操作,请参见 mGPU 使用方法。

在 更多配置 处设置 节点标签 的 key 为

vke.volcengine.com/mgpu-compute-policy、Value 为fixed-share、guaranteed-burst-share或native-burst-share,表示在该节点池中的节点上,配置 Value 取值对应的算力分配策略。

详细的参数说明,请参见 管理节点池。注意

- 您可以通过开启或关闭节点池的 节点标签及污点自动更新 功能,控制是否同步标签到节点池中的存量节点中。关闭该功能时,可能导致存量节点上的 GPU 算力分配策略与预期不符,请谨慎配置。

- 更改节点池中节点的 mGPU 算力分配策略后,需要重启节点池中的所有 mGPU 相关节点使策略生效。重启节点的操作,请参见 重启实例。

- 不设置算力分配策略时(即不设置

vke.volcengine.com/mgpu-compute-policy节点标签),则默认按fixed-share策略分配算力。

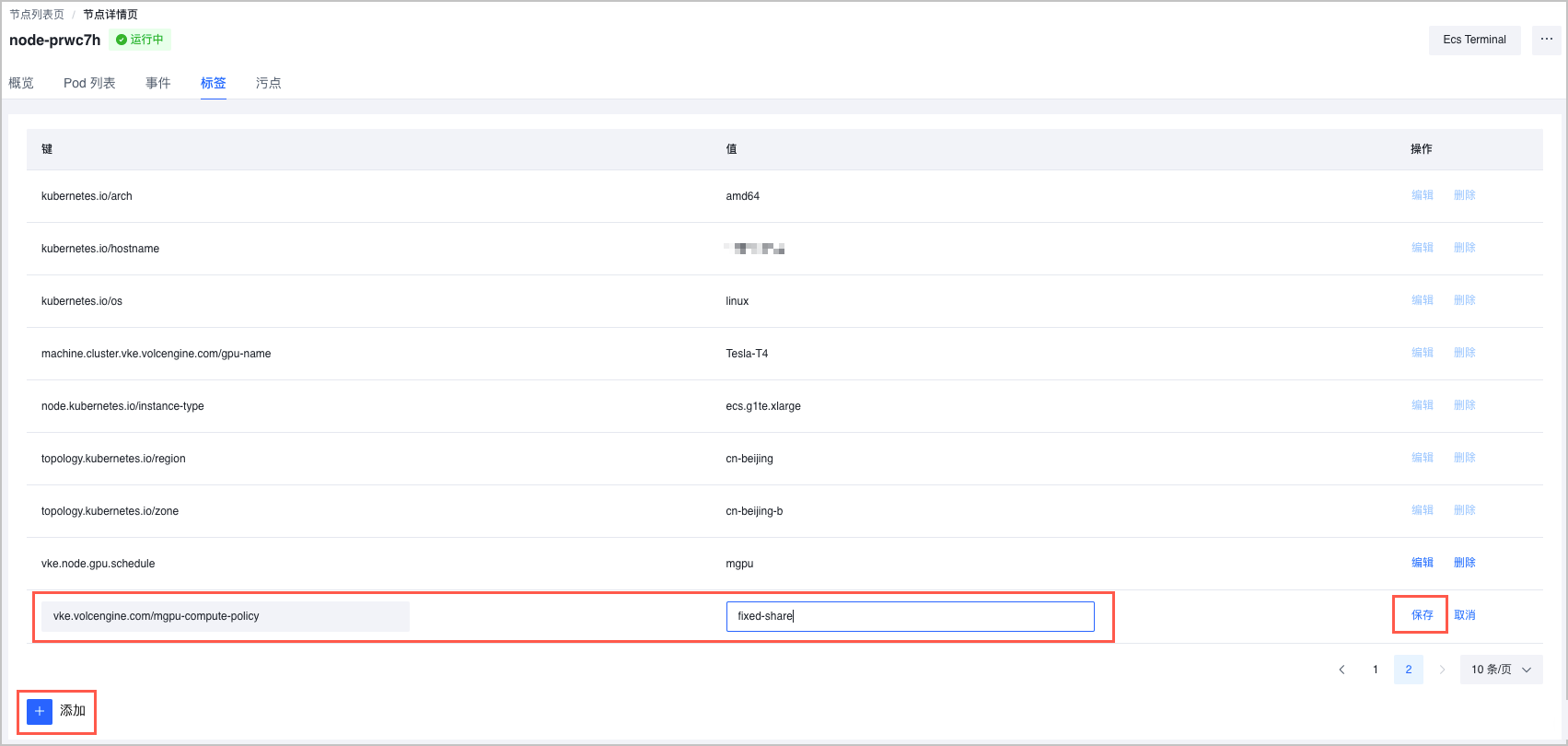

- 节点

在集群管理页面的左侧导航栏中,单击 节点。

在 节点 页面,找到已完成 mGPU 相关配置的节点,选择对应 操作 列下的

...> 标签管理。在 标签 页签,单击 添加标签,在节点标签列表的最后,添加 key 为

vke.volcengine.com/mgpu-compute-policy、Value 为fixed-share、guaranteed-burst-share或native-burst-share的标签,表示在该节点上,配置 Value 取值对应的算力分配策略。

- 更改节点的 mGPU 算力分配策略后,需要重启节点使策略生效。重启节点的操作,请参见 重启实例。

vke.volcengine.com/mgpu-compute-policy属于系统标签,节点上添加系统标签后不允许修改 Value 值。- 不设置算力分配策略时(即不设置

vke.volcengine.com/mgpu-compute-policy节点标签),则默认按fixed-share策略分配算力。

- 节点池

第二步:通过 mGPU 部署 AI 应用

登录 持续交付控制台。

在左侧导航栏选择 AI 应用。

在 AI 应用页面,单击 创建应用。

选择 自定义创建 模板,并单击 下一步:应用配置。

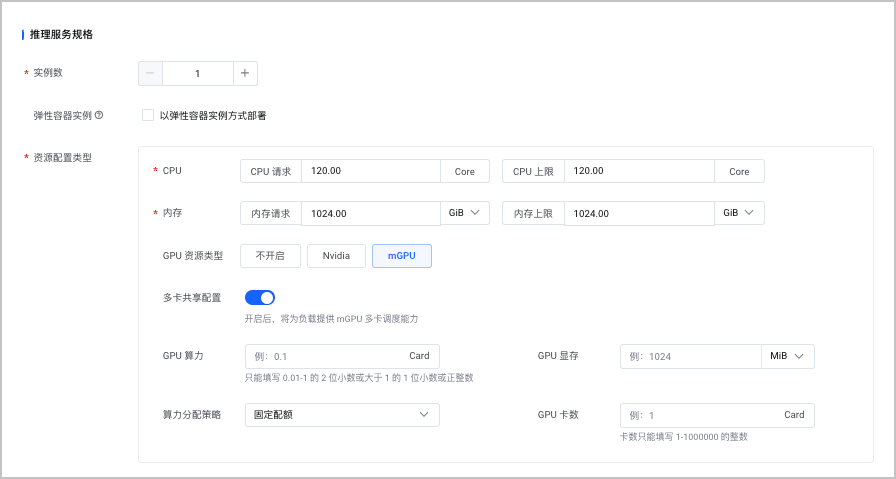

在 部署环境及规格 > 推理服务规格,配置 mGPU 相关参数。本文重点介绍 mGPU 相关参数,创建 AI 应用的详细参数介绍和操作说明参见 创建和部署 AI 应用(自定义创建)。

配置项 说明 实例数 根据业务规模,设置应用的副本数。 弹性容器实例 不勾选 弹性容器实例。仅 ECS 部署场景支持 mGPU 功能。弹性容器实例 VCI 暂不支持。 资源配置类型

- CPU:定义每个实例的 CPU 规格。其中,CPU 请求 ≤ CPU 上限。

- 内存:定义每个实例的 CPU 内存规格。其中,内存请求 ≤ 内存上限。

- GPU 资源类型:选择 mGPU。

- 多卡共享配置:不开启,为多负载共享单 GPU。开启后,支持为负载提供多 GPU 卡的调度能力。

- GPU 算力:填写分配的算力大小。支持正整数或者 [0.01,1) 的 2 位小数。

- GPU 显存:填写分配的显存大小。单卡共享需要大于 256MiB,多卡共享需要大于 1024MiB。

- 算力分配策略: mGPU 支持多种算力分配策略,以满足不同的使用场景。

- 固定配额:每个容器都有固定的算力配额,在容器运行过程中即使 GPU 还有剩余算力,也无法超过固定算力配额。

- 固定争抢:每个容器都有保底的算力配额,但只要 GPU 还有空闲算力,就可以被容器使用。

- 争抢模式:可设置算力配额,设置的值越高,可争抢到的配额越高,但不保证每个容器都能争抢到与已设置的算力配额相同的配额。

- GPU 卡数:

完成后单击 确定,应用将开始创建并部署。

后续操作

配置 mGPU 算力分配策略后,可查看 mGPU 的各项监控指标。详细操作,请参见 查看 mGPU 监控指标。