Kafka集群长时间宕机后,消费者能够恢复吗?

社区干货

社区干货

Kafka@记一次修复Kafka分区所在broker宕机故障引发当前分区不可用思考过程 | 社区征文

怀疑是Kafka某个节点有问题-失联-假死?## 思考过程从这个表象来看,某台机器有过宕机事件,宕机原因因环境而异,但Kafka的高可用性HA我们是耳熟能详的,为啥我们搭建的Kafka集群由多个节点组成,但其中某个节点宕掉,整个分区就不能正常使用-消费者端无法订阅到消息。 首先,我们来看下Kafka的配置信息:```js[root@xx-xx-xxx-xx kafka_2.11-2.1.1]# nohup bin/kafka-server-start.sh config/server.properties & ```!...

聊聊 Kafka:Topic 创建流程与源码分析 | 社区征文

一个或多个订阅这些事件的消费者。可以根据需要随时读取主题中的事件——与传统消息传递系统不同,事件在消费后不会被删除。相反,您可以通过每个主题的配置设置来定义 Kafka 应该保留您的事件多长时间,之后旧事件将... 副本数是必须小于集群的 Broker 数的,副本只有设置在不同的机器上才有作用。## 二、Topic 的创建方式### 2.1 zookeeper 方式(不推荐)```./bin/kafka-topics.sh --create --zookeeper localhost:2181 --part...

Kafka 消息传递详细研究及代码实现|社区征文

本文将研究 Kafka 从生产、存储到消费消息的详细过程。 ## Producer### 消息发送所有的 Kafka 服务器节点任何时间都能响应是否可用、是否 topic 中的 partition leader,这样生产者就能发送它的请求到服务器... 发送了一条/批消息之后,需要什么条件或者需要等待多久才能发送下一条消息呢,发送失败会重试吗?......Kafka Documentation 中 *[Producer Configs](https://kafka.apache.org/documentation/#producerconfigs)* ...

消息队列选型之 Kafka vs RabbitMQ

对此本文将在接下来的内容中以 Kafka 和 RabbitMQ 为例分享消息队列选型的一些经验。消息队列即 Message+Queue,消息可以说是一个数据传输单位,它包含了创建时间、通道/主题信息、输入参数等全部数据;队列(Queue)是一种 FIFO(先进先出)的数据结构,编程语言一般都内置(内存中的)队列实现,可以作为进程间通讯(IPC)的方法。使用队列最常见的场景就是生产者/消费者模式:生产者生产消息放到队列中,消费者从队列里面获取消息消费。典型...

特惠活动

特惠活动

Kafka集群长时间宕机后,消费者能够恢复吗?-优选内容

Kafka集群长时间宕机后,消费者能够恢复吗?-优选内容

Kafka集群长时间宕机后,消费者能够恢复吗?-相关内容

Kafka集群长时间宕机后,消费者能够恢复吗?-相关内容

聊聊 Kafka:Topic 创建流程与源码分析 | 社区征文

一个或多个订阅这些事件的消费者。可以根据需要随时读取主题中的事件——与传统消息传递系统不同,事件在消费后不会被删除。相反,您可以通过每个主题的配置设置来定义 Kafka 应该保留您的事件多长时间,之后旧事件将... 副本数是必须小于集群的 Broker 数的,副本只有设置在不同的机器上才有作用。## 二、Topic 的创建方式### 2.1 zookeeper 方式(不推荐)```./bin/kafka-topics.sh --create --zookeeper localhost:2181 --part...

Kafka 消息传递详细研究及代码实现|社区征文

本文将研究 Kafka 从生产、存储到消费消息的详细过程。 ## Producer### 消息发送所有的 Kafka 服务器节点任何时间都能响应是否可用、是否 topic 中的 partition leader,这样生产者就能发送它的请求到服务器... 发送了一条/批消息之后,需要什么条件或者需要等待多久才能发送下一条消息呢,发送失败会重试吗?......Kafka Documentation 中 *[Producer Configs](https://kafka.apache.org/documentation/#producerconfigs)* ...

消息队列选型之 Kafka vs RabbitMQ

对此本文将在接下来的内容中以 Kafka 和 RabbitMQ 为例分享消息队列选型的一些经验。消息队列即 Message+Queue,消息可以说是一个数据传输单位,它包含了创建时间、通道/主题信息、输入参数等全部数据;队列(Queue)是一种 FIFO(先进先出)的数据结构,编程语言一般都内置(内存中的)队列实现,可以作为进程间通讯(IPC)的方法。使用队列最常见的场景就是生产者/消费者模式:生产者生产消息放到队列中,消费者从队列里面获取消息消费。典型...

流式导入

后即可立即访问。同时可以随时停止数据导入任务以减少资源使用,并在任何必要的时候恢复该任务。ByteHouse 将在内部记录 offset,以确保停止/恢复过程中不会丢失数据。当前已经支持的 Kafka 消息格式为: JSON Protobuf 支持的 Kafka/Confluent Cloud 版本:0.10 及以上 必备权限要将 Kafka 数数据迁移到ByteHouse,需要确保 Kafka 和 ByteHouse 之间的访问权限配置正确。需要在Kafka中授予4个权限: 列出主题 (Topics) 列出消费者组 (...

Topic 和 Group 管理

为什么消息的存储时间显示为 1970? 为什么消息在 Topic 分区中分布不均衡? 为什么 Group 的订阅关系显示为空? 为什么 Group 列表中多了一些 Group?通过消息队列 Kafka版控制台或 OpenAPI 查看指定实例的 Group 列... 那么也会在 Kafka 集群上创建对应的 Group。 为什么 Group 会被自动删除?消息队列 Kafka版支持自动删除 Group(auto.delete.group) 功能,您可以设置后端服务是否自动删除 Empty 状态的消费组。开启后,如果消费者组...

字节跳动新一代云原生消息队列实践

Kafka 版本最大的差别在于我们将其从 Broker 中独立,作为单独的进程提供服务。这样的好处是读写流量与消费者协调的资源可以完全隔离,不会互相影响。另外 Coordinator 可以独立扩缩容,以应对不同集群的情况。* Con... 可以秒级将流量调度到健康节点恢复服务。### 数据存储模型在分层之后 **数据存储模型上的优势** ,主要体现在 BMQ 中,一个 Partition 的数据会和 Kafka 一样被切分为若干个 Segment,Kafka 中的这些 Segment ...

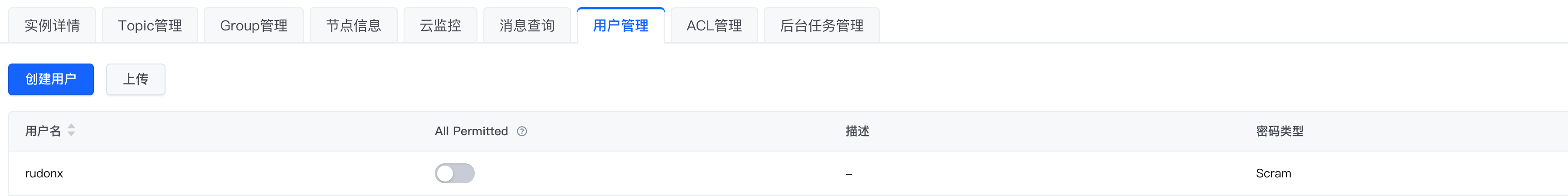

如何排查消费者无法连接到Kafka问题

# 问题描述在开发和测试过程中,我们可能会遇到无法连接 Kafka 的情况,本文使用 kafka-console-consumer,来模拟几类常见的连接报错# 环境配置* 密码类型选择 Scram* 使用 SASL_SSL接入点,公网连接,客户端配置文件如下:```Plain Textsasl.jaas.config=org.apache.kafka.common.security.sc...

重置消费位点

根据时间点重置:从过去的某个指定时段内选择一个时间点开始消费。该时间段由 Topic 的消息保留时间决定。 根据指定 offset 位点重置:从当前分区的某个指定位点开始消费。重置后,Group 在当前分区中将指定位点开始消费。 前提条件消息队列 Kafka版不支持在线重置消费位点,在重置消费位点之前,必须停止 Consumer Group 中的所有消费者客户端,确保 Group 的状态为 Empty。 停止消费者客户端后,需要经过指定的超时时间,服务端才认为...

Kafka 迁移上云(方案一)

本文介绍通过方案一将开源 Kafka 集群迁移到火山引擎消息队列 Kafka版的操作步骤。 注意事项业务迁移只迁移消息生产、消费链路和业务流量,并不会迁移 Kafka 旧集群上的消息数据。 创建Kafka实例、迁移消息收发链路... 云上和云下双集群同步处理消息消费,无法保证消费的有序性。迁移步骤如下: 启动新的消费者和生产者。为新建的消息队列 Kafka版实例开启新的消费者和生产者,在云端搭建新的消息生产和消费流程,并启动消息的生产与消费...