暂停Camel KafkaConsumer

社区干货

社区干货

如何排查消费者无法连接到Kafka问题

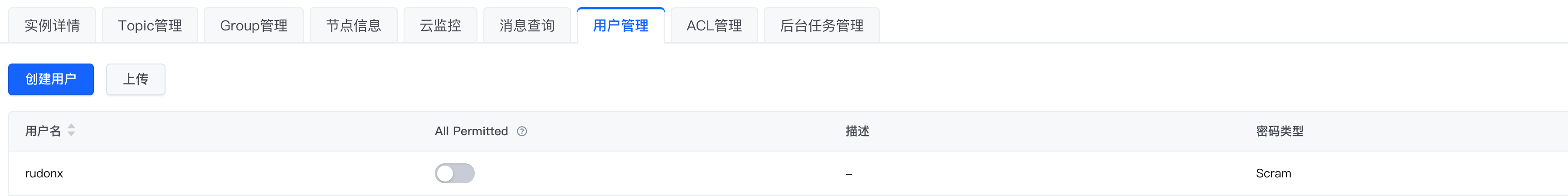

# 问题描述在开发和测试过程中,我们可能会遇到无法连接 Kafka 的情况,本文使用 kafka-console-consumer,来模拟几类常见的连接报错# 环境配置* 密码类型选择 Scram* 使用 SASL_SSL接入点,公网连接,客户端配置文件如下:```Plain Textsasl.jaas.config=org.apache.kafka.common.security.sc...

Kafka 消息传递详细研究及代码实现|社区征文

## 背景新项目涉及大数据方面。之前接触微服务较多,趁公司没反应过来,赶紧查漏补缺。Kafka 是其中之一。Apache Kafka 是一个开源的分布式事件流平台,可跨多台计算机读取、写入、存储和处理事件,并有发布和订阅事... consumer = new KafkaConsumer<>(properties);// 订阅 topicconsumer.subscribe(Collections.singletonList("Topic")); try { // noinspection InfiniteLoopStatement while (true) { ...

消息队列选型之 Kafka vs RabbitMQ

在面对众多的消息队列时,我们往往会陷入选择的困境:“消息队列那么多,该怎么选啊?Kafka 和 RabbitMQ 比较好用,用哪个更好呢?”想必大家也曾有过类似的疑问。对此本文将在接下来的内容中以 Kafka 和 RabbitMQ 为例分... 红包 Platform 通过 MQ 通知红包 Consumer 实现异步转账,同时有兜底 Task 查询转账所有未到终态领取单并通过 MQ 异步发送转账消息。 **解耦**其次通过使用消息队列,发送方和接收方可以解耦,彼此之...

Kafka@记一次修复Kafka分区所在broker宕机故障引发当前分区不可用思考过程 | 社区征文

包括不限于改Kafka,主题创建删除,Zookeeper配置信息重启服务等等,于是我们来一起看看... Ok,Now,我们还是先来一步步分析它并解决它,依然以”化解“的方式进行,我们先来看看业务进程中线程报错信息:```jsorg.apache.kafka.clients.NetworkClient : [Consumer clientId=consumer-1, groupId=xxxx-center] 1 partitions have leader brokers without a matching listener, including [xxxx-xxxx-xxxx-message-0]```!...

特惠活动

特惠活动

暂停Camel KafkaConsumer-优选内容

暂停Camel KafkaConsumer-优选内容

暂停Camel KafkaConsumer-相关内容

暂停Camel KafkaConsumer-相关内容

Kafka 消息传递详细研究及代码实现|社区征文

## 背景新项目涉及大数据方面。之前接触微服务较多,趁公司没反应过来,赶紧查漏补缺。Kafka 是其中之一。Apache Kafka 是一个开源的分布式事件流平台,可跨多台计算机读取、写入、存储和处理事件,并有发布和订阅事... consumer = new KafkaConsumer<>(properties);// 订阅 topicconsumer.subscribe(Collections.singletonList("Topic")); try { // noinspection InfiniteLoopStatement while (true) { ...

通过 Kafka 协议消费日志

可以将日志主题作为 Kafka 的 Topic 进行消费,每条日志对应一条 Kafka 消息。在实际的业务场景中,通过开源 Kafka SDK 成功对接日志服务后,可以使用 Kafka Consumer 将采集到指定日志主题的日志数据消费到下游的大数... import org.apache.kafka.clients.consumer.ConsumerRecord;import org.apache.kafka.clients.consumer.ConsumerRecords;import org.apache.kafka.clients.consumer.KafkaConsumer;import org.apache.kafka.common...

消息队列选型之 Kafka vs RabbitMQ

在面对众多的消息队列时,我们往往会陷入选择的困境:“消息队列那么多,该怎么选啊?Kafka 和 RabbitMQ 比较好用,用哪个更好呢?”想必大家也曾有过类似的疑问。对此本文将在接下来的内容中以 Kafka 和 RabbitMQ 为例分... 红包 Platform 通过 MQ 通知红包 Consumer 实现异步转账,同时有兜底 Task 查询转账所有未到终态领取单并通过 MQ 异步发送转账消息。 **解耦**其次通过使用消息队列,发送方和接收方可以解耦,彼此之...

流式导入

同时可以随时停止数据导入任务以减少资源使用,并在任何必要的时候恢复该任务。ByteHouse 将在内部记录 offset,以确保停止/恢复过程中不会丢失数据。当前已经支持的 Kafka 消息格式为: JSON Protobuf 支持的 Kafka/Confluent Cloud 版本:0.10 及以上 必备权限要将 Kafka 数数据迁移到ByteHouse,需要确保 Kafka 和 ByteHouse 之间的访问权限配置正确。需要在Kafka中授予4个权限: 列出主题 (Topics) 列出消费者组 (Consumer group) ...

Kafka订阅埋点数据(私有化)

"org.apache.kafka.common.serialization.ByteArrayDeserializer"); properties.put("value.deserializer", "org.apache.kafka.common.serialization.ByteArrayDeserializer"); KafkaConsumer kafkaConsume... (properties); kafkaConsumer.subscribe(Collections.singletonList("behavior_event")); System.out.println(properties); System.out.println("consumer beginning "); while (true) { Consu...

Kafka订阅埋点数据(私有化)

"org.apache.kafka.common.serialization.ByteArrayDeserializer"); properties.put("value.deserializer", "org.apache.kafka.common.serialization.ByteArrayDeserializer"); KafkaConsumer kafkaConsume... (properties); kafkaConsumer.subscribe(Collections.singletonList("behavior_event")); System.out.println(properties); System.out.println("consumer beginning "); while (true) { Consu...

Kafka消息订阅及推送

或者新增集团需要重新手动建立新的topic 消费 topic目前支持kafka消息推送,以集团粒度进行消息的分发,部署时默认构建topic为 cdp_dataAsset_orgId_1 ,该topic仅支持消费集团id为1,客户可在终端进入kafka目录通过以下命令进行消费调试 sql //消费kafka/opt/tiger/kafka_2.11-2.1.1/bin/kafka-console-consumer.sh --bootstrap-server $(sd config kafka_vpc) --from-beginning --topic cdp_dataAsset_orgId_1 新建topic如果客户需...

Kafka@记一次修复Kafka分区所在broker宕机故障引发当前分区不可用思考过程 | 社区征文

包括不限于改Kafka,主题创建删除,Zookeeper配置信息重启服务等等,于是我们来一起看看... Ok,Now,我们还是先来一步步分析它并解决它,依然以”化解“的方式进行,我们先来看看业务进程中线程报错信息:```jsorg.apache.kafka.clients.NetworkClient : [Consumer clientId=consumer-1, groupId=xxxx-center] 1 partitions have leader brokers without a matching listener, including [xxxx-xxxx-xxxx-message-0]```!...

迁移概述

本文介绍 Kafka 业务迁移的方案与基本流程。业务上云过程中,您可以参考本文档,将自建 Kafka 集群或其他云厂商 Kafka 集群平滑迁移至火山引擎消息队列 Kafka版。 背景信息消息队列 Kafka版是一款基于 Apache Kafka ... 迁移方案消息队列 Kafka版提供以下两种迁移方案供您选择,请根据自身业务特点,谨慎选择迁移方案。 方案 说明 适用场景 方案一 先在云端建立新的消息生产与消费流程,再停止原集群的生产业务,并在旧集群消费完旧消息...