Kafka流:基于摄取时间的连接

社区干货

社区干货

Kafka 消息传递详细研究及代码实现|社区征文

并有发布和订阅事件流的特性。本文将研究 Kafka 从生产、存储到消费消息的详细过程。 ## Producer### 消息发送所有的 Kafka 服务器节点任何时间都能响应是否可用、是否 topic 中的 partition leader,这样... Java 实现 Kafka 消息发送分为直接、同步、异步发送。其中直接发送无回调,同步发送有阻塞,故生产环境多用异步发送。```Properties properties = new Properties();// 建立与 Kafka 群集的初始连接的主机/端...

如何使用 SASL_SSL 公网连接消息队列Kafka版

# 问题描述开启公网连接后,如何使用 Python 正常连接到 Kafka 进行生产和消费。# 问题分析在公网环境下,消息队列 Kafka 版要求通过 SSL 证书对消息进行鉴权和加密,保障数据传输过程的安全性,防止数据在网络传输过程中被截取或者窃听,相较于普通公网访问方式具备更高的安全性。目前支持客户端对服务端证书的单向认证, 所以需要下载 SASL_SSL 证书 并指定 SASL_SSL 协议。# 解决方案Python 示例demo如下:```pythonfrom kaf...

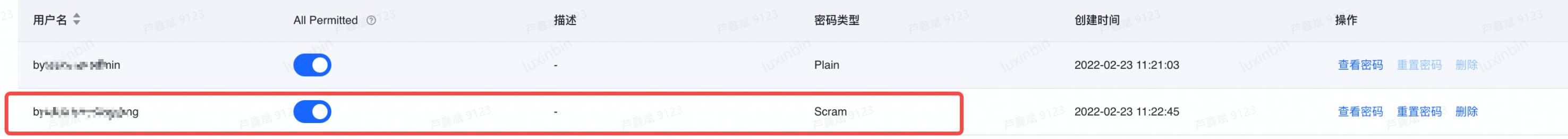

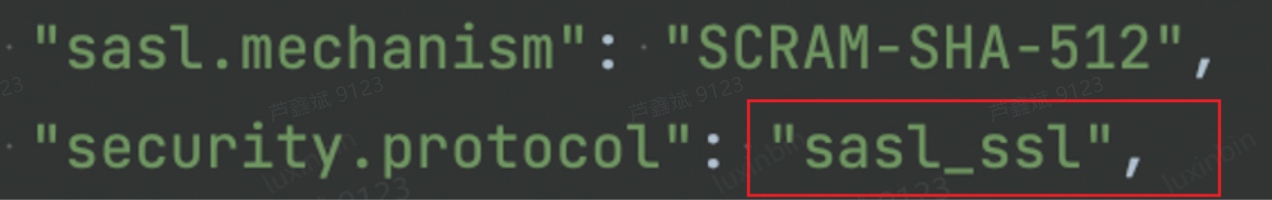

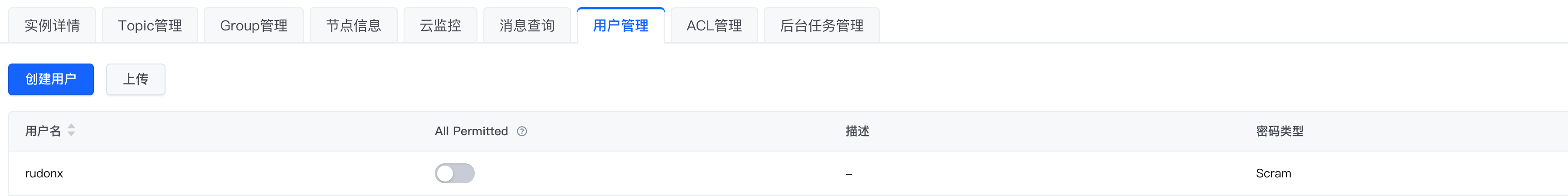

如何使用Scram类型密码连接消息队列Kafka

# 问题描述 客户在前端创建Scram类型密码,代码中无法连接到Kafka  # 问题分析 客户代码中协议及认证机制部分配置如下:  因为SASL_SSL协议并不支持SCRAM,需要更改为SASL_PLAINTEXT...

如何排查消费者无法连接到Kafka问题

# 问题描述在开发和测试过程中,我们可能会遇到无法连接 Kafka 的情况,本文使用 kafka-console-consumer,来模拟几类常见的连接报错# 环境配置* 密码类型选择 Scram* 使用 SASL_SSL接入点,公网连接,客户端配置文件如下:```Plain Textsasl.jaas.config=org.apache.kafka.common.security.sc...

特惠活动

特惠活动

Kafka流:基于摄取时间的连接-优选内容

Kafka流:基于摄取时间的连接-优选内容

Kafka流:基于摄取时间的连接-相关内容

Kafka流:基于摄取时间的连接-相关内容

Kafka数据接入

1. 产品概述 Kafka Topic数据能够支持产品实时场景,以下将介绍如何将火山Kafka数据接入CDP。 2. 使用限制 用户需具备 项目编辑 或 权限-按内容管理-模块-数据连接-新建连接 权限,才能新建数据连接。 3. 操作步骤 ... js分区键需要能被toDate/toDateTime。仅支持使用int类型的时间戳(支持秒/毫秒级),或者'2020-01-01'/'2020-01-01 00:00:00'格式的字符串。推荐使用int类型时间戳。如果使用json建表,json中分区键的值也应遵守上面的...

新功能发布记录

展示流量和存储的 TopN 信息。 以 Group 为维度,展示消费组消息堆积的 TopN 信息。 全部地域 查看监控数据 2024年1月功能名称 功能描述 发布时间 发布地域 相关文档 新增实例规格 新增 kafka.800xrate.h... 消费连接信息。 2023-09-26 全部地域 查看 Topic 详情 Group 描述 支持为 Group 添加描述信息,用于标注 Group 用途等等场景。 2023-09-26 全部地域 创建 Group 新增实例规格 新增 kafka.30xrate.hw、kaf...

使用Logstash消费Kafka中的数据并写入到云搜索

您将学习如何使用 Logstash 消费 Kafka 中的数据,并写入到云搜索服务中。 关于实验 预计部署时间:20分钟级别:初级相关产品:消息队列 - Kafka & 云搜索受众: 通用 环境说明 如果还没有火山引擎账号,点击此链接注册账... 我们使用了 Kafka 的默认接入点地址,同时指定了需要消费的 Topic。在 output 部分,我们指定了需要连接的 云搜索集群地址,索引以及用户名密码。 input { kafka { bootstrap_servers => "xxxxxx.kafka.ivolces.c...

推荐配置的告警规则

消息队列 Kafka版支持配置云监控告警规则,帮助您实时关注实例的运行状态。本文档介绍典型场景下的告警规则配置示例,建议参考这些推荐的告警策略,配置监控指标的告警规则。 实例维度 实例磁盘使用容量超过 85%告警规... Kafka 实例的 IP 连接数上限为 20000,推荐设置 IP 连接数超过 90% 的告警。 告警规则配置告警规则的核心配置如下。创建告警规则的操作步骤请参考设置告警规则。 配置 取值 维度 实例 触发条件 监控指标:IP 连...

使用 Kafka 协议上传日志

限制说明支持的 Kafka 协议版本为 0.11.x~2.0.x。 支持压缩方式包括 gzip、snappy 和 lz4。 为保证日志传输的安全性,必须使用 SASL_SSL 连接协议。对应的用户名为日志服务项目 ID,密码为火山引擎账号密钥,详细信息请参考示例。 如果日志主题中有多个 Shard,日志服务不保证数据的有序性,建议使用负载均衡模式上传日志。 当使用 Kafka Producer Batch 打包发送数据的时候,一次 Batch 数据的大小不能超过 5MiB,一条消息的大小上限...

通过 Kafka 协议消费日志

Kafka 消费的日志数据在服务端的数据保留时间为 2 小时,2 小时后或关闭 Kafka 协议消费功能时会被删除。但有效期内的日志数据可以被持续消费。 支持通过标准的开源 Kafka Java SDK 进行日志数据消费,消费日志的示例代码请参考示例代码。也可以使用 Spark Streaming 或 Flink 的 Kakfa 插件对接日志服务,详细说明请参考通过 Spark Streaming 消费日志和通过 Flink 消费日志。 为保证日志传输的安全性,必须使用 SASL_SSL 连接协议...

如何使用Nginx代理访问VPC内的自建Kafka

关于实验 预计部署时间:30分钟级别:初级相关产品:同VPC内的ECS两台(1台做Nginx代理,1台做Kafka Server)受众: 通用 环境说明 如果还没有火山引擎账号,点击此链接注册账号 如果您还没有VPC,请先点击链接创建VPC 云... 因为第一次访问kafka返回的地址是opendts,如果不解析到nginx的公网ip180.184.70.*数据将无法连接传输180.184.70.* opendts2.准备python环境运行如下脚本 undefined from kafka import KafkaProducerfrom kafka imp...

实例连接

消息队列 Kafka版提供以下实例连接相关的常见问题供您参考。 FAQ 列表是否支持修改 VPC 和子网? 是否支持修改实例的连接地址和端口号? SSL 证书的有效期是多久? 是否支持无密码访问 Kafka 实例? 是否支持跨 VPC 或... Kafka 客户端访问实例时无需下载并手动配置 SSL 证书,旧证书到期时也无需手动替换新证书,所以您无需担心证书过期风险。通过 SASL_SSL 方式收发消息的流程请参考 Java SDK Demo 中提供的SASL_SSL 接入点 PLAIN 机制...

使用默认接入点连接实例

本文介绍在 VPC 网络环境下通过默认接入点连接 Kafka 实例,进行消息生产和消息消费的操作步骤。 背景信息消息队列 Kafka版提供 PLAINTEXT 协议的普通访问方式,即默认接入点。在 VPC 网络环境下通过默认接入点连接实例时,无需配置用户名及密码,直接访问即可。 前提条件已获取默认接入点信息,包括连接地址和端口号。详细信息请参考查看接入点。 已创建 Topic。操作步骤请参考创建 Topic。 已购买火山引擎 ECS,并成功安装 JDK、配置...