Kafka流追加至JSON作为事件丰富化

社区干货

社区干货

火山引擎云原生数据仓库 ByteHouse 技术白皮书 V1.0(中)

> 更多技术交流、求职机会,欢迎关注**字节跳动数据平台微信公众号,回复【1】进入官方交流群** 近日,《火山引擎云原生数据仓库 ByteHouse 技术白皮书》正式发布。白皮书简述了 ByteHouse 基于 ClickHouse 引擎... Json (multiline)- Avro- Parquet- Excel (xls)### 实时导入ByteHouse 能够连接到 Kafka,并将数据持续传输到目标数据表中。与离线导入不同,Kafka 任务一旦启动将持续运行。ByteHouse 的 Kafka 导...

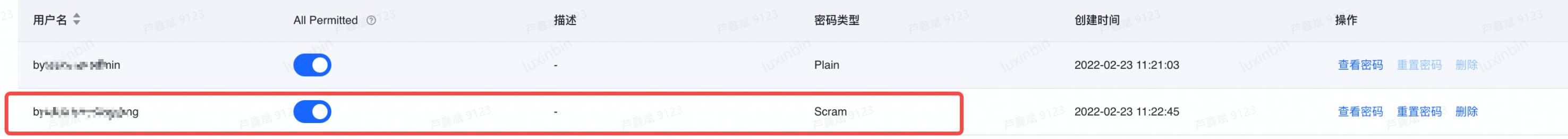

如何使用Scram类型密码连接消息队列Kafka

# 问题描述 客户在前端创建Scram类型密码,代码中无法连接到Kafka  # 问题分析 客户代... import jsonimport timeimport uuidfrom kafka import KafkaProducerfrom kafka.errors import KafkaErrorproducer = KafkaProducer(bootstrap_servers=['kafka-6a1*****.kafka.ivolces.com:9093'], ...

火山引擎云原生数据仓库 ByteHouse 技术白皮书 V1.0 (Ⅳ)

> 更多技术交流、求职机会,欢迎关注**字节跳动数据平台微信公众号,回复【1】进入官方交流群**近日,《火山引擎云原生数据仓库 ByteHouse 技术白皮书》正式发布。白皮书简述了 ByteHouse 基于 ClickHouse 引擎的发展历程,首次详细展现 ByteHouse 的整体架构设计及自研核心技术,为云原生数据仓库发展,及企业数字化转型实战运用提供最新的参考和启迪。以下为 ByteHouse 技术白皮书【数据导入导出】版块摘录。技术白皮书(Ⅰ)(Ⅱ...

「火山引擎」数智平台 VeDI 数据中台产品双月刊 VOL.05

添加小助手微信加入社群**获取产品动态~接下来让我们来看看 3-4 月数据中台产品有什么大事件吧~ # **产品迭代一览**## **/ 大数据研发治理** **套件** **DataLeap /****【** **公有云** **-华东区... Kafka升级至2.8.1;Hudi升级至0.12.2;Flink升级至1.16.0,引入StarRocks、Doris、HBase和ByteHouse Connector,支持MySQL Sink,优化多个配置,达到开箱即用;支持avro,csv,debezium-json和avro-confluent等格式;Presto、...

特惠活动

特惠活动

Kafka流追加至JSON作为事件丰富化-优选内容

Kafka流追加至JSON作为事件丰富化-优选内容

Kafka流追加至JSON作为事件丰富化-相关内容

Kafka流追加至JSON作为事件丰富化-相关内容

高阶使用

本文将为您介绍火山引擎 E-MapReduce(EMR)kafka 组件相关的高阶使用,方便您更深入的使用 Kafka。 扩容 您可以在 EMR 控制台的集群管理页面,进行 Kafka 集群的扩容操作。开源 Kafka 扩容新的 broker 后,流量不会自动... 其主要的三个操作: --generate:生成分区重分配计划 --execute:执行分区重分配计划 --verify:验证分区重分配结果 2.1 选择要处理的 topic将要处理的 topic 信息按照如下格式保存到 JSON 文件。例如要处理的 topi...

Kafka数据接入

在跳转的页面选择 火山Kafka 。3. 填写所需的基本信息,并进行 测试连接 。 连接成功后点击 保存 即可。 点击 数据融合>元数据管理 。 点击右上角 新建数据源 ,创建实时数据源时,选择对应用户的kafka连接及Topic; 选择所需Topic后,有两种方式设置Topic中msg到数据源类型(ClickHouse类型)的映射: 1)采用当前Topic内的msg 2)自定义msg的json结构 配置支持嵌套json,需使用jsonpath提取。 示例:outter.inner.cnt表示获取{"outter...

使用 Kafka 协议上传日志

基于简单的配置即可实现 Kafka Producer 采集并上传日志信息到日志服务。日志服务提供基于 Java 和 Go 语言的示例项目供您参考,详细信息请参考示例。通过 Kafka 协议采集日志时,对于合法的 JSON 格式日志,日志服务... 并通过 Kafka 协议上传到日志服务。通过 Kafka Java SDK 上传日志的相关依赖及示例代码如下: 添加依赖。在 pom 文件中添加 kafka-clients 的相关依赖。 xml org.apache.kafka kafka-clients 2.2.2 上传日志。参考以...

Kafka订阅埋点数据(私有化)

本文档介绍了在增长分析(DataFinder)产品私有化部署场景下,开发同学如何访问Kafka Topic中的流数据,以便进一步进行数据分析和应用,比如实时推荐等。 1. 准备工作 kafka消费只支持内网环境消费,在开始之前,需要提前... ("value " + JsonIterator.deserialize(record.value())); } kafkaConsumer.commitAsync(); }}具体API及可配置参数详细参见官网文档:KafkaConsumer。 3. 数据格式 behavior_event:普通事件,一条数...

Kafka订阅埋点数据(私有化)

本文档介绍了在增长分析(DataFinder)产品私有化部署场景下,开发同学如何访问Kafka Topic中的流数据,以便进一步进行数据分析和应用,比如实时推荐等。 1. 准备工作 kafka消费只支持内网环境消费,在开始之前,需要提前... ("value " + JsonIterator.deserialize(record.value())); } kafkaConsumer.commitAsync(); }}具体API及可配置参数详细参见官网文档:KafkaConsumer。 3. 数据格式 behavior_event:普通事件,一条数...

Kafka订阅埋点数据(私有化)

本文档介绍了在增长分析(DataFinder)产品私有化部署场景下,开发同学如何访问Kafka Topic中的流数据,以便进一步进行数据分析和应用,比如实时推荐等。 1. 准备工作 kafka消费只支持内网环境消费,在开始之前,需要提前... ("value " + JsonIterator.deserialize(record.value())); } kafkaConsumer.commitAsync(); }}具体API及可配置参数详细参见官网文档:KafkaConsumer。 3. 数据格式 behavior_event:普通事件,一条数...

Kafka/BMQ

Kafka 连接器提供从 Kafka Topic 或 BMQ Topic 中消费和写入数据的能力,支持做数据源表和结果表。您可以创建 source 流从 Kafka Topic 中获取数据,作为作业的输入数据;也可以通过 Kafka 结果表将作业输出数据写入到... 建议您在任务中添加该参数配置,设置动态检测的时间间隔。如果任务中不配置该参数,将不会动态发现分区。此时新增分区,将无法读取到新增分区中的数据。 format 是 (none) String 用来反序列化 Kafka 消息体(va...

DescribeKafkaConsumer

调用 DescribeKafkaConsumer 查看指定日志主题的 Kafka 消费功能状态。 使用说明此接口调用频率限制为 20 次/s,超出频率限制会报错 ExceedQPSLimit。 请求说明请求方式:GET 请求地址:https://tls-{Region}.ivolces... ConsumeTopic String out-0fdaa6b6-3c9f-424c-8664-fc0d222c**** Kafka 协议消费主题 ID,格式为 out+日志主题 ID。通过 Kafka 协议消费此日志主题中的日志数据时,Topic 应指定为此 ID。 请求示例json GET https:...

ModifyUserAuthority

调用 ModifyUserAuthority 接口更改指定 SASL 用户对于所有用户的默认权限。 使用说明消息队列 Kafka版为 SASL 用户提供灵活的权限策略,支持 Topic 粒度的权限管控。您可以通过此接口指定 SASL 用户对于所有 Topic... 响应参数无 示例 请求示例JSON POST /?Action=ModifyUserAuthority&Version=2022-05-01 HTTP/1.1Content-Type: application/jsonHost: kafka.volcengineapi.comX-Date: 20210328T100802ZAuthorization: HMAC-SH...