kafka-console-consumer.sh 被怀疑在执行解码操作

社区干货

社区干货

如何排查消费者无法连接到Kafka问题

# 问题描述在开发和测试过程中,我们可能会遇到无法连接 Kafka 的情况,本文使用 kafka-console-consumer,来模拟几类常见的连接报错# 环境配置* 密码类型选择 Scram```./bin/kafka-topics.sh -... 也就是上面我们说的 Kafka 版本 >= 2.2 推荐的创建 topic 的方式;- 根据传入的参数判断判断是否有 --create 参数,有的话走创建主题逻辑。### 3.3 创建 AdminClientTopicService 对象```object AdminClient...

Kafka 消息传递详细研究及代码实现|社区征文

所有的 Kafka 服务器节点任何时间都能响应是否可用、是否 topic 中的 partition leader,这样生产者就能发送它的请求到服务器上。producer 只会将数据 push 给 partition 中的 leader,而 follower 需要自己去 lea... consumer 通过向 broker 发出一个 “fetch” 请求来获取它想要消费的 partition。consumer 的每个请求都在 log 中指定了对应的 offset,并接收从该位置开始的一块数据。若现在 consumer 想查找 offset 为 345682...

Kafka@记一次修复Kafka分区所在broker宕机故障引发当前分区不可用思考过程 | 社区征文

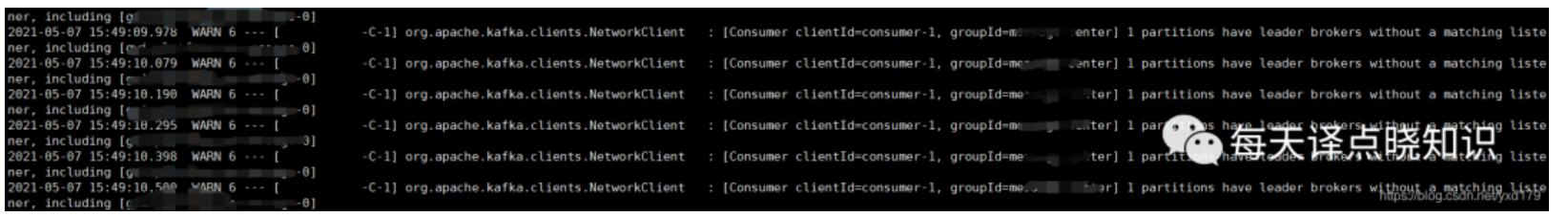

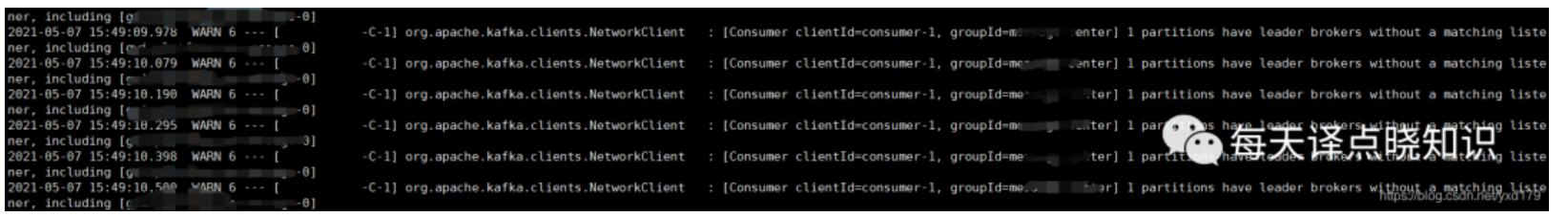

[Consumer clientId=consumer-1, groupId=xxxx-center] 1 partitions have leader brokers without a matching listener, including [xxxx-xxxx-xxxx-message-0]```## 假设猜想从字面意思来看,当前分区所对应的的broker失去监听,为什么监听不到?怀疑是Kafka某个节点有问题-失联-假死?## 思考...

特惠活动

特惠活动

kafka-console-consumer.sh 被怀疑在执行解码操作-优选内容

kafka-console-consumer.sh 被怀疑在执行解码操作-优选内容

kafka-console-consumer.sh 被怀疑在执行解码操作-相关内容

kafka-console-consumer.sh 被怀疑在执行解码操作-相关内容

如何排查消费者无法连接到Kafka问题

# 问题描述在开发和测试过程中,我们可能会遇到无法连接 Kafka 的情况,本文使用 kafka-console-consumer,来模拟几类常见的连接报错# 环境配置* 密码类型选择 Scram```./bin/kafka-topics.sh -... 也就是上面我们说的 Kafka 版本 >= 2.2 推荐的创建 topic 的方式;- 根据传入的参数判断判断是否有 --create 参数,有的话走创建主题逻辑。### 3.3 创建 AdminClientTopicService 对象```object AdminClient...

创建并连接到 Kafka 集群

前言 Kafka是是一个分布式、支持分区的(partition)、多副本的(replica) 分布式消息系统, 深受开发人员的青睐。在本教程中,您将学习如何创建 Kafka 集群,并使用客户端连接,生产数据并消费数据。 关于实验 预计部署时... [root@rudonx kafka_2.11-2.2.0] bin/kafka-console-producer.sh --broker-list kafka-xxxxx.kafka.ivolces.com:9092 --topic rudonx>1 rudonx>2 wanyix>3 liwangz步骤5:启动consumer并消费测试数据新开一个终端,...

Kafka 消息传递详细研究及代码实现|社区征文

所有的 Kafka 服务器节点任何时间都能响应是否可用、是否 topic 中的 partition leader,这样生产者就能发送它的请求到服务器上。producer 只会将数据 push 给 partition 中的 leader,而 follower 需要自己去 lea... consumer 通过向 broker 发出一个 “fetch” 请求来获取它想要消费的 partition。consumer 的每个请求都在 log 中指定了对应的 offset,并接收从该位置开始的一块数据。若现在 consumer 想查找 offset 为 345682...

Kafka@记一次修复Kafka分区所在broker宕机故障引发当前分区不可用思考过程 | 社区征文

[Consumer clientId=consumer-1, groupId=xxxx-center] 1 partitions have leader brokers without a matching listener, including [xxxx-xxxx-xxxx-message-0]```## 假设猜想从字面意思来看,当前分区所对应的的broker失去监听,为什么监听不到?怀疑是Kafka某个节点有问题-失联-假死?## 思考...

高阶使用

缺点是老的分区还是在老的 broker 上,集群整体上流量是不均衡的。 Reassign:这种方式即迁移分区数据到新的 broker,步骤相对复杂。 1 扩分区执行以下命令实现扩分区操作: shell /usr/lib/emr/current/kafka/bin/kafka-topics.sh --alter --zookeeper {zookeeper_connect} --topic {topic} --partitions {num}2 Reassign 进行数据均衡针对已有分区数已经超过 24,且数据占比较大的情况,则考虑使用如下方式进行均衡。 脚本:kafka-r...

消息队列选型之 Kafka vs RabbitMQ

在面对众多的消息队列时,我们往往会陷入选择的困境:“消息队列那么多,该怎么选啊?Kafka 和 RabbitMQ 比较好用,用哪个更好呢?”想必大家也曾有过类似的疑问。对此本文将在接下来的内容中以 Kafka 和 RabbitMQ 为例分... 上图通过举例在秒杀活动中的利用消息队列实现流量削峰。通过在后台启动若干个队列处理程序,消费消息队列中的消息,再执行校验库存、下单等逻辑。因为只有有限个队列处理线程在执行,所以落入后端数据库上的并发请求是...

Kafka 迁移上云(方案一)

本文介绍通过方案一将开源 Kafka 集群迁移到火山引擎消息队列 Kafka版的操作步骤。 注意事项业务迁移只迁移消息生产、消费链路和业务流量,并不会迁移 Kafka 旧集群上的消息数据。 创建Kafka实例、迁移消息收发链路... 通过控制台创建 Group 的操作步骤请参考通过控制台创建 Group。 3 迁移消息服务业务迁移的方案一先启动新的消费端和生产端,让新集群的生产和消费正常运行。再下线旧的生产端,待旧集群的消息被旧 Consumer 消费完成...