Kafka消费者无法消费。

社区干货

社区干货

如何排查消费者无法连接到Kafka问题

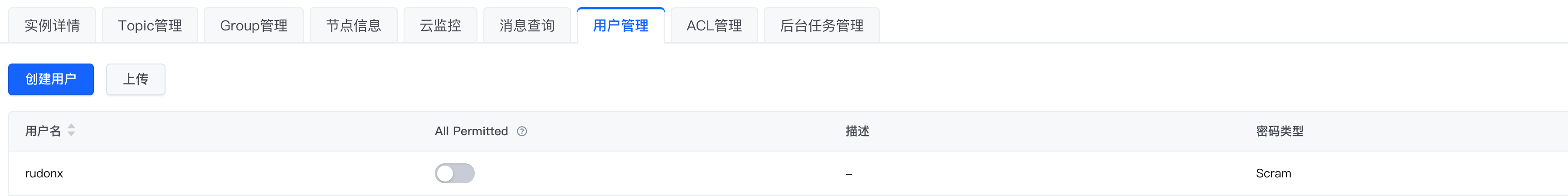

# 问题描述在开发和测试过程中,我们可能会遇到无法连接 Kafka 的情况,本文使用 kafka-console-consumer,来模拟几类常见的连接报错# 环境配置* 密码类型选择 Scram* 使用 SASL_SSL接入点,公网连接,客户端配置文件如下:```Plain Textsasl.jaas.config=org.apache.kafka.common.security.sc...

Kafka 消息传递详细研究及代码实现|社区征文

## 背景新项目涉及大数据方面。之前接触微服务较多,趁公司没反应过来,赶紧查漏补缺。Kafka 是其中之一。Apache Kafka 是一个开源的分布式事件流平台,可跨多台计算机读取、写入、存储和处理事件,并有发布和订阅事件流的特性。本文将研究 Kafka 从生产、存储到消费消息的详细过程。 ## Producer### 消息发送所有的 Kafka 服务器节点任何时间都能响应是否可用、是否 topic 中的 partition leader,这样生产者就能发送它的...

排查Kafka消息堆积的问题

# 问题描述在使用 Kafka 过程中,发现 Kafka 有消息堆积,我们该如何排查此类问题?# 问题分析通常来说,消费堆积有如下原因:1. 生产速度过快,而消费过慢,从而引起堆积。2. 消费端产生了阻塞下面我们会针对上述两种常见原因进行分析。# 解决方案## 消费者消费过慢提高消费者消费速度通常有如下方案:1. 采用多 Consumer 进程或线程同时消费数据。需要注意的是:在理想情况下,Consumer 实例的数量应该等于该 Group 订阅主题...

字节跳动新一代云原生消息队列实践

相较于 Kafka 省去了 ISR 相关的管理。Controller 可以更加专注地关注集群整体流量均衡及故障检测。在 BMQ 中用户所有请求都会由 Proxy 接入,因此 BMQ 的 Metadata 中的 ‘Broker’ 信息实际上填写的是 BMQ 中 Proxy 的信息,客户端根据 Metadata 请求将生产和消费等请求发送到对应的 Proxy,再由 Proxy 处理或转发。这样的架构有助于 BMQ 做更多的容错工作。例如在 Broker 重启时,Proxy 可以感知到相关错误并进行 **退避重试...

特惠活动

特惠活动

Kafka消费者无法消费。-优选内容

Kafka消费者无法消费。-优选内容

Kafka消费者无法消费。-相关内容

Kafka消费者无法消费。-相关内容

流式导入

兼顾了消费性能和实时性。 更多原理请参考 HaKafka 引擎文档。 注意 建议 Kafka 版本满足以下条件,否则可能会出现消费数据丢失的问题,详见 Kafka 社区 Issue = 2.5.1 = 2.4.2 操作步骤 创建数据源在右上角选择数据管理与查询 > 数据导入 > 对应集群. 单击左侧选择 “+”,新建数据源。 配置数据源在右侧数据源配置界面,根据界面提示,依次输入以下信息:源类型:选择 Kafka 数据源类型 源名称:任务名称,和其他任务不能重名。 K...

排查Kafka消息堆积的问题

# 问题描述在使用 Kafka 过程中,发现 Kafka 有消息堆积,我们该如何排查此类问题?# 问题分析通常来说,消费堆积有如下原因:1. 生产速度过快,而消费过慢,从而引起堆积。2. 消费端产生了阻塞下面我们会针对上述两种常见原因进行分析。# 解决方案## 消费者消费过慢提高消费者消费速度通常有如下方案:1. 采用多 Consumer 进程或线程同时消费数据。需要注意的是:在理想情况下,Consumer 实例的数量应该等于该 Group 订阅主题...

字节跳动新一代云原生消息队列实践

相较于 Kafka 省去了 ISR 相关的管理。Controller 可以更加专注地关注集群整体流量均衡及故障检测。在 BMQ 中用户所有请求都会由 Proxy 接入,因此 BMQ 的 Metadata 中的 ‘Broker’ 信息实际上填写的是 BMQ 中 Proxy 的信息,客户端根据 Metadata 请求将生产和消费等请求发送到对应的 Proxy,再由 Proxy 处理或转发。这样的架构有助于 BMQ 做更多的容错工作。例如在 Broker 重启时,Proxy 可以感知到相关错误并进行 **退避重试...

消息队列选型之 Kafka vs RabbitMQ

对此本文将在接下来的内容中以 Kafka 和 RabbitMQ 为例分享消息队列选型的一些经验。消息队列即 Message+Queue,消息可以说是一个数据传输单位,它包含了创建时间、通道/主题信息、输入参数等全部数据;队列(Queue)是一种 FIFO(先进先出)的数据结构,编程语言一般都内置(内存中的)队列实现,可以作为进程间通讯(IPC)的方法。使用队列最常见的场景就是生产者/消费者模式:生产者生产消息放到队列中,消费者从队列里面获取消息消费。典型...

Kafka 概述

3 Kafka 的架构3.1 Kafka 的专用术语术语名称 说明 Broker Kafka 集群包含一个或多个服务器,负责消息的存储、服务等。这种服务器被称为 broker。 Topic 每条发布到 Kafka 集群的消息都有一个类别,这个类别被称为 topic。不同 topic 的消息分开存储。 Partition Partition 是物理上的概念。每个 topic 包含一个或多个 partition。 Record 生产和消费一条消息,或者记录。每条记录包含:一个 key,一个 value,以及一个 timestamp。 O...

Kafka订阅埋点数据(私有化)

本文档介绍了在增长分析(DataFinder)产品私有化部署场景下,开发同学如何访问Kafka Topic中的流数据,以便进一步进行数据分析和应用,比如实时推荐等。 1. 准备工作 kafka消费只支持内网环境消费,在开始之前,需要提前准备好如下输入: Kafka 0.10.1版本及以上的客户端(脚本或JAR包) zookeeper链接:可联系运维获取 broker链接:可联系运维获取 topic名称:下方给出了两个topic数据格式,确认需要消费哪一个topic; ConsumerGroup:确认好Co...

Kafka订阅埋点数据(私有化)

本文档介绍了在增长分析(DataFinder)产品私有化部署场景下,开发同学如何访问Kafka Topic中的流数据,以便进一步进行数据分析和应用,比如实时推荐等。 1. 准备工作 kafka消费只支持内网环境消费,在开始之前,需要提前准备好如下输入: Kafka 0.10.1版本及以上的客户端(脚本或JAR包) zookeeper链接:可联系运维获取 broker链接:可联系运维获取 topic名称:下方给出了两个topic数据格式,确认需要消费哪一个topic; ConsumerGroup:确认好C...

Kafka订阅埋点数据(私有化)

本文档介绍了在增长分析(DataFinder)产品私有化部署场景下,开发同学如何访问Kafka Topic中的流数据,以便进一步进行数据分析和应用,比如实时推荐等。 1. 准备工作 kafka消费只支持内网环境消费,在开始之前,需要提前准备好如下输入: Kafka 0.10.1版本及以上的客户端(脚本或JAR包) zookeeper链接:可联系运维获取 broker链接:可联系运维获取 topic名称:下方给出了两个topic数据格式,确认需要消费哪一个topic; ConsumerGroup:确认好Co...

Kafka 迁移上云(方案一)

本文介绍通过方案一将开源 Kafka 集群迁移到火山引擎消息队列 Kafka版的操作步骤。 注意事项业务迁移只迁移消息生产、消费链路和业务流量,并不会迁移 Kafka 旧集群上的消息数据。 创建Kafka实例、迁移消息收发链路之前,请先确定 Kafka 实例可正常访问,以免因访问异常造成迁移失败。您可以访问 Kafka 实例详情页中的接入点,确认实例的网络连通性。 业务迁移之前,请确认您已根据业务需求选择了正确的迁移方案。迁移方案对比请参考概...