kafka集群和topic

社区干货

社区干货

聊聊 Kafka:Topic 创建流程与源码分析 | 社区征文

为了使数据具有容错性和高可用性,每个主题都可以**复制**,甚至可以跨地理区域或数据中心**复制**,以便始终有多个代理拥有数据副本,以防万一出现问题。常见的生产设置是复制因子为 3,即,你的数据将始终存在三个副本。此复制在主题分区级别执行。在设置副本时,副本数是必须小于集群的 Broker 数的,副本只有设置在不同的机器上才有作用。## 二、Topic 的创建方式### 2.1 zookeeper 方式(不推荐)```./bin/kafka-topics.sh -...

Kafka@记一次修复Kafka分区所在broker宕机故障引发当前分区不可用思考过程 | 社区征文

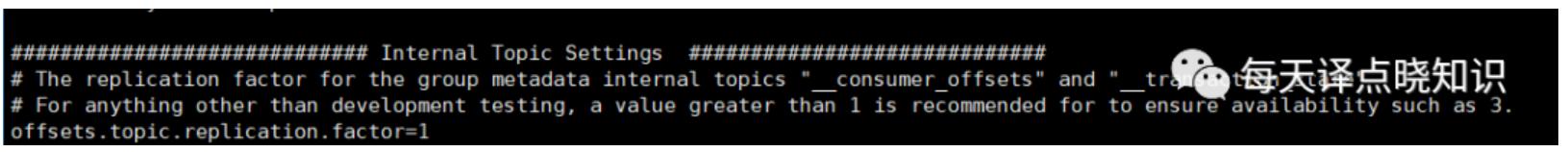

Kafka集群由多个节点组成,但其中某个节点宕掉,整个分区就不能正常使用-消费者端无法订阅到消息。 首先,我们来看下Kafka的配置信息:```js[root@xx-xx-xxx-xx kafka_2.11-2.1.1]# nohup bin/kafka-server-start.sh config/server.properties & ```这里使用了默认的topic分区副本数量:o...

一文了解字节跳动消息队列演进之路

Kafka 同样也在各大互联网公司的产品和大数据系统中得到了广泛的应用。Kafka 集群(Cluster)由多台机器组成,每个集群里面可以拥有多个主题(Topic)。用户可以将所有逻辑上相关的数...

Kafka数据同步

DocumentID=173809#%E6%AD%A5%E9%AA%A42%EF%BC%9A%E5%90%8C%E6%AD%A5%E5%88%9B%E5%BB%BA%E7%81%AB%E5%B1%B1-kafka-topic)在火山创建好Kafka实例后,在“Topic管理”页签下,创建与Source集群需要迁移topic的同名topic。注意分区数最好与原集群分区保持一致。## 步骤3:**下载SASL_SSL证书** [#](https://vsop-...

特惠活动

特惠活动

kafka集群和topic-优选内容

kafka集群和topic-优选内容

kafka集群和topic-相关内容

kafka集群和topic-相关内容

基础使用

Kafka > 部署拓扑页签,进入 Kafka 组件服务的部署拓扑。 单击组件名称下 (emr-core-1 主机名称)的 ECS ID,跳转进入到云服务器的实例界面,点击右上角的远程连接按钮。 选择一种远程连接方式(推荐选择 ECS Terminal),并输入集群相关认证信息,登录到 Kafka 集群的命令行环境中,来执行相关命令行操作。 说明 若集群节点组节点已挂载公网 IP,则您也可以通过 SSH 方式连接集群,详见登录集群。 3 常用命令3.1 创建 topicshell /usr/...

Topic 和 Group 管理

消息队列 Kafka版会自动为指定实例创建一个 Consumer Group,用于消费指定 Topic 中的数据。该 Group 名称以 connect-task 为前缀,并显示在该实例的 Group 列表中。 您之前如使用过 Assign 方式提交消费位点,那么也会在 Kafka 集群上创建对应的 Group。 为什么 Group 会被自动删除?消息队列 Kafka版支持自动删除 Group(auto.delete.group) 功能,您可以设置后端服务是否自动删除 Empty 状态的消费组。开启后,如果消费者组中的所有...

Kafka 概述

可扩展性 Kafka 集群支持热扩展。 持久性、可靠性 消息被持久化到本地磁盘,并且支持数据备份,防止数据丢失。 高并发 支持数千个客户端同时读写。 容错性 允许集群中节点失败(若副本数量为 n,则允许 n-1 个节点失败)。 3 Kafka 的架构3.1 Kafka 的专用术语术语名称 说明 Broker Kafka 集群包含一个或多个服务器,负责消息的存储、服务等。这种服务器被称为 broker。 Topic 每条发布到 Kafka 集群的消息都有一个类别,这个类别被称为...

从 Kafka 导入数据

Kafka 集群和自建 Kafka 集群的数据。创建导入任务后,您可以通过日志服务控制台或服务日志查看导入任务详情。此外,日志服务还会为导入的日志数据添加以下元数据字段。 字段 说明 __content__ Kafka 消息。 __path__ 字段值为空。 __source__ Kafka 集群的服务地址。 注意事项从 Kafka 导入数据功能的限制项如下: 限制 说明 Kafka 版本 Kafka 版本需为 0.11.x 以上。 并发子任务数量 日志服务会根据 Kafka Topic 数...

高阶使用

集群整体上流量是不均衡的。 Reassign:这种方式即迁移分区数据到新的 broker,步骤相对复杂。 1 扩分区执行以下命令实现扩分区操作: shell /usr/lib/emr/current/kafka/bin/kafka-topics.sh --alter --zookeeper {zookeeper_connect} --topic {topic} --partitions {num}2 Reassign 进行数据均衡针对已有分区数已经超过 24,且数据占比较大的情况,则考虑使用如下方式进行均衡。 脚本:kafka-reassign-partitions.sh,其主要的三个操...

Kafka/BMQ

Kafka 连接器提供从 Kafka Topic 或 BMQ Topic 中消费和写入数据的能力,支持做数据源表和结果表。您可以创建 source 流从 Kafka Topic 中获取数据,作为作业的输入数据;也可以通过 Kafka 结果表将作业输出数据写入到 Kafka Topic 中。 注意事项使用 Flink SQL 的用户需要注意,不再支持 kafka-0.10 和 kafka-0.11 两个版本的连接器,请直接使用 kafka 连接器访问 Kafka 0.10 和 0.11 集群。Kafka-0.10 和 Kafka-0.11 两个版本的连接...

聊聊 Kafka:Topic 创建流程与源码分析 | 社区征文

为了使数据具有容错性和高可用性,每个主题都可以**复制**,甚至可以跨地理区域或数据中心**复制**,以便始终有多个代理拥有数据副本,以防万一出现问题。常见的生产设置是复制因子为 3,即,你的数据将始终存在三个副本。此复制在主题分区级别执行。在设置副本时,副本数是必须小于集群的 Broker 数的,副本只有设置在不同的机器上才有作用。## 二、Topic 的创建方式### 2.1 zookeeper 方式(不推荐)```./bin/kafka-topics.sh -...

准备工作

本文将向您介绍如何从随机数据源获取数据,进行加工计算,然后写入到 Kafka 消息队列。 1 新建Kafka数据源登录消息队列 Kafka 版控制台。 新建一个 Kafka Topic,具体操作请参见创建Topic。 获取 Kafka 的 bootstr... 如下所示: 从 EMR 集群下拉列表中,选择已创建成功的 EMR 集群名称。 说明 需选择 EMR 1.3.1 及之前的版本,进行 EMR Flink SQL 作业开发。若无对应版本,需先前往 EMR 控制台创建集群,详细操作说明请参见创建集群。 ...

消息队列

脏数据可注入目标: 集群中的中间件 主机中的中间件 故障参数: 参数 是否必填 说明 故障名称 是 故障的名称。 Host 是 数据库客户端的 IP。 端口 是 数据库客户端的端口号。 是否需要用户名密码 是 选择是否需要输入账户和密码登录。选择是,则需要配置对应的用户名和密码。 用户名 是 数据库账号的用户名。 密码 是 数据库账号的密码。 脏数据值 是 注入脏数据的数据值。 Kafka Topic 是 脏数据注入的目标 Topic。 重复数据可...