Kafka是否具有一个分区和一个通道,一个通道是否对应一个线程的处理?

社区干货

社区干货

Kafka 消息传递详细研究及代码实现|社区征文

## 背景新项目涉及大数据方面。之前接触微服务较多,趁公司没反应过来,赶紧查漏补缺。Kafka 是其中之一。Apache Kafka 是一个开源的分布式事件流平台,可跨多台计算机读取、写入、存储和处理事件,并有发布和订阅事... 当多条消息发送到一个分区时,producer 批量发送消息大小的上限 (以字节为单位)。即使没有达到这个大小,生产者也会定时发送消息,避免消息延迟过大。默认16K,值越小延迟越低,吞吐量和性能也会降低。type: intdef...

Kafka@记一次修复Kafka分区所在broker宕机故障引发当前分区不可用思考过程 | 社区征文

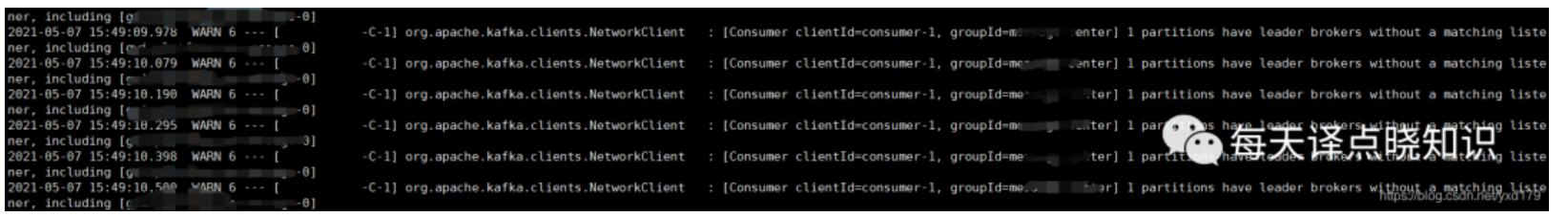

线程报错信息:```jsorg.apache.kafka.clients.NetworkClient : [Consumer clientId=consumer-1, groupId=xxxx-center] 1 partitions have leader brokers without a matching listener, including [xxxx-xxxx-xxxx-message-0]```## 假设猜想从字面意思来看,当前分区所对应的的broker失...

消息队列选型之 Kafka vs RabbitMQ

对此本文将在接下来的内容中以 Kafka 和 RabbitMQ 为例分享消息队列选型的一些经验。消息队列即 Message+Queue,消息可以说是一个数据传输单位,它包含了创建时间、通道/主题信息、输入参数等全部数据;队列(Queue)... 通过在后台启动若干个队列处理程序,消费消息队列中的消息,再执行校验库存、下单等逻辑。因为只有有限个队列处理线程在执行,所以落入后端数据库上的并发请求是有限的 。而请求是可以在消息队列中被短暂地堆积, 当库...

排查Kafka消息堆积的问题

在使用 Kafka 过程中,发现 Kafka 有消息堆积,我们该如何排查此类问题?# 问题分析通常来说,消费堆积有如下原因:1. 生产速度过快,而消费过慢,从而引起堆积。2. 消费端产生了阻塞下面我们会针对上述两种常见原因进行分析。# 解决方案## 消费者消费过慢提高消费者消费速度通常有如下方案:1. 采用多 Consumer 进程或线程同时消费数据。需要注意的是:在理想情况下,Consumer 实例的数量应该等于该 Group 订阅主题的分区总数...

特惠活动

特惠活动

Kafka是否具有一个分区和一个通道,一个通道是否对应一个线程的处理?

-优选内容

Kafka是否具有一个分区和一个通道,一个通道是否对应一个线程的处理?

-优选内容

Kafka是否具有一个分区和一个通道,一个通道是否对应一个线程的处理?

-相关内容

Kafka是否具有一个分区和一个通道,一个通道是否对应一个线程的处理?

-相关内容

Kafka订阅埋点数据(私有化)

本文档介绍了在增长分析(DataFinder)产品私有化部署场景下,开发同学如何访问Kafka Topic中的流数据,以便进一步进行数据分析和应用,比如实时推荐等。 1. 准备工作 kafka消费只支持内网环境消费,在开始之前,需要提前... 一条数据为一个普通事件; user_profile:用户属性,一条数据为一个用户属性相关事件; item_profile:业务对象属性,一条数据为一个业务对象属性相关的事件; ad_event_v2:由广告监测相关服务处理后,unify后的原始数据; ...

Kafka订阅埋点数据(私有化)

本文档介绍了在增长分析(DataFinder)产品私有化部署场景下,开发同学如何访问Kafka Topic中的流数据,以便进一步进行数据分析和应用,比如实时推荐等。 1. 准备工作 kafka消费只支持内网环境消费,在开始之前,需要提前... 一条数据为一个普通事件; user_profile:用户属性,一条数据为一个用户属性相关事件; item_profile:业务对象属性,一条数据为一个业务对象属性相关的事件; ad_event_v2:由广告监测相关服务处理后,unify后的原始数据; ...

Kafka订阅埋点数据(私有化)

本文档介绍了在增长分析(DataFinder)产品私有化部署场景下,开发同学如何访问Kafka Topic中的流数据,以便进一步进行数据分析和应用,比如实时推荐等。 1. 准备工作 kafka消费只支持内网环境消费,在开始之前,需要提前... 一条数据为一个普通事件; user_profile:用户属性,一条数据为一个用户属性相关事件; item_profile:业务对象属性,一条数据为一个业务对象属性相关的事件; ad_event_v2:由广告监测相关服务处理后,unify后的原始数据; ...

配置 Kafka 数据源

Kafka 数据源为您提供实时读取和离线写入 Kafka 的双向通道能力,实现不同数据源与 Kafka 数据源之间进行数据传输。本文为您介绍 DataSail 的 Kafka 数据同步的能力支持情况。 1 支持的 Kafka 版本实时读、离线读:支... *数据源名称 已在数据源管理界面注册的 Kafka 数据源,下拉可选。若还未建立相应数据源,可单击数据源管理按钮,前往创建 Kafka 数据源。 *Topic名称 选择 Kafka 处理消息源的不同分类主题名称,下拉可选数据源下...

Kafka CPU 消耗场景分析

Kafka客户端的设计本身并不是同步消息发送的,业务在调用发送接口后,消息并不会直接发送到服务端,而是缓存在客户端内存中,发送的消息会在缓存中做消息聚合。之后由客户端后台会维护的一个异步发送线程来不断从内存缓... 发送和消费都已经使用了批量聚合方式,但是部分场景下也会存在过快的请求速率。原因在于 Kafka 本身默认的配置都为尽速处理,发送端尽可能快地发送,消费端尽可能快地消费。因而在用户业务量相对较大的场景下,默认的...

排查Kafka消息堆积的问题

在使用 Kafka 过程中,发现 Kafka 有消息堆积,我们该如何排查此类问题?# 问题分析通常来说,消费堆积有如下原因:1. 生产速度过快,而消费过慢,从而引起堆积。2. 消费端产生了阻塞下面我们会针对上述两种常见原因进行分析。# 解决方案## 消费者消费过慢提高消费者消费速度通常有如下方案:1. 采用多 Consumer 进程或线程同时消费数据。需要注意的是:在理想情况下,Consumer 实例的数量应该等于该 Group 订阅主题的分区总数...

通过 Kafka 消费火山引擎 Proto 格式的订阅数据

关联 Kafka 和订阅任务本文以 macOS 操作系统为例,介绍如何关联 Kafka 和订阅任务。 登录 DTS 控制台,创建并配置数据订阅通道。详细信息,请参见订阅方案概览。 在目标数据订阅通道中新增消费组。详细信息,请参见新建消费组。 按需选择 Java 消费示例或 Python 消费示例,Python 语言和 Java 语言各消费示例的目录如下所示: Python 语言 . ├── dts_kafka_consumer_demo.py 消费 Demo 文件 ├── volc.proto ...

字节跳动基于Apache Atlas的近实时消息同步能力优化 | 社区征文

每台服务器支持的Kafka Consumer数量有限,在每日百万级消息体量下,经常有长延时等问题,影响用户体验。在2020年底,我们针对Atlas的消息消费部分做了重构,将消息的消费和处理从后端服务中剥离出来,并编写了Flink任... 它会将消息的处理结果更新给State Manager,同时上报与消息处理相关的Metric。- State Manager:负责维护每个Kafka Partition的消息状态,并暴露当前应提交的Offset信息给MQ Consumer。# 实现## 线程模型