用Spark/Scala找到列中定界值的计数,消除重复项。

社区干货

社区干货

万字长文,Spark 架构原理和 RDD 算子详解一网打进! | 社区征文

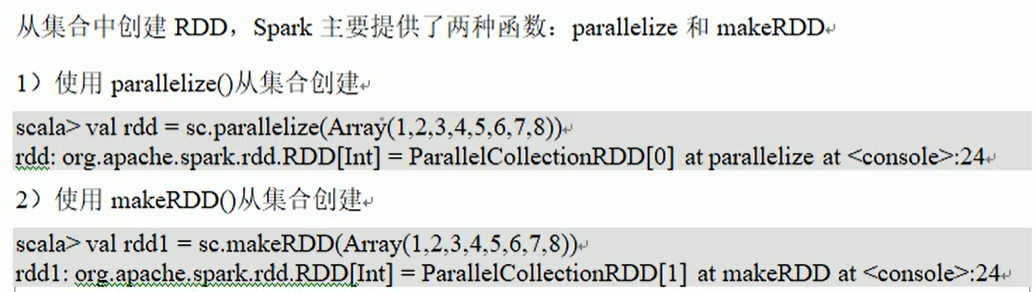

Spark在进行任务调度的时候,会尽可能地将计算任务分配到其所要处理数据块的存储位置。### 2.4 RDD可以从哪来1. 通过序列化集合的方式2. 通过读取文件的方式```sqlscala> sc.textFile("hdfs://wc/e...

计算引擎在K8S上的实践|社区征文

提供了如项目管理、代码托管、CI/CD等功能。因此数据平台也面临着从Hadoop到云原生的探索。我们做了一些尝试:首先是存储,使用OSS等对象存储替代了HDFS。其次就是计算,也是本篇文章将要介绍的,将Spark计算任务从Yar... apiVersion: "sparkoperator.k8s.io/v1beta2"kind: SparkApplicationmetadata: name: spark-pi namespace: defaultspec: type: Scala mode: cluster image: "gcr.io/spark-operator/spark:v3.1.1" ...

一文了解 DataLeap 中的 Notebook

并提供一个默认的 Spark Session。用户可以通过在 Driver 上的 Kernel,直接发起运行 Spark 相关代码。同时,为了满足 Spark 用户的使用习惯,我们额外提供了在同一个 Kernel 内交叉运行 SQL 和 Scala 代码的能力。... 3. 运维困难。当用户 JupyterLab 可能出现问题,为了找到对应的 JupyterLab,我们需要先根据项目对应到 JupyterHub user,然后根据 user 找到 JupyterHub 记录的服务 id,再去 PaaS 平台找服务,进 webshell。 4. 当然...

关于 DataLeap 中的 Notebook你想知道的都在这

并提供一个默认的 Spark Session。用户可以通过在 Driver 上的 Kernel,直接发起运行 Spark 相关代码。同时,为了满足 Spark 用户的使用习惯,我们额外提供了在同一个 Kernel 内交叉运行 SQL 和 Scala 代码的能力。... 用户体验受影响较大。1. 运维困难。当用户 JupyterLab 可能出现问题,为了找到对应的 JupyterLab,我们需要先根据项目对应到 JupyterHub user,然后根据 user 找到 JupyterHub 记录的服务 id,再去 PaaS 平台找服务,...

特惠活动

特惠活动

用Spark/Scala找到列中定界值的计数,消除重复项。

-优选内容

用Spark/Scala找到列中定界值的计数,消除重复项。

-优选内容

用Spark/Scala找到列中定界值的计数,消除重复项。

-相关内容

用Spark/Scala找到列中定界值的计数,消除重复项。

-相关内容

使用 VCI 运行 Spark 数据处理任务

建议您结合自己业务实际需求和安装运行 Spark Operator 的需求,选择合适的节点规格,保证节点的 vCPU、内存等满足您的业务运行需求。 集群创建需要 15~20 分钟,请在 集群列表 查看创建进度,并确认集群创建成功。 步骤二:连接集群在 容器服务控制台 的 集群 页面,找到本文上方 步骤一 中已创建的集群,单击集群名称。 在集群 基本信息 页面,单击 连接信息 页签。 查看 公网访问 Config,获取集群访问凭证。 登录 kubectl 客户端,进...

Spark批式读写Iceberg

Apache Spark 是一种用于大数据工作负载的分布式开源处理系统。本文以 Spark 3.x 操作Iceberg表为例,介绍如何通过 Spark API 以批处理的方式读写 Iceberg 表。 1 前提条件适合 E-MapReduce(EMR) 1.2.0以后的版本(包... .overwritePartitions() 查询数据: val dataFrame = spark.table("iceberg.iceberg_db.iceberg_001") 3 完整示例本示例是使用Spark DataFrame API批式读写Iceberg表。 编写Spark代码。 以Scala版代码为例,代码示例...

Spark Jar 作业开发

1. 概述 为满足用户更加定制化的数据查询分析需求,LAS 提供了 Spark Jar 任务的查询方式。用户可以通过编写自己的 Spark 应用程序来进行定制化的数据分析工作,同时 LAS 会管控用户对数据集访问的权限与平台现有权限... iver.cores = lasJobDriverCUspark.driver.memory = lasJobDriverCU * 4gspark.executor.cores = lasJobExecutorCUspark.executor.memory = lasJobExecutorCU * 4g4. 相关限制 目前 Spark Jar 任务支持 Java/Scala...

Spark流式读写 Iceberg

本文以 Spark 3.x 操作 Iceberg 表为例介绍如何通过 Spark Structured Streaming 流式读写 Iceberg 表。 1 前提条件适合 E-MapReduce(EMR) 1.2.0以后的版本(包括 EMR 1.2.0) 不适配 EMR 2.x 的版本。EMR2.x 版本中... 3 完整示例本示例上采用 linux 的 netcat 命令发送数据,Spark 接收数据后写入 Iceberg 表中。 编写 Spark 代码。 以 Scala 版代码为例,代码示例如下。 import org.apache.spark.SparkConfimport org.apache.spark....

CreateApplication

调用 CreateApplication 接口,创建 Spark 任务。 前提条件一般是由开发人员(Project_Dev )负责开发任务,请确保操作者已被添加为项目成员并关联角色,请参见权限概述。 请求参数参数 类型 是否必填 示例值 说明 ... ApplicationType string 是 SPARK_BATCH_SQL 需要创建的任务类型: SPARK_BATCH_JAR:当需要创建Spark Scala 任务时,同样填这个类型 SPARK_BATCH_SQL SPARK_BATCH_PYTHON Dependency object(POSTApiV1AppCre...

ListApplication

PageNum int 否 10 每页能展示的 Spark 任务数量。 State string 否 CREATED 根据任务状态进行筛选。 CREATED:已创建 STARTING:启动中 RUNNING:运行中 FAILED:失败 CANCELLING:下线中 SUCCEEDED:成功 STOPPED:停止 UNKNOWN:未知 ApplicationTrn string 否 1646***3459458 任务 ID。 ApplicationType string 否 SPARK_BATCH_SQL 任务类型。可能的取值如下: SPARK_BATCH_JAR:当是 Spark Scala 任务时,同样是这...

计算引擎在K8S上的实践|社区征文

提供了如项目管理、代码托管、CI/CD等功能。因此数据平台也面临着从Hadoop到云原生的探索。我们做了一些尝试:首先是存储,使用OSS等对象存储替代了HDFS。其次就是计算,也是本篇文章将要介绍的,将Spark计算任务从Yar... apiVersion: "sparkoperator.k8s.io/v1beta2"kind: SparkApplicationmetadata: name: spark-pi namespace: defaultspec: type: Scala mode: cluster image: "gcr.io/spark-operator/spark:v3.1.1" ...

一文了解 DataLeap 中的 Notebook

并提供一个默认的 Spark Session。用户可以通过在 Driver 上的 Kernel,直接发起运行 Spark 相关代码。同时,为了满足 Spark 用户的使用习惯,我们额外提供了在同一个 Kernel 内交叉运行 SQL 和 Scala 代码的能力。... 3. 运维困难。当用户 JupyterLab 可能出现问题,为了找到对应的 JupyterLab,我们需要先根据项目对应到 JupyterHub user,然后根据 user 找到 JupyterHub 记录的服务 id,再去 PaaS 平台找服务,进 webshell。 4. 当然...

关于 DataLeap 中的 Notebook你想知道的都在这

并提供一个默认的 Spark Session。用户可以通过在 Driver 上的 Kernel,直接发起运行 Spark 相关代码。同时,为了满足 Spark 用户的使用习惯,我们额外提供了在同一个 Kernel 内交叉运行 SQL 和 Scala 代码的能力。... 用户体验受影响较大。1. 运维困难。当用户 JupyterLab 可能出现问题,为了找到对应的 JupyterLab,我们需要先根据项目对应到 JupyterHub user,然后根据 user 找到 JupyterHub 记录的服务 id,再去 PaaS 平台找服务,...