Kafka服务器日志中的时间戳旁边的是一个三位数的数字是什么?

社区干货

社区干货

Kafka 消息传递详细研究及代码实现|社区征文

## 背景新项目涉及大数据方面。之前接触微服务较多,趁公司没反应过来,赶紧查漏补缺。Kafka 是其中之一。Apache Kafka 是一个开源的分布式事件流平台,可跨多台计算机读取、写入、存储和处理事件,并有发布和订阅事件流的特性。本文将研究 Kafka 从生产、存储到消费消息的详细过程。 ## Producer### 消息发送所有的 Kafka 服务器节点任何时间都能响应是否可用、是否 topic 中的 partition leader,这样生产者就能发送它的...

聊聊 Kafka:Topic 创建流程与源码分析 | 社区征文

一个或多个订阅这些事件的消费者。可以根据需要随时读取主题中的事件——与传统消息传递系统不同,事件在消费后不会被删除。相反,您可以通过每个主题的配置设置来定义 Kafka 应该保留您的事件多长时间,之后旧事件将... 如果日志已经存在,只返回现有日志的副本,否则如果 isNew=true 或者如果没有离线日志目录,则为给定的主题和给定的分区创建日志,否则抛出 KafkaStorageException。

消息队列选型之 Kafka vs RabbitMQ

Kafka 和 RabbitMQ 比较好用,用哪个更好呢?”想必大家也曾有过类似的疑问。对此本文将在接下来的内容中以 Kafka 和 RabbitMQ 为例分享消息队列选型的一些经验。消息队列即 Message+Queue,消息可以说是一个数据传输单位,它包含了创建时间、通道/主题信息、输入参数等全部数据;队列(Queue)是一种 FIFO(先进先出)的数据结构,编程语言一般都内置(内存中的)队列实现,可以作为进程间通讯(IPC)的方法。使用队列最常见的场景就是生产者...

Kafka@记一次修复Kafka分区所在broker宕机故障引发当前分区不可用思考过程 | 社区征文

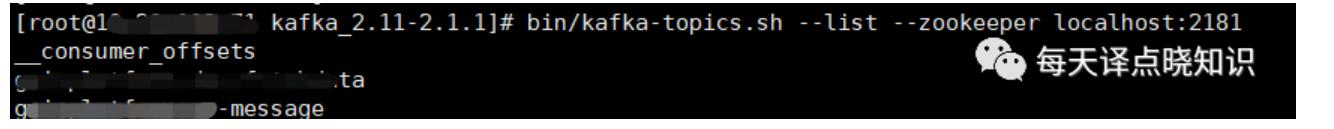

业务组内研发童鞋碰到了这样一个问题,反复尝试并研究,包括不限于改Kafka,主题创建删除,Zookeeper配置信息重启服务等等,于是我们来一起看看... Ok,Now,我们还是先来一步步分析它并解决它,依然以”化解“的方式进... kafka-topics.sh --list --zookeeper localhost:2181```然后,查询topic日志内...

特惠活动

特惠活动

Kafka服务器日志中的时间戳旁边的是一个三位数的数字是什么?-优选内容

Kafka服务器日志中的时间戳旁边的是一个三位数的数字是什么?-优选内容

Kafka服务器日志中的时间戳旁边的是一个三位数的数字是什么?-相关内容

Kafka服务器日志中的时间戳旁边的是一个三位数的数字是什么?-相关内容

聊聊 Kafka:Topic 创建流程与源码分析 | 社区征文

一个或多个订阅这些事件的消费者。可以根据需要随时读取主题中的事件——与传统消息传递系统不同,事件在消费后不会被删除。相反,您可以通过每个主题的配置设置来定义 Kafka 应该保留您的事件多长时间,之后旧事件将... 如果日志已经存在,只返回现有日志的副本,否则如果 isNew=true 或者如果没有离线日志目录,则为给定的主题和给定的分区创建日志,否则抛出 KafkaStorageException。

从 Kafka 导入数据

日志服务支持 Kafka 数据导入功能,本文档介绍从 Kafka 中导入数据到日志服务的操作步骤。 背景信息日志服务数据导入功能支持将 Kafka 集群的消息数据导入到指定日志主题。Kafka 数据导入功能通常用于业务上云数据迁... 则可配置时间转换格式为 %Y-%m-%dT%H:%M:%S.%f%z。 时区:时区配置。默认为机器所在时区,支持设置为 GMT 格式或 UTC 格式。 默认时间来源 关闭指定时间字段时,您可以选择系统当前时间或 Kafka 消息时间戳作为日志...

投递日志到消息队列 Kafka版

日志服务支持投递日志到 Kafka 中,本文档介绍创建投递配置的操作流程。 前提条件已开通日志服务,并成功采集到日志数据。详细说明请参考快速入门。 已开通火山引擎消息队列 Kafka 版,并在指定日志主题的同一地域创建... 您可以在字段列表中选择需要投递到 Kafka 实例中的字段名称。 除日志源中定义的字段以外,支持投递 __source__ 等日志服务为每条日志默认添加的元数据字段。 投递时间范围 设置待投递日志的时间范围。日志时间为...

OpenKafkaConsumer

调用 OpenKafkaConsumer 接口为指定日志主题开启 Kafka 协议消费功能。 使用说明调用此接口为日志主题开启 Kafka 协议消费功能之后,可以将日志主题作为 Kafka 的 Topic 进行消费,每条日志对应一条 Kafka 消息。通过 Kafka 协议消费日志具体方式和配置请参考通过 Kafka 协议消费日志。此接口调用频率限制为 20 次/s,超出频率限制会报错 ExceedQPSLimit。 说明 消费日志时会产生私网或公网的读流量。价格信息请参考计费指引。 关闭...

DescribeKafkaConsumer

调用 DescribeKafkaConsumer 查看指定日志主题的 Kafka 消费功能状态。 使用说明此接口调用频率限制为 20 次/s,超出频率限制会报错 ExceedQPSLimit。 请求说明请求方式:GET 请求地址:https://tls-{Region}.ivolces.com/DescribeKafkaConsumer 请求参数下表仅列出该接口特有的请求参数和部分公共参数。更多信息请见公共参数。 Query参数 类型 是否必选 示例值 描述 TopicId String 是 c7e0e442-19bf-4fb3-b547-5992fb8b**** 日志主...

通过 ByteHouse 消费日志

ByteHouse(云数仓版)支持通过 Kafka 流式传输数据。本文档介绍如何将日志服务中的日志数据通过 Kafka 协议消费到 ByteHouse。 背景信息日志服务支持通过 Kafka 协议消费指定日志主题中的日志数据,例如消费到 ByteH... Kafka 数据源和新建数据导入任务步骤。 登录 ByteHouse 控制台。 新建数据库。在数据库页面的左上角单击 + 新建数据库。 填写数据库的基本信息。 配置 说明 数据库名称 数据库的名称,只能包含字母、数字和下划...

读取日志服务 TLS 数据写入云搜索服务 Cloud Search

每条日志对应一条 Kafka 消息。您可以使用 Flink kafka 连接器连接日志服务,通过 Flink 任务将日志服务中采集的日志数据消费到下游的大数据组件或者数据仓库。本文通过 Flink SQL 任务,实现读取 TLS 主题中的日志数... 取值说明如下: 不能以数字、短横线(-)开头。 只能包含中文、数字、字母、中划线(-)和下划线(_)。 长度在 1~128 个字符内。 可用区 选择需要创建实例的可用区。 版本 兼容 6.7.1 及 7.10.2 Elasticsearch 版本。...

读取日志服务 TLS 数据写入云搜索服务 ESCloud

每条日志对应一条 Kafka 消息。您可以使用 Flink kafka 连接器连接日志服务,通过 Flink 任务将日志服务中采集的日志数据消费到下游的大数据组件或者数据仓库。本文通过 Flink SQL 任务,实现读取 TLS 主题中的日志数... 取值说明如下: 不能以数字、短横线(-)开头。 只能包含中文、数字、字母、中划线(-)和下划线(_)。 长度在 1~128 个字符内。 可用区 选择需要创建实例的可用区。 版本 兼容 6.7.1 及 7.10.2 Elasticsearch 版本。...

Kafka/BMQ

满足任意一个条件都会立即发送消息。 说明 如果在写 Kafka 数据时出现吞吐量不足,建议您提升 batch.size 取值,一般设置为 128KB。 properties.linger.ms 否 0 string 消息在 Batch 中的停留时间,即发送消息前... 指定启动位点时间戳,单位毫秒。 sink.partitioner 否 fixed String Flink 分区到 Kafka 分区的映射关系。取值如下: fixed(默认值):每个 Flink 分区对应一个 Kafka 分区。 round-robin:Flink 分区中的数据将被...