Kafka的Java消费者在调用poll时只获取了几条消息,有时甚至没有获取到消息,请有人帮忙增加poll的次数。

社区干货

社区干货

Kafka 消息传递详细研究及代码实现|社区征文

Kafka存储成本。type: stringdefault: nonevalid values: [none, gzip, snappy, lz4, zstd]importance: high [**retries**](url)生产者发送消息失败或出现潜在暂时性错误时,会进行的重试次数。type: intdefault: 2147483647valid values: [0, ..., 2147483647]importance: high [**batch.size**](url)当多条消息发送到一个分区时,producer 批量发送消息大小的上限 (以字节为单位)。即使没有达到这个...

Kafka@记一次修复Kafka分区所在broker宕机故障引发当前分区不可用思考过程 | 社区征文

但Kafka的高可用性HA我们是耳熟能详的,为啥我们搭建的Kafka集群由多个节点组成,但其中某个节点宕掉,整个分区就不能正常使用-消费者端无法订阅到消息。 首先,我们来看下Kafka的配置信息:```js[root@xx-xx-xx... 当前Broker节点下该分区没有查询到任何可用信息...   // 调用 adminClient 创建 Topic val createResult = adminClient.createTopics(Collections.singleton(newTopic), ne...

特惠活动

特惠活动

Kafka的Java消费者在调用poll时只获取了几条消息,有时甚至没有获取到消息,请有人帮忙增加poll的次数。-优选内容

Kafka的Java消费者在调用poll时只获取了几条消息,有时甚至没有获取到消息,请有人帮忙增加poll的次数。-优选内容

Kafka的Java消费者在调用poll时只获取了几条消息,有时甚至没有获取到消息,请有人帮忙增加poll的次数。-相关内容

Kafka的Java消费者在调用poll时只获取了几条消息,有时甚至没有获取到消息,请有人帮忙增加poll的次数。-相关内容

Kafka@记一次修复Kafka分区所在broker宕机故障引发当前分区不可用思考过程 | 社区征文

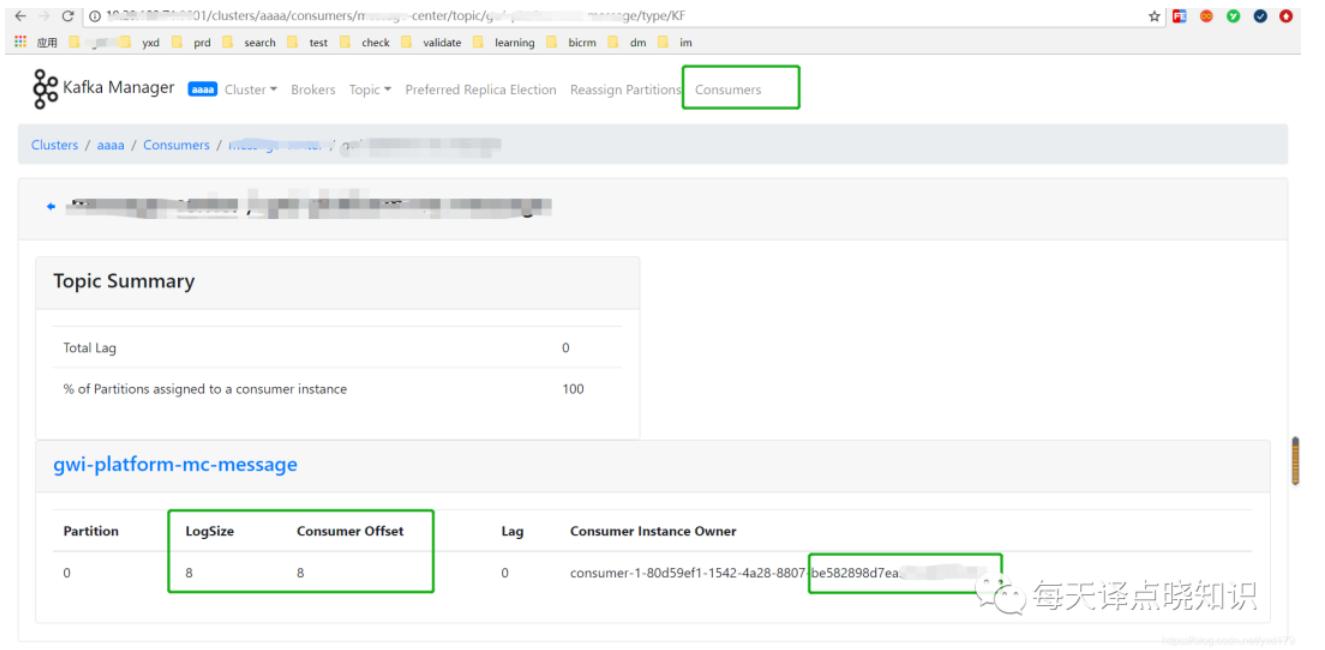

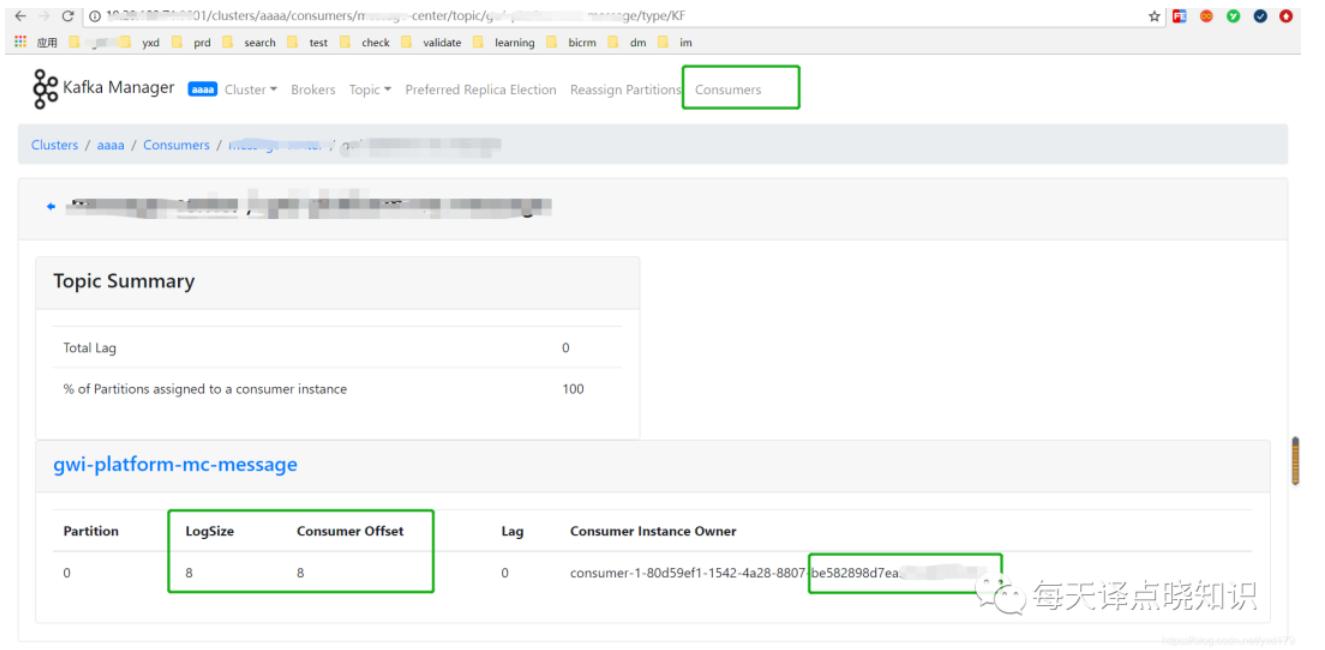

但Kafka的高可用性HA我们是耳熟能详的,为啥我们搭建的Kafka集群由多个节点组成,但其中某个节点宕掉,整个分区就不能正常使用-消费者端无法订阅到消息。 首先,我们来看下Kafka的配置信息:```js[root@xx-xx-xx... 当前Broker节点下该分区没有查询到任何可用信息...   // 调用 adminClient 创建 Topic val createResult = adminClient.createTopics(Collections.singleton(newTopic), ne...

消息顺序性与可靠性

使用消息队列 Kafka版收发消息时,往往需要关注消息的顺序性与可靠性,本文档介绍实现消息顺序性、保证消息可靠性的推荐方式。 消息顺序性Kafka 的消息在单个分区中可以保证数据的先入先出,即写入同一分区的消息,若消... retries 消息发送失败后的重试次数。可配置 0 次、1 次或多次。Apache Java 客户端默认无限次重试。 enable.idempotence 消息幂等性配置。若配置开启,则在生产端会保证消息的幂等性。 Kafka 消费者客户端通...

默认接入点收发消息

本文以 Java 客户端为例,介绍如何在 VPC 环境下通过默认接入点(PLAINTEXT)接入消息队列 Kafka版,并收发消息。 前提条件已完成准备工作。详细说明请参考准备工作。 1 安装Java依赖库在 Java 项目的 pom.xml 中添加相... public synchronized static Properties getKafkaProperties(String path) { if (null != properties) { return properties; } //获取配置文件config.properties的内容 ...

消息队列选型之 Kafka vs RabbitMQ

消息队列是一种能实现生产者到消费者单向通信的通信模型,而一般大家说 MQ 是指实现了这个模型的中间件,比如 RabbitMQ、RocketMQ、Kafka 等。我们所要讨论的选型主要是针对消息中间件。**消息队列的应用场景... 稳定的和安全的企业级消息通信。不过由于历史原因包袱太重,目前市场份额没有后面三种消息中间件多,其最新架构被命名为 Apollo,号称下一代 ActiveMQ,有兴趣的同学可自行了解。* **RabbitMQ** 是采用 Erlang 语言实...

Kafka数据同步

Kafka MirrorMaker 是 Kafka 官网提供的跨数据中心流数据同步方案,其实现原理是通过从 Source 集群消费消息,然后将消息生产到 Target 集群从而完成数据迁移操作。用户只需要通过简单的consumer配置和producer配置,... producer消费者的配置(producer.properties)也在此config目录下,该文件有较大修改:```XMLbootstrap.servers= SASL接入点(公网) # 需要根据实际情况修改```接入点的获取途径如下:

代码示例: Plain public static void main() { Properties properties = new Properties(); // broker list获取方式: sd config kafka_vpc properties.put("bootstrap.servers", "127.0.0.1:9092"); p... records = kafkaConsumer.poll(Duration.ofMillis(100)); for (ConsumerRecord record : records) { System.out.println("value " + JsonIterator.deserialize(record.value())); } ...