kafka消费端配置详细

社区干货

社区干货

聊聊 Kafka:Topic 创建流程与源码分析 | 社区征文

事件在消费后不会被删除。相反,您可以通过每个主题的配置设置来定义 Kafka 应该保留您的事件多长时间,之后旧事件将被丢弃。Kafka 的性能在数据大小方面实际上是恒定的,因此长时间存储数据是完全没问题的。主题是**分区的**,这意味着一个主题分布在位于不同 Kafka 代理的多个“桶”上。数据的这种分布式放置对于可伸缩性非常重要,因为它允许客户端应用程序同时从/向多个代理读取和写入数据。当一个新事件发布到一个主题时,它实际...

Kafka 消息传递详细研究及代码实现|社区征文

Kafka 是其中之一。Apache Kafka 是一个开源的分布式事件流平台,可跨多台计算机读取、写入、存储和处理事件,并有发布和订阅事件流的特性。本文将研究 Kafka 从生产、存储到消费消息的详细过程。 ## Produce... Kafka Documentation 中 *[Producer Configs](https://kafka.apache.org/documentation/#producerconfigs)* 里有相关配置说明:[**compression.type**](url)生产者生成的数据的压缩类型。通过使用压缩,可以节省...

如何排查消费者无法连接到Kafka问题

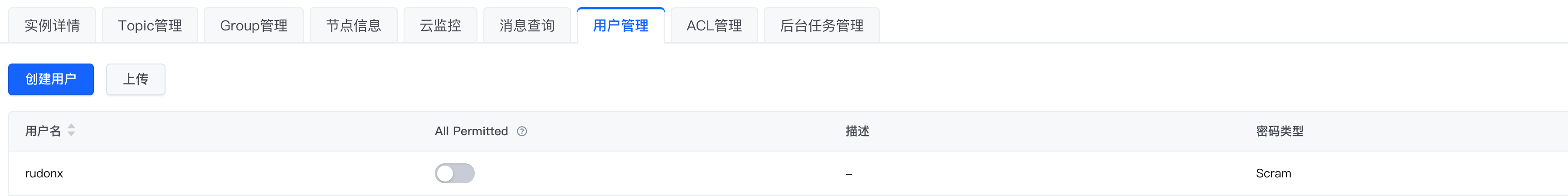

# 问题描述在开发和测试过程中,我们可能会遇到无法连接 Kafka 的情况,本文使用 kafka-console-consumer,来模拟几类常见的连接报错# 环境配置* 密码类型选择 Scram* 使用 SASL_SSL接入点,公网连接,客户端配置文件如下:```Plain Textsasl.jaas.config=org.apache.kafka.common.security.sc...

Logstash 如何通过 Kafka 协议消费 TLS 日志

# **问题现象**如何通过修改 Logstash 配置文件,实现通过 Kafka 协议消费日志到其他业务系统。# 问题分析TLS 日志服务支持通过 Logstash 消费日志数据,您可以通过配置 Logstash 服务内置的 logstash-input-kafk... 详细信息请参考[示例](https://www.volcengine.com/docs/6470/148247#%E7%A4%BA%E4%BE%8B)。 || username | Kafka SASL 用户名。应配置为日志服务的日志项目 ID。 || password | Kafka SASL 用户密码。应配置为火...

特惠活动

特惠活动

kafka消费端配置详细-优选内容

kafka消费端配置详细-优选内容

kafka消费端配置详细-相关内容

kafka消费端配置详细-相关内容

通过 Kafka 协议消费日志

详细信息请参考示例代码。 如果日志主题中有多个 Shard,日志服务不保证消费的有序性,建议使用负载均衡模式上传日志。 费用说明消费日志时会产生私网或公网的读流量。价格信息请参考计费指引。 内网读流量:通过 Kafka 协议消费日志数据到火山引擎其他私网服务时,如果源日志主题和消费端属于同一地域,可以使用私网传输,此时会产生内网读流量费用。例如源数据在日志服务北京地域的某日志主题中,通过 Kafka 消费日志数据到 ECS 自建...

新功能发布记录

详细配置步骤。 全部地域 接入 Filebeat 监控数据-TopN 数据 以 Topic 为维度,展示流量和存储的 TopN 信息。 以 Group 为维度,展示消费组消息堆积的 TopN 信息。 全部地域 查看监控数据 2024年1月功能名称 功能描述 发布时间 发布地域 相关文档 新增实例规格 新增 kafka.800xrate.hw、kafka.1200xrate.hw 和 kafka.1500xrate.hw 共计 3 款实例规格。 2024-1-5 全部地域 产品规格 优化实例详情 在实例详情页,增...

Kafka订阅埋点数据(私有化)

开发同学如何访问Kafka Topic中的流数据,以便进一步进行数据分析和应用,比如实时推荐等。 1. 准备工作 kafka消费只支持内网环境消费,在开始之前,需要提前准备好如下输入: Kafka 0.10.1版本及以上的客户端(脚本或J... record : records) { System.out.println("value " + JsonIterator.deserialize(record.value())); } kafkaConsumer.commitAsync(); }}具体API及可配置参数详细参见官网文档:KafkaCon...

Kafka订阅埋点数据(私有化)

开发同学如何访问Kafka Topic中的流数据,以便进一步进行数据分析和应用,比如实时推荐等。 1. 准备工作 kafka消费只支持内网环境消费,在开始之前,需要提前准备好如下输入: Kafka 0.10.1版本及以上的客户端(脚本或JA... record : records) { System.out.println("value " + JsonIterator.deserialize(record.value())); } kafkaConsumer.commitAsync(); }}具体API及可配置参数详细参见官网文档:KafkaCon...

Kafka订阅埋点数据(私有化)

开发同学如何访问Kafka Topic中的流数据,以便进一步进行数据分析和应用,比如实时推荐等。 1. 准备工作 kafka消费只支持内网环境消费,在开始之前,需要提前准备好如下输入: Kafka 0.10.1版本及以上的客户端(脚本或JA... record : records) { System.out.println("value " + JsonIterator.deserialize(record.value())); } kafkaConsumer.commitAsync(); }}具体API及可配置参数详细参见官网文档:KafkaCon...

通过 Kafka 消费火山引擎 Proto 格式的订阅数据

关联 Kafka 和订阅任务本文以 macOS 操作系统为例,介绍如何关联 Kafka 和订阅任务。 登录 DTS 控制台,创建并配置数据订阅通道。详细信息,请参见订阅方案概览。 在目标数据订阅通道中新增消费组。详细信息,请参见新建消费组。 按需选择 Java 消费示例或 Python 消费示例,Python 语言和 Java 语言各消费示例的目录如下所示: Python 语言 . ├── dts_kafka_consumer_demo.py 消费 Demo 文件 ├── volc.proto ...

默认接入点收发消息

详细说明请参考准备工作。 1 添加配置文件创建消息队列 Kafka版配置文件 config.json。配置文件字段的详细说明,请参考配置文件。使用默认接入点时,配置文件示例如下。 说明 请根据注释提示填写相关参数,并删除注释。 json { "bootstrap.servers": "xxxxx", // 修改配置为实例的默认接入点 "topic": "xxxx", // 修改配置为待发送的 topic 名称 "consumer": { "group.id": "xxxx" // 修改为指定消费组的名称 }} 2 发送消息...

使用Logstash消费Kafka中的数据并写入到云搜索

请先点击链接创建VPC 消息队列 - Kafka 云搜索 云服务器ECS:Centos 7 在 ECS 主机上准备 Kafka 客户端的运行环境,提前安装好Java运行环境 在 ECS 主机上安装 Logstash 实验步骤 步骤一:准备 Logstash 配置文件Logstash 配置文件有如下格式: input{ 数据源}filter{ 处理方式}output{ 输出目标端}我们使用如下配置文件:在如下配置文件中的 input 部分,我们使用了 Kafka 的默认接入点地址,同时指定了需要消费的 Topi...

创建 Kafka 触发器

函数服务支持对接火山引擎的 消息队列 Kafka 版。 通过创建 Kafka 触发器,函数服务将作为消费者消费 Kafka 中的消息,并将消息传递给用户函数,触发函数代码逻辑。您无需关心函数服务消费消息的细节,只需编写处理消息的函数。本文为您介绍如何创建 Kafka 触发器。 前提条件函数已开启 VPC 调用功能,详细操作可参见 更新函数配置。 函数至少完成一次全量发布,详细操作可参见 发布函数。 已创建 Kafka 实例和 Topic,且已获得访问 Kaf...