kafka消费端出现问题

社区干货

社区干货

如何排查消费者无法连接到Kafka问题

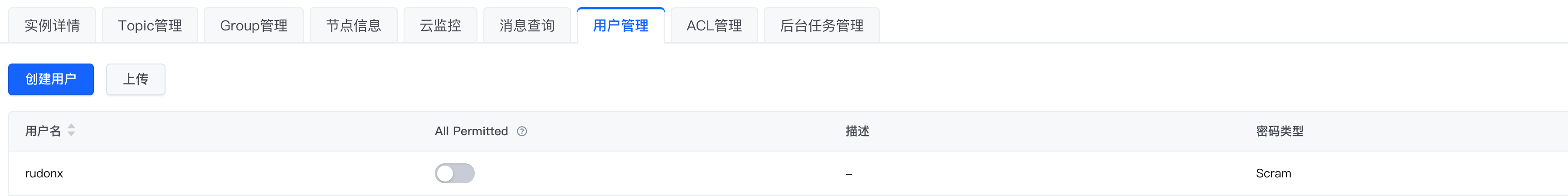

# 问题描述在开发和测试过程中,我们可能会遇到无法连接 Kafka 的情况,本文使用 kafka-console-consumer,来模拟几类常见的连接报错# 环境配置* 密码类型选择 Scram* 使用 SASL_SSL接入点,公网连接,客户端配置文件如下:```Plain Textsasl.jaas.config=org.apache.kafka.common.security.sc...

排查Kafka消息堆积的问题

# 问题描述在使用 Kafka 过程中,发现 Kafka 有消息堆积,我们该如何排查此类问题?# 问题分析通常来说,消费堆积有如下原因:1. 生产速度过快,而消费过慢,从而引起堆积。2. 消费端产生了阻塞下面我们会针对上述两种常见原因进行分析。# 解决方案## 消费者消费过慢提高消费者消费速度通常有如下方案:1. 采用多 Consumer 进程或线程同时消费数据。需要注意的是:在理想情况下,Consumer 实例的数量应该等于该 Group 订阅主题...

Kafka@记一次修复Kafka分区所在broker宕机故障引发当前分区不可用思考过程 | 社区征文

怀疑是Kafka某个节点有问题-失联-假死?## 思考过程从这个表象来看,某台机器有过宕机事件,宕机原因因环境而异,但Kafka的高可用性HA我们是耳熟能详的,为啥我们搭建的Kafka集群由多个节点组成,但其中某个节点宕掉,整个分区就不能正常使用-消费者端无法订阅到消息。 首先,我们来看下Kafka的配置信息:```js[root@xx-xx-xxx-xx kafka_2.11-2.1.1]# nohup bin/kafka-server-start.sh config/server.properties & ```!...

Kafka 消息传递详细研究及代码实现|社区征文

Kafka 是其中之一。Apache Kafka 是一个开源的分布式事件流平台,可跨多台计算机读取、写入、存储和处理事件,并有发布和订阅事件流的特性。本文将研究 Kafka 从生产、存储到消费消息的详细过程。 ## Produce... 无法进行消费、吞吐量很低、延迟高等问题。而 pull 出现这些问题的概率更小,即使 message 很多,也能根据自身服务器的速率消化数据,一直能进行消费。pull 更支持批处理,吞吐量高且有效利用了缓冲区。但 pull 也...

特惠活动

特惠活动

kafka消费端出现问题-优选内容

kafka消费端出现问题-优选内容

kafka消费端出现问题-相关内容

kafka消费端出现问题-相关内容

Kafka@记一次修复Kafka分区所在broker宕机故障引发当前分区不可用思考过程 | 社区征文

怀疑是Kafka某个节点有问题-失联-假死?## 思考过程从这个表象来看,某台机器有过宕机事件,宕机原因因环境而异,但Kafka的高可用性HA我们是耳熟能详的,为啥我们搭建的Kafka集群由多个节点组成,但其中某个节点宕掉,整个分区就不能正常使用-消费者端无法订阅到消息。 首先,我们来看下Kafka的配置信息:```js[root@xx-xx-xxx-xx kafka_2.11-2.1.1]# nohup bin/kafka-server-start.sh config/server.properties & ```!...

Topic 和 Group 管理

消息队列 Kafka版会自动为指定实例创建一个 Consumer Group,用于消费指定 Topic 中的数据。该 Group 名称以 connect-task 为前缀,并显示在该实例的 Group 列表中。 您之前如使用过 Assign 方式提交消费位点,那么也会在 Kafka 集群上创建对应的 Group。 为什么 Group 会被自动删除?消息队列 Kafka版支持自动删除 Group(auto.delete.group) 功能,您可以设置后端服务是否自动删除 Empty 状态的消费组。开启后,如果消费者组中的所有...

Kafka订阅埋点数据(私有化)

确认需要消费哪一个topic; ConsumerGroup:确认好ConsumerGroup,以免冲突,导致数据消费异常; 确认需要消费的app_id:Topic中存在多个app_id,需要消费数据后从中过滤出自己关心的app_id。 2. 订阅方式 您可以根据需要选择不同的方式订阅流数据。 2.1 Kafka Console Consumerkafka自带的工具,订阅kafka流数据,并输出到console终端,一般用于查看数据格式、排查数据问题等场景下,以下给出两种示例(不同的Kafka版本使用方式不一样),更多...

Kafka订阅埋点数据(私有化)

确认需要消费哪一个topic; ConsumerGroup:确认好ConsumerGroup,以免冲突,导致数据消费异常; 确认需要消费的app_id:Topic中存在多个app_id,需要消费数据后从中过滤出自己关心的app_id。 2. 订阅方式 您可以根据需要选择不同的方式订阅流数据。 2.1 Kafka Console Consumerkafka自带的工具,订阅kafka流数据,并输出到console终端,一般用于查看数据格式、排查数据问题等场景下,以下给出两种示例(不同的Kafka版本使用方式不一样),更多...

Kafka订阅埋点数据(私有化)

确认需要消费哪一个topic; ConsumerGroup:确认好ConsumerGroup,以免冲突,导致数据消费异常; 确认需要消费的app_id:Topic中存在多个app_id,需要消费数据后从中过滤出自己关心的app_id。 2. 订阅方式 您可以根据需要选择不同的方式订阅流数据。 2.1 Kafka Console Consumerkafka自带的工具,订阅kafka流数据,并输出到console终端,一般用于查看数据格式、排查数据问题等场景下,以下给出两种示例(不同的Kafka版本使用方式不一样),更多...

Kafka 消息传递详细研究及代码实现|社区征文

Kafka 是其中之一。Apache Kafka 是一个开源的分布式事件流平台,可跨多台计算机读取、写入、存储和处理事件,并有发布和订阅事件流的特性。本文将研究 Kafka 从生产、存储到消费消息的详细过程。 ## Produce... 无法进行消费、吞吐量很低、延迟高等问题。而 pull 出现这些问题的概率更小,即使 message 很多,也能根据自身服务器的速率消化数据,一直能进行消费。pull 更支持批处理,吞吐量高且有效利用了缓冲区。但 pull 也...

Kafka 消费者最佳实践

本文档以 Confluent 官方 Java 版本客户端 SDK 为例,介绍使用火山引擎 Kafka 实例时的消费者最佳实践。 广播与单播在同一个消费组内部,每个消息都预期仅仅只被消费组内的某个消费者消费一次,因而使用同一个消费组的... 由业务侧调用commitAsync的方法进行消费位点的提交,以避免消息处理失败后,因自动提交可能导致无法重试的问题。同时需要注意业务主动调用提交方法的频率不宜太快,处理完一批消息后定时提交一次即可,推荐 5s 提交一次...

聊聊 Kafka:Topic 创建流程与源码分析 | 社区征文

事件在消费后不会被删除。相反,您可以通过每个主题的配置设置来定义 Kafka 应该保留您的事件多长时间,之后旧事件将被丢弃。Kafka 的性能在数据大小方面实际上是恒定的,因此长时间存储数据是完全没问题的。主题是**分区的**,这意味着一个主题分布在位于不同 Kafka 代理的多个“桶”上。数据的这种分布式放置对于可伸缩性非常重要,因为它允许客户端应用程序同时从/向多个代理读取和写入数据。当一个新事件发布到一个主题时,它实际...

通过 Kafka 协议消费日志

费用说明消费日志时会产生私网或公网的读流量。价格信息请参考计费指引。 内网读流量:通过 Kafka 协议消费日志数据到火山引擎其他私网服务时,如果源日志主题和消费端属于同一地域,可以使用私网传输,此时会产生内... 在Kafka协议消费区域中,打开对应的功能开关。 在弹出对话框中确认待开启 Kafka 协议消费功能的日志项目和日志主题,并单击确定。成功开启Kafka协议消费功能之后,此日志主题的详情页面会显示 Kafka协议消费主题ID。...