flink无法从流处理作业环境中获取S3凭证

社区干货

社区干货

干货|8000字长文,深度介绍Flink在字节跳动数据流的实践

着重分享了Flink在字节跳动数据流的实践。文|Richard 字节跳动数据平台开发套件团队高级研发工程师 DataLeap 字节跳动数据流的业务背景数据流处理的主要是埋...

基于 Flink 构建实时数据湖的实践

Flink 也同样适合 **OLAP 查询**,这一点将在本文进行详细介绍。# 整体架构在基于 Flink 构建实时数据湖的整体架构中,底层使用 K8s 作为容器编排和管理平台。存储层支持 HDFS 或 S3。由于 Iceberg 良好的文件组... Schema 演进是流处理中一个常见的问题,即通过在流作业过程中动态变更目的端的 Schema 保证数据的正确写入。Iceberg 本身对 Schema 变更有很好的支持。在 Iceberg 的存储架构中:Catalog 是不存储 Schema 的,只存储最...

基于 Flink 构建实时数据湖的实践

存储层支持 HDFS 或 S3。由于 Iceberg 良好的文件组织架构和生态,所以选择了 Iceberg 作为 Table Format。计算层则使用 Flink 进行出入湖,其中 Flink SQL 是最常用的出入湖方式,同时也用 Flink Datastream API 开发... Schema 演进是流处理中一个常见的问题,即通过在流作业过程中动态变更目的端的 Schema 保证数据的正确写入。Iceberg 本身对 Schema 变更有很好的支持。在 Iceberg 的存储架构中:Catalog 是不存储 Schema 的,只存储最...

字节跳动 Flink 状态查询实践与优化

获取有效线索。 但目前对于 Flink SQL 任务来说,当我们想要查询作业 State 时,通常会因为无法获知 State 的定义方式和具体类型等信息,而导致查询 State 的成本过高。 为了解决这个问题,字节跳... 负责读取状态的 Task 会创建一个新的 StateBackend ,然后将状态文件中的数据恢复到 Statebackend 中。等到状态恢复完成之后就会遍历全部的 Key 并把对应的状态交给 ReaderFunction 处理。 特惠活动

特惠活动

flink无法从流处理作业环境中获取S3凭证-优选内容

flink无法从流处理作业环境中获取S3凭证-优选内容

flink无法从流处理作业环境中获取S3凭证-相关内容

flink无法从流处理作业环境中获取S3凭证-相关内容

基于 Flink 构建实时数据湖的实践

Flink **也同样适合 OLAP 查询** ,这一点将在本文进行详细介绍。**整体架构**在基于 Flink 构建实时数据湖的整体架构中,底层使用 K8s 作为容器编排和管理平台。存储层支持 HDFS 或 S3。由于... Schema 演进是流处理中一个常见的问题,即通过在流作业过程中动态变更目的端的 Schema 保证数据的正确写入。Iceberg 本身对 Schema 变更有很好的支持。在 Iceberg 的存储架构中:Catalog 是不存储 Schema 的,只存储最...

Flink OLAP 在资源管理和运行时的优化

Flink OLAP 作业 QPS 和资源隔离是 Flink OLAP 计算面临的最大难题,也是字节跳动内部业务使用 Flink 执行 OLAP 计算需要解决的最大痛点。本次分享将围绕 Flink OLAP 难点和瓶颈分析、作业调度、Runtime 执行、收益... 不同于流式计算任务,OLAP 任务大部分都是秒级、毫秒级的小作业,具有 QPS 高、时延小的特点。以内部业务为例,业务方要求在高峰期支持大于 200 的 QPS,并且 Lantency p99 < 2s,而优化前的 Flink 调度性能还不能满足业...

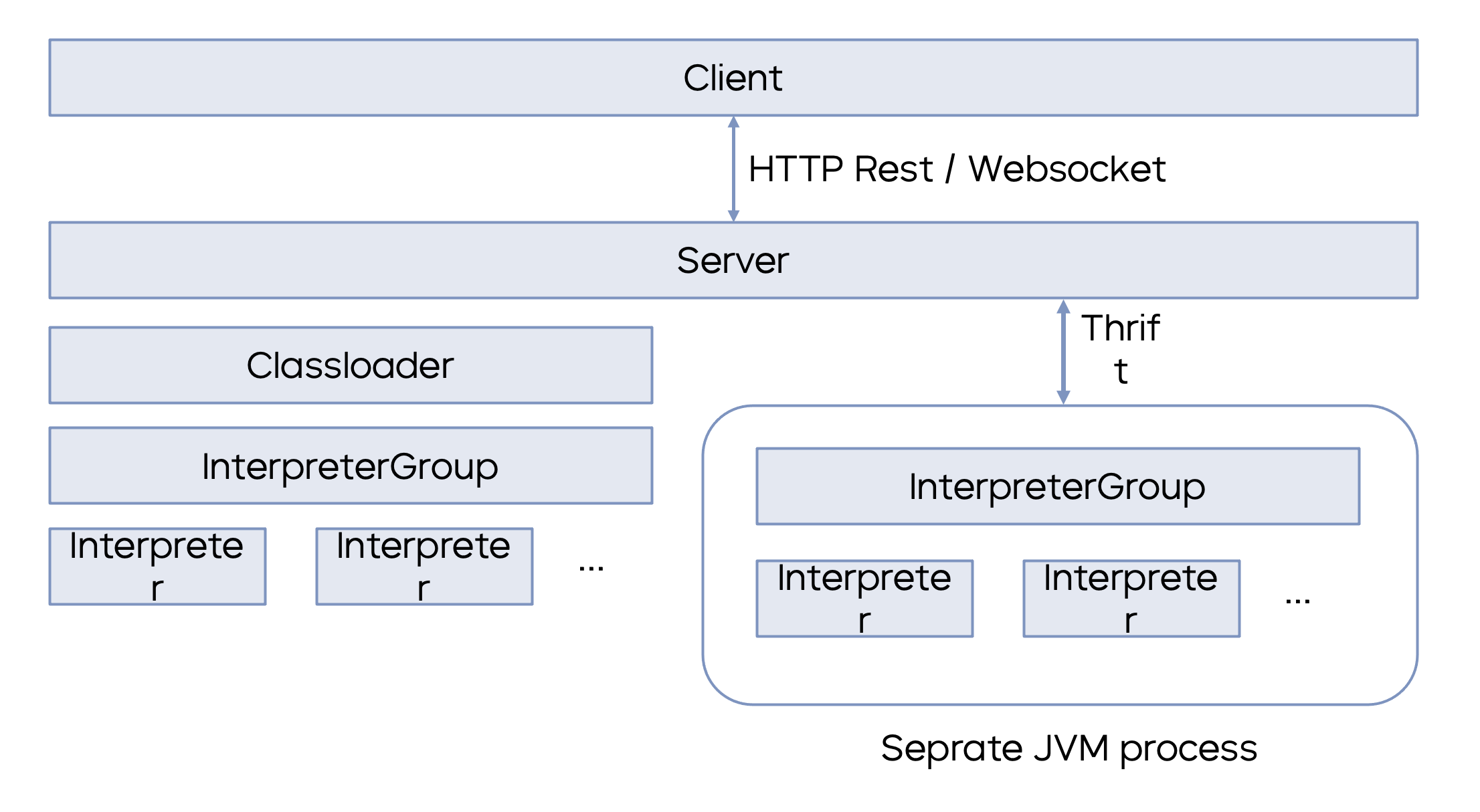

火山引擎基于 Zeppelin 的 Flink/Spark 云原生实践

环境信息。 # Apache Zeppelin 的云原生实践Apache Zeppelin 的云原生实践包含五个部分:- **Docker** **镜像优化**:开源 Zeppelin 包含了较多的解释器,在火山引擎的实践过程中,我们通过裁剪只包含 Flink 和 Spark 的部分,同时利用 Docker 镜像的多阶段构建技术,达到镜像缩小、体积缩小的目...

Flink OLAP Improvement of Resource Management and Runtime

本文整理自字节跳动基础架构工程师曹帝胄在 Flink Forward Asia 核心技术专场的分享。Flink OLAP 作业 QPS 和资源隔离是 Flink OLAP 计算面临的最大难题,也是字节跳动内部业务使用 Flink 执行 OLAP 计算需要解决的... S3%2BdRNFkePNemGu2jgYoF7XdiOg%3D)首先通过设计针对调度性能的一系列 Benchmark,从业务出发根据复杂度构建 3 组测试作业。每个 Source 节点只会产生一条数据,数据量可以忽略不计。测试环境使用 了5 台物理机...

幸福里基于 Flink & Paimon 的流式数仓实践

这种业务场景在实时数仓建模中遇到了诸多挑战。本次分享主要介绍幸福里业务基于 Flink & Paimon 构建流式数仓的实践经验,从业务背景、流批一体数仓架构、实践中遇到的问题和解决方案,借助 Paimon 最终能拿到的收益... 不能有数据丢失和重复的情况发生。- 需要全量计算,增量数据在 MQ 留存时间有限,需要拿到全量数据 View 进行计算。## 实时数仓建模特点在实际业务的实时数仓 Pipeline 中,进入实时数仓前有多个数据源,每个数...

基于 Zeppelin 的 Flink/Spark 云原生实践

文章主要介绍了 Apache Zeppelin 支持 Flink 和 Spark 云原生实践。作者|火山引擎云原生计算研发工程师-陶克路 火山引擎云原生计算研发工程师-王正**01** **Apache Zeppelin ... 环境信息。是访问火山引擎服务的安全凭证,包含Access Key ID(简称为AK)和Secret Access Key(简称为SK)两部分。您可登录火山引擎控制台,前往访问控制的访问密钥中创建及管理您的Access Key。更多信息可参考访问密钥帮助文档。 申请数据集在DataSail中确认已创建要生产或消费的数据集 环境检查Java版本需要不低于1.8 Flink版本需要不低于1.11 导入依赖下载以下JAR和POM文件 【附件下载】: flink-connecto...

Flink CEP 在抖音电商的实践

本篇内容主要从 Flink CEP 简介、业务场景与挑战、解决方案实践和未来展望四个方面展开介绍。作者|抖音电商实时数仓研发工程师-张健**01****Flink CEP 简介**