Kafkabrokers之间或者broker与客户端之间出现toomanyopenfiles错误

社区干货

社区干货

Kafka@记一次修复Kafka分区所在broker宕机故障引发当前分区不可用思考过程 | 社区征文

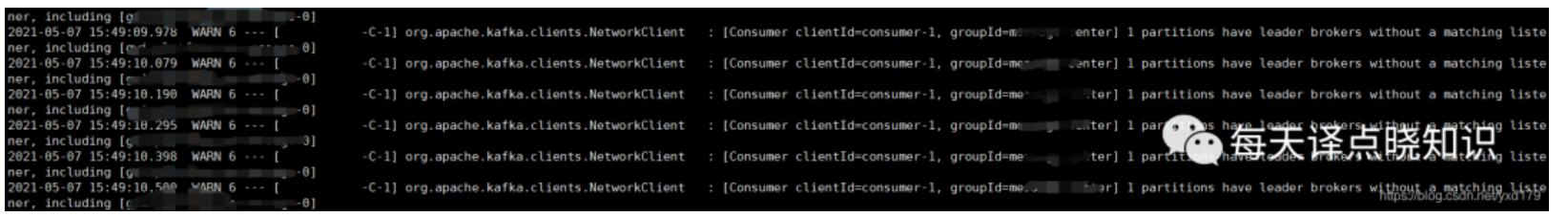

报错信息:```jsorg.apache.kafka.clients.NetworkClient : [Consumer clientId=consumer-1, groupId=xxxx-center] 1 partitions have leader brokers without a matching listener, including [xxxx-xxxx-xxxx-message-0]```## 假设猜想从字面意思来看,当前分区所对应的的broker失去监...

聊聊 Kafka:Topic 创建流程与源码分析 | 社区征文

这意味着一个主题分布在位于不同 Kafka 代理的多个“桶”上。数据的这种分布式放置对于可伸缩性非常重要,因为它允许客户端应用程序同时从/向多个代理读取和写入数据。当一个新事件发布到一个主题时,它实际上被附加... 以防万一出现问题。常见的生产设置是复制因子为 3,即,你的数据将始终存在三个副本。此复制在主题分区级别执行。在设置副本时,副本数是必须小于集群的 Broker 数的,副本只有设置在不同的机器上才有作用。## 二、...

Kafka 消息传递详细研究及代码实现|社区征文

可以节省网络带宽和Kafka存储成本。type: stringdefault: nonevalid values: [none, gzip, snappy, lz4, zstd]importance: high [**retries**](url)生产者发送消息失败或出现潜在暂时性错误时,会进行... acks = 0:producer 把消息发送到 broker 即视为成功,不等待 broker 反馈。该情况吞吐量最高,消息最易丢失acks = 1:producer 等待 leader 将记录写入本地日志后,在所有 follower 节点反馈之前就先确认成功。若 le...

消息队列选型之 Kafka vs RabbitMQ

在面对众多的消息队列时,我们往往会陷入选择的困境:“消息队列那么多,该怎么选啊?Kafka 和 RabbitMQ 比较好用,用哪个更好呢?”想必大家也曾有过类似的疑问。对此本文将在接下来的内容中以 Kafka 和 RabbitMQ 为例分... 发送方和接收方可以解耦,彼此之间不直接通信。发送方只需将消息发送到队列中,而不需要关心消息的具体处理方式和接收方的可用性。 特惠活动

特惠活动

Kafkabrokers之间或者broker与客户端之间出现toomanyopenfiles错误

-优选内容

Kafkabrokers之间或者broker与客户端之间出现toomanyopenfiles错误

-优选内容

Kafkabrokers之间或者broker与客户端之间出现toomanyopenfiles错误

-相关内容

Kafkabrokers之间或者broker与客户端之间出现toomanyopenfiles错误

-相关内容

Kafka订阅埋点数据(私有化)

本文档介绍了在增长分析(DataFinder)产品私有化部署场景下,开发同学如何访问Kafka Topic中的流数据,以便进一步进行数据分析和应用,比如实时推荐等。 1. 准备工作 kafka消费只支持内网环境消费,在开始之前,需要提前准备好如下输入: Kafka 0.10.1版本及以上的客户端(脚本或JAR包) zookeeper链接:可联系运维获取 broker链接:可联系运维获取 topic名称:下方给出了两个topic数据格式,确认需要消费哪一个topic; ConsumerGroup:确认好Co...

Kafka订阅埋点数据(私有化)

本文档介绍了在增长分析(DataFinder)产品私有化部署场景下,开发同学如何访问Kafka Topic中的流数据,以便进一步进行数据分析和应用,比如实时推荐等。 1. 准备工作 kafka消费只支持内网环境消费,在开始之前,需要提前准备好如下输入: Kafka 0.10.1版本及以上的客户端(脚本或JAR包) zookeeper链接:可联系运维获取 broker链接:可联系运维获取 topic名称:下方给出了两个topic数据格式,确认需要消费哪一个topic; ConsumerGroup:确认好C...

Kafka订阅埋点数据(私有化)

本文档介绍了在增长分析(DataFinder)产品私有化部署场景下,开发同学如何访问Kafka Topic中的流数据,以便进一步进行数据分析和应用,比如实时推荐等。 1. 准备工作 kafka消费只支持内网环境消费,在开始之前,需要提前准备好如下输入: Kafka 0.10.1版本及以上的客户端(脚本或JAR包) zookeeper链接:可联系运维获取 broker链接:可联系运维获取 topic名称:下方给出了两个topic数据格式,确认需要消费哪一个topic; ConsumerGroup:确认好Co...

Kafka 集群数据均衡

Kakfa 实例均为集群化部属,每个 Kakfa 实例由多个 Broker 组成。本文档介绍如何保障 Kafka 集群各个 Broker 之间的数据均衡。 数据均衡每个 Kakfa 实例由多个 Broker 组成。不同 Broker 之间的数据流量、磁盘占用率... Broker 数量 = 0 规范数据写入方式除了合理创建资源之外,还需要规范消息生产行为,尽可能保证数据的均衡性。建议生产者客户端在消息发送时使每个分区尽可能被公平的选择,例如消息发送时的分区选择使用轮询的方式。...

高阶使用

本文将为您介绍火山引擎 E-MapReduce(EMR)kafka 组件相关的高阶使用,方便您更深入的使用 Kafka。 扩容 您可以在 EMR 控制台的集群管理页面,进行 Kafka 集群的扩容操作。开源 Kafka 扩容新的 broker 后,流量不会自动迁移到新 broker 上。通常有两种方式将流量迁移到新的 broker。 扩分区:脚本直接扩容分区。比如之前有 12 个分区,扩容到 24 个分区。新分区会根据策略分配到新的 broker 上,是最简单的方式。缺点是老的分区还是在老...

创建并连接到 Kafka 集群

前言 Kafka是是一个分布式、支持分区的(partition)、多副本的(replica) 分布式消息系统, 深受开发人员的青睐。在本教程中,您将学习如何创建 Kafka 集群,并使用客户端连接,生产数据并消费数据。 关于实验 预计部署时... kafka/2.2.0/kafka_2.11-2.2.0.tgztar zxvf kafka_2.11-2.2.0.tgz步骤4:启动producer并输入测试数据undefined [root@rudonx kafka_2.11-2.2.0] bin/kafka-console-producer.sh --broker-list kafka-xxxxx.kafka.iv...

Kafka 迁移上云(方案二)

本文介绍通过方案二将开源 Kafka 集群迁移到火山引擎消息队列 Kafka版的操作步骤。 注意事项业务迁移只迁移消息生产、消费链路和业务流量,并不会迁移 Kafka 旧集群上的消息数据。 创建 Kafka 实例、迁移消息收发链... 当其中一个 Broker 故障时仍可保障数据可用性,副本数越大可靠性越高。 Group ID Group 的 ID,即生产和消费时指定的消费组 Group ID。 在火山引擎消息队列 Kafka版控制台中创建同样数量和配置的 Topic。您可以根...

Kafka 迁移上云(方案一)

本文介绍通过方案一将开源 Kafka 集群迁移到火山引擎消息队列 Kafka版的操作步骤。 注意事项业务迁移只迁移消息生产、消费链路和业务流量,并不会迁移 Kafka 旧集群上的消息数据。 创建Kafka实例、迁移消息收发链路... 当其中一个 Broker 故障时仍可保障数据可用性,副本数越大可靠性越高。 Group ID Group 的 ID,即生产和消费时指定的消费组 Group ID。 在火山引擎消息队列 Kafka版控制台中创建同样数量和配置的 Topic。您可以根...

消息队列选型之 Kafka vs RabbitMQ

在面对众多的消息队列时,我们往往会陷入选择的困境:“消息队列那么多,该怎么选啊?Kafka 和 RabbitMQ 比较好用,用哪个更好呢?”想必大家也曾有过类似的疑问。对此本文将在接下来的内容中以 Kafka 和 RabbitMQ 为例分... 发送方和接收方可以解耦,彼此之间不直接通信。发送方只需将消息发送到队列中,而不需要关心消息的具体处理方式和接收方的可用性。