w10安装cuda

社区干货

社区干货

Linux安装CUDA

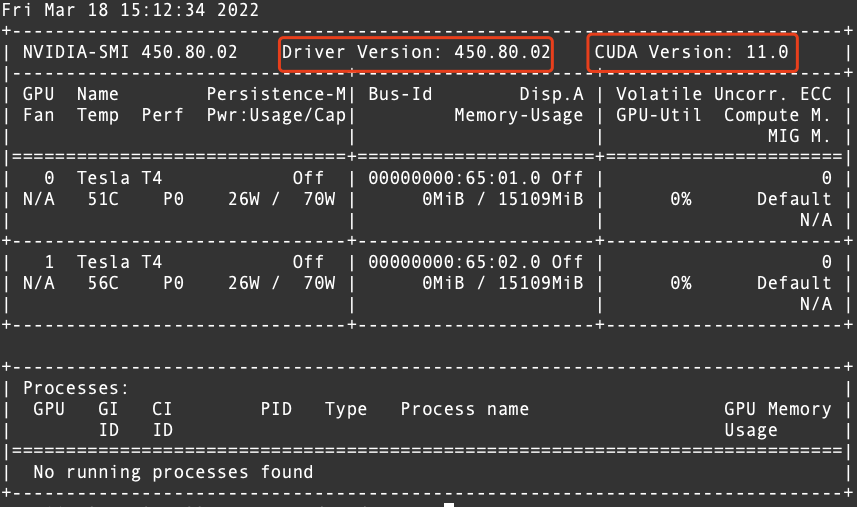

# 运行环境 * CentOS * RHEL * Ubuntu * OpenSUSE # 问题描述 初始创建的火山引擎实例并没有安装相关cuda软件,需要手动安装。 # 解决方案 1. 确认驱动版本,以及与驱动匹配的cuda版本,执行命令`nvidia-smi`显示如下。  从上�

我的AI学习之路----拥抱Tensorflow 拥抱未来|社区征文

> `前言:` “Hello,大家好我叫是Dream呀!” 不知不觉,这句话已经陪伴了我一年多了。也许你是第一次听,但这并没有关系,因为时间无言,相遇即缘!😜 # 写在前面 2020年10月08日,我正式接��

【高效视频处理】体验火山引擎多媒体处理框架 BMF |社区征文

BMF访问链接:

如何对 Linux 操作系统的 GPU 实例进行压测?

# 问题描述 Linux 操作系统的 GPU 实例如何进行压力测试以及性能测试? # 问题分析 GPU_BURN 是一款开源的软件,可以对 GPU 进行压力测试。 GPU 性能测试使用 CUDA sample 自带的 deviceQuery、bandwith 稳定性测试以及性能测试。 # 解决方案 所有的测试均需要在 GPU 实例上面安装相对应的 cuda 版本,具体请参考如

特惠活动

特惠活动

w10安装cuda-优选内容

w10安装cuda-优选内容

w10安装cuda-相关内容

w10安装cuda-相关内容

GPU实例部署paddlepaddle-gpu环境

本文介绍 GPU 实例部署深度学习Paddle环境。 前言 在ECS GPU实例上部署深度学习Paddle环境。 关于实验 预计实验时间:20分钟级别:初级相关产品:ECS受众: 通用 环境说明 本文测试规格如下:实例规格:ecs.pni2.3xlargeGPU 类型:Tesla A100 80G显存容量:81920MiB实例镜像:velinux - 1.0 with GPU DriverNVIDIA-SMI:470.57.02NVID

安装GPU驱动

背景信息GPU云服务器正常工作需提前安装正确的基础设施软件,对NVIDIA Tesla系列的GPU而言,有以下两个层次的软件包需要安装: 驱动GPU工作的硬件驱动程序。 上层应用程序所需要的库。 在通用计算场景下,如深度学习、AI等通用计算业务场景或者OpenGL、Direct3D、云游戏等图形加速场景,安装了Tesla驱动�

NVIDIA驱动安装指引

驱动说明NVIDIA驱动程序是用来驱动NVIDIA GPU卡的程序,是硬件所对应的软件,用于提升操作系统对其芯片组的兼容性。当前火山引擎提供的GPU实例均为计算型,即GPU卡直通型,实例必须安装GPU驱动来驱动物理GPU卡,以获得GPU卡的能力。 GPU实例当前支持安装以下两种NVIDIA驱动,建议您安装最新版本的驱动��

新功能发布记录

本文介绍了GPU云服务器各特性版本的功能发布和对应的文档动态,新特性将在各个地域(Region)陆续发布,欢迎体验。 说明 “邀测”产品或功能暂未对全部用户开放。为方便了解产品,部分“邀测”产品或功能的配套文档已开放给全部用户,同时存在一部分“邀测”产品或功能的配套文档仅开通产品��

NVIDIA驱动FAQ

实例如何安装GPU驱动?您可结合实际情况,直接创建已安装GPU驱动的实例,或在已有实例上自行安装GPU驱动: 创建已安装GPU驱动的实例您可在创建GPU实例时,通过以下方式直接使用已安装GPU驱动的实例:在创建实例页面的“镜像”中,选择公共镜像,勾选“后台自动安装GPU驱动”即可自动安装驱动,建

我的AI学习之路----拥抱Tensorflow 拥抱未来|社区征文

> `前言:` “Hello,大家好我叫是Dream呀!” 不知不觉,这句话已经陪伴了我一年多了。也许你是第一次听,但这并没有关系,因为时间无言,相遇即缘!😜 # 写在前面 2020年10月08日,我正式接��

卸载NVIDIA Tesla驱动

卸载NVIDIA Tesla驱动(Linux)注意事项卸载GPU驱动需要root账号操作权限,如果您是普通用户,请使用sudo命令获取root权限后再操作,本文以root登录系统操作为例。 卸载不同CUDA版本的命令可能不同,若不存在cuda-uninstaller文件, 请进入“/usr/local/cuda/bin/”目录查看是否存在uninstall_cuda开头的文件。若有,请�

GPU服务器使用

本文将介绍如何创建并使用GPU云服务器。 前言GPU云服务器(GPU Compute service)是提供 GPU 算力的弹性计算服务,拥有超强的计算能力,能高效服务于机器学习、科学计算、图形处理、视频编解码等多种场景,本文将介绍如何创建并使用GPU云服务器。 关于实验 预计部署时间:30分钟 级别:初级 相关产品:

GPU-搭建AIGC能力(Windows)

本文介绍如何部署Stable Diffusion WebUI工具前端和Stable Diffusion训练模型,实现高质量AI图片生成,掌握整个AI作画推理流程及关键参数对图片输出的影响。 AIGC简介AIGC(AI generated content)是一种利用AI技术自动生成内容的生产方式,代表着AI从理解语言、理解文字、理解图片和视频,走向了生成内容,是一种�