基于hadoop的数据仓库工具

社区干货

社区干货

浅谈大数据建模的主要技术:维度建模 | 社区征文

## 前言我们不管是基于 Hadoop 的数据仓库(如 Hive ),还是基于传统 MPP 架构的数据仓库(如Teradata ),抑或是基于传统 Oracle 、MySQL 、MS SQL Server 关系型数据库的数据仓库,其实都面临如下问题:- 怎么组织数据仓库中的数据?- 怎么组织才能使得数据的使用最为方便和便捷?- 怎么组织才能使得数据仓库具有良好的可扩展性和可维护性?> **Ralph Kimball 维度建模理论很好地回答和解决了上述问题。**维度建模理论和技术也是...

干货 |揭秘字节跳动基于 Doris 的实时数仓探索

技术能力和工具开放给外部企业,提供云基础、视频与内容分发、数据平台 VeDI、人工智能、开发与运维等服务,帮助企业在数字化升级中实现持续增长。火山引擎 EMR 是一款云原生开源大数据平台产品。首先,从开源大数据... 数据生态的众多软件栈,包括 Hadoop、Spark、Flink 等引擎,并且做到100%开源兼容。Doris 作为一款 OLAP 领域极具代表性的开源组件,所以我们也将其集成在火山引擎 EMR 生态中。其次,从云原生角度,我们也会基于云的特...

干货|揭秘字节跳动对Apache Doris 数据湖联邦分析的升级和优化

>火山引擎 EMR 作为一款云原生开源大数据平台产品,集成了包括 Hadoop、Spark、Flink 等引擎,并做到100%开源兼容。Doris 作为 OLAP 领域中一款极具代表性的开源组件,也被集成到了火山引擎 EMR 产品生态中。 > 本文... 其次介绍 Apache Doris 数据湖联邦分析的整体设计和相关特性,最后介绍 Apache Doris 在数据湖联邦分析上的未来规划。# 1. 湖仓一体架构演进回顾湖仓一体的发展史,主要经历了三个阶段。第一个阶段是数据仓库,第...

揭秘字节跳动基于 Doris 的实时数仓探索

昭伟** 来自字节跳动数据平台E-MapReduce团队火山引擎是字节跳动旗下的云服务平台,将字节跳动快速发展过程中积累的增长方法、技术能力和工具开放给外部企业,提供云基础、视频与内容分发、数据平台 VeDI、人工智... 数据生态的众多软件栈,包括 Hadoop、Spark、Flink 等引擎,并且做到100%开源兼容。Doris 作为一款 OLAP 领域极具代表性的开源组件,所以我们也将其集成在火山引擎 EMR 生态中。其次,从云原生角度,我们也会基于云的特...

特惠活动

特惠活动

基于hadoop的数据仓库工具-优选内容

基于hadoop的数据仓库工具-优选内容

基于hadoop的数据仓库工具-相关内容

基于hadoop的数据仓库工具-相关内容

揭秘字节跳动基于 Doris 的实时数仓探索

昭伟** 来自字节跳动数据平台E-MapReduce团队火山引擎是字节跳动旗下的云服务平台,将字节跳动快速发展过程中积累的增长方法、技术能力和工具开放给外部企业,提供云基础、视频与内容分发、数据平台 VeDI、人工智... 数据生态的众多软件栈,包括 Hadoop、Spark、Flink 等引擎,并且做到100%开源兼容。Doris 作为一款 OLAP 领域极具代表性的开源组件,所以我们也将其集成在火山引擎 EMR 生态中。其次,从云原生角度,我们也会基于云的特...

干货 | 这样做,能快速构建企业级数据湖仓

**基于** **火山引擎** **EMR** **构建企业级** **数据湖** **仓**=======================================================火山引擎EMR 一句话总结,火山引擎 EMR 是开源大数据平台 E-MapReduce,提供企业级的 Hadoop、Spark、Flink、Hive、Presto、Kafka、ClickHouse、Hudi、Iceberg 等大数据生态组件,100% 开源兼容,支持构建实时数据湖、数据仓库、湖仓一体等数据平台架构,能帮助用户轻松完...

观点 | 数仓领域的未来趋势解读

字节跳动数据平台> > > 数据仓库发展历程很久,随着云计算等技术发展以及海量数据应用场景等出现,对数据仓库提出全新要求,高性能、实时性、云原生等成为数据仓库发展关键词,也因此演变出不同的数仓发... 往往是数据量最大的数据源,包括用户访问日志、用户操作记录等,数据量通常是业务数据的数百倍。 **随着大数据应用的深入发展,最核心的业务需求如下:****1)提高分析的实时性**最近10年,以hadoop技术...

ELT in ByteHouse 实践与展望

用户可以将数据导入后,通过自定义的SQL语句,在ByteHouse内部进行数据转换,而无需依赖独立的ETL系统及资源。 火山引擎ByteHouse是一款基于开源ClickHouse推出的云原生数据仓库,本篇文章将介绍ByteHouse团队如... **数据预计算流派**:如Kylin等。如果Hadoop系统中出报表较慢或聚合能力较差,可以去做一个数据的预计算,提前将配的指标的cube或一些视图算好。实际SQL查询时,可以直接用里面的cube或视图做替换,之后直接返回。...

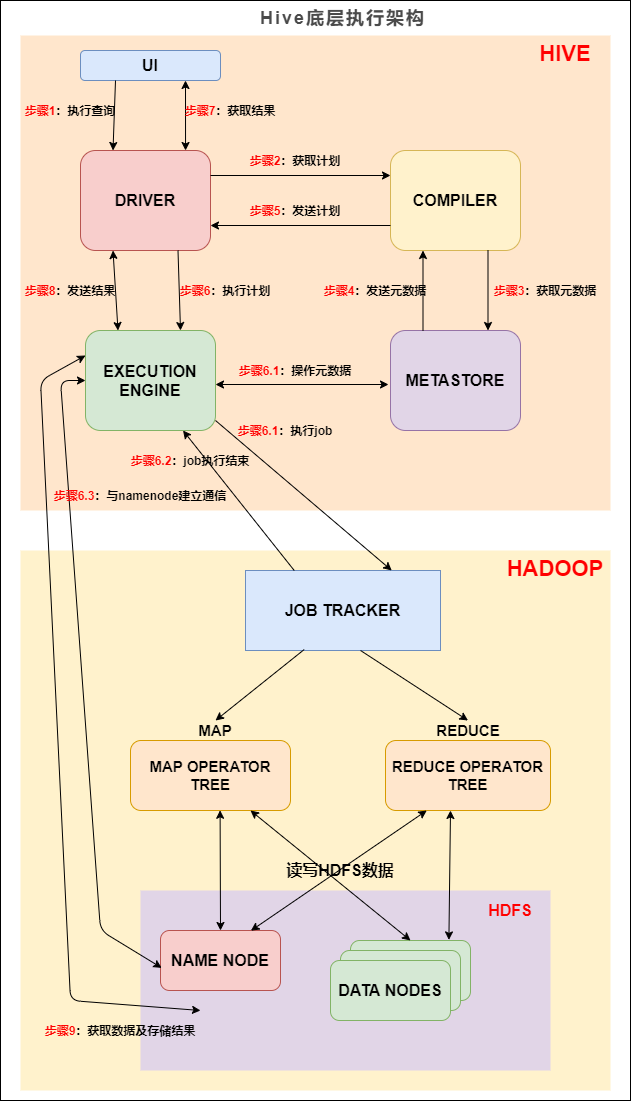

Hive SQL 底层执行过程 | 社区征文

Hive 是数据仓库工具,再具体点就是一个 SQL 解析引擎,因为它即不负责存储数据,也不负责计算数据,只负责解析 SQL,记录元数据。Hive直接访问存储在 HDFS 中或者 HBase 中的文件,通过 MapReduce、Spark 或 Tez 执行... Hive 的主要组件与 Hadoop 交互的过程:在 Hive 这一侧,总共有五个组件:1. UI:用户界面。可看作我们提交SQL语句的命令行界面。...

EMR-3.9.0发布说明

环境信息版本 环境 OS veLinux(Debian 10兼容版) Python2 2.7.16 Python3 3.10.13 Java ByteOpenJDK 1.8.0_352 系统环境应用程序版本 Hadoop集群 Flink集群 Kafka集群 Pulsar集群 Presto集群 Trino集群 HBase集群 ... 以及访问Paimon数据。且在Spark和Flink中集成了StarRocks connector。 【组件】Hudi组件版本由0.12.2升级为0.14.1。 【组件】Iceberg组件版本由1.2.0升级为1.4.3。 【组件】Airflow组件版本由2.4.2升级为2.7.3。...

观点|SparkSQL在企业级数仓建设的优势

**惊帆** 来自 字节跳动数据平台EMR团队EMR 前言Apache Hive 经过多年的发展,目前基本已经成了业界构建超大规模数据仓库的事实标准和数据处理工具,Hive已经不单单是一个技... 数仓架构通常是一个企业数据分析的起点,在数仓之下会再有一层数据湖,用来做异构数据的存储以及数据的冷备份。但是也有很多企业,特别是几乎完全以结构化数据为主的企业在实施上会把数据湖和企业数仓库合并,基于某个...

EMR-2.0.0版本说明

环境信息 系统环境版本 环境 OS veLinux(Debian 10兼容版) Python2 2.7.16 Python3 3.7.3 Java ByteOpenJDK 1.8.0_302 应用程序版本 Hadoop集群 Flume 1.9.0 OpenLDAP 2.4.58 Ranger 1.2.0 ZooKeeper 3.7.0 Flink ... Hive可使用TOS作为数据存储介质。 支持多种方式访问TOS:自定义配置方式配置AK/SK、环境变量配置AK/SK和对VEECSforEMRRole角色授权TOS访问权限 【组件】基于Ranger提供HDFS、YARN、Hive组件的权限访问控制。 已...

火山引擎云原生数据仓库 ByteHouse 技术白皮书 V1.0(上)

> 更多技术交流、求职机会,欢迎关注**字节跳动数据平台微信公众号,回复【1】进入官方交流群** **近日,《火山引擎云原生数据仓库 ByteHouse 技术白皮书》正式发布。** 白皮书简述了 ByteHouse 基于 ClickHous... ByteHouse 需要支持海量数据的实时接入、无限扩展存储、实时合并计算和关联聚合查询。 **随着大数据应用的深入发展,最核心的业务需求如下:****1)提高分析的实时性**最近 10 年,以 hadoop 技术体系为代表...