为什么删除Kafka主题可能会花费很长时间?

社区干货

社区干货

聊聊 Kafka:Topic 创建流程与源码分析 | 社区征文

## 一、Topic 介绍Topic(主题)类似于文件系统中的文件夹,事件就是该文件夹中的文件。Kafka 中的主题总是多生产者和多订阅者:一个主题可以有零个、一个或多个向其写入事件的生产者,以及零个、一个或多个订阅这些事件的消费者。可以根据需要随时读取主题中的事件——与传统消息传递系统不同,事件在消费后不会被删除。相反,您可以通过每个主题的配置设置来定义 Kafka 应该保留您的事件多长时间,之后旧事件将被丢弃。Kafka 的性能在...

Pulsar 在云原生消息引擎领域为何如此流行?| 社区征文

主题的多种订阅模式(独占、共享和故障转移)。 - 通过 Apache BookKeeper 提供的持久化消息存储机制保证消息传递 。 - 由轻量级的 serverless 计算框架 Pulsar Functions 实现流原生的数据处理。 - 基于 Pulsar Functions 的 serverless connector 框架 Pulsar IO 使得数据更易移入、移出 Apache Pulsar。 - 分层式存储可在数据陈旧时,将数据从热存储卸载到冷/长期存储(如S3、GCS)中。## 二、什么是云原生既然说 Pulsar...

干货 | 实时数据湖在字节跳动的实践

支持对海量的离线数据做更新删除。**第二是智能的查询加速。**用户使用数据湖的时候,不希望感知到数据湖的底层实现细节,数据湖的解决方案应该能够自动地优化数据分布,提供稳定的产品性能。**第三是批流... 为什么Hive Matestore 没有办法去满足元数据管理的这个诉求?这就涉及到数据湖管理元数据的特殊性。以Hudi为例,作为一个典型的事务型数据湖,Hudi使用时间线 Timeline 来追踪针对表的各种操作。比如commit comp...

干货 | 实时数据湖在字节跳动的实践

支持对海量的离线数据做更新删除。**第二是智能的查询加速。** 用户使用数据湖的时候,不希望感知到数据湖的底层实现细节,数据湖的解决方案应该能够自动地优化数据分布,提供稳定的产品性能。**第三是批流一体的... 为什么Hive Matestore 没有办法去满足元数据管理的这个诉求?这就涉及到数据湖管理元数据的特殊性。以Hudi为例,作为一个典型的事务型数据湖,Hudi使用时间线 Timeline 来追踪针对表的各种操作。比如 commit compac...

特惠活动

特惠活动

为什么删除Kafka主题可能会花费很长时间?-优选内容

为什么删除Kafka主题可能会花费很长时间?-优选内容

为什么删除Kafka主题可能会花费很长时间?-相关内容

为什么删除Kafka主题可能会花费很长时间?-相关内容

Datafinder用户使用常见FAQ

每一个动作的时间戳,在离开页面时上报predefine_page_close埋点,将每一段活跃状态的时长相加作为用户单次使用时长。 3、为什么小程序应用中分享分析没有数据? 请检查一下相关设置,具体说明为:init初始化中设置auto... 会在每个页面离开时上报这个pv_hide事件。 11、HTTP API 里面的platform字段值可以随便传吗? platform平台类型,不是必填字段,可以自定义值进行上传;但随便传可能会影响应用概况功能的分析;应用概况中终端platform ...

干货|8000字长文,深度介绍Flink在字节跳动数据流的实践

数据延迟可能会影响推荐效果、广告收入、实时数据报表。同时随着业务发展,实时数据需求日益增加,分流规则新增和修改也会日益频繁。如果每次规则变动都需要修改代码并重启Flink Job,会影响很多下游,因此 **分... 和Kafka的性能瓶颈、以及JSON数据格式带来的性能和数据质量问题都一一显现出来,与此同时下游业务对延迟、数据质量的敏感程度却是与日俱增。于是,我们一方面对一些痛点进行了针对性的优化。另一方面,花费1年多...

干货|8000字长文,深度介绍Flink在字节跳动数据流的实践

数据延迟可能会影响推荐效果、广告收入、实时数据报表。同时随着业务发展,实时数据需求日益增加,分流规则新增和修改也会日益频繁。如果每次规则变动都需要修改代码并重启Flink Job,会影响很多下游,因此**分流规则... PyFlink和Kafka的性能瓶颈、以及JSON数据格式带来的性能和数据质量问题都一一显现出来,与此同时下游业务对延迟、数据质量的敏感程度却是与日俱增。于是,我们一方面对一些痛点进行了针对性的优化。另一方面,花费1...

一种在数据量比较大、字段变化频繁场景下的大数据架构设计方案|社区征文

设置一个较长的保存周期。kafka直接作为数仓的存储层,优点是不关心数据的格式,不管源系统字段怎么变,都可以JSON、Avro、Protobuf等格式存储,并且可以轻松地扩展,可以处理大量数据,达到高吞吐量和低延迟。同时可以实时数据处理,可以将多个数据源汇聚到同一个Kafka主题中,方便在数仓中使用。> 注:Avro和Protobuf都是二进制数据序列化格式,相比于JSON这种文本格式,它们在存储和传输时更加紧凑,解析和序列化效率更高。Avro和Protob...

火山引擎DataLeap:「数据血缘」踩过哪些坑?来看看字节跳动内部进化史

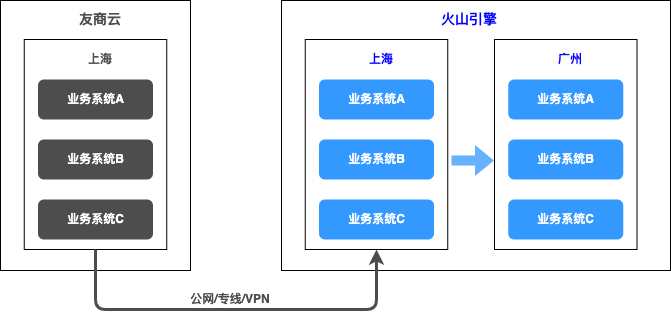

后面将为大家详细解答为什么要通过对比的方式。3. 冗余一份元数据存储到图数据库中。### **存储模型**:上云迁移背景与流程

另外相同的产品价格也会有差异。企业无论是出于成本考虑,还是业务需求考虑,都是有可能需要把已经在云上的业务,迁移到其他云上。 ### 云迁移策略云迁移可能会涉及到将所有系统和数据迁移到云上,没有放之四海而皆准的方法可以应用于整个应用程序产品组合。您需要考虑一些因素,例如您的组织采用云的时间表、迁...