hbase本地文件系统

社区干货

社区干货

9年演进史:字节跳动 10EB 级大数据存储实战

# 背景## **HDFS** **简介**HDFS 全名 Hadoop Distributed File System,是业界使用最广泛的开源分布式文件系统。原理和架构与 Google 的 GFS 基本一致。它的特点主要有以下几项:- 和本地文件系统一样的目录... HBase,日志服务,Kafka 数据存储 - Yarn,Flink 的计算框架平台数据 - Spark,MapReduce 的计算相关数据存储![]()# **字节跳动特色的** **HDFS** **架构**在深入相关的技术细节之前,我们先看看字节跳动的 H...

9年演进史:字节跳动 10EB 级大数据存储实战

是业界使用最广泛的开源分布式文件系统。原理和架构与 Google 的 GFS 基本一致。它的特点主要有以下几项:* 和本地文件系统一样的目录树视图* Append Only 的写入(不支持随机写)* 顺序和随机读* 超大数据... HBase,日志服务,Kafka 数据存储* Yarn,Flink 的计算框架平台数据* Spark,MapReduce 的计算相关数据存储**02****字节跳动特色的 HDFS 架构**在深入相关的技术细节之前,我...

万字长文,Spark 架构原理和 RDD 算子详解一网打进! | 社区征文

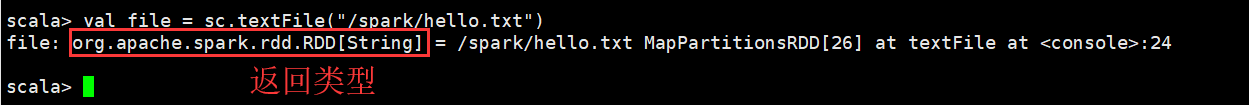

由外部存储系统的数据集创建,包括本地的文件系统,还有所有Hadoop支持的数据集,比如HDFS、Cassandra、HBase等```cppscala> val file = sc.textFile("/spark/hello.txt")```### 3.2 通过并行化的方式创建RDD由一个已经存在的Scala集合创建。```cppscala> val array = Array(1,2,3,4,5)array: Array[Int] = Array(1, 2, 3, 4, 5)scala> val ...

基于国产化环境的金融级业务系统性能优化实践|社区征文

操作系统采用国产Kylin操作系统;- 数据库采用国产分布式数据库,QianBase;QianBase是基于Trafodion架构。Trafodion是HP公司资助的一个开源项目。它提供了一个成熟的企业级SQL on HBase解决方案。Trafodion的主要... 文件系统在通过驱动读写磁盘时,不会立即将读写请求发送给驱动,而是延迟执行, 这样Linux内核的I/O调度器可以将多个读写请求合并为一个请求或者排序(减少机械磁盘的寻址)发送给驱动,提升性能。目前Linux版本主要支...

特惠活动

特惠活动

hbase本地文件系统-优选内容

hbase本地文件系统-优选内容

hbase本地文件系统-相关内容

hbase本地文件系统-相关内容

使用 HBase Shell 连接实例

如需通过公网地址访问 HBase 实例,需确保运行 Java 工具的设备 IP 地址已加入 HBase 实例的白名单中。白名单设置方法,请参见编辑白名单。 已在 ECS 实例或本地设备上安装 Java 环境,建议使用 JDK 8 版本。更多详... 在页面右下方单击 HBase Shell 下载。 解压 HBase Shell 工具包,并修改 hbase-2.x/conf/hbase-site.xml 文件中的配置。 bash 解压 HBase Shell 工具包tar -zxvf hbase-shell-2.x-tar.gz 编辑 hbase-site.xml 文...

使用 HBase Shell 连接实例

如需通过公网地址访问 HBase 实例,需确保运行 Java 工具的设备 IP 地址已加入 HBase 实例的白名单中。白名单设置方法,请参见编辑白名单。 已在 ECS 实例或本地设备上安装 Java 环境,建议使用 JDK 8 版本。更多详... 在页面右下方单击 HBase Shell 下载。 解压 HBase Shell 工具包,并修改 hbase-2.x/conf/hbase-site.xml 文件中的配置。 bash 解压 HBase Shell 工具包tar -zxvf hbase-shell-2.x-tar.gz 编辑 hbase-site.xml 文...

编辑白名单

表格数据库 HBase 版实例创建成功后,您可以为实例设置白名单,以允许设备访问该实例。本文介绍如何编辑白名单,包括修改分组名称和 IP 地址。 前提条件设置白名单前,您需要先获取客户端 IP 地址。 访问方式 IP 地址获取方式 火山引擎 ECS 私网访问 在 ECS 中,执行 ifconfig 命令查看网卡信息。 本地客户端公网访问 根据操作系统,选择对应的方法: Linux 操作系统:执行 curl ipinfo.io grep ip 命令,获取公网 IP 地址。 Windows 操...

Java 程序通过 Thrift2 地址访问 HBase 实例

前提条件如需通过私网地址访问 HBase 实例,需同时满足如下要求: 已购 ECS 服务器与 HBase 实例在相同私有网络 VPC 下。ECS 服务器的购买方法,请参见购买云服务器。 已将 ECS 服务器的 IP 地址添加至 HBase 中的白名单中。白名单设置方法,请参见编辑白名单。 如需通过公网地址访问 HBase 实例,需确保运行 Java 工具的设备 IP 地址已加入 HBase 实例的白名单中。白名单设置方法,请参见编辑白名单。 已在 ECS 实例或本地设备上安...

9年演进史:字节跳动 10EB 级大数据存储实战

# 背景## **HDFS** **简介**HDFS 全名 Hadoop Distributed File System,是业界使用最广泛的开源分布式文件系统。原理和架构与 Google 的 GFS 基本一致。它的特点主要有以下几项:- 和本地文件系统一样的目录... HBase,日志服务,Kafka 数据存储 - Yarn,Flink 的计算框架平台数据 - Spark,MapReduce 的计算相关数据存储![]()# **字节跳动特色的** **HDFS** **架构**在深入相关的技术细节之前,我们先看看字节跳动的 H...

HBase

HBase 连接器提供了对分布式 HBase 数据库表的读写数据能力,支持做数据源表、结果表和维表。 使用限制Flink 目前提供了 HBase-1.4 和 HBase-2.2 两种连接器,请根据实际情况选择: 在 Flink 1.11-volcano 引擎版本中仅支持使用 HBase-1.4 连接器。 在 Flink 1.16-volcano 引擎版本中支持使用 HBase-1.4 和 HBase-2.2 两种连接器。 注意事项在公网环境中连接火山 HBase 时,您需要添加以下两个参数: 'properties.zookeeper.znode.me...

设置白名单

白名单是数据库连接的安全防控手段。创建 HBase 实例后,默认禁止所有 IP 地址访问实例。本文介绍如何手动将客户端 IP 地址或地址段添加到白名单,来访问 HBase 实例。 前提条件设置白名单前,您需要先获取客户端 IP 地址。 访问方式 IP 地址获取方式 火山引擎 ECS 私网访问 在 ECS 中,执行 ifconfig 命令查看网卡信息。 本地客户端公网访问 根据操作系统,选择对应的方法: Linux 操作系统:执行 curl ipinfo.io grep ip 命令,获取公...

功能发布记录(2023年)

本文为您介绍 2023 年大数据研发治理套件 DataLeap 产品功能和对应的文档动态。 2023/12/21序号 功能 功能描述 使用文档 1 数据集成 ByteHouse CDW 离线写入时,支持写入动态分区; HBase 数据源支持火山引擎 ... 系统管理等全量功能。 数据开发 离线集成 流式集成 数据监控 数据探查 数据对比 数据地图 数据服务 2 数据开发 临时查询支持交互式分析 Notebook 查询类型。 LAS SQL 依赖推荐功能支持引导创建 Sensor 任务。 ...

EMR-2.4.0 版本说明

环境信息 系统环境版本 环境 OS veLinux(Debian 10兼容版) Python2 2.7.16 Python3 3.7.3 Java ByteOpenJDK 1.8.0_352 应用程序版本 Hadoop集群 HBase集群 HDFS 2.10.2 2.10.2 YARN 2.10.2 2.10.2 MapReduce2 2.10... 加载本地jar到ClassPath,替换从HDFS下载。 【组件】Hive中新增 JobCommitter 功能,大幅提升存算分离场景下写数据到 TOS 的性能。 【组件】Hue组件升级至4.11.0版本。 组件版本 下面列出了 EMR 和此版本一起安装...