apikafka日志配置

社区干货

社区干货

Logstash 如何通过 Kafka 协议消费 TLS 日志

# **问题现象**如何通过修改 Logstash 配置文件,实现通过 Kafka 协议消费日志到其他业务系统。# 问题分析TLS 日志服务支持通过 Logstash 消费日志数据,您可以通过配置 Logstash 服务内置的 logstash-input-kafka 插件获取日志服务中的日志数据。# 解决方案## 1.安装 logstash1.1 [下载安装包](https://www.elastic.co/cn/downloads/logstash)。1.2 解压安装包到指定目录。1.3 查看logstash 版本```Java[root@lxb-jms ...

Kafka 消息传递详细研究及代码实现|社区征文

Kafka Documentation 中 *[Producer Configs](https://kafka.apache.org/documentation/#producerconfigs)* 里有相关配置说明:[**compression.type**](url)生产者生成的数据的压缩类型。通过使用压缩,可以节省... acks = 1:producer 等待 leader 将记录写入本地日志后,在所有 follower 节点反馈之前就先确认成功。若 leader 在接收记录后,follower 复制数据完成前产生错误,则记录可能丢失acks = all:leader 节点会等待所有同...

聊聊 Kafka:Topic 创建流程与源码分析 | 社区征文

## 一、Topic 介绍Topic(主题)类似于文件系统中的文件夹,事件就是该文件夹中的文件。Kafka 中的主题总是多生产者和多订阅者:一个主题可以有零个、一个或多个向其写入事件的生产者,以及零个、一个或多个订阅这些事件的消费者。可以根据需要随时读取主题中的事件——与传统消息传递系统不同,事件在消费后不会被删除。相反,您可以通过每个主题的配置设置来定义 Kafka 应该保留您的事件多长时间,之后旧事件将被丢弃。Kafka 的性能在...

Kafka@记一次修复Kafka分区所在broker宕机故障引发当前分区不可用思考过程 | 社区征文

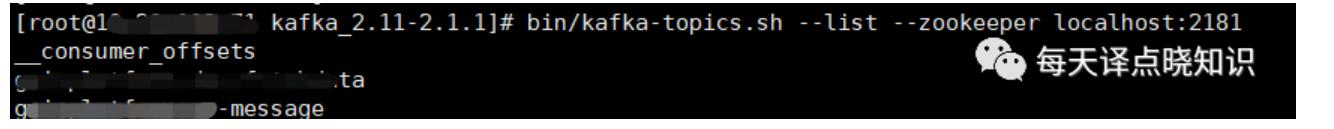

包括不限于改Kafka,主题创建删除,Zookeeper配置信息重启服务等等,于是我们来一起看看... Ok,Now,我们还是先来一步步分析它并解决它,依然以”化解“的方式进行,我们先来看看业务进程中线程报错信息:```jsor... kafka-topics.sh --list --zookeeper localhost:2181```然后,查询topic日志内...

特惠活动

特惠活动

apikafka日志配置-优选内容

apikafka日志配置-优选内容

apikafka日志配置-相关内容

apikafka日志配置-相关内容

API 概览

消息队列 Kafka版提供以下相关API 接口。 实例管理API 说明 ListKafkaConf 调用 ListKafkaConf 接口获取消息队列 Kafka版支持的相关配置。 CreateKafkaInstance 调用 CreateKafkaInstance 接口创建Kafka实例。 DeleteKafkaInstance 调用 DeleteKafkaInstance 接口删除Kafka实例。 DescribeInstanceDetail 调用 DescribeInstanceDetail 接口获取指定Kafka实例的详细信息。 DescribeInstancesSummary 调用 DescribeInstancesSumm...

从 Kafka 导入数据

并发子任务数量 日志服务会根据 Kafka Topic 数量,创建多个子任务进行并发导入。 Kafka Topic 数量超过 2,000 时,日志服务会创建 16 个子任务。 Kafka Topic 数量超过 1,000 时,日志服务会创建 8 个子任务。 Kafka Topic 数量超过 500 时,日志服务会创建 4 个子任务。 Kafka Topic 数量小于等于 500 时,日志服务会创建 2 个子任务。 数据导入配置数量 单个日志项目中,最多可创建 100 个不同类型的数据导入配置。 费用说明...

采集概述

云产品等各种数据源的日志数据采集场景。本文档介绍日志服务支持的采集方式及采集方案。 功能概述日志服务提供日志采集工具 LogCollector、多语言 SDK 等日志采集方式,兼容 Kafka 协议、OpenTelemetry 协议等多种开源协议框架,支持主机应用、K8s 集群、移动客户端、火山引擎云产品、其他云厂商等多种来源的日志类数据采集。您可以在控制台首页或指定日志主题的日志接入页面选择日志接入的方式,并通过简单的配置快速将日志数据接入...

Logstash 如何通过 Kafka 协议消费 TLS 日志

# **问题现象**如何通过修改 Logstash 配置文件,实现通过 Kafka 协议消费日志到其他业务系统。# 问题分析TLS 日志服务支持通过 Logstash 消费日志数据,您可以通过配置 Logstash 服务内置的 logstash-input-kafka 插件获取日志服务中的日志数据。# 解决方案## 1.安装 logstash1.1 [下载安装包](https://www.elastic.co/cn/downloads/logstash)。1.2 解压安装包到指定目录。1.3 查看logstash 版本```Java[root@lxb-jms ...

读取日志服务 TLS 数据写入云搜索服务 ESCloud

开通主题的 Kafka 协议消费、获取与 TLS 交互需要用到的连接地址。 登录日志服务控制台。 在顶部导航栏选择目标地域。 创建日志项目。在左侧导航栏中单击日志项目管理,然后单击创建日志项目。 在创建日志项目对话框,设置项目名称和描述语句,然后单击确定。 创建日志主题。在项目详情页面的日志主题区域,单击创建日志主题。 在创建日志主题对话框,设置主题名称、日志存储时长、日志分区数量等关键参数,然后单击确定。 配置 说明...

读取日志服务 TLS 数据写入云搜索服务 Cloud Search

Kafka 协议消费、获取与 TLS 交互需要用到的连接地址。 登录日志服务控制台。 在顶部导航栏选择目标地域。 创建日志项目。 在左侧导航栏中单击日志项目管理,然后单击创建日志项目。 在创建日志项目对话框,设置项目名称和描述语句,然后单击确定。 创建日志主题。 在项目详情页面的日志主题区域,单击创建日志主题。 在创建日志主题对话框,设置主题名称、日志存储时长、日志分区数量等关键参数,然后单击确定。 配置 说明 主题...

API 概览

资源检查API 说明 DescribeRegions 调用 DescribeRegions 接口查看 Region 列表。 DescribeAvailabilityZones 调用 DescribeAvailabilityZones 接口查看可用区列表。 实例管理API 说明 CreateInstance 调用 CreateInstance 创建消息队列 Kafka版实例。 ModifyInstanceParameters 调用 ModifyInstanceParameters 接口修改对应实例的参数配置。 ModifyInstanceAttributes 调用 ModifyInstanceAttributes 接口修改对应...

通过 ByteHouse 消费日志

背景信息日志服务支持通过 Kafka 协议消费指定日志主题中的日志数据,例如消费到 ByteHouse(云数仓版)中进行进一步的分析处理。在 ByteHouse 中创建 Kafka 数据导入任务之后,可以直接通过 Kafka 流式传输数据。数据导入任务将自动运行,持续读取日志主题中的日志数据,并将其写入到指定的数据库表中。消费日志时,支持仅消费其中的部分字段,并设置最大消息大小等配置。同时您可以随时停止数据导入任务以减少资源使用,并在任何必要的...

Kafka 消息传递详细研究及代码实现|社区征文

Kafka Documentation 中 *[Producer Configs](https://kafka.apache.org/documentation/#producerconfigs)* 里有相关配置说明:[**compression.type**](url)生产者生成的数据的压缩类型。通过使用压缩,可以节省... acks = 1:producer 等待 leader 将记录写入本地日志后,在所有 follower 节点反馈之前就先确认成功。若 leader 在接收记录后,follower 复制数据完成前产生错误,则记录可能丢失acks = all:leader 节点会等待所有同...