kafka如何查看接入数据

社区干货

社区干货

如何排查消费者无法连接到Kafka问题

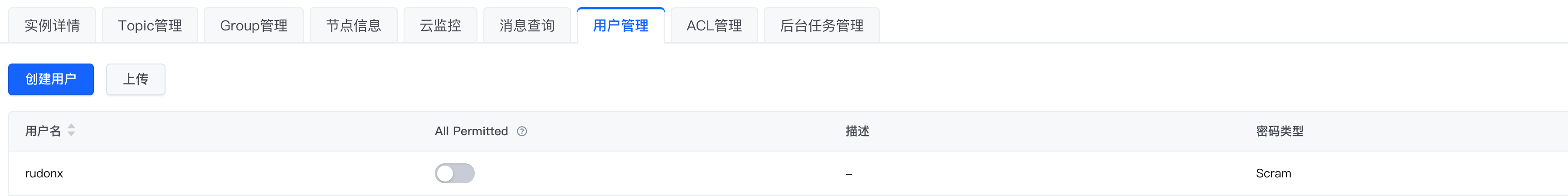

# 问题描述在开发和测试过程中,我们可能会遇到无法连接 Kafka 的情况,本文使用 kafka-console-consumer,来模拟几类常见的连接报错# 环境配置* 密码类型选择 Scram* 使用 SASL_SSL接入点,公网连接,客户端配置文件如下:```Plain Textsasl.jaas.config=org.apache.kafka.common.security.sc...

Logstash 如何通过 Kafka 协议消费 TLS 日志

# **问题现象**如何通过修改 Logstash 配置文件,实现通过 Kafka 协议消费日志到其他业务系统。# 问题分析TLS 日志服务支持通过 Logstash 消费日志数据,您可以通过配置 Logstash 服务内置的 logstash-input-kafka 插件获取日志服务中的日志数据。# 解决方案## 1.安装 logstash1.1 [下载安装包](https://www.elastic.co/cn/downloads/logstash)。1.2 解压安装包到指定目录。1.3 查看logstash 版本```Java[root@lxb-jms ...

观点 | 如何构建面向海量数据、高实时要求的企业级OLAP数据引擎?

数据库引擎百花齐放,为什么要大力投入ClickHouse?[点击查看](http://mp.weixin.qq.com/s?__biz=MzkwMzMwOTQwMg==&mid=2247496439&idx=1&sn=980a232e1edb18a5d343e009010bb326&chksm=c09a83c2f7ed0ad4580d435b8c21a... 意味着用户可以接入任意一个服务节点(当然如果有需要,也可以隔离开),并且可以水平扩展,意味着平台具备支持高并发查询的能力。* **元数据服务**元数据服务(Catalog Service)提供对查询相关元数据信息的读写。...

火山引擎DataLeap专家总结:3个必看的“数据血缘”建设经验!

元数据种类和数量也经历了非线性增长,并在此期间涌现出一些问题。 **第一,扩展性**。好的扩展性可以在面对新型元数据血缘时保证快速接入和迭代,而扩展性不佳则会导致在业务变化时需要不停地重构来适... 适合当前阶段的数据血缘方案。 **/ 数据血缘模型-展示层/**字节内部有很多种元数据类型,包括线上传统的离线数仓Hive、OLAP分析引擎ClickHouse,以及实时侧元数据,如Kafka和ES以及...

特惠活动

特惠活动

kafka如何查看接入数据-优选内容

kafka如何查看接入数据-优选内容

kafka如何查看接入数据-相关内容

kafka如何查看接入数据-相关内容

使用 SASL_SSL 接入点连接实例

并授予其读写数据的权限,在访问实例时可使用对应的 SASL 用户账密进行权限认证。 消息队列 Kafka版支持通过 SSL 证书对消息进行鉴权和加密,保障数据传输过程的安全性,防止数据在网络传输过程中被截取或者窃听,相较于普通访问方式具备更高的安全性。目前支持客户端对服务端证书的单向认证。 前提条件已获取 SASL_SSL 接入点信息,包括连接地址和端口号。详细信息请参考查看接入点。 已创建 Topic。操作步骤请参考创建 Topic。 如果...

使用 SASL_PLAINTEXT 接入点连接实例

默认情况下可以通过 VPC 内访问 Kafka 实例,开启公网访问功能之后,还可以通过公网访问实例。两种网络类型均可以通过 SASL_PLAINTEXT 接入点进行接入。如果公网环境下访问实例需要通过 SSL 认证,推荐选择 SASL_SSL 接入点,详细接入方式请参考使用 SASL_SSL 接入点连接实例。 前提条件已获取 SASL_PLAINTEXT 接入点信息,包括连接地址和端口号。详细信息请参考查看接入点。 已创建 Topic。操作步骤请参考创建Topic。 如果通过公网访...

实时数据接入

1. 概述 实时数据接入,是指支持通过对接实时数据源,将实时数据接入系统中。 注意 SaaS支持对接火山Kafka;私有化支持对接火山Kafka、开源火山Kafka和Pulsar 2. 操作说明 2.1 新建Kafka数据连接点击 数据融合 > 数... 添加数据连接,选择前序已创建的实时数据连接、选择接入的kafka topic。 添加IDM算子生成OneID 确认是否无法和匹配历史已有ID新增or删除实时转换:根据ID类型对应的ID类型字段数据,通过ID-Mapping服务实时查询到...

接入 Filebeat

version: "2.8.0" 替换为需要读取数据的实际 topic。 topics: ["topic-test"] 消费组名称,Kafka 服务端会自动创建消费组。 group_id: "group-test" fetch: min: 10240 output.file: 数据读取后写入的文件路径,替换为本地实际路径。 path: "{$filepath}/output" 数据读取后写入的文件名前缀。 filename: "kafka"参数 说明 hosts Kafka 实例的接入点地址,支持配置多个不同协议的接入点。如何查看实例接入点,请...

从 Kafka 导入数据

默认为从Kafka导入。 日志项目 用于存储 Kafka 数据的日志项目。 日志主题名称 用于存储 Kafka 数据的日志主题名称。 说明 不支持将数据导入到云产品日志、服务日志等日志的专属日志主题。 任务名称 日志导入任务的名称。 步骤二 导入配置填写导入配置。 配置 说明 服务地址 不同类型的 Kafka 集群对应的服务地址不同,详细说明如下: 火山引擎消息队列 Kafka 版:Kafka 实例的接入点,详细说明请参考查看接入点。如果 ...

Kafka Exporter 接入

托管 Prometheus 服务提供基于 exporter 的方式来监控 Kafka 运行状态,本文为您介绍如何在集群中部署 kafka-exporter,并实现对 Kafka 的监控。 前提条件已注册并开通火山引擎容器服务(VKE)。 已创建托管 Prometheus 工作区,详情请参见 创建工作区。 VKE 集群已接入托管 Prometheus,详情请参见 容器服务接入。 已在 VKE 集群中创建 PodMonitor CRD 资源,详情请参见 创建 PodMonitor CRD 资源。 已在 VKE 集群中部署 Grafana 并接入...

默认接入点收发消息

查看运行结果。运行结果示例如下。 说明 消息队列 Kafka版提供示例项目供您快速接入,下载并解压缩 Demo 后,可以直接执行以下命令发送并消费消息。 undefined go run -mod=vendor {DemoPath}/kafka.go```` 示例代... { case *kafka.Message: // 消费到数据后,对数据执行处理。此处处理时间不宜过长,过长会导致链接断开 handleMessage(msg) count++ } } if !config.Consumer.AutoCommit { ...

Kafka

1. 概述 Kafka Topic 数据能够支持产品实时数据分析场景,本篇将介绍如何进行 Kafka 数据模型配置。 温馨提示:Kafka 数据源仅支持私有化部署模式使用,如您使用的SaaS版本,若想要使用 Kafka 数据源,可与贵公司的客户成功经理沟通,提出需求。 2. 快速入门 下面介绍两种方式创建数据连接。 2.1 从数据连接新建(1)在数据准备模块中选择数据连接,点击新建数据连接。(2)点击 Kafka 进行连接。(3)填写连接的基本信息,点击测试连接,显示连...

Kafka 迁移上云(方案一)

并不会迁移 Kafka 旧集群上的消息数据。 创建Kafka实例、迁移消息收发链路之前,请先确定 Kafka 实例可正常访问,以免因访问异常造成迁移失败。您可以访问 Kafka 实例详情页中的接入点,确认实例的网络连通性。 业务迁... 由自建集群接入点改为消息队列 Kafka版的公网接入点。 检验新的 Kafka 实例业务是否正常运行。您可以根据业务自身的运行逻辑判断当前服务的健康度,确认火山引擎 Kafka 实例是否正常运行,也可以参考 查看迁移进度...