kafka安装必须使用zk

社区干货

社区干货

聊聊 Kafka:Topic 创建流程与源码分析 | 社区征文

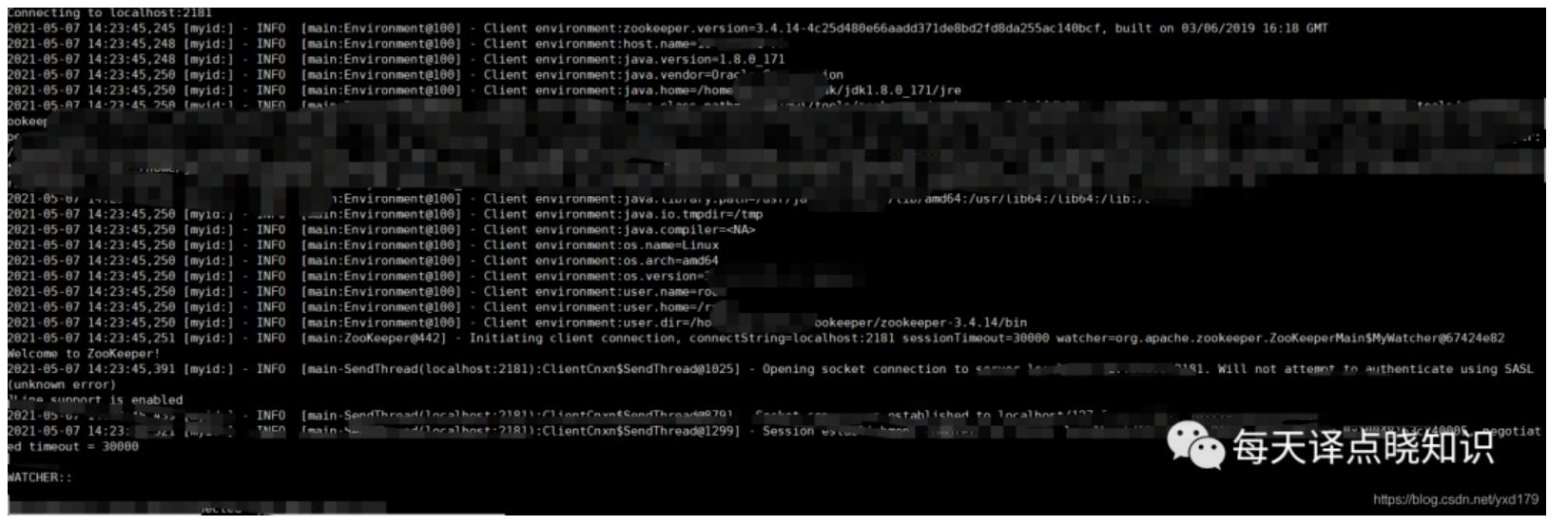

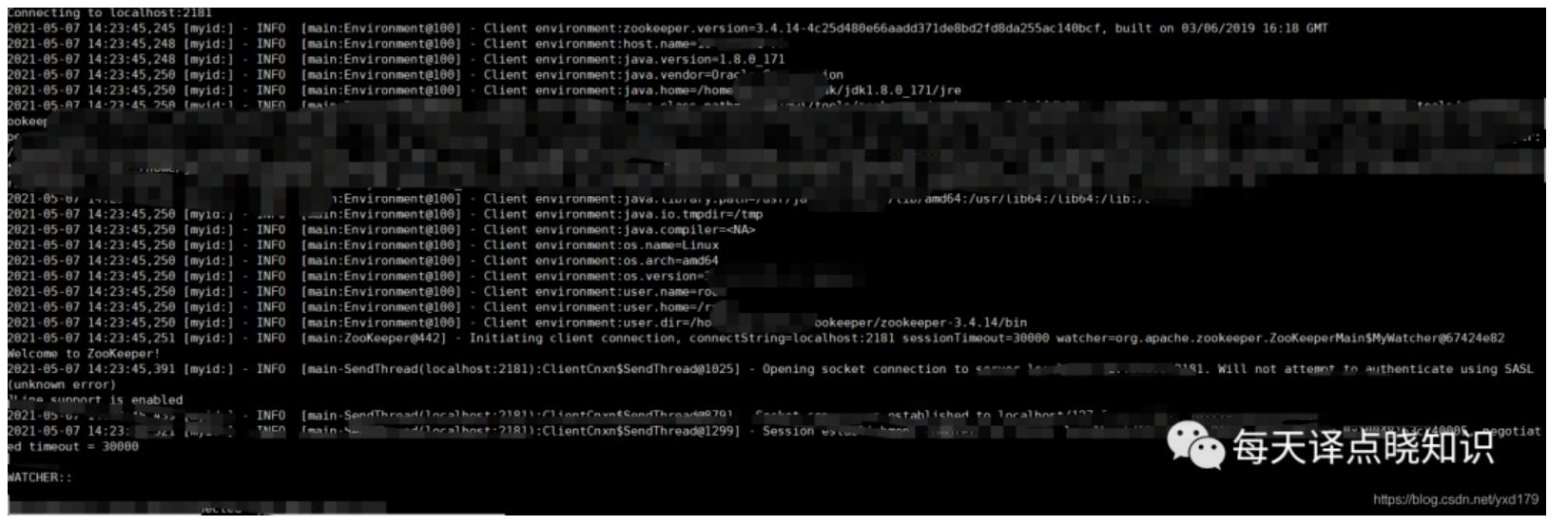

Kafka 中的主题总是多生产者和多订阅者:一个主题可以有零个、一个或多个向其写入事件的生产者,以及零个、一个或多个订阅这些事件的消费者。可以根据需要随时读取主题中的事件——与传统消息传递系统不同,事件在消费... /bin/kafka-topics.sh --create --zookeeper localhost:2181 --partitions 3 --replication-factor 3 --topic topic_test```注:-–zookeeper 后面接的是 kafka 的 zk 配置, 假如你配置的是 localhost:2181/kafk...

Kafka@记一次修复Kafka分区所在broker宕机故障引发当前分区不可用思考过程 | 社区征文

包括不限于改Kafka,主题创建删除,Zookeeper配置信息重启服务等等,于是我们来一起看看... Ok,Now,我们还是先来一步步分析它并解决它,依然以”化解“的方式进行,我们先来看看业务进程中线程报错信息:```jsor... /zkCli.sh -server localhost:2181 ```输入 ls /,查看到了Zookeeper中存储了...

Logstash 如何通过 Kafka 协议消费 TLS 日志

您可以通过配置 Logstash 服务内置的 logstash-input-kafka 插件获取日志服务中的日志数据。# 解决方案## 1.安装 logstash1.1 [下载安装包](https://www.elastic.co/cn/downloads/logstash)。1.2 解压安装包到指定目录。1.3 查看logstash 版本```Java[root@lxb-jms ~]# /usr/share/logstash/bin/logstash -Vlogstash 7.17.7```建议使用的 Logstash 版本为 7.12~8.8.1,如果其他版本需要根据实际情况调整适配。## 2....

字节跳动基于Apache Atlas的近实时消息同步能力优化 | 社区征文

文 | **洪剑**、**大滨** 来自字节跳动数据平台开发套件团队# 背景## 动机字节数据中台DataLeap的Data Catalog系统基于Apache Atlas搭建,其中Atlas通过Kafka获取外部系统的元数据变更消息。在开源版本中,每台... 业务侧只需要编写消息的处理逻辑;另外,将系统状态以Metric方式暴露 || 轻量 | 支持与后端服务混合部署,不引入额外的维护成本## 相关工作在启动自研之前,我们评估了两个比较相关的方案,分别是Flink和Ka...

特惠活动

特惠活动

kafka安装必须使用zk-优选内容

kafka安装必须使用zk-优选内容

kafka安装必须使用zk-相关内容

kafka安装必须使用zk-相关内容

配置 Kafka 数据源

2 使用限制子账号新建数据源时,需要有项目的管理员角色,方可以进行新建数据源操作。各角色对应权限说明,详见:管理成员。 Kafka 数据源目前支持可视化配置实时读取和离线写入 Kafka。 为确保同步任务使用的独享集... "parameter": { "hbase_conf":{ "hbase.zookeeper.quorum":"hb-cxxxxxx-zk.config.config.volces.com:2181", "hbase.zookeeper.property.clientPort":"2181", ...

使用 Kafka 协议上传日志

日志服务支持通过 Kafka 协议上传和消费日志数据,基于 Kafka 数据管道提供完整的数据上下行服务。使用 Kafka 协议上传日志功能,无需手动开启功能,无需在数据源侧安装数据采集工具,基于简单的配置即可实现 Kafka Pr... 限制说明支持的 Kafka 协议版本为 0.11.x~2.0.x。 支持压缩方式包括 gzip、snappy 和 lz4。 为保证日志传输的安全性,必须使用 SASL_SSL 连接协议。对应的用户名为日志服务项目 ID,密码为火山引擎账号密钥,详细信...

快速开始

本文介绍如何快速使用 Volcengine Java SDK 实现基础的 Kafka 实例资源管理流程,包括创建实例、创建 Topic等操作。 前提条件已安装 Volcengine Java SDK。更多信息,请参见安装 Java SDK。 已创建并获取火山引擎访问密钥 AccessKey。访问密钥 AccessKey 拥有所有 API 的全部权限。建议您通过 IAM 用户进行 API 相关操作和日常运维。使用 IAM 用户前,主账号需要为 IAM 用户授予消息队列 Kafka版相关资源和操作的权限。 示例代码 创...

快速开始

本文介绍如何快速使用 Volcengine Python SDK 实现基础的 Kafka 实例资源管理流程,包括创建实例、创建 Topic 等操作。 前提条件已安装 Volcengine Python SDK。更多信息,请参见安装 Python SDK。 已创建并获取火山引擎访问密钥 AccessKey。访问密钥 AccessKey 拥有所有 API 的全部权限。建议您通过 IAM 用户进行 API 相关操作和日常运维。使用 IAM 用户前,主账号需要为 IAM 用户授予消息队列 Kafka版相关资源和操作的权限。 示例...

快速开始

本文介绍如何快速使用 Volcengine Go SDK 实现基础的 Kafka 实例资源管理流程,包括创建实例、创建 Topic、查看实例等操作。 前提条件已安装 Volcengine Go SDK。更多信息,请参见安装 Go SDK。 已创建并获取火山引擎访问密钥 AccessKey。访问密钥 AccessKey 拥有所有 API 的全部权限。建议您通过 IAM 用户进行 API 相关操作和日常运维。使用 IAM 用户前,主账号需要为 IAM 用户授予消息队列 Kafka版相关资源和操作的权限。 示例代...

使用Logstash消费Kafka中的数据并写入到云搜索

请先点击链接创建VPC 消息队列 - Kafka 云搜索 云服务器ECS:Centos 7 在 ECS 主机上准备 Kafka 客户端的运行环境,提前安装好Java运行环境 在 ECS 主机上安装 Logstash 实验步骤 步骤一:准备 Logstash 配置文件Logstash 配置文件有如下格式: input{ 数据源}filter{ 处理方式}output{ 输出目标端}我们使用如下配置文件:在如下配置文件中的 input 部分,我们使用了 Kafka 的默认接入点地址,同时指定了需要消费的 Topi...

通过 Kafka 消费火山引擎 Proto 格式的订阅数据

介绍如何使用 Go、Java 和 Python 语言消费 Canal 格式的数据。 前提条件已注册火山引擎账号并完成实名认证。账号的创建方法和实名认证,请参见如何进行账号注册和实名认证。 已安装 protoc,建议使用 protoc 3.18 或以上版本。 说明 您可以执行 protoc -version 查看 protoc 版本。 用于订阅消费数据的客户端需要指定服务端 Kafka 版本号,版本号需为 2.2.x(例如 2.2.2)。您可以在示例代码中指定 Kafka 版本号,具体参数如下表所...

Kafka@记一次修复Kafka分区所在broker宕机故障引发当前分区不可用思考过程 | 社区征文

包括不限于改Kafka,主题创建删除,Zookeeper配置信息重启服务等等,于是我们来一起看看... Ok,Now,我们还是先来一步步分析它并解决它,依然以”化解“的方式进行,我们先来看看业务进程中线程报错信息:```jsor... /zkCli.sh -server localhost:2181 ```输入 ls /,查看到了Zookeeper中存储了...

如何使用Nginx代理访问VPC内的自建Kafka

1台做Kafka Server)受众: 通用 环境说明 如果还没有火山引擎账号,点击此链接注册账号 如果您还没有VPC,请先点击链接创建VPC 云服务器ECS:Centos 7 本地电脑准备python环境,默认生产和消费消息。 实验步骤 步骤1:部署配置Nginx代理1.下载安装nginx,确保编译过程中添加"--with-stream"模块,如果需要其他模块可以自行参考Nginx官网文档 undefined 下载Nginx源码包wget https://nginx.org/download/nginx-1.20.1.tar.gz解压源码包...