kafka读写顺序的一致性

社区干货

社区干货

Kafka 消息传递详细研究及代码实现|社区征文

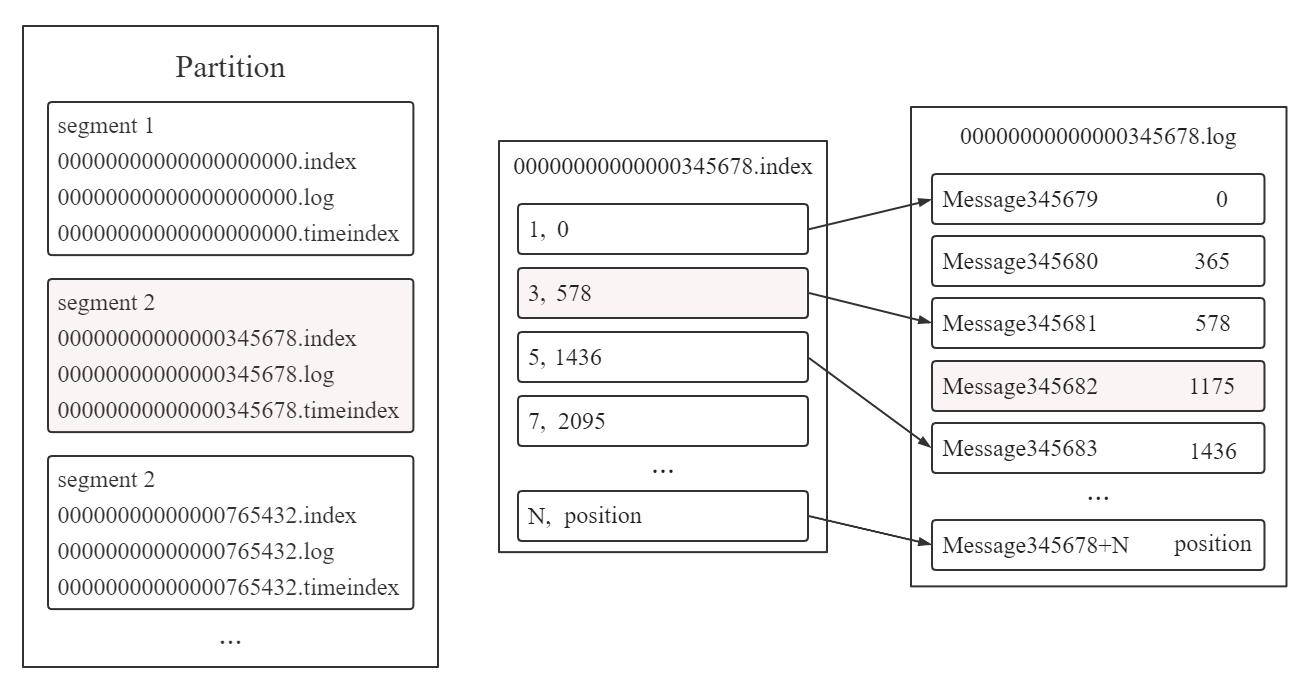

## 背景新项目涉及大数据方面。之前接触微服务较多,趁公司没反应过来,赶紧查漏补缺。Kafka 是其中之一。Apache Kafka 是一个开源的分布式事件流平台,可跨多台计算机读取、写入、存储和处理事件,并有发布和订阅事... 顺序为:(1) 利用二分法找到小于 345682 且离其最近的 segment 2 文件(2) 34...

消息队列选型之 Kafka vs RabbitMQ

在面对众多的消息队列时,我们往往会陷入选择的困境:“消息队列那么多,该怎么选啊?Kafka 和 RabbitMQ 比较好用,用哪个更好呢?”想必大家也曾有过类似的疑问。对此本文将在接下来的内容中以 Kafka 和 RabbitMQ 为例分... 具有强一致性、高吞吐、低延时及高可扩展性等流数据存储特性。目前市面上的消息中间件还有很多,比如腾讯系的 PhxQueue、CMQ、CKafka,又比如基于 Go 语言的 NSQ,有时人们也把类似 Redis 的产品也看做消息中间件...

字节跳动新一代云原生消息队列实践

它主要负责写入请求的处理,其余请求交给了 Proxy 和 Coordinator 处理。* Coordinator 与 Kafka 版本最大的差别在于我们将其从 Broker 中独立,作为单独的进程提供服务。这样的好处是读写流量与消费者协调的资源可... 因为只要存活的存储节点可以支持写入流量,新写入的数据就可以选择剩余健康的存储节点写入。对于已经存入的数据,两台存储节点宕机会导致同时存在这两台机器上的 Segment 无法读取,若这个 Segment 是最近写入的尚未被...

干货|字节跳动流式数据集成基于Flink Checkpoint两阶段提交的实践和优化(2)

> > > 字节跳动开发套件数据集成团队(DTS ,Data Transmission Service)在字节跳动内基于 Flink 实现了流批一体的数据集成服务。其中一个典型场景是 Kafka/ByteMQ/RocketMQ -> HDFS/Hive 。Kafka/ByteMQ/RocketMQ... [第一篇主要介绍Flink Checkpoint 以及 MQ dump 写入流程。](http://mp.weixin.qq.com/s?__biz=MzkwMzMwOTQwMg==&mid=2247490866&idx=1&sn=ff8e0bce2bce0eaea87cfafcaba4c6f6&chksm=c0996c07f7eee5114ded498b3c42b...

特惠活动

特惠活动

kafka读写顺序的一致性-优选内容

kafka读写顺序的一致性-优选内容

kafka读写顺序的一致性-相关内容

kafka读写顺序的一致性-相关内容

实例管理

消息队列 Kafka版提供多种实例规格供您选择,你可以根据业务的读写流量峰值、所需的存储空间大小和分区数量估算计算规格与存储规格。 读写流量:购买时选择网卡读流量峰值和网卡写流量峰值中的较大值进行评估。 建议... 消息队列 Kafka版通过参数自动删除旧消息提供磁盘容量阈值策略,在磁盘容量达到一定水位阈值后,消息队列 Kafka版会根据已设定的磁盘容量阈值策略,删除旧消息或暂停实例的数据写入,避免磁盘使用率达到 100% 而导致 K...

Kafka 迁移上云(方案一)

1.1 迁移评估根据现有业务量和消息量估算所需的消息队列 Kafka版资源,例如业务读写流量峰值、磁盘容量和分区数等。不同规格的 Kafka 实例代表不同的计算能力及存储空间,请根据业务量合理评估资源需求。 1.2 准备相... 下线自建 Kafka 集群的生产者,但维持旧的消费者。此时旧消费者仍在持续消费存量的旧消息,即同时有两个消费端在同时消费不同的消息。 先停止生产业务可以避免生产流量不断写入,导致消费业务一直在处理源源不断的新...

CreateSaslUser

调用 CreateSaslUser 接口创建 Kafka SASL 用户。 使用说明CreateSaslUser 接口用于在 Kafka 实例下创建一个 SASL 用户,该用户可以使用 SASL/SCRAM 机制发布和订阅消息。 此接口的 API Version 为 2018-01-01。 此... AllAuthority Bool 可选 true SASL 用户是否默认具备所有 Topic 的读写权限。默认为 true。 true:此用户具备所有 Topic 的读写权限。 false:此用户不具备所有 Topic 的读写权限。 响应参数null 示例请求示例...

读取日志服务 TLS 数据写入云搜索服务 ESCloud

您可以使用 Flink kafka 连接器连接日志服务,通过 Flink 任务将日志服务中采集的日志数据消费到下游的大数据组件或者数据仓库。本文通过 Flink SQL 任务,实现读取 TLS 主题中的日志数据,然后写入到 ESCloud 索引中... 每个分区提供的写入能力为 5 MiB/s、500 次/s,读取能力为 10 MiB/s、100 次/s。创建后暂不支持修改分区数量,但支持通过自动分裂功能提高日志主题的整体读写能力。 自动分裂日志分区 是否开启分区的自动分裂功能...

读取日志服务 TLS 数据写入云搜索服务 Cloud Search

您可以使用 Flink kafka 连接器连接日志服务,通过 Flink 任务将日志服务中采集的日志数据消费到下游的大数据组件或者数据仓库。本文通过 Flink SQL 任务,实现读取 TLS 主题中的日志数据,然后写入到 ESCloud 索引中... 每个分区提供的写入能力为 5 MiB/s、500 次/s,读取能力为 10 MiB/s、100 次/s。创建后暂不支持修改分区数量,但支持通过自动分裂功能提高日志主题的整体读写能力。 自动分裂日志分区 是否开启分区的自动分裂功能...

字节跳动新一代云原生消息队列实践

它主要负责写入请求的处理,其余请求交给了 Proxy 和 Coordinator 处理。* Coordinator 与 Kafka 版本最大的差别在于我们将其从 Broker 中独立,作为单独的进程提供服务。这样的好处是读写流量与消费者协调的资源可... 因为只要存活的存储节点可以支持写入流量,新写入的数据就可以选择剩余健康的存储节点写入。对于已经存入的数据,两台存储节点宕机会导致同时存在这两台机器上的 Segment 无法读取,若这个 Segment 是最近写入的尚未被...

ModifyUserAuthority

调用 ModifyUserAuthority 接口更改指定 SASL 用户对于所有用户的默认权限。 使用说明消息队列 Kafka版为 SASL 用户提供灵活的权限策略,支持 Topic 粒度的权限管控。您可以通过此接口指定 SASL 用户对于所有 Topic... kafka-cnngbnntswg1**** SASL 用户所属的实例 ID。 UserName String 是 my_user SASL 用户名称。 AllAuthority Boolean 是 true 指定用户是否具备所有 Topic 的读写权限。 true:此用户具备所有 Topic 的...

CreateTopic

请求参数参数 参数类型 是否必选 示例值 说明 InstanceId String 必选 kafka-****x 实例 ID。 TopicName String 必选 my_topic 待创建的 Topic 名称。必须符合以下命名规范: 长度为 3~64 个字符。 只能以英文或数字开头。 支持的字符包括英文字母、数字、连字符(-)、下划线(_)和英文句号(.)。 AllAuthority Bool 可选 true 待创建的 Topic 默认是否对所有用户都开启读写权限。 true:所有用户都具备此 Topic 的读写权限...

干货|字节跳动流式数据集成基于Flink Checkpoint两阶段提交的实践和优化(2)

> > > 字节跳动开发套件数据集成团队(DTS ,Data Transmission Service)在字节跳动内基于 Flink 实现了流批一体的数据集成服务。其中一个典型场景是 Kafka/ByteMQ/RocketMQ -> HDFS/Hive 。Kafka/ByteMQ/RocketMQ... [第一篇主要介绍Flink Checkpoint 以及 MQ dump 写入流程。](http://mp.weixin.qq.com/s?__biz=MzkwMzMwOTQwMg==&mid=2247490866&idx=1&sn=ff8e0bce2bce0eaea87cfafcaba4c6f6&chksm=c0996c07f7eee5114ded498b3c42b...