Kafkaoffset-外部存储VS消费者已提交(分区)

社区干货

社区干货

Kafka 消息传递详细研究及代码实现|社区征文

可以节省网络带宽和Kafka存储成本。type: stringdefault: nonevalid values: [none, gzip, snappy, lz4, zstd]importance: high [**retries**](url)生产者发送消息失败或出现潜在暂时性错误时,会进行的重试次数。type: intdefault: 2147483647valid values: [0, ..., 2147483647]importance: high [**batch.size**](url)当多条消息发送到一个分区时,producer 批量发送消息大小的上限 (以字节为单位)...

聊聊 Kafka:Topic 创建流程与源码分析 | 社区征文

因此长时间存储数据是完全没问题的。主题是**分区的**,这意味着一个主题分布在位于不同 Kafka 代理的多个“桶”上。数据的这种分布式放置对于可伸缩性非常重要,因为它允许客户端应用程序同时从/向多个代理读取和写入数据。当一个新事件发布到一个主题时,它实际上被附加到该主题的分区之一。具有相同事件键(例如,客户或车辆 ID)的事件被写入同一分区,并且 Kafka 保证给定主题分区的任何消费者将始终以与写入事件完全相同的顺序读...

Kafka@记一次修复Kafka分区所在broker宕机故障引发当前分区不可用思考过程 | 社区征文

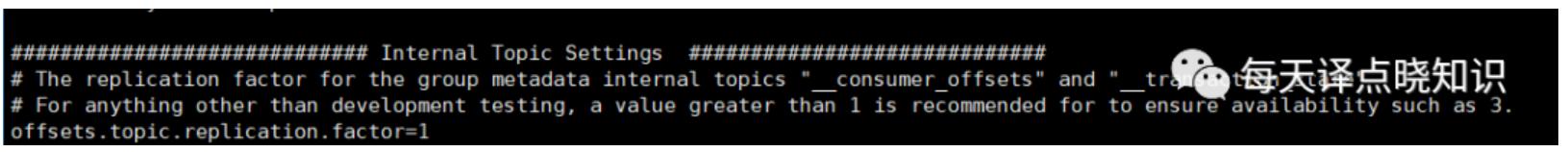

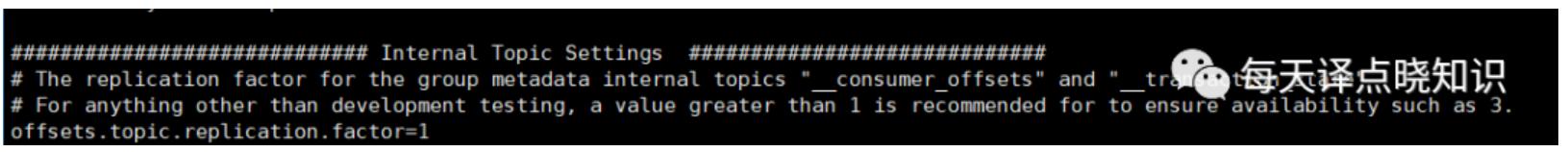

整个分区就不能正常使用-消费者端无法订阅到消息。 首先,我们来看下Kafka的配置信息:```js[root@xx-xx-xxx-xx kafka_2.11-2.1.1]# nohup bin/kafka-server-start.sh config/server.properties & ```这里使用了默认的topic分区副本数量:offsets.topic.replication.factor=1,当分区副本...

消息队列选型之 Kafka vs RabbitMQ

pkra8NfKc%3D)准确的说,消息队列是一种能实现生产者到消费者单向通信的通信模型,而一般大家说 MQ 是指实现了这个模型的中间件,比如 RabbitMQ、RocketMQ、Kafka 等。我们所要讨论的选型主要是针对消息中间件。... **主题和分区*** **主题(Topic)** :是一类消息的集合。* **分区(Partition)** :每个主题被分成多个分区,每个 Partition 在存储层面是 Append Log 文件。* **偏移量(Offset):** 消息在分区中的位置称为偏移量...

特惠活动

特惠活动

Kafkaoffset-外部存储VS消费者已提交(分区)

-优选内容

Kafkaoffset-外部存储VS消费者已提交(分区)

-优选内容

Kafkaoffset-外部存储VS消费者已提交(分区)

-相关内容

Kafkaoffset-外部存储VS消费者已提交(分区)

-相关内容

消息生产与消费

消息队列 Kafka版提供以下消息生产与消费相关的常见问题供您参考。 FAQ 列表Kafka 实例是否支持延迟消息? 如何查看正在消费消息的 IP 地址? 如何确定消息是否发送成功? Producer 建立的 Broker 连接数量是多少? Ka... 在消费者状态区域中,展开 Topic,其中消费者信息一列即为正在消费消息的客户端 IP 地址。当消费者信息为空时,说明当前无客户端正在消费该分区,或者消费者使用的是第三方的 Kafka 客户端。 如何确定消息是否发送成功...

Kafka@记一次修复Kafka分区所在broker宕机故障引发当前分区不可用思考过程 | 社区征文

整个分区就不能正常使用-消费者端无法订阅到消息。 首先,我们来看下Kafka的配置信息:```js[root@xx-xx-xxx-xx kafka_2.11-2.1.1]# nohup bin/kafka-server-start.sh config/server.properties & ```这里使用了默认的topic分区副本数量:offsets.topic.replication.factor=1,当分区副本...

Kafka/BMQ

请直接使用 kafka 连接器访问 Kafka 0.10 和 0.11 集群。Kafka-0.10 和 Kafka-0.11 两个版本的连接器使用的 Kafka 客户端有缺陷,在某些情况下可能无法自动提交 Kafka offset 信息。 使用 datastream API 开发的用户... 将不会动态发现分区。此时新增分区,将无法读取到新增分区中的数据。 format 是 (none) String 用来反序列化 Kafka 消息体(value)时使用的格式。支持的格式如下: csv json avro debezium-json canal-json raw...

Kafka 迁移上云(方案二)

1.1 迁移评估根据现有业务量和消息量估算所需的消息队列 Kafka版资源,例如业务读写流量峰值、磁盘容量和分区数等。不同规格的 Kafka 实例代表不同的计算能力及存储空间,请根据业务量合理评估资源需求。 1.2 准备相... 迁移步骤如下: 迁移生产端至消息队列 Kafka版实例。在旧集群停止生产端之后,在新集群中启动新的生产端业务。此时新集群中无消费端,所以产生的新消息暂时不会被消费。 在旧消息全部被旧消费者消费完毕后,下线旧消费...

Kafka 迁移上云(方案一)

1.1 迁移评估根据现有业务量和消息量估算所需的消息队列 Kafka版资源,例如业务读写流量峰值、磁盘容量和分区数等。不同规格的 Kafka 实例代表不同的计算能力及存储空间,请根据业务量合理评估资源需求。 1.2 准备相... 迁移步骤如下: 启动新的消费者和生产者。为新建的消息队列 Kafka版实例开启新的消费者和生产者,在云端搭建新的消息生产和消费流程,并启动消息的生产与消费。如果 Kafka 实例开启了公网访问,您可以直接修改生产端和...

Topic 和 Group 管理

消息队列 Kafka版提供以下 Topic 和 Group 管理相关的常见问题供您参考。 FAQ 列表支持多少个 Topic? 支持多少个分区? Topic 是否支持 ACL 权限配置? 如何管理 Group 的 offset? Group 不需要订阅 Topic 时,如何删... 如何管理 Group 的 offset?Broker 会如实记录 Consumer 客户端提交的消费位点信息。通常情况下,消费位点的提交机制取决于对接的 Kafka 客户端 SDK,SDK 通过以下两种机制指定消费位点: 自动提交消费位点:Kafka 客户...

重置消费位点

背景信息消息队列 Kafka版支持重置 Group、Topic 或分区级别的消费位点,支持的重置方式包括以下三种。 根据最新 offset 位点重置:跳过所有堆积消息,从最新位点开始消费。堆积的消息本身并不会因此被删除。 根据时... Group 在当前分区中将指定位点开始消费。 前提条件消息队列 Kafka版不支持在线重置消费位点,在重置消费位点之前,必须停止 Consumer Group 中的所有消费者客户端,确保 Group 的状态为 Empty。 停止消费者客户端后,...

消息顺序性与可靠性

使用消息队列 Kafka版收发消息时,往往需要关注消息的顺序性与可靠性,本文档介绍实现消息顺序性、保证消息可靠性的推荐方式。 消息顺序性Kafka 的消息在单个分区中可以保证数据的先入先出,即写入同一分区的消息,若消... Kafka 服务端配置火山引擎消息队列 Kafka版支持通过以下参数提升数据存储的可靠性。 配置 说明 Topic 副本数 写入该 Topic 中的消息所保存的副本数。支持 2 副本和 3 副本,3 副本可靠性更高,但是会占用更多额外...

消息队列选型之 Kafka vs RabbitMQ

pkra8NfKc%3D)准确的说,消息队列是一种能实现生产者到消费者单向通信的通信模型,而一般大家说 MQ 是指实现了这个模型的中间件,比如 RabbitMQ、RocketMQ、Kafka 等。我们所要讨论的选型主要是针对消息中间件。... **主题和分区*** **主题(Topic)** :是一类消息的集合。* **分区(Partition)** :每个主题被分成多个分区,每个 Partition 在存储层面是 Append Log 文件。* **偏移量(Offset):** 消息在分区中的位置称为偏移量...