Kafka分区中是否能够分割.gz文件?

社区干货

社区干货

Kafka 消息传递详细研究及代码实现|社区征文

可以节省网络带宽和Kafka存储成本。type: stringdefault: nonevalid values: [none, gzip, snappy, lz4, zstd]importance: high [**retries**](url)生产者发送消息失败或出现潜在暂时性错误时,会进行的重试次数。type: intdefault: 2147483647valid values: [0, ..., 2147483647]importance: high [**batch.size**](url)当多条消息发送到一个分区时,producer 批量发送消息大小的上限 (以字节为单位)...

聊聊 Kafka:Topic 创建流程与源码分析 | 社区征文

## 一、Topic 介绍Topic(主题)类似于文件系统中的文件夹,事件就是该文件夹中的文件。Kafka 中的主题总是多生产者和多订阅者:一个主题可以有零个、一个或多个向其写入事件的生产者,以及零个、一个或多个订阅这些事... 您可以通过每个主题的配置设置来定义 Kafka 应该保留您的事件多长时间,之后旧事件将被丢弃。Kafka 的性能在数据大小方面实际上是恒定的,因此长时间存储数据是完全没问题的。主题是**分区的**,这意味着一个主题分...

Kafka@记一次修复Kafka分区所在broker宕机故障引发当前分区不可用思考过程 | 社区征文

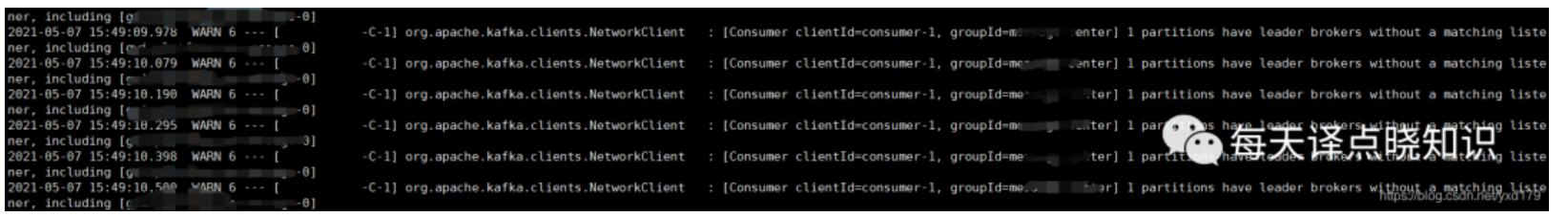

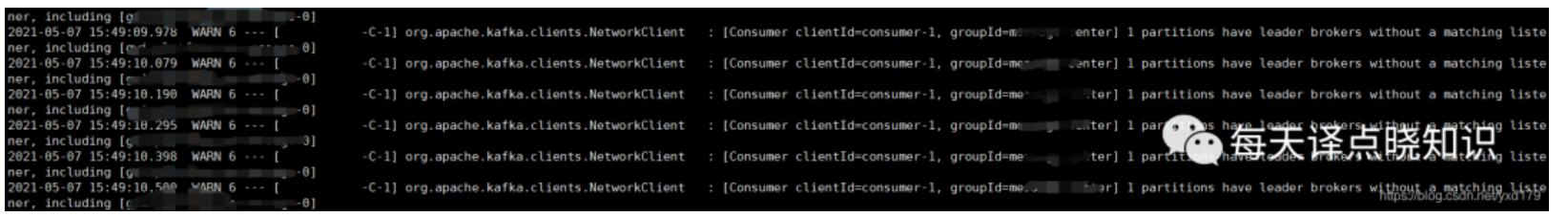

中线程报错信息:```jsorg.apache.kafka.clients.NetworkClient : [Consumer clientId=consumer-1, groupId=xxxx-center] 1 partitions have leader brokers without a matching listener, including [xxxx-xxxx-xxxx-message-0]```## 假设猜想从字面意思来看,当前分区所对应的的broke...

消息队列选型之 Kafka vs RabbitMQ

在面对众多的消息队列时,我们往往会陷入选择的困境:“消息队列那么多,该怎么选啊?Kafka 和 RabbitMQ 比较好用,用哪个更好呢?”想必大家也曾有过类似的疑问。对此本文将在接下来的内容中以 Kafka 和 RabbitMQ 为例分... **主题和分区*** **主题(Topic)** :是一类消息的集合。* **分区(Partition)** :每个主题被分成多个分区,每个 Partition 在存储层面是 Append Log 文件。* **偏移量(Offset):** 消息在分区中的位置称为偏移量...

特惠活动

特惠活动

Kafka分区中是否能够分割.gz文件?

-优选内容

Kafka分区中是否能够分割.gz文件?

-优选内容

Kafka分区中是否能够分割.gz文件?

-相关内容

Kafka分区中是否能够分割.gz文件?

-相关内容

消息顺序性与可靠性

使用消息队列 Kafka版收发消息时,往往需要关注消息的顺序性与可靠性,本文档介绍实现消息顺序性、保证消息可靠性的推荐方式。 消息顺序性Kafka 的消息在单个分区中可以保证数据的先入先出,即写入同一分区的消息,若消息 A 先于消息 B 写入,那么在进行消息读取时,消息 A 也一定可以先于消息 B 被客户端读取。但 Kafka 消息的分区顺序性仅保证通过同一生产者先后发送的消息是有序的,不同生产者发送的消息无法确认到达服务端的先后顺序...

Kafka@记一次修复Kafka分区所在broker宕机故障引发当前分区不可用思考过程 | 社区征文

中线程报错信息:```jsorg.apache.kafka.clients.NetworkClient : [Consumer clientId=consumer-1, groupId=xxxx-center] 1 partitions have leader brokers without a matching listener, including [xxxx-xxxx-xxxx-message-0]```## 假设猜想从字面意思来看,当前分区所对应的的broke...

实例管理

消息队列 Kafka版提供多种实例规格供您选择,你可以根据业务的读写流量峰值、所需的存储空间大小和分区数量估算计算规格与存储规格。 读写流量:购买时选择网卡读流量峰值和网卡写流量峰值中的较大值进行评估。 建议... 开启方式 Producer 的配置文件中设置参数 compression.type,该参数默认为 none,表示关闭压缩。您可以设置为 snappy,表示 snappy 开启压缩格式。 说明 消息压缩场景会额外消耗 CPU,建议在日志采集等压缩场景使用...

创建并连接到 Kafka 集群

前言 Kafka是是一个分布式、支持分区的(partition)、多副本的(replica) 分布式消息系统, 深受开发人员的青睐。在本教程中,您将学习如何创建 Kafka 集群,并使用客户端连接,生产数据并消费数据。 关于实验 预计部署时... 请根据您的业务选择 步骤3:安装原生客户端连接Kafka下载Kafka 工具包。 进行解压。 进入到解压完的目录中。 undefined wget https://archive.apache.org/dist/kafka/2.2.0/kafka_2.11-2.2.0.tgztar zxvf kafka_...

Kafka 消费者最佳实践

本文档以 Confluent 官方 Java 版本客户端 SDK 为例,介绍使用火山引擎 Kafka 实例时的消费者最佳实践。 广播与单播在同一个消费组内部,每个消息都预期仅仅只被消费组内的某个消费者消费一次,因而使用同一个消费组的... 包括每个消费者需要消费的分区分配、消费者加入或退出的重均衡等。 自由分配(Assign):完全由业务自己指定消费者需要消费的分区信息,不同消费者之间的消费协调等都需要业务自己实现。 推荐直接使用订阅(Subscribe)的...

使用Logstash消费Kafka中的数据并写入到云搜索

前言 Kafka 是一个分布式、支持分区的(partition)、多副本的(replica) 分布式消息系统, 深受开发人员的青睐。 云搜索服务是火山引擎提供的完全托管的在线分布式搜索服务,兼容 Elasticsearch、Kibana 等软件及常用开源插件,为您提供结构化、非结构化文本的多条件检索、统计、报表 在本教程中,您将学习如何使用 Logstash 消费 Kafka 中的数据,并写入到云搜索服务中。 关于实验 预计部署时间:20分钟级别:初级相关产品:消息队列 - Ka...

Upsert Kafka

其中每条数据记录代表一个更新或删除事件。数据记录中有 key,表示 UPDATE;数据记录中没有 key,表示 INSERT;数据记录中 key 的 value 为空,表示 DELETE。 作为结果表时,Upsert Kafka 连接器可以消费上游计算逻辑产生的 changelog 流。它会将 INSERT 或 UPDATE_AFTER 数据作为正常的 Kafka 消息写入,并将 DELETE 数据以 value 为空的 Kafka 消息写入,表示对应 key 的消息被删除。Flink将根据主键列的值对数据进行分区,从而保证主键...

消息生产与消费

如何确定消息是否发送成功? Producer 建立的 Broker 连接数量是多少? Kafka 实例是否支持延迟消息?火山引擎消息队列 Kafka版暂不支持延迟消息。 如何查看正在消费消息的 IP 地址?您可以参考以下步骤查看消费中的客... 在消费者状态区域中,展开 Topic,其中消费者信息一列即为正在消费消息的客户端 IP 地址。当消费者信息为空时,说明当前无客户端正在消费该分区,或者消费者使用的是第三方的 Kafka 客户端。 如何确定消息是否发送成功...

Kafka 迁移上云(方案二)

请先确定 Kafka 实例可正常访问,以免因访问异常造成迁移失败。您可以访问 Kafka 实例详情页中的接入点,确认实例的网络连通性。 业务迁移之前,请确认您已根据业务需求选择了正确的迁移方案。迁移方案对比请参考概述。 1 环境准备迁移之前,您需要根据业务量合理评估资源需求,并创建 Kafka 实例及相关的依赖资源。 1.1 迁移评估根据现有业务量和消息量估算所需的消息队列 Kafka版资源,例如业务读写流量峰值、磁盘容量和分区数等。不...