gpu集群如何配置cuda

社区干货

社区干货

GPU在Kubernetes中的使用与管理 | 社区征文

Kubernetes尚未实现像管理CPU那样来管理GPU,比如有如下限制:- 对于GPU资源只能设置`limit`,这意味着`requests`不可以单独使用,要么只设置`limit`、要么同时设置二者,但二者值必须相等,不可以只设置`request`而... 它使用我们刚说到的`扩展资源`资源字段来传递GPU信息,下面是官方给出的声明使用nvidia硬件的示例:```apiVersion: v1kind: Podmetadata: name: cuda-vector-addspec: restartPolicy: OnFailure contai...

GPU推理服务性能优化之路

比如CPU与GPU分离,TensorRT开启半精度优化,同模型混合部署,GPU数据传输与推理并行等。下面从理论,框架与工具,实战优化技巧三个方面介绍下推理服务性能优化的方法。# 二、理论篇## 2.1 CUDA架构4. 编辑后的配置文件如图...

如何对 Linux 操作系统的 GPU 实例进行压测?

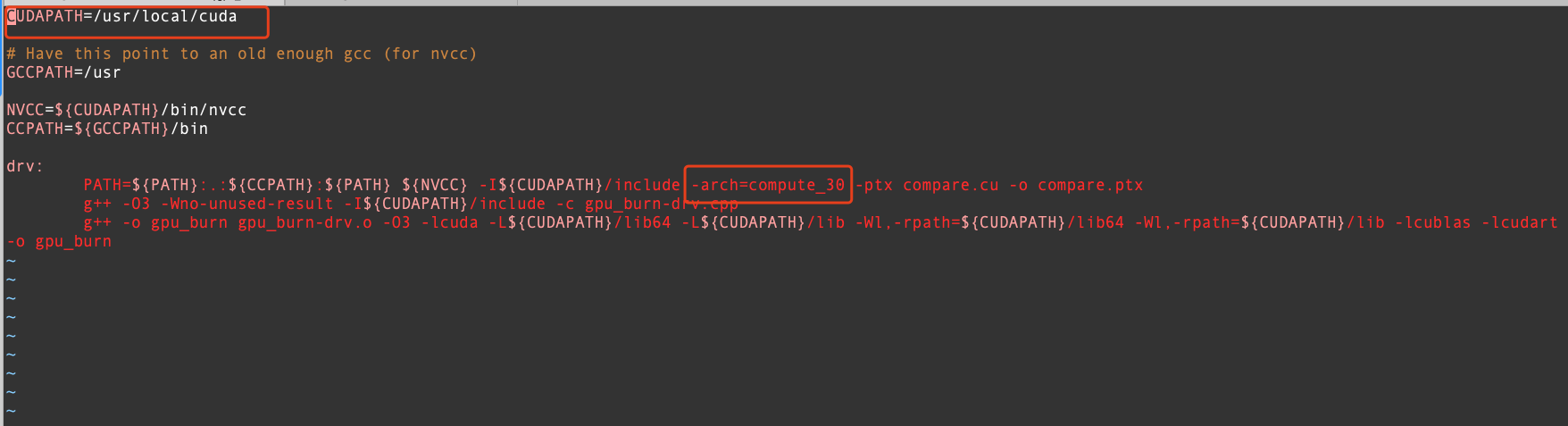

# 问题描述Linux 操作系统的 GPU 实例如何进行压力测试以及性能测试?# 问题分析GPU_BURN 是一款开源的软件,可以对 GPU 进行压力测试。GPU 性能测试使用 CUDA sample 自带的 deviceQuery、bandwith 稳定性测试以... cuda`这里更改为自己安装 cuda 的位置即可,删除`-arch=compute_30`。 4. 编辑后的配置文件...

特惠活动

特惠活动

gpu集群如何配置cuda-优选内容

gpu集群如何配置cuda-优选内容

gpu集群如何配置cuda-相关内容

gpu集群如何配置cuda-相关内容

GPU服务器使用

本文将介绍如何创建并使用GPU云服务器。 前言GPU云服务器(GPU Compute service)是提供 GPU 算力的弹性计算服务,拥有超强的计算能力,能高效服务于机器学习、科学计算、图形处理、视频编解码等多种场景,本文将介绍如... “GPU计算型” ---> 选择“GUP实例规格” ---> 选择“镜像及其版本” ---> 点击“确定”。 选择“私有网络” ---> 选择“分配弹性公网IP”,根据实际需求选择计费类型以及带宽大小,点击“下一步:高级配置”。 选择“...

新功能发布记录

2024年04月12日序号 功能描述 发布地域 阶段 文档 1 创建GPU云服务器时,支持后台自动安装更高版本的GPU驱动、CUDA和CUDNN库。 全部 商用 驱动安装指引 2023年11月24日序号 功能描述 发布地域 阶段 文档 1 邀测上线GPU计算型gni3实例。 华东2(上海) 邀测 GPU计算型gni3 2023年09月08日序号 功能描述 发布地域 阶段 文档 1 部署了HPC GPU实例的高性能计算集群最多支持绑定5个vePFS文件系统。 华北2(北京) 邀测 管理vePFS存储资源 2...

GPU-部署Pytorch应用

不仅能够实现强大的GPU加速,同时还支持动态神经网络。 软件版本操作系统:本文以Ubuntu 18.04为例。 NVIDIA驱动:GPU驱动:用来驱动NVIDIA GPU卡的程序。本文以470.57.02为例。 CUDA工具包:使GPU能够解决复杂计算问题... 执行source ~/.bashrc命令使配置文件生效。回显如下,表示配置成功,进入base环境。 创建虚拟环境,指定python版本。 执行conda create -n cuda11.4 python=3.8.3命令。其中,cuda11.4表示虚拟环境名称,您可以按需更...

GPU-部署NGC环境

NVIDIA驱动:GPU驱动:用来驱动NVIDIA GPU卡的程序。本文以470.57.02为例。 CUDA:使GPU能够解决复杂计算问题的计算平台。本文以CUDA 11.4为例。 CUDNN:深度神经网络库,用于实现高性能GPU加速。本文以8.2.4.15为例。... 查看GPU驱动。nvidia-smi回显如下,表示已安装成功。 执行以下命令,查看CUDA驱动。/usr/local/cuda/bin/nvcc -V回显如下,表示已安装成功。 步骤二:安装nvidia-docker依次执行以下命令,设置Docker-CE。 curl https:/...

GPU在Kubernetes中的使用与管理 | 社区征文

Kubernetes尚未实现像管理CPU那样来管理GPU,比如有如下限制:- 对于GPU资源只能设置`limit`,这意味着`requests`不可以单独使用,要么只设置`limit`、要么同时设置二者,但二者值必须相等,不可以只设置`request`而... 它使用我们刚说到的`扩展资源`资源字段来传递GPU信息,下面是官方给出的声明使用nvidia硬件的示例:```apiVersion: v1kind: Podmetadata: name: cuda-vector-addspec: restartPolicy: OnFailure contai...

自定义 GPU 驱动安装说明

(例如:将 CUDA 打包容器镜像,需要提供符合该环境的 OS)。 前提条件已经开通容器服务并创建容器集群。详细介绍参见:创建集群。 已经开通对象存储服务并创建存储桶,用于上传 GPU 驱动文件和其他 GPU 依赖文件。详细... 确保容器集群与 TOS 的网络互通,推荐开启公网访问以保证网络互通。 若需要使用自动化安装 GPU 驱动功能,节点配置需要注意以下情况: 系统镜像:目前仅支持公共镜像中的 veLinux 标准版。 计算规格:目前仅支持使用...

GPU-基于Diffusers和Gradio搭建SDXL推理应用

软件要求GPU驱动:用来驱动NVIDIA GPU卡的程序。本文以470.57.02为例。 Pytorch:开源的Python机器学习库,实现强大的GPU加速的同时还支持动态神经网络。本文以2.0.0为例。Pytorch使用CUDA进行GPU加速时,在GPU驱动已... 参考本地数据上传到GPU实例中。 操作步骤步骤一:创建实例请参考通过向导购买实例创建一台符合以下条件的实例: 基础配置:计算规格:ecs.g1ve.2xlarge 镜像:Ubuntu 20.04,并勾选“后台自动安装GPU驱动”。 存储:云盘容...

GPU-部署基于DeepSpeed-Chat的行业大模型

参考本地数据上传到GPU实例中。 步骤一:准备环境创建GPU计算型实例请参考通过向导购买实例创建一台符合以下条件的实例: 基础配置:计算规格:ecs.pni2.3xlarge 镜像:Ubuntu 20.04 with GPU Driver。该镜像已默认安装Tesla 470.129.06版本的GPU驱动,适配的CUDA版本为11.4,需自行安装。 存储:云盘容量在100 GiB以上。 网络配置:勾选“分配弹性公网IP”。 创建成功后,在实例绑定的安全组中添加入方向规则:放行TCP 6006端口。具体操...

安装GPU驱动

选择支持自动安装或者预装了特定版本GPU驱动和CUDA的公共镜像,详情请参见NVIDIA驱动安装指引。 搭载A100/A800显卡的实例还需安装NVIDIA-Fabric Manager服务,否则将无法正常使用GPU实例。 前提条件您已购买GPU实例,并为其绑定公网IP,使其具备访问公网的能力。 安装GPU驱动(Linux)Linux操作系统的驱动安装采用Shell脚本安装方式,适用于任何Linux发行版,包括CentOS、Ubuntu等。 登录NVIDIA 驱动下载 。 设置搜索条件,单击“搜索”...