最新cuda支持列表

社区干货

社区干货

GPU在Kubernetes中的使用与管理 | 社区征文

Kubernetes要想挨个支持是不现实的,所以Kubernetes就把这些硬件加速设备统一当做`扩展资源`来处理。Kubernetes在Pod的API对象里并没有提供像CPU那样的资源类型,它使用我们刚说到的`扩展资源`资源字段来传递GPU信息,下面是官方给出的声明使用nvidia硬件的示例:```apiVersion: v1kind: Podmetadata: name: cuda-vector-addspec: restartPolicy: OnFailure containers: - name: cuda-vector-add # https:...

2022技术盘点之平台云原生架构演进之道|社区征文

支持业务更好的发展。### 1.2 平台简介[SmartOps](https://smartops.anchnet.com/)多云管理平台解决异构的基础设施资源复杂难管理问题。平台可纳管不同环境、不同云厂商资源统一管理,并结合平台的统一监控告警... 进行最新资源的部署。利用基于 Kubernetes 的声明式 Gitops 持续部署工具Drone CI + Argo CD,可以应用定义...

AI ASIC 的基准测试、优化和生态系统协作的整合|KubeCon China

而且支持相应的维度越界检查。除了 -1 轴之外,其他维度支持任意 stride 访存,此外,GEMM、TPC、DMA 的指令序列是独立的,pipeline 运行时是 latency 会被隐藏起来。此外,TPC 也添加了 AI 负载常见的激活函数,作为... 而各家 ASIC 由于具备类似 CUDA 的开发生态,往往都需要单独适配,且各家 ASIC 往往都会自带一套自身的软件栈,从使用方式,硬件管理,监控接入等层面,都需要额外开发。这些相比沿用 GPU,都是额外成本。...

「跨越障碍,迈向新的征程」盘点一下2022年度我们开发团队对于云原生的技术体系的变革|社区征文

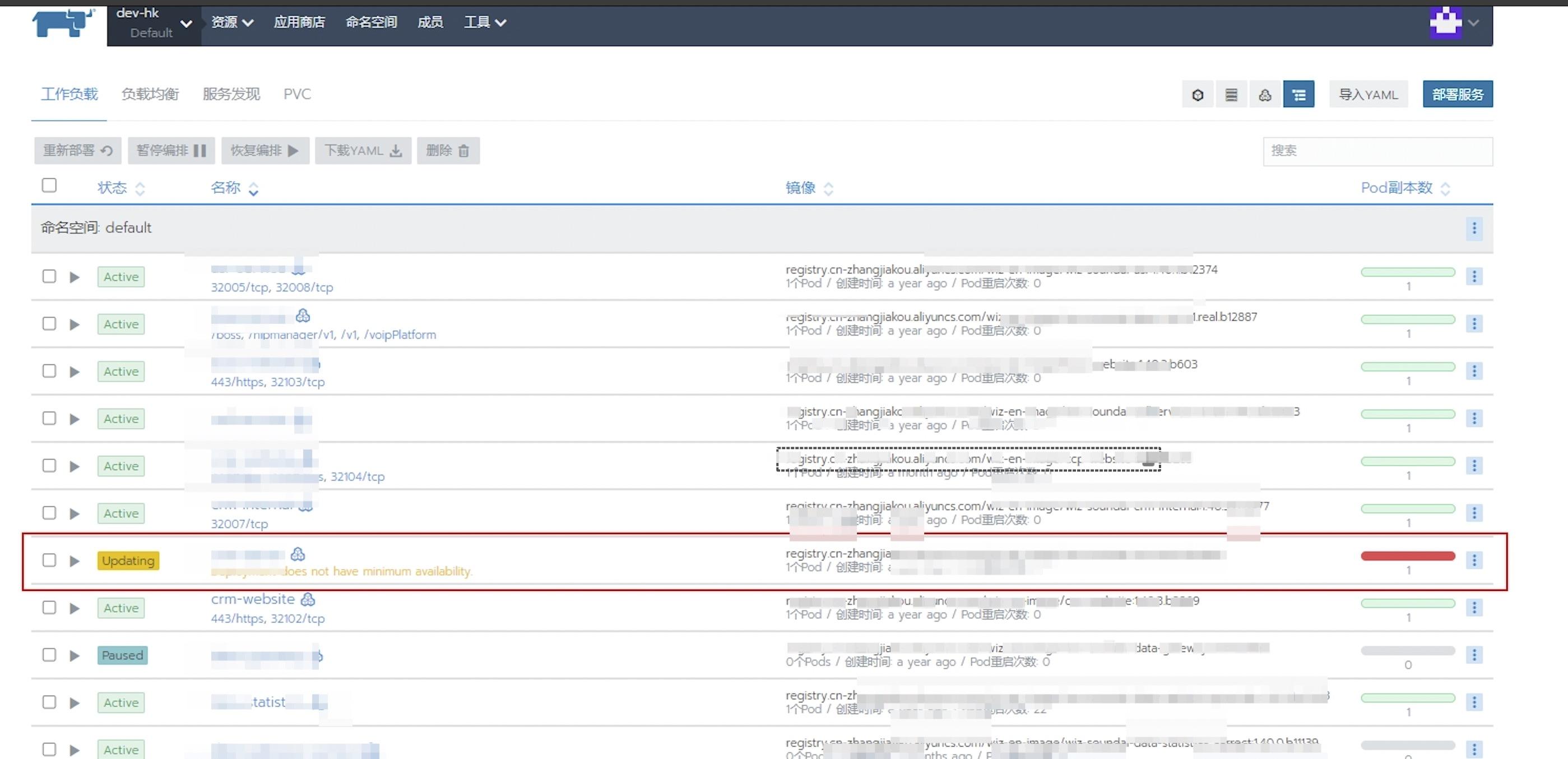

(最新)在升级到高版本K8s集群版本之前,我们使用的都是Rancher管理工具,如下图所示。##### Kuboard(最终选择)kuboard是一款专为 Kubernetes 设计的免费管理界面,兼容 Ku...

特惠活动

特惠活动

最新cuda支持列表-优选内容

最新cuda支持列表-优选内容

最新cuda支持列表-相关内容

最新cuda支持列表-相关内容

OpenAPI 调用说明

本文档不再维护且将与近期下线,查看最新账单OpenAPI调用说明文档请点击跳转至费用中心-API调用说明。本文介绍了调用火山引擎费用中心 - 账单管理 OpenAPI 的调用方法,对于具体 OpenAPI 接口的介绍,请参考 OpenAPI 接口列表。 一、前提条件 当前我们提供了通过 http 请求直接调用和通过火山引擎 SDK 调用两种方式来使用我们提供的服务,这两种方式都需要事先进行以下操作: 通过控制台注册账号,获取对应的 AccessKey ID 和 AccessKe...

新功能发布记录

本文为您介绍容器服务相关功能的最新动态。新特性将在各个地域陆续发布,欢迎体验。 说明 发布地域 用于记录该功能首次发布时开放的地域。新增支持地域时,历史功能的地域信息不做修改,其当前实际支持的地域以控制台... 2024-05-14 组件页面支持快捷查看组件底层资源状态 安装组件后,支持一键查看组件对应的底层资源对象列表,便于用户了解组件及其对应的资源对象列表之间的关系与运行状态。 华北 2 (北京) 2024-05-13 安装组件 华南...

HPC裸金属-基于NCCL的单机/多机RDMA网络性能测试

支持安装在单个节点或多个节点的大量GPU卡上,实现多个GPU的快速通信。 关键组件本文所述操作需要安装的软件包介绍如下。 关键组件 说明 NVIDIA驱动 GPU驱动:用来驱动NVIDIA GPU卡的程序。 CUDA工具包:使GPU能够... 单击目标集群进入“实例列表”页签查看集群绑定的实例。 配置多机间免密登录。 在A实例(Sever端)中依次执行以下命令,创建密钥对并开启读写权限。 ssh-keygen -t rsa -N "" -f ~/.ssh/id_rsachmod 600 ~/.ssh/id_rs...

GPU-基于Diffusers和Gradio搭建SDXL推理应用

本文以搭载了一张V100显卡的ecs.g1ve.2xlarge实例,介绍如何在GPU云服务器上基于Diffusers搭建SDXL 1.0的base + refiner组合模型。 背景信息SDXL Stable Diffusion XL(简称SDXL)是最新的图像生成模型,与之前的SD模型... 实现强大的GPU加速的同时还支持动态神经网络。本文以2.0.0为例。Pytorch使用CUDA进行GPU加速时,在GPU驱动已经安装的情况下,依然不能使用,很可能是版本不匹配的问题,请严格关注虚拟环境中CUDA与Pytorch的版本匹配情...

GPU在Kubernetes中的使用与管理 | 社区征文

Kubernetes要想挨个支持是不现实的,所以Kubernetes就把这些硬件加速设备统一当做`扩展资源`来处理。Kubernetes在Pod的API对象里并没有提供像CPU那样的资源类型,它使用我们刚说到的`扩展资源`资源字段来传递GPU信息,下面是官方给出的声明使用nvidia硬件的示例:```apiVersion: v1kind: Podmetadata: name: cuda-vector-addspec: restartPolicy: OnFailure containers: - name: cuda-vector-add # https:...

GPU-部署NGC环境

CUDA:使GPU能够解决复杂计算问题的计算平台。本文以CUDA 11.4为例。 CUDNN:深度神经网络库,用于实现高性能GPU加速。本文以8.2.4.15为例。 TensorFlow:深度学习框架。 前提条件您已购买Linux实例,并勾选“后台自动... 即可自动复制最新版本TensorFlow的镜像地址。 依次执行以下命令,拉取镜像并查看下载的镜像文件。 docker pull nvcr.io/nvidia/clara-agx/agx-tensorflow:21.05-tf1-py3 //链接请替换为上一步中复制的TensorFlow镜...

安装GPU驱动

参考本文和安装CUDA工具包手动安装Tesla驱动。 说明 为方便使用,您可以在创建GPU实例时,选择支持自动安装或者预装了特定版本GPU驱动和CUDA的公共镜像,详情请参见NVIDIA驱动安装指引。 搭载A100/A800显卡的实例还需... Linux 64-bit CUDA Toolkit 选择CUDA Toolkit版本。 12.2 语言 选择驱动对应的语言。 Chinese (Simplified) 最新 默认项为 全部,保持默认选项即可。 全部 选择特定的版本进入下载页面,单击“下载”按钮。本文...

编辑连接终端

主节点终端、默认终端和自定义终端均支持编辑,本文介绍编辑连接终端的操作步骤。 背景信息不同类型的终端支持修改的项目不同,详情请参见下表。 终端类型 主节点终端 默认终端 自定义读写终端 自定义只读终端 设置公... 在实例列表页面,单击目标实例名称,进入实例信息页。 在实例信息页,单击连接管理页签。 在连接管理页签中,单击目标终端区域中的编辑。 在编辑连接终端页面,可以对终端进行以下修改和调整。 设置项 具体操作 设...

模型的性能评估及优化

相关概念 Tensor 配置 使用前提 支持性能评估的模型:格式为 SavedModel 且 TensorFlow 的版本为 1.14 ~ 2.4。 格式为 TorchScript 且 PyTorch 的版本为 1.5 ~ 1.8。 发起性能评估之前,需要填写模型的 Tensor 配置。 存在未结束的评估任务时无法发起新的评估任务。 操作步骤 登录机器学习平台,单击左侧导航栏中的【模型服务】-【模型管理】进入列表页面。 单击待查看模型的名称进入详情页面,并在模型版本列表中选中希望进行性能...