Kafka代理遇到严重问题,错误日志显示“在读取响应之前与X的连接断开”。

社区干货

社区干货

聊聊 Kafka:Topic 创建流程与源码分析 | 社区征文

因此长时间存储数据是完全没问题的。主题是**分区的**,这意味着一个主题分布在位于不同 Kafka 代理的多个“桶”上。数据的这种分布式放置对于可伸缩性非常重要,因为它允许客户端应用程序同时从/向多个代理读取和... 否则将分配和错误传递给延迟操作并设置键。- 尝试立即完成请求,否则将其放入炼狱。#### 3.6.4 把 topic 相关数据写入到 zk 中我们来看下 adminZkClient.createTopicWithAssignment(topic.name, configs, as...

Kafka 消息传递详细研究及代码实现|社区征文

可跨多台计算机读取、写入、存储和处理事件,并有发布和订阅事件流的特性。本文将研究 Kafka 从生产、存储到消费消息的详细过程。 ## Producer### 消息发送所有的 Kafka 服务器节点任何时间都能响应是否可... acks = 1:producer 等待 leader 将记录写入本地日志后,在所有 follower 节点反馈之前就先确认成功。若 leader 在接收记录后,follower 复制数据完成前产生错误,则记录可能丢失acks = all:leader 节点会等待所有同...

Kafka@记一次修复Kafka分区所在broker宕机故障引发当前分区不可用思考过程 | 社区征文

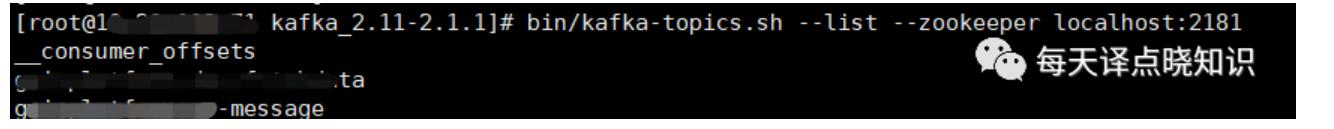

写在前面的话,业务组内研发童鞋碰到了这样一个问题,反复尝试并研究,包括不限于改Kafka,主题创建删除,Zookeeper配置信息重启服务等等,于是我们来一起看看... Ok,Now,我们还是先来一步步分析它并解决它,依然以”... kafka-topics.sh --list --zookeeper localhost:2181```然后,查询topic日志内...

消息队列选型之 Kafka vs RabbitMQ

在面对众多的消息队列时,我们往往会陷入选择的困境:“消息队列那么多,该怎么选啊?Kafka 和 RabbitMQ 比较好用,用哪个更好呢?”想必大家也曾有过类似的疑问。对此本文将在接下来的内容中以 Kafka 和 RabbitMQ 为例分... =&rk3s=8031ce6d&x-expires=1715962830&x-signature=e02%2B1%2BCF9HbuNgwbCEJU809q3XY%3D)首先消息队列支持异步通信,发送方可以快速将消息放入队列中并立即返回,而不需要等待接收方的响应。这种异步通信模式可...

特惠活动

特惠活动

Kafka代理遇到严重问题,错误日志显示“在读取响应之前与X的连接断开”。-优选内容

Kafka代理遇到严重问题,错误日志显示“在读取响应之前与X的连接断开”。-优选内容

Kafka代理遇到严重问题,错误日志显示“在读取响应之前与X的连接断开”。-相关内容

Kafka代理遇到严重问题,错误日志显示“在读取响应之前与X的连接断开”。-相关内容

使用 Kafka 协议上传日志

包含多层嵌套的日志字段将被作为一个字符串进行采集和保存。 限制说明支持的 Kafka 协议版本为 0.11.x~2.0.x。 支持压缩方式包括 gzip、snappy 和 lz4。 为保证日志传输的安全性,必须使用 SASL_SSL 连接协议。对... 错误信息使用 Kafka 协议上传日志失败时,会按照 Kafka 的错误码返回对应的错误信息,请参考 Kafka error list获取更多信息。除此之外,日志服务还在 Java 语言的 Kafka 错误码 SASLAuthenticationException 中封装...

消息队列选型之 Kafka vs RabbitMQ

在面对众多的消息队列时,我们往往会陷入选择的困境:“消息队列那么多,该怎么选啊?Kafka 和 RabbitMQ 比较好用,用哪个更好呢?”想必大家也曾有过类似的疑问。对此本文将在接下来的内容中以 Kafka 和 RabbitMQ 为例分... =&rk3s=8031ce6d&x-expires=1715962830&x-signature=e02%2B1%2BCF9HbuNgwbCEJU809q3XY%3D)首先消息队列支持异步通信,发送方可以快速将消息放入队列中并立即返回,而不需要等待接收方的响应。这种异步通信模式可...

通过 Kafka 协议消费日志

2 小时后或关闭 Kafka 协议消费功能时会被删除。但有效期内的日志数据可以被持续消费。 支持通过标准的开源 Kafka Java SDK 进行日志数据消费,消费日志的示例代码请参考示例代码。也可以使用 Spark Streaming 或 Flink 的 Kakfa 插件对接日志服务,详细说明请参考通过 Spark Streaming 消费日志和通过 Flink 消费日志。 为保证日志传输的安全性,必须使用 SASL_SSL 连接协议。对应的用户名为日志服务项目 ID,密码为火山引擎账号密...

Kafka订阅埋点数据(私有化)

订阅kafka流数据,并输出到console终端,一般用于查看数据格式、排查数据问题等场景下,以下给出两种示例(不同的Kafka版本使用方式不一样),更多参数可以参考kafka官方手册。 Plain /opt/tiger/kafka/bin/kafka-consol... 字段说明 4.1 behavior_event以下字段不保证在每一条行为日志中都是全量采集的 protobuf Event { User user; // 用户信息,见下面User结构 Header header; ...

Kafka订阅埋点数据(私有化)

订阅kafka流数据,并输出到console终端,一般用于查看数据格式、排查数据问题等场景下,以下给出两种示例(不同的Kafka版本使用方式不一样),更多参数可以参考kafka官方手册。 Plain /opt/tiger/kafka/bin/kafka-consol... 字段说明 4.1 behavior_event以下字段不保证在每一条行为日志中都是全量采集的 protobuf Event { User user; // 用户信息,见下面User结构 Header header; ...

Kafka订阅埋点数据(私有化)

订阅kafka流数据,并输出到console终端,一般用于查看数据格式、排查数据问题等场景下,以下给出两种示例(不同的Kafka版本使用方式不一样),更多参数可以参考kafka官方手册。 Plain /opt/tiger/kafka/bin/kafka-consol... 字段说明 4.1 behavior_event以下字段不保证在每一条行为日志中都是全量采集的 protobuf Event { User user; // 用户信息,见下面User结构 Header header; ...

快速开始

集群类型为 Kafka。 根据需要填写好其它的集群创建选项,确认无误后,单击立即创建,提交创建集群。详见创建集群。 单击集群列表 > Kafka 集群名称, 进入集群详情页,可以查看集群创建的进度和操作日志。 等待集群状... Kafka 集群名称 > 节点管理, 进入节点组列表界面。 您可任意展开选择 CoreGroup 的一个节点,例如单击 core-1-1 的节点 ID,进入节点的 ECS 详情页面。 在节点的 ECS 详情页面中,单击右上角远程连接,并选择一种远程...

OpenKafkaConsumer

调用 OpenKafkaConsumer 接口为指定日志主题开启 Kafka 协议消费功能。 使用说明调用此接口为日志主题开启 Kafka 协议消费功能之后,可以将日志主题作为 Kafka 的 Topic 进行消费,每条日志对应一条 Kafka 消息。通过... .ivolces.com/OpenKafkaConsumer HTTP/1.1Content-Type: application/json{ "TopicId": "66********"}返回示例json HTTP/1.1 200 OKContent-Type: application/json; charset=utf-8{}错误码下表为您列举了该接口...

读取日志服务 TLS 数据写入云搜索服务 ESCloud

每条日志对应一条 Kafka 消息。您可以使用 Flink kafka 连接器连接日志服务,通过 Flink 任务将日志服务中采集的日志数据消费到下游的大数据组件或者数据仓库。本文通过 Flink SQL 任务,实现读取 TLS 主题中的日志数... 在详情页面,查看资源池配置详情,阅读并勾选 Flink 相关协议,然后单击立即购买。您可以返回资源池列表页面,查看创建进度。创建完成后显示为运行中。 开发任务-生产消息按照以下步骤开发并运行负责生产消息的 F...