Hbase与spark-submit不兼容。

社区干货

社区干货

9年演进史:字节跳动 10EB 级大数据存储实战

目前已直接支持了十多种数据平台,间接支持了上百种业务发展。从集群规模和数据量来说,HDFS 平台在公司内部已经成长为总数十万台级别服务器的大平台,支持了 10 EB 级别的数据量。**当前在字节跳动,** **HDFS** **承载的主要业务如下:**- Hive,HBase,日志服务,Kafka 数据存储 - Yarn,Flink 的计算框架平台数据 - Spark,MapReduce 的计算相关数据存储![]()# **字节跳动特色的** **HDFS** **架构**在深入相关的技术细...

计算引擎在K8S上的实践|社区征文

value: "spark-thrift-server-test" imagePullPolicy: Always ports: - containerPort: 9000 args: - /opt/spark/bin/spark-submit ... 每次都重新打镜像会不通用。其实这不算一个问题,因为mainApplicationFile最终会对应到spark-submit的application-jar参数,它本身是支持`hdfs://` path 或者 a `http://` 的,因此在任务提交之前将每个任务自身的ya...

「火山引擎」数据中台产品双月刊 VOL.04

接入并支持数据地图组件。- **【数据研发体验增强】** - LAS SQL 任务支持对接 LAS Spark STS 模式,降低作业执行时冷启动的时间成本。 - 提交 LAS SQL 任务新增队列水位校验,预览队列及服务资源使... HBase 的必选组件;Impala、Kudu、ClickHouse、Doris、StarRocks 等服务的核心指标接入监控和告警管理;HBase 中的表支持 Snappy 压缩;Hive,组件行为与开源保持一致,不再支持中文的表字段名;Doris,版本升级至1.1.5;H...

「火山引擎」数据中台产品双月刊 VOL.05

HBase和ByteHouse Connector,支持MySQL Sink,优化多个配置,达到开箱即用;支持avro,csv,debezium-json和avro-confluent等格式;Presto、Trino优化进入客户端方式。- 新增软件栈 2.2.0:HBase集群中集成Knox组件用于... **Hive 升级诉求:** SQL 语法兼容 95+% Hive 语法,字节内部完成全量 Hive 任务 -> SparkSQL 迁移 。更多内容请查看: ### **云原生开源大数据平台** **E-MapReduce** ###### **【冷热数据分层】**- ...

特惠活动

特惠活动

Hbase与spark-submit不兼容。-优选内容

Hbase与spark-submit不兼容。-优选内容

Hbase与spark-submit不兼容。-相关内容

Hbase与spark-submit不兼容。-相关内容

功能发布记录

增强和解决的问题【组件】Proton组件由1.8.0版本升级到1.8.4,优化访问TOS时的吞吐与请求次数、以及小文件写等场景,参考:Proton 发行版本。 【组件】HBase组件由2.3.7升级为2.5.2,并和Phoenix完成适配,参考:apache官网。 【组件】YARN组件修复开源问题[YARN-11178],解决在Kerbeor环境下CPU繁忙问题。 遗留问题【组件】当前 Spark 3.5.1 版本暂不支持 Spark on GPU 计算,我们将在开源社区提供该能力后,再发布支持 Spark on GPU ...

EMR 1.2.0版本说明

环境信息 系统环境版本 环境 OS veLinux(Debian 10兼容版) Python2 2.7.16 Python3 3.7.3 Java ByteOpenJDK 1.8.0_302 应用程序版本组件 Hadoop集群 Flink集群 Kafka集群 Presto集群 Trino集群 HBase集群 OpenSear... 并发写入和 SQL 兼容表演进等功能。 增加了对Presto和Trino的支持,采用Iceberg connector 即可对Iceberg中数据进行操作。 增加了对Spark的支持,配置了Catalog之后,即可轻松使用Spark读写Iceberg数据。 新增Hud...

「火山引擎」数据中台产品双月刊 VOL.05

HBase和ByteHouse Connector,支持MySQL Sink,优化多个配置,达到开箱即用;支持avro,csv,debezium-json和avro-confluent等格式;Presto、Trino优化进入客户端方式。- 新增软件栈 2.2.0:HBase集群中集成Knox组件用于... **Hive 升级诉求:** SQL 语法兼容 95+% Hive 语法,字节内部完成全量 Hive 任务 -> SparkSQL 迁移 。更多内容请查看: ### **云原生开源大数据平台** **E-MapReduce** ###### **【冷热数据分层】**- ...

EMR 1.3.0版本说明

环境信息 系统环境版本 环境 OS veLinux(Debian 10兼容版) Python2 2.7.16 Python3 3.7.3 Java ByteOpenJDK 1.8.0_302 应用程序版本组件 Hadoop集群 Flink集群 Kafka集群 Presto集群 Trino集群 HBase集群 OpenSear... 支持CloudFS ,在TOS基础上提供兼容HDFS语义,同时可基于业务需要,开启缓存加速。 【组件】Ranger的Spark、Hive插件支持对Iceberg表格式进行鉴权控制。 【组件】Doris支持查询分析数据湖格式Hudi Doris支持创建Hud...

「火山引擎」数智平台 VeDI 数据中台产品双月刊 VOL.04

接入并支持数据地图组件。- **【数据研发体验增强】** - LAS SQL 任务支持对接 LAS Spark STS 模式,降低作业执行时冷启动的时间成本。 - 提交 LAS SQL 任务新增队列水位校验,预览队列及服务资源使... HBase 的必选组件;Impala、Kudu、ClickHouse、Doris、StarRocks 等服务的核心指标接入监控和告警管理;HBase 中的表支持 Snappy 压缩;Hive,组件行为与开源保持一致,不再支持中文的表字段名;Doris,版本升级至1.1.5;H...

EMR-3.6.0 版本说明

环境信息 系统环境版本 环境 OS veLinux(Debian 10兼容版) Python2 2.7.16 Python3 3.10.13 Java ByteOpenJDK 1.8.0_352 应用程序版本 Hadoop集群 Flink集群 Kafka集群 HBase集群 StarRocks集群 ClickHouse集群 Op... Spark支持GPU机型 【组件】支持Tez Web UI 【组件】Hadoop集群类型、Kafka集群类型、HBase集群类型、Flink集群类型、自定义集群类型适配Kerberos,该特性属于白名单功能。 更改、增强和解决的问题【组件】Tez版本...

基于火山引擎 EMR 构建企业级数据湖仓

满足多引擎访问:能够对接 Spark 等 ETL 的场景,同时能够支持 Presto 和 channel 等交互式的场景,还要支持流 Flink 的访问能力。 - 开放存储:数据不局限于某种存储底层,支持包括从本地、HDFS 到云对象存储等多... Spark、Flink、Hive、Presto、Kafka、ClickHouse、Hudi、Iceberg 等大数据生态组件,100% 开源兼容,支持构建实时数据湖、数据仓库、湖仓一体等数据平台架构,能帮助用户轻松完成企业大数据平台的建设,降低运维门槛,快...

万字长文,Spark 架构原理和 RDD 算子详解一网打进! | 社区征文

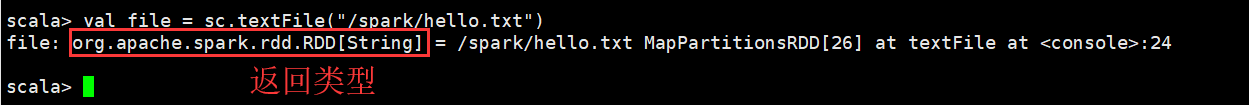

还有所有Hadoop支持的数据集,比如HDFS、Cassandra、HBase等```cppscala> val file = sc.textFile("/spark/hello.txt")```### 3.2 通过并行化的方式创建RDD由一个已经存在的Scala集合创建。```cppscala> val array = Array(1,2,3,4,5)array: Array[Int] = Array(1, 2, 3, 4, 5)scala> val rdd = sc.parallelize(array)rdd: org.apache.sp...

EMR-3.10.0发布说明

环境信息版本 环境 OS veLinux(Debian 10兼容版) Python2 2.7.16 Python3 3.10.13 Java ByteOpenJDK 1.8.0_352 系统环境应用程序版本 Hadoop集群 Flink集群 Kafka集群 Pulsar集群 Presto集群 Trino集群 HBase集群 ... HBase组件由2.3.7升级为2.5.2,并和Phoenix完成适配 【组件】YARN组件修复开源问题[YARN-11178],解决在Kerbeor环境下CPU繁忙问题。 遗留问题【组件】Spark组件不支持在GPU机型执行任务。 【组件】Hive组件集成 H...