实时数据采集方案

最近更新时间:2024.04.11 10:47:40

首次发布时间:2023.11.21 15:36:48

实时数据采集方案支持您将源数据库的增量数据实时采集至消息队列。该方案场景适用于您将源端增量数据同步至目标端数据源库表中,且增量数据较大或者存在波峰波谷时,建议您先进行数据缓存的中间步骤。您可根据实际场景进行选择使用。

本文将为您介绍如何创建实时采集方案。

1 前置操作

- 已开通并创建 DataLeap 项目,创建的全量增量任务均会同步到该项目下。详见新建项目。

- 已开通全域数据集成(DataSail)产品。详见服务开通。

- 已创建合适资源规格的独享数据集成资源组,并将其绑定至创建成功的 DataLeap 项目下。且独享集成资源组已和 DataSail 做网络配置打通。

资源组购买操作详见资源组管理,项目绑定操作详见数据集成资源组,网络操作详见 DataSail 网络配置。 - 已完成来源和目标端的数据源准备,创建数据源操作详见 MySQL 数据源配置、DataSail 数据源配置。

2 数据同步解决方案

2.1 新建实时数据采集

数据源配置前置操作准备完成后,您可开始进行实时数据采集方案配置:

- 登录 DataSail 控制台。

- 在左侧导航栏中选择数据同步方案,进入数据同步解决方案配置界面。

- 单击目录树上方项目选择入口,选择已创建的 DataLeap 项目。

- 单击右上角新建数据同步解决方案按钮,下拉选择实时数据采集按钮,进入实时数据采集方案配置界面。按照以下配置,完成方案新建。

进入配置界面后,您可按实际场景需求,完成方案的基本配置、数据来源配置、数据目标配置、运行配置等流程配置。

2.3 基本配置

基本配置参数说明如下表所示。其中名称前带 * 的参数为必填参数,名称前未带 * 的参数为可选参数。

配置项 | 说明 |

|---|---|

基本信息 | |

*方案名称 | 输入实时数据采集方案名称。只允许字符.、字母、数字、下划线、连字符、[]、【】、()、()以及中文字符,且需在127个字符以内。 |

方案描述 | 输入此方案的描述信息,方便后续维护管理。 |

*保存至 | 下拉选择方案保存路径,此路径为数据开发项目中的任务路径。创建方式详见任务目录树管理。 |

*链路类型 | 下拉选择来源和目标端数据源类型。

|

*写入模式 | 当目标端为 LAS、Hive 数据源类型时,实时数据采集方案支持“实时写入日志表”模式,表示源端所有表的变更记录写入一张 log 表里,log 表由平台自动生成。您可将 log 表与准实时解决方案关联绑定,组合生成全增量表。 |

网络与资源配置 | |

*数据来源 | 下拉选择数据源管理中创建成功的源端数据源名称,支持选择多个。 说明 目前对于 JDBC 类火山引擎标品数据源类型,您可通过批量新增数据源的方式,进行批量创建,单次最多创建 200 个数据源:

|

*数据目标 | 下拉选择数据源管理中创建成功的目标端数据源名称。 |

*实时集成任务资源组 | 下拉选择 DataLeap 项目控制台中已绑定的独享数据集成资源组:

|

方案基本配置完成后,单击右下角下一步按钮,进行方案的数据来源配置。

2.4 数据来源配置

在数据来源配置界面中,完成数据来源设置与库表映射规则匹配策略:

其中名称前带 * 的参数为必填参数,名称前未带 * 的参数为可选参数。

配置项 | 说明 |

|---|---|

数据源设置 | |

*数据源名称 | 下拉选择数据源管理中创建成功的数据源。若此前仍未创建相应数据源,您可单击右侧数据源管理按钮,前往数据源管理界面,进行数据源的创建。或单击批量新建数据源按钮,进行批量创建。 |

*订阅格式 | 下拉选择数据订阅格式,不同源端数据类型支持格式不同,您可根据实际情况进行选择。 |

*源库、源 Schema、源表/Topic 选择限定条件 | 您可通过设置源库、源 Schema、源表的限定条件,来获取源表信息。

|

表 | 单击获取源表按钮,平台根据源库、源表限定条件的设置,自动加载符合条件的表。 |

映射规则 | |

*库表匹配策略 | 支持选择与来源库表同名和自定义方式匹配:

|

数据来源配置完成后,单击右下角下一步按钮,进行方案的数据目标配置。

2.5 数据目标设置

在数据目标配置界面中,完成数据源目标端设置与映射相关配置:

其中名称前带 * 的参数为必填参数,名称前未带 * 的参数为可选参数。

配置项 | 说明 | |

|---|---|---|

数据源设置 | ||

*数据源 | 下拉选择数据源管理中创建成功的目标端数据源。若此前仍未创建相应数据源,您可单击右侧数据源管理按钮,前往数据源管理界面,进行数据源的创建。 | |

映射配置 | ||

高级配置 | 高级参数配置 | 您可按需为同步解决方案配置多表映射高级参数,以 key-value 的形式输入。 |

*刷新源表和目标表映射 | 单击刷新源表和目标表映射按钮,自动加载源表和目标表信息,您可以在列表中进行以下操作: | |

Topic/表建立方式 | Topic/表建立方式分为使用已有表、自动建表和数据表不存在几种方式:

| |

配置 | 您可为采集方案配置映射高级参数,以 key-value 的形式输入。

| |

数据目标配置完成后,单击右下角下一步按钮,进行方案的运行配置。

2.6 运行配置

在运行配置界面,您可设置实时采集同步时相关的运行参数。

其中名称前带 * 的参数为必填参数,名称前未带 * 的参数为可选参数。

配置项 | 说明 |

|---|---|

*实时集成任务资源组 | 下拉选择 DataLeap 项目控制台中已绑定的独享数据集成资源组:

|

*资源设置 | 可通过自定义和默认两种设置方式,进行实时任务运行资源的设定,如单TaskManager CPU数量、单TaskManager内存大小、JobManager CPU数量等。 说明 默认设置中,各运行资源设置如下:

|

集成高级参数设置 | 打开高级参数输入按钮,根据实际业务要求,以 Key\Value 形式,在编辑框中输入实时任务所需的高级参数。支持参数详见高级参数。 |

Flink 运行参数设置 | 支持输入 Flink 相关的动态参数和执行参数,具体参数设置详见 Flink 官方文档。 |

3 提交方案

方案运行配置完成后,单击右下角提交方案按钮,进行方案的提交,在弹窗中,您可根据实际情况勾选方案是否立即执行,并单击确定按钮,完成实时数据采集方案的创建。

4 实时整库方案运维

采集方案创建完成后,进入到方案列表界面,便可查看方案的执行概况,同时您也可以在列表界面进行以下操作:

4.1 解决方案筛选

在创建众多的解决方案后,您可在方案列表界面通过搜索或筛选的方式进行快速定位方案。

- 您可通过方案名称、方案 ID、数据来源名称、数据目标名称等信息,输入搜索的方式进行筛选。

- 您也可通过下拉选择方案操作状态、方案类型、数据来源名称、数据目标类型、创建人等选项进行任务的定位操作。

4.2 解决方案运维

在方案列表的运维列中,您可操作执行方案运维相关内容:

注意

启动中的解决方案不支持进行提交执行、方案编辑、方案删除、运行监控操作。

运维操作 | 说明 |

|---|---|

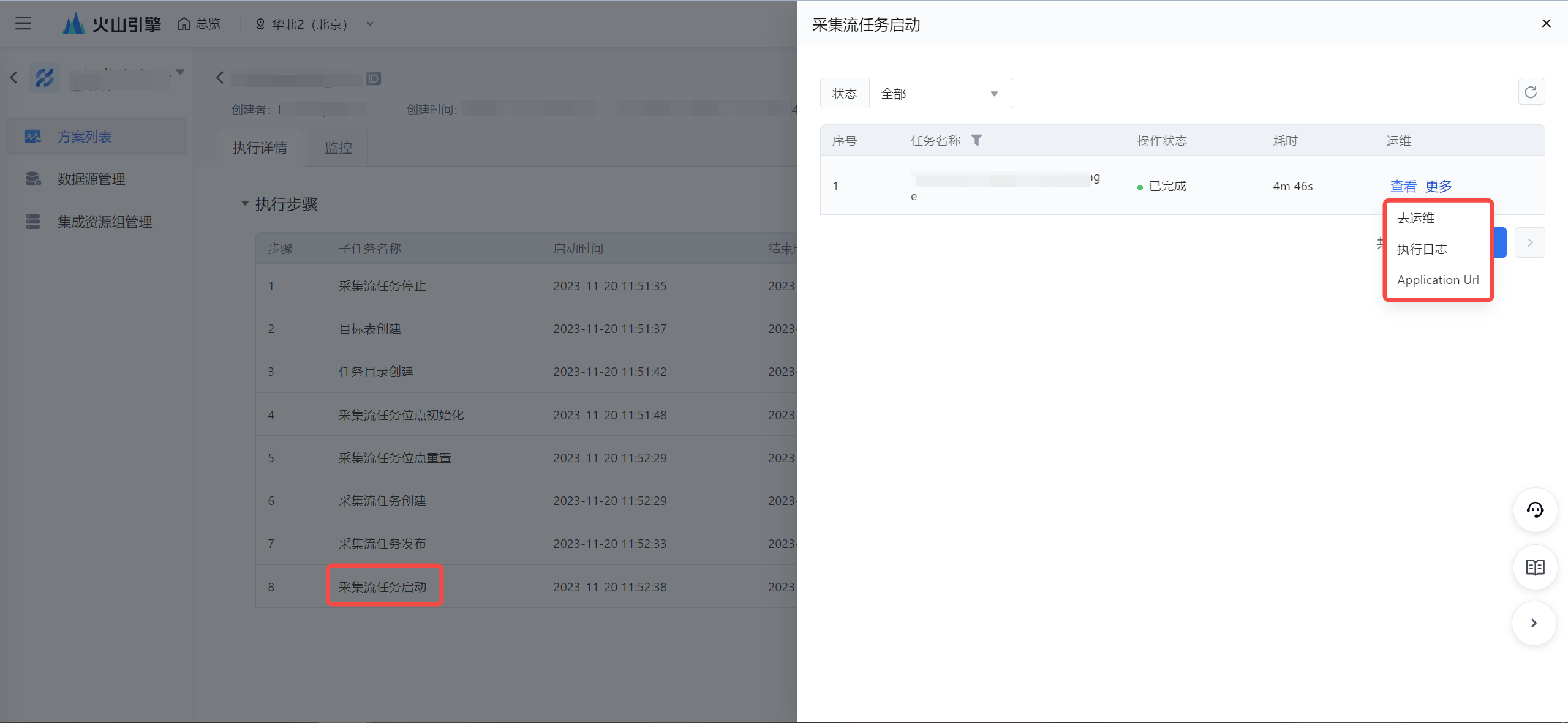

执行详情 |

|

提交执行 | 未在启动中的任务,您可单击运维操作列的提交执行按钮,将任务提交到运行状态,开启实时数据采集任务的运行。

|

方案查看 | 单击运维操作列更多中的方案查看按钮,可对当前采集方案的各个配置步骤进行查看。 |

方案编辑 | 单击运维操作列更多中的方案编辑按钮,可对当前采集方案的方案名称、数据来源端、目标端、运行配置步骤进行修改编辑。 |

方案复制 | 对已创建成功的采集方案任务,您可单击运维操作列更多中的方案复制按钮,对当前采集方案进行复制操作,生成一个新的采集方案。 |

方案删除 | 单击运维操作列更多中的方案删除按钮,将处于非运行中、非启动中的方案进行删除,当前仅删除采集方案本身,已生成的 Topic 和集成任务不会被删除。 |

运行监控 | 单击运维操作列更多中的运行监控按钮,为当前实时数据采集方案配置实时采集任务的运行监控。 |

强制重启 | 单击运维操作列更多中的强制重启按钮,将之前创建的采集方案进行重启操作,区别于提交执行,强制重启会位点初始化、采集流任务停止等操作。 |

提交停止 | 单击运维操作列更多中的提交停止按钮,可将处于正常运行中的采集流任务进行停止操作。 |

操作历史 | 单击运维操作列更多中的操作历史按钮,您可查看当前同步方案的操作历史情况,如创建方案、重启方案、提交停止等操作,均会记录在操作历史中。您可单击操作列中的查看详情按钮,对历史版本的操作进行查看。 |

5 后续步骤

方案提交完成,任务处于运行中后,您也可以前往运维中心>实时任务运维界面,对实时采集任务进行一系列运维操作,如对任务配置监控报警,开启停止任务等操作。运维操作详见实时任务运维。