kafka如何获取7天的数据

社区干货

社区干货

聊聊 Kafka:Topic 创建流程与源码分析 | 社区征文

类似于文件系统中的文件夹,事件就是该文件夹中的文件。Kafka 中的主题总是多生产者和多订阅者:一个主题可以有零个、一个或多个向其写入事件的生产者,以及零个、一个或多个订阅这些事件的消费者。可以根据需要随时读取主题中的事件——与传统消息传递系统不同,事件在消费后不会被删除。相反,您可以通过每个主题的配置设置来定义 Kafka 应该保留您的事件多长时间,之后旧事件将被丢弃。Kafka 的性能在数据大小方面实际上是恒定的,因...

Kafka 消息传递详细研究及代码实现|社区征文

## 背景新项目涉及大数据方面。之前接触微服务较多,趁公司没反应过来,赶紧查漏补缺。Kafka 是其中之一。Apache Kafka 是一个开源的分布式事件流平台,可跨多台计算机读取、写入、存储和处理事件,并有发布和订阅事... 请求来获取它想要消费的 partition。consumer 的每个请求都在 log 中指定了对应的 offset,并接收从该位置开始的一块数据。若现在 consumer 想查找 offset 为 345682 的数据,整个查询过程基于二分法,顺序为:...

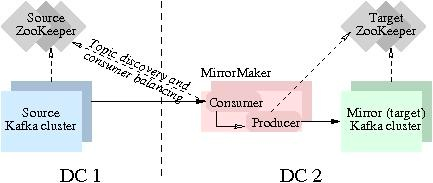

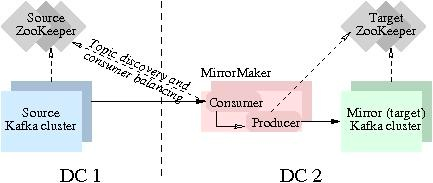

Kafka数据同步

即可实现实时数据同步。本实验主要聚焦跑通Kafka MirrorMaker (MM1)数据迁移流程。实验中的S... 接入点的获取途径如下:外网访问,需要添加SASL认证信息:```XMLsasl.jaas.config=org.apache...

消息队列选型之 Kafka vs RabbitMQ

对此本文将在接下来的内容中以 Kafka 和 RabbitMQ 为例分享消息队列选型的一些经验。消息队列即 Message+Queue,消息可以说是一个数据传输单位,它包含了创建时间、通道/主题信息、输入参数等全部数据;队列(Queue)是一种 FIFO(先进先出)的数据结构,编程语言一般都内置(内存中的)队列实现,可以作为进程间通讯(IPC)的方法。使用队列最常见的场景就是生产者/消费者模式:生产者生产消息放到队列中,消费者从队列里面获取消息消费。典型...

特惠活动

特惠活动

kafka如何获取7天的数据-优选内容

kafka如何获取7天的数据-优选内容

kafka如何获取7天的数据-相关内容

kafka如何获取7天的数据-相关内容

Kafka

1. 概述 Kafka Topic 数据能够支持产品实时数据分析场景,本篇将介绍如何进行 Kafka 数据模型配置。 温馨提示:Kafka 数据源仅支持私有化部署模式使用,如您使用的SaaS版本,若想要使用 Kafka 数据源,可与贵公司的客户... 新建数据集。(2)选择数据连接的时候,点击新建配置。之后的步骤与上述 2.1 的(2)、(3)步一致,在完成上传之后会停在数据集选择数据连接的弹出框中,即可直接进行下一步的数据集创建。 3. 功能介绍 (1)拖拽提取 Kafka ...

聊聊 Kafka:Topic 创建流程与源码分析 | 社区征文

类似于文件系统中的文件夹,事件就是该文件夹中的文件。Kafka 中的主题总是多生产者和多订阅者:一个主题可以有零个、一个或多个向其写入事件的生产者,以及零个、一个或多个订阅这些事件的消费者。可以根据需要随时读取主题中的事件——与传统消息传递系统不同,事件在消费后不会被删除。相反,您可以通过每个主题的配置设置来定义 Kafka 应该保留您的事件多长时间,之后旧事件将被丢弃。Kafka 的性能在数据大小方面实际上是恒定的,因...

使用 Kafka 协议上传日志

日志服务支持通过 Kafka 协议上传日志数据到服务端,即可以使用 Kafka Producer SDK 来采集日志数据,并通过 Kafka 协议上传到日志服务。本文介绍通过 Kafka 协议将日志上传到日志服务的操作步骤。 背景信息Kafka 作... 日志主题名称 选择通过 Kafka 协议上传的日志数据所保存的日志主题。 填写数据源配置,并单击下一步。 配置 说明 密钥 火山引擎账户密钥,包括 AccessKey ID 和 AccessKey Secret。您可以参考页面提示获取密...

Kafka 消息传递详细研究及代码实现|社区征文

## 背景新项目涉及大数据方面。之前接触微服务较多,趁公司没反应过来,赶紧查漏补缺。Kafka 是其中之一。Apache Kafka 是一个开源的分布式事件流平台,可跨多台计算机读取、写入、存储和处理事件,并有发布和订阅事... 请求来获取它想要消费的 partition。consumer 的每个请求都在 log 中指定了对应的 offset,并接收从该位置开始的一块数据。若现在 consumer 想查找 offset 为 345682 的数据,整个查询过程基于二分法,顺序为:...

使用Logstash消费Kafka中的数据并写入到云搜索

您将学习如何使用 Logstash 消费 Kafka 中的数据,并写入到云搜索服务中。 关于实验 预计部署时间:20分钟级别:初级相关产品:消息队列 - Kafka & 云搜索受众: 通用 环境说明 如果还没有火山引擎账号,点击此链接注册账... 请先点击链接创建VPC 消息队列 - Kafka 云搜索 云服务器ECS:Centos 7 在 ECS 主机上准备 Kafka 客户端的运行环境,提前安装好Java运行环境 在 ECS 主机上安装 Logstash 实验步骤 步骤一:准备 Logstash 配置文...

读取日志服务 TLS 数据写入云搜索服务 Cloud Search

实现读取 TLS 主题中的日志数据,然后写入到 ESCloud 索引中。 流程介绍 准备数据源 TLS 主题。您需要在日志服务控制台创建一个日志项目,然后创建一个日志主题,并开通 Kafka 协议消费。还需要获取项目的访问地址、项... 单位为天,默认为 30 天。取值范围为 1~3650,指定为 3650 天表示永久存储。 日志分区数量 日志分区的数量,默认创建 1 个分区,取值范围为1~10。 每个分区提供的写入能力为 5 MiB/s、500 次/s,读取能力为 10 MiB/s、...

创建并连接到 Kafka 集群

前言 Kafka是是一个分布式、支持分区的(partition)、多副本的(replica) 分布式消息系统, 深受开发人员的青睐。在本教程中,您将学习如何创建 Kafka 集群,并使用客户端连接,生产数据并消费数据。 关于实验 预计部署时间:20分钟级别:初级相关产品:消息队列 - Kafka受众: 通用 环境说明 如果还没有火山引擎账号,点击此链接注册账号 如果您还没有VPC,请先点击链接创建VPC 消息队列 - Kafka 云服务器ECS:Centos 7 在ECS主机上准备K...

读取日志服务 TLS 数据写入云搜索服务 ESCloud

实现读取 TLS 主题中的日志数据,然后写入到 ESCloud 索引中。 流程介绍 准备数据源 TLS 主题。您需要在日志服务控制台创建一个日志项目,然后创建一个日志主题,并开通 Kafka 协议消费。还需要获取项目的访问地址、项... 单位为天,默认为 30 天。取值范围为 1~3650,指定为 3650 天表示永久存储。 日志分区数量 日志分区的数量,默认创建 1 个分区,取值范围为1~10。 每个分区提供的写入能力为 5 MiB/s、500 次/s,读取能力为 10 MiB/s、...

Kafka数据同步

即可实现实时数据同步。本实验主要聚焦跑通Kafka MirrorMaker (MM1)数据迁移流程。实验中的S... 接入点的获取途径如下:外网访问,需要添加SASL认证信息:```XMLsasl.jaas.config=org.apache...