kafka日志服务器

社区干货

社区干货

Logstash 如何通过 Kafka 协议消费 TLS 日志

# **问题现象**如何通过修改 Logstash 配置文件,实现通过 Kafka 协议消费日志到其他业务系统。# 问题分析TLS 日志服务支持通过 Logstash 消费日志数据,您可以通过配置 Logstash 服务内置的 logstash-input-kafk... kafka { bootstrap_servers => "tls-cn-beijing.ivolces.com:9093" security_protocol => "SASL_SSL" sasl_mechanism => "PLAIN" enabl...

Kafka 消息传递详细研究及代码实现|社区征文

本文将研究 Kafka 从生产、存储到消费消息的详细过程。 ## Producer### 消息发送所有的 Kafka 服务器节点任何时间都能响应是否可用、是否 topic 中的 partition leader,这样生产者就能发送它的请求到服务器... properties.put(ProducerConfig.BOOTSTRAP_SERVERS_CONFIG, "kafka1:9092, kafka2:9092, kafka3:9092");// 消息不成功重试次数properties.put(ProducerConfig.RETRIES_CONFIG, 0);// 请求的最大大小 以字节为...

Kafka@记一次修复Kafka分区所在broker宕机故障引发当前分区不可用思考过程 | 社区征文

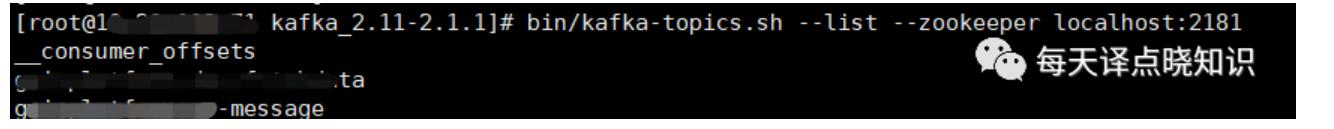

Kafka集群由多个节点组成,但其中某个节点宕掉,整个分区就不能正常使用-消费者端无法订阅到消息。 首先,我们来看下Kafka的配置信息:```js[root@xx-xx-xxx-xx kafka_2.11-2.1.1]# nohup bin/kafka-server-st... kafka-topics.sh --list --zookeeper localhost:2181```然后,查询topic日志内...

聊聊 Kafka:Topic 创建流程与源码分析 | 社区征文

/bin/kafka-topics.sh --create --zookeeper localhost:2181 --partitions 3 --replication-factor 3 --topic topic_test```注:-–zookeeper 后面接的是 kafka 的 zk 配置, 假如你配置的是 localhost:2181/kafka 带命名空间的这种,则不要漏掉了。### 2.2 Kafka 版本 >= 2.2 支持下面的方式(推荐)```./bin/kafka-topics.sh --create --bootstrap-server localhost:9092 --partitions 3 --replication-factor 3 --topic to...

特惠活动

特惠活动

kafka日志服务器-优选内容

kafka日志服务器-优选内容

kafka日志服务器-相关内容

kafka日志服务器-相关内容

从 Kafka 导入数据

日志服务支持 Kafka 数据导入功能,本文档介绍从 Kafka 中导入数据到日志服务的操作步骤。 背景信息日志服务数据导入功能支持将 Kafka 集群的消息数据导入到指定日志主题。Kafka 数据导入功能通常用于业务上云数据迁移等场景,例如将自建 ELK 系统聚合的各类系统日志、应用程序数据导入到日志服务,实现数据的集中存储、查询分析和加工处理。日志服务导入功能支持导入火山引擎消息队列 Kafka 集群和自建 Kafka 集群的数据。创建导入...

通过 Flink 消费日志

2 为 Flink 配置 Kafka sourceKafka Source 提供了构建类来创建 KafkaSource 的实例。其使用方法和实现细节请参考 Flink 官方文档。在构建 KafkaSource 时必须通过以下方法指定基础属性。 方法 说明 setBootstrapServers() Bootstrap server,应配置为初始连接的集群地址。格式为服务地址:端口号,例如 tls-cn-beijing.ivolces.com:9093。 服务地址为当前地域下日志服务的服务地址。请根据地域和网络类型选择正确的服务地址,详细...

通过 Spark Streaming 消费日志

日志服务提供 Kafka 协议消费功能,您可以使用 Spark Streaming 的 spark-streaming-kafka 组件对接日志服务,通过 Spark Streaming 将日志服务中采集的日志数据消费到下游的大数据组件或者数据仓库。 场景概述Spark... kafkaParams.put("bootstrap.servers", tlsEndConsumePoint);//指定kafka输出key的数据类型及编码格式(默认为字符串类型编码格式为uft-8)kafkaParams.put("key.deserializer", StringDeserializer.class);//指定ka...

通过 ByteHouse 消费日志

ByteHouse(云数仓版)支持通过 Kafka 流式传输数据。本文档介绍如何将日志服务中的日志数据通过 Kafka 协议消费到 ByteHouse。 背景信息日志服务支持通过 Kafka 协议消费指定日志主题中的日志数据,例如消费到 ByteHouse(云数仓版)中进行进一步的分析处理。在 ByteHouse 中创建 Kafka 数据导入任务之后,可以直接通过 Kafka 流式传输数据。数据导入任务将自动运行,持续读取日志主题中的日志数据,并将其写入到指定的数据库表中。消费...

接入 Filebeat

Input 在指定的位置中查找日志数据。 Filebeat 会为每个找到的日志启动 Harvester,Harvester 读取日志并将日志数据发送到 libbeat。 libbeat 聚集数据,然后将聚集的数据发送到配置的 Output。 如需了解 Filebeat 更多信息,请参考开源文档Filebeat 概述、Filebeat 快速入门-安装与配置、Filebeat 工作原理。 前提条件本文介绍在 Filebeat 中接入消息队列 Kafka版,要求用于安装 Filebeat 的云服务器和 Kafka 实例两者的所处地域、所...

OpenKafkaConsumer

调用 OpenKafkaConsumer 接口为指定日志主题开启 Kafka 协议消费功能。 使用说明调用此接口为日志主题开启 Kafka 协议消费功能之后,可以将日志主题作为 Kafka 的 Topic 进行消费,每条日志对应一条 Kafka 消息。通过... 日志主题不存在。 400 ConsumeTopicOperateDisable Please try this operator for consume topic after 2min. 请勿频繁操作,请于 2 分钟后再进行。 500 InternalServerError We encountered an unexpected server...

管理 Kafka 投递配置

成功创建日志投递配置后,您可以在投递配置列表查看并管理 Kafka 投递配置,例如修改投递配置,暂停或启动日志投递等。 修改投递配置成功创建投递配置后,您可以在日志投递页面的投递配置列表中查看投递配置的基本信息,也可以单击投递配置名称,查看投递配置的详细配置,或根据需求随时修改投递配置的各项参数配置。操作步骤如下: 登录日志服务控制台。 在左侧导航栏中选择日志服务 > 日志项目管理。 找到指定的日志项目,单击项目名称。...

Logstash 如何通过 Kafka 协议消费 TLS 日志

# **问题现象**如何通过修改 Logstash 配置文件,实现通过 Kafka 协议消费日志到其他业务系统。# 问题分析TLS 日志服务支持通过 Logstash 消费日志数据,您可以通过配置 Logstash 服务内置的 logstash-input-kafk... kafka { bootstrap_servers => "tls-cn-beijing.ivolces.com:9093" security_protocol => "SASL_SSL" sasl_mechanism => "PLAIN" enabl...

CloseKafkaConsumer

调用 CloseKafkaConsumer 关闭指定日志主题的 Kafka 协议消费功能。 使用说明停止消费后,您可以调用此接口关闭 Kafka 协议消费功能。此接口调用频率限制为 20 次/s,超出频率限制会报错 ExceedQPSLimit。 请求说明请求方式:PUT 请求地址:https://tls-{Region}.ivolces.com/CloseKafkaConsumer 请求参数下表仅列出该接口特有的请求参数和部分公共参数。更多信息请见公共参数。 Body参数 类型 是否必选 示例值 描述 TopicId String ...