怎样确认显卡支持cuda

社区干货

社区干货

Linux安装CUDA

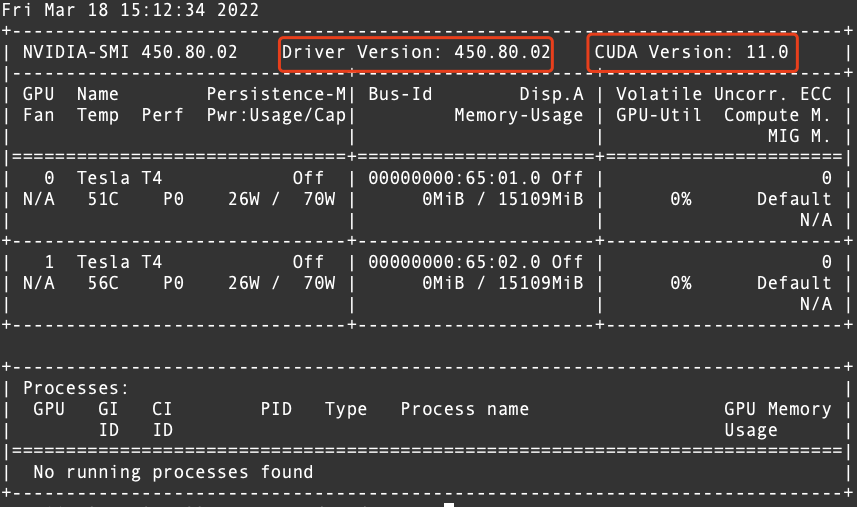

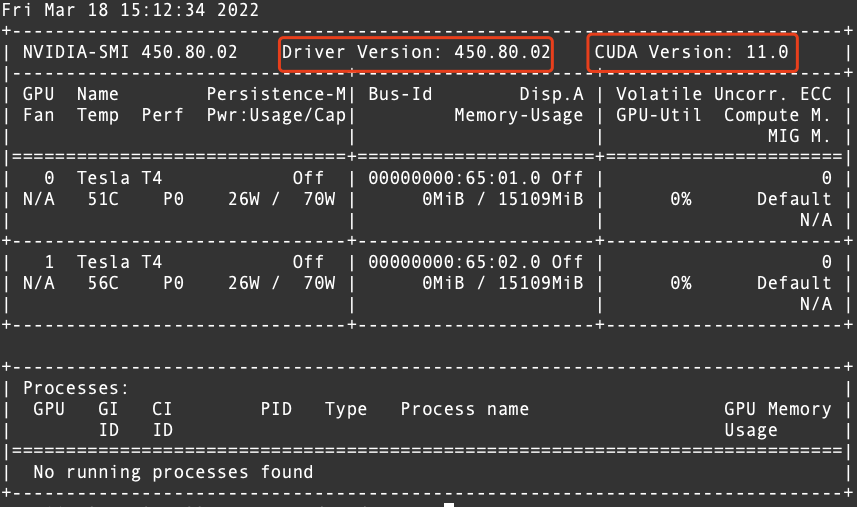

# 运行环境* CentOS* RHEL* Ubuntu* OpenSUSE# 问题描述初始创建的火山引擎实例并没有安装相关cuda软件,需要手动安装。# 解决方案1. 确认驱动版本,以及与驱动匹配的cuda版本,执行命令`nvidia-smi`显示如下。  从上图中可以确认CUDA的版本为 11.02. 从英伟达官方网站下载相对应的 CUDA 版本的...

我的AI学习之路----拥抱Tensorflow 拥抱未来|社区征文

那个时候我还不知道Python具体是什么,只知道大家都叫它编程语言,于是我开始试着了解,初识Python的这些日子也算是打开了我的AI之路,我和Tensorflow之间也产生了深刻的感情!作为一名人工智能专业的学生,谷歌的Tens... 3.CUDA8.04.cuDNN5.Python 3.5**需要注意的是,CUDA8.0是NVIDIA显卡才能安装的,不安装CUDA8.0的话,TensorFlow只能用电脑的CPU来计算了,计算速度会大打折扣。## 2.TensorFlow安装过程### 2.1 安装anaconda进...

【发布】多模态 VisualGLM-6B,最低只需 8.7G 显存

用户可以在消费级的显卡上进行本地部署(INT4量化级别下最低只需8.7G显存)。 **二、使用**模型推理使用pip安装依赖``` pip install -r requirements.txt ```此时默认会安装deepspeed库(支持sat库训练),此库对于模型推理并非必要,同时部分Windows环境安装此库时会遇到问题。如果想绕过deep...

火山引擎部署ChatGLM-6B实战指导

V100等GPU显卡的ECS云主机,操作系统镜像选择Ubuntu 带GPU驱动的镜像,火山引擎默认提供的GPU驱动版本为CUDA11.3,如果需要升级版本的话可以参考后面的步骤,配置GPU服务器。### 配置网际快...

特惠活动

特惠活动

怎样确认显卡支持cuda-优选内容

怎样确认显卡支持cuda-优选内容

怎样确认显卡支持cuda-相关内容

怎样确认显卡支持cuda-相关内容

NVIDIA驱动FAQ

执行nvidia-smi命令查看的CUDA版本和实际的安装版本为何不一致?执行nvidia-smi命令查询到的CUDA版本代表您的GPU实例可以支持的最高CUDA版本,并不代表您实际安装的CUDA版本。 如何查询GPU显卡的详细信息?不同操作系统的GPU实例,查看GPU显卡信息的操作如下: Linux操作系统,您可以执行nvidia-smi命令,查看GPU显卡的详细信息。 Windows操作系统,您可以在设备管理器中查看GPU显卡的详细信息。 如果您想了解GPU卡的运行和使用情况,请...

Linux安装CUDA

# 运行环境* CentOS* RHEL* Ubuntu* OpenSUSE# 问题描述初始创建的火山引擎实例并没有安装相关cuda软件,需要手动安装。# 解决方案1. 确认驱动版本,以及与驱动匹配的cuda版本,执行命令`nvidia-smi`显示如下。  从上图中可以确认CUDA的版本为 11.02. 从英伟达官方网站下载相对应的 CUDA 版本的...

GPU-基于Diffusers和Gradio搭建SDXL推理应用

本文以搭载了一张V100显卡的ecs.g1ve.2xlarge实例,介绍如何在GPU云服务器上基于Diffusers搭建SDXL 1.0的base + refiner组合模型。 背景信息SDXL Stable Diffusion XL(简称SDXL)是最新的图像生成模型,与之前的SD模型... 实现强大的GPU加速的同时还支持动态神经网络。本文以2.0.0为例。Pytorch使用CUDA进行GPU加速时,在GPU驱动已经安装的情况下,依然不能使用,很可能是版本不匹配的问题,请严格关注虚拟环境中CUDA与Pytorch的版本匹配情...

GPU-使用Llama.cpp量化Llama2模型

本文以搭载了一张V100显卡的ecs.g1ve.2xlarge实例,介绍如何在云服务器上利用Llama.cpp执行Llama2-7B模型的量化,并对比基于CPU的推理和基于GPU的推理速度。 背景信息Llama.cpp简介Llama.cpp是使用C++语言编写的大模型量化工具,同时也提供了部署和运行量化后模型的demo。它基于GGML(一种机器学习张量库),实现了对Llama模型的量化、推理部署功能。旨在实现开源大模型运行于相对低配置或廉价的硬件之上,它能支持将Llama模型推理部署至...

HPC裸金属-基于NCCL的单机/多机RDMA网络性能测试

本文介绍如何在虚拟环境或容器环境中,使用NCCL测试ebmhpcpni2l实例的RDMA网络性能。 背景信息ebmhpcpni2l实例搭载NVIDIA A800显卡,同时支持800Gbps RDMA高速网络,大幅提升集群通信性能,提高大规模训练加速比。更多... 支持安装在单个节点或多个节点的大量GPU卡上,实现多个GPU的快速通信。 关键组件本文所述操作需要安装的软件包介绍如下。 关键组件 说明 NVIDIA驱动 GPU驱动:用来驱动NVIDIA GPU卡的程序。 CUDA工具包:使GPU能够...

VirtualBox制作ubuntu14镜像

实验介绍CUDA 是 NVIDIA 发明的一种并行计算平台和编程模型。它通过利用图形处理器 (GPU) 的处理能力,可大幅提升计算性能。PyTorch是一个开源的Python机器学习库,基于Torch,用于自然语言处理等应用程序。 Pytorch使... 确定选择的时区 设置磁盘分区格式分区, 设置 不自动更新 空格键选择软件,一定要选择OpenSSH server,其他根据自己需求选择 根据需要选择 步骤三:设置ssh远程登录由于VirtualBox不支持鼠标,也不知道快捷键复...

新功能发布记录

支持后台自动安装更高版本的GPU驱动、CUDA和CUDNN库。 全部 商用 驱动安装指引 2023年11月24日序号 功能描述 发布地域 阶段 文档 1 邀测上线GPU计算型gni3实例。 华东2(上海) 邀测 GPU计算型gni3 2023年09月08日序... 功能描述 发布地域 阶段 文档 1 部署了hpcpni2实例的高性能计算集群支持绑定vePFS文件系统。 华北2(北京) 邀测 管理vePFS存储资源 2022年12月13日序号 功能描述 发布地域 阶段 文档 1 搭载T4显卡的GPU计算型g1te、...

GPU-部署基于DeepSpeed-Chat的行业大模型

查看CUDA。nvcc -V回显如下,表示CUDA安装成功。 创建虚拟环境执行以下命令,下载Anaconda安装包。wget https://repo.anaconda.com/archive/Anaconda3-2023.07-2-Linux-x86_64.sh 执行以下命令,安装Anaconda。bash Anaconda3-2023.07-2-Linux-x86_64.sh持续按“Enter”键进行安装。 输入“yes”确认信息。 Anaconda的安装路径/root/anaconda3,请按“Enter”确认安装。 输入“yes”确定初始化Anaconda。 执行以下命令使配置文件生...

安装NVIDIA-Fabric Manager软件包

操作场景NVIDIA-Fabric Manager服务可以使多A100/A800显卡间通过NVSwitch互联。有关NVSwitch的更多介绍,请参见NVIDIA官网。 说明 搭载A100/A800显卡的实例请参见实例规格介绍,如果未安装与GPU驱动版本对应的NVIDIA... 方式一:通过安装包安装CentOS 8.x wget https://developer.download.nvidia.cn/compute/cuda/repos/rhel8/x86_64/nvidia-fabric-manager-470.57.02-1.x86_64.rpmrpm -ivh nvidia-fabric-manager-470.57.02-1.x86_...