使用 Hive 访问 CloudFS 中的数据

最近更新时间:2023.08.02 14:36:25

首次发布时间:2022.05.26 14:18:32

Hive 是基于 Hadoop 的一个数据仓库工具,用来进行数据提取、转化、加载。本文介绍如何配置 Hive 服务来访问 CloudFS 中的数据。

前提条件

在使用 Hive 服务访问大数据文件存储服务 CloudFS 前,确保您已经完成以下准备工作:

- 开通大数据文件存储服务 CloudFS 并创建文件存储,获取挂载信息。详细操作请参考创建文件存储系统。

- 开通 E-MapReduce 服务并创建集群。详细操作请参考E-MapReduce 集群创建。

- 在配置 Hive 服务之前,请确认

/user/hive/目录中的数据已完成全量迁移。详细操作请参考迁移 Hadoop 文件系统数据至 CloudFS。

步骤一:配置 CloudFS 服务

说明

集群所有节点都要修改如下配置。

- 下载 CloudFS SDK 并解压。下载地址:inf.hdfs.cfs_sdk_deploy_1.4.1.tar.gz。

- 将解压后的 SDK 目录下的

cloudfs-hadoop-with-dependencies-cfs-1.4.1.jar文件复制到Hadoop的share/hadoop/hdfs目录下。 - 配置

core-site.xml文件。

<property> <name>fs.defaultFS</name> <value>cfs://xxxx.cfs-cn-beijing.ivolces.com</value> </property> <property> <name>fs.cfs.impl</name> <value>com.volcengine.cloudfs.fs.CfsFileSystem</value> </property> <property> <name>fs.AbstractFileSystem.cfs.impl</name> <value>com.volcengine.cloudfs.fs.CFS</value> </property> <property> <name>cfs.access.key</name> <value>AKxxxxxxxxxxx</value> </property> <property> <name>cfs.secret.key</name> <value>SKxxxxxxxxxxx</value> </property> <!-- 可选:如果使用的是 STS Token,需要填写 --> <property> <name>cfs.security.token</name> <value>STSTokenxxxxxxxx</value> </property> <!-- 可选:如果开启缓存加速,需要配置缓存加速接入的 VPC 的网段 --> <property> <name>cfs.client.network.segment</name> <value><VPC 网段,例如 192.168.0.0/16></value> </property>

其中:

xxxx.cfs-cn-beijing.ivolces.com是大数据文件存储的挂载点地址,将其替换为已创建文件存储系统的挂载地址即可。AKxxx和SKxxx分别为访问密钥ID和私有访问密钥,详细说明请参考密钥管理。

- 登录火山引擎 E-MapReduce 控制台。

- 在集群管理页面,找到需要挂载文件存储实例的目标 E-MapReduce 集群。

- 选择服务列表 > HDFS。

- 在页面右侧的操作栏中,单击重启 > 重启全部组件,重启服务。

步骤二:使用 Hive 访问 CloudFS 数据

您可以通过以下两种方法将 Hive 的表数据存储至 CloudFS:

- 修改 hive 默认存储位置。

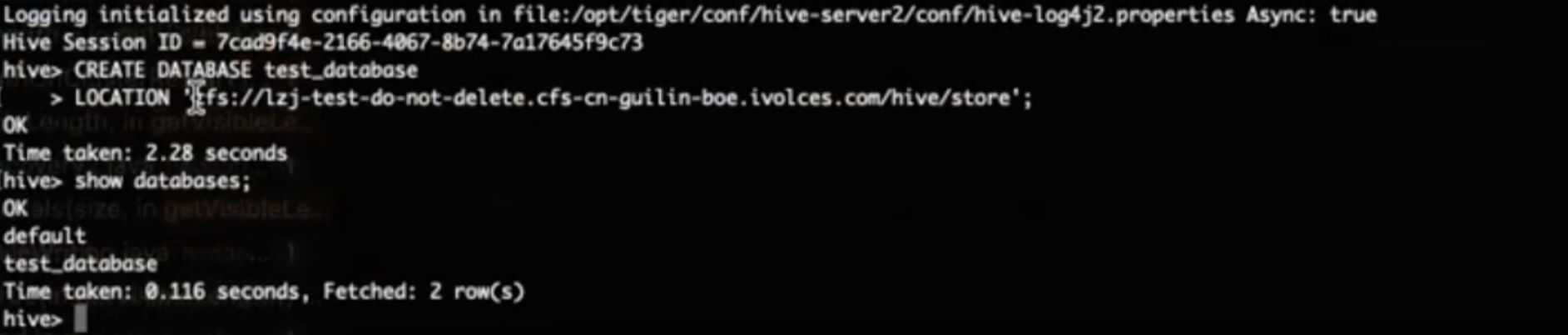

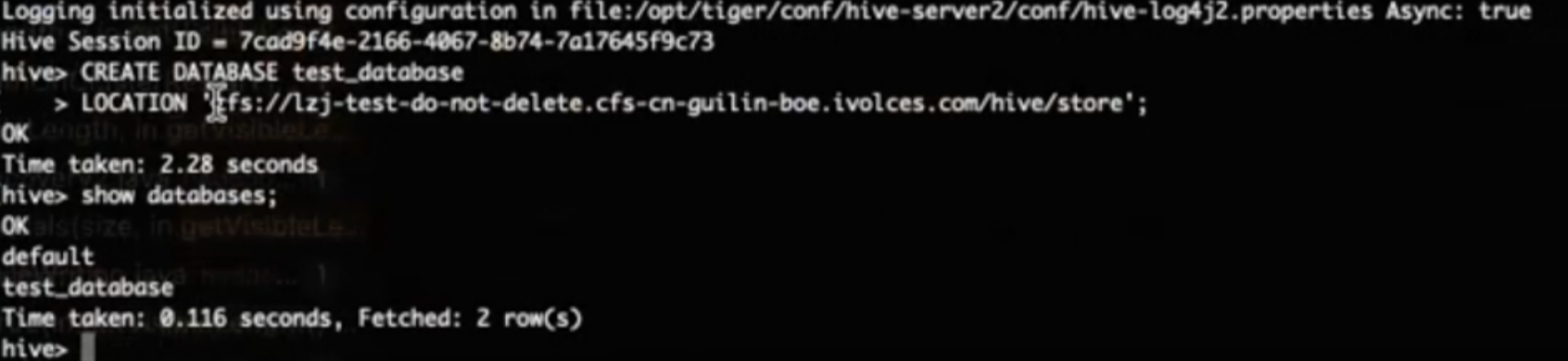

修改 hive-site 中的配置项hive.metastore.warehouse.dir。例如配置成:cfs://{YOUR_ENDPOINT}/hive/store。 - 创建库/表/分区时指定存储路径。

CREATE DATABASE database_name LOCATION 'cfs://{YOUR_ENDPOINT}/hive/store';CREATE [EXTERNAL] TABLE table_name [(col_name data_type,...)] LOCATION 'cfs://{YOUR_ENDPOINT}/hive/store';ALTER TABLE table_name ADD PARTITION[(col_name data_type,...)] LOCATION 'cfs://{YOUR_ENDPOINT}/hive/store';说明

{YOUR_ENDPOINT}替换为您的文件存储 CFS 版挂载点域名(cfs://xxxx.cfs-cn-beijing.ivolces.com)。

- 修改 hive 默认存储位置。

验证是否存储成功。

- 创建 Hive 表。

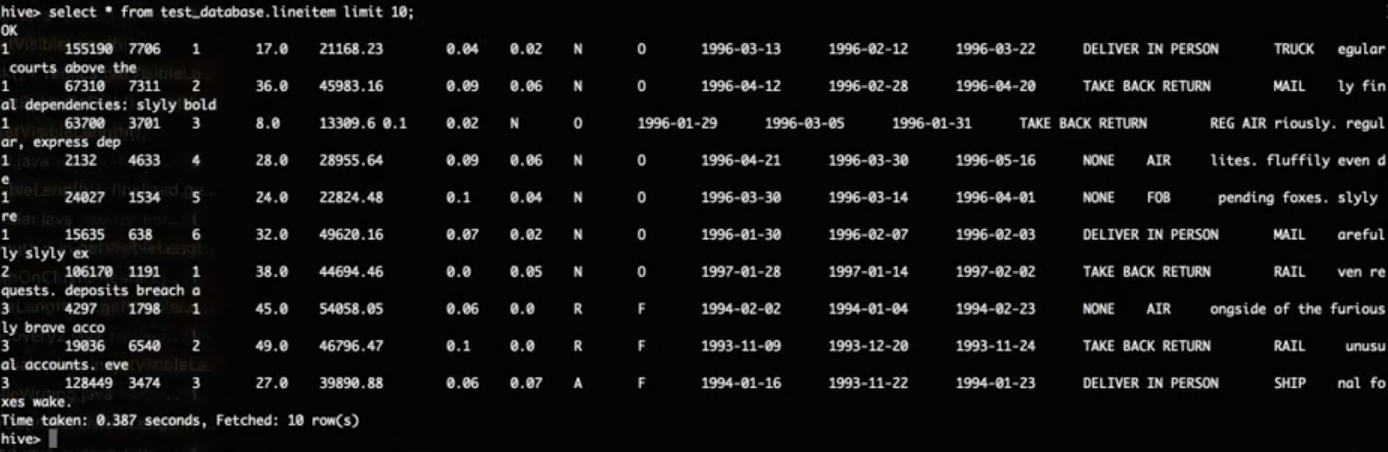

执行表查询命令查看返回结果:

- 将本地数据集加载至 Hive 表中。

LOAD DATA LOCAL INPATH '/{Directory}/tpch/region.tbl' INTO TABLE region; LOAD DATA LOCAL INPATH '/{Directory}/tpch/nation.tbl' INTO TABLE nation; LOAD DATA LOCAL INPATH '/{Directory}/tpch/part.tbl' INTO TABLE part; LOAD DATA LOCAL INPATH '/{Directory}/tpch/supplier.tbl' INTO TABLE supplier; LOAD DATA LOCAL INPATH '/{Directory}/tpch/partsupp.tbl' INTO TABLE partsupp; LOAD DATA LOCAL INPATH '/{Directory}/tpch/customer.tbl' INTO TABLE customer; LOAD DATA LOCAL INPATH '/{Directory}/tpch/orders.tbl' INTO TABLE orders; LOAD DATA LOCAL INPATH '/{Directory}/tpch/lineitem.tbl' INTO TABLE lineitem;说明

{Directory}替换为您的文件加载路径。

上传完成后,将返回下图内容。

3. 执行查询命令查询 Hive 表。select C_NATIONKEY,count(*) from customer group by C_NATIONKEY;

- 创建 Hive 表。