《跟着德爷闯东非》是Pico一款全新的6DoF互动纪录片。主角由在全球拥有530万粉丝的明星探险家德爷(Edward James Stafford)担任。观众以第一视角摄影师的身份陪伴德爷一起冒险,近距离观察野生动物,体验非洲大草原的野外生存之旅。

与行业内常见的不具备互动性的3DoF实拍纪录片以及不具备写实性的游戏引擎制作的6DoF纪录片不同,《跟着德爷闯东非》纪录片的拍摄采用空间重建技术及虚实融合技术,兼顾实拍和虚拟互动,以全新的6DoF互动体验,增强了VR内容的沉浸性和交互性,让用户跟随德爷的脚步沉浸式体验从城市“跃入”荒野的快感。

全新VR空间互动性的挑战和难点

传统VR实拍视频的交互通常采用不同选项触发不同结局的AB型互动方式,而《跟着德爷闯东非》想要实现的是全新的VR空间互动,用户可以抓起虚拟世界中的物体完成任务,比如和德爷一起钻木取火,也可以在场景中自由走动,在非洲草原和德爷一起追捕猎杀珍珠鸡,实现全新的交互和达到高沉浸感,突破传统视频的界限。

而想要实现全新的交互和体验高沉浸感,需要做到:

实际拍摄的VR视频和用于互动的场景、物品具备高度一致性,包含几何结构、纹理色彩及光影的一致性,这对于空间重建技术提出了很高的要求,需要做到高精度、高质量、真实感建模,超写实数字复原空间场景,让用户感受到原汁原味的非洲荒野。

用户在体验中,虚拟元素与实际场景相互交织,让用户在场景中难以区分哪些是真实的,哪些是虚拟的,达到了最佳的体验效果。这就要求无缝虚实融合技术,需要对重建的数字素材和实拍的视频素材进行像素级配准,这样用户才能够自然沉浸

的地在场景中和德爷一起探索非洲,并从实拍3DoF视频中德爷手里顺利接过数字重建的6DoF互动道具。

空间重建,复原现实世界

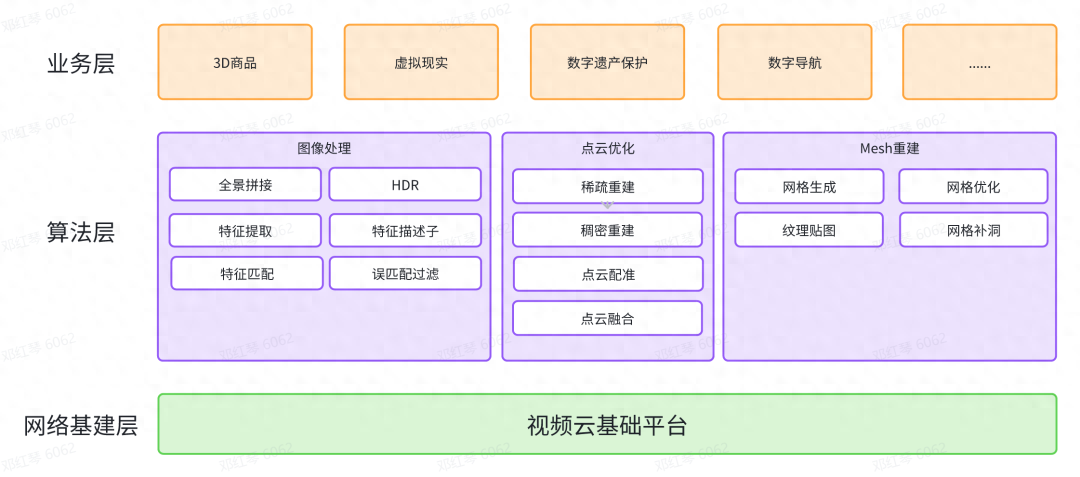

空间重建技术能够复原现实世界的场景和物品并转化为数字资产,是计算机视觉和摄影测量中的重要研究课题,也在智慧城市、虚拟现实、数字导航与数字遗产保护等方面有着重要的应用。

- 火山引擎多媒体实验室团队自研改进SFM算法框架,实现高精度的场景稀疏重建及图像定位。

针对特征点提取、匹配算法,通过结合传统特征与深度学习方法,算法在大视角/尺度变化、暗光、弱纹理、运动模糊等多种挑战场景下仍能有效提取足量稳定的特征;通过将特征点纳入自注意力和交叉注意力网络,结合多源传感器输入检索全局最优图像特征匹配,使得算法即使在空地跨视角、鱼眼/针孔/全景跨相机等复杂数据输入的情况下,实现建图完整度、成功率均达到100%。同时,开发支持多相机系统、多相机模型光束法平差优化算法,同时也兼容其他不同传感器的联合重建,实现高精度、多模态的位姿估计。

- 在稀疏重建算法之后,需要进行稠密算法重建。

火山引擎多媒体实验室通过立体视觉 (Multiple View Stereo,简称MVS)技术将二维图像信息转化为三维点云信息。团队自研基于多目立体视觉及全景图的深度估计算法,通过神经网络进行稠密深度估计,在野外大场景环境获得高精度的场景稠密几何测量。获得点云信息后,进行点云去噪和补全,并通过点云配准实现场景几何一致性。最后,通过基于TSDF和图像语义信息的点云融合策略,进一步滤除噪声,生成更加平滑一致的完整场景点云。

- 获得场景点云后,进行 Mesh 重建。

火山引擎多媒体实验室自研多种网格优化算法,实现网格平滑、去噪、简化和补洞,获得更加精细、完整的高质量网格模型。得益于图像处理期间高精度的相机位姿估计以及图像超分等画质优化,结合自研贴图算法,获得更高清、拼缝更少的高质量纹理贴图。同时通过纹理重打包算法优化,实现更高的纹理利用率,降低存储资源浪费,提升纹理有效分辨率。

东非洞穴重建效果

目前,火山引擎视频云平台具备自动化空间建模链路,助力大场景重建,可支持采集RGBD/RGB数据(无人机、手持采集等)自动化上传云平台,2-4小时后自动产出建模结果,建模精度可达1cm~2cm。同时,火山引擎视频云的云渲染可视化系统,联合自研动态传输算法,可实现高度真实感的模型渲染。 火山引擎视频云三维重建平台

火山引擎视频云三维重建平台

火山引擎多媒体实验室将神经辐射场技术(NeRF)与自研大场景建模技术相结合,研发行业领先的大场景光场重建方案,实现高度真实感(psnr>30)的场景重建、复现及后编辑。

在具体实践的场景中,动态物体会使NeRF重建出现伪影,借助自研动静态分割、影子检测、inpainting等算法,对场景中和几何不一致的区域进行提取、修复。同时借助自研高精度SFM算法框架,对场景进行高精度的几何重建,包括相机参数估计以及稀疏、稠密点云生成。另外,对场景进行拆分以减小单次训练资源消耗,并可做分布式训练、维护。在神经辐射场训练过程中,针对室外无边界大场景,团队通过优化策略以提升该场景下的新视角生成效果,比如,通过在训练中同时优化位姿提高重建精度、基于哈希编码的层次化表达提升模型训练速度、借助外观编码提升不同时间采集场景的外观一致性、借助mvs稠密深度信息提升几何精度等。

以团队同毫末智行合作为例,完成单路采集以及多路合并的NeRF重建,相关成果已在毫末AI Day发布。

大场景多趟3D重建

虚实融合,提升用户体验

为提升用户沉浸式体验,火山引擎多媒体实验室自研虚实融合技术,将环境实拍全景图与场景模型进行对齐、融合。 团队利用先进的人工智能技术,建立全景图图像特征与模型关键点的匹配关系,通过PnP算法以及光束法平差算法将全景图注册至场景模型坐标系,实现尺度、位置的统一,从而实现模型渲染与实拍全景视频渲染的统一,达到虚实融合的效果。

同时,为扩大用户体验的自由度,团队针对该场景自研非球面天空盒渲染,克服传统的球面全景图渲染仅在图像采集中心视觉一致的缺陷,进一步提升实拍全景图渲染模型与地形模型的匹配程度,以实现更大运动范围的视觉一致性,进一步提升沉浸式体验。