7月5日,自然语言处理(NLP)领域顶级学术会议ACL(The Association for Computational Linguistics:国际计算语言学协会)公布了本届会议的最佳论文,字节跳动火山翻译团队的论文《Vocabulary Learning via Optimal Transport for Neural Machine Translation》获此殊荣。

ACL是国际自然语言处理领域的顶会,每年夏天的ACL会议不仅会吸引世界各大知名科研机构的注意,也是全球主要科技公司的关注焦点。

本届 ACL 共计收到 3350 篇论文投稿,最终有 21.3% 的论文录用到主会(Main Conference),并额外接收了 14.9% 的论文到 Findings 子刊,综合录用率为 36.2%。其中仅评出一篇最佳论文,是整场会议的最高奖项。

ACL 2021 的最佳论文来自字节跳动火山翻译团队,该研究提出了一种新的词表学习方案 VOLT,在多种翻译任务上取得了优秀的结果。

- 论文地址:

https://arxiv.org/pdf/2012.15671.pdf

- 代码地址:

https://github.com/Jingjing-NLP/VOLT

对于从业者来说,大家无时无刻不在使用词表对语言进行向量化表示。在深度学习时代,词表构建基本上是所有自然语言处理任务的第一步工作。尽管现今也有了一些比较通用的词表处理方法,但是仍然没有办法回答最基础的问题:什么是最优词表,如何生成最优词表?

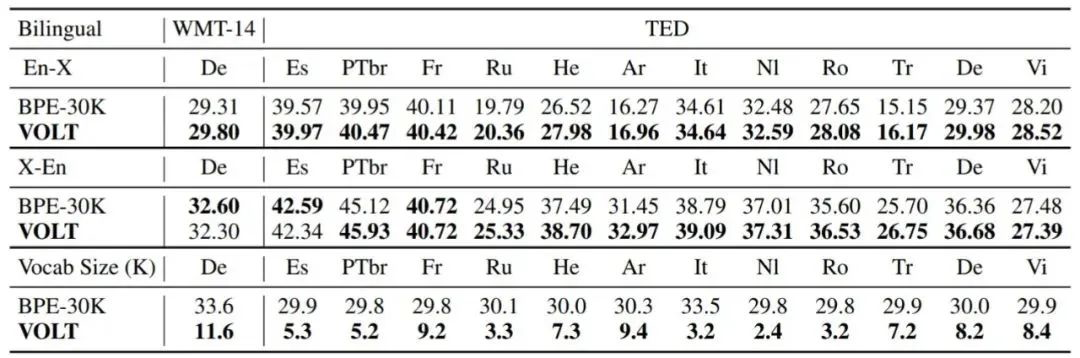

为了回答该问题,本论文尝试提出一种无需训练的词表评价指标和针对该评价指标的词表学习方案 VOLT。该方案在常用的英德翻译、低资源翻译、多语言翻译上都取得了相比传统词表解决方案更好的结果。

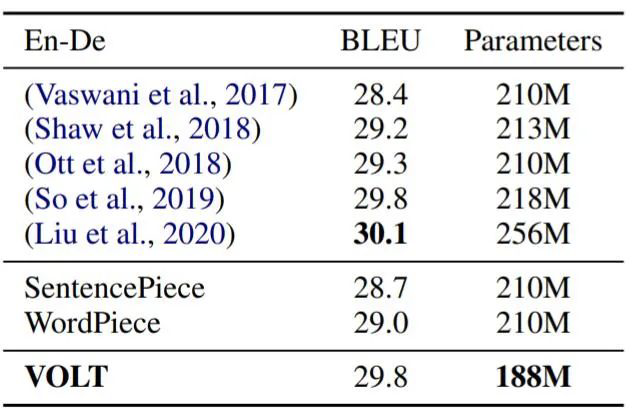

使用 VOLT 生成词汇,简单的基线方法就能够逼近 SOTA (SOTA:State Of The Art,当前最高水平)。该研究在 En-De 数据集上测试了 VOLT 和其他几种方法的性能,结果如表 2 所示。与其他方法相比,VOLT 以更少的词汇量实现了几乎最佳的性能。这些结果表明,简单的基线方法使用定义明确的词表就能够获得良好的结果。

然而之前的词表粒度和词表大小都是由经验性决定的。此外,经验的发现一般集中在常用的数据上。新数据或者新语言去找到这些经验知识往往需要大量的时间成本和计算成本。本项技术的优点在于可以快速给不同语言找到匹配的词表粒度和大小,对多语言翻译,稀有语对翻译有很重要的应用价值。

除了以上提及的VOLT技术外,火山翻译团队的一系列NLP的相关研究,已经成功应用于火山翻译,为抖音、今日头条、飞书、西瓜视频等产品提供更好的翻译服务。

(点击“LightSeq”即可跳转至相关文章),

NeurST

地址:https://github.com/bytedance/neurst

GLAT

地址:https://arxiv.org/abs/2008.07905

火山翻译团队中的每一个人都在为“让翻译更简单”而努力着,我们相信,随着更多前沿技术的研发和落地,“无障碍沟通”将不再是神话。