6月28日,2023火山引擎V-Tech体验创新科技峰会上,火山引擎正式发布“火山方舟”大模型服务平台。火山引擎智能算法负责人、火山方舟负责人吴迪以《绽放·共赢,“火山方舟”大模型平台启航》为主题进行演讲,深度阐释了火山引擎大模型理念,解读“火山方舟”的功能特点,为模型提供方以及模型使用方带来全新价值。

大模型百花齐放,“火山方舟”启航

这一轮由大模型、大算力带来的技术变革,让更多人看到了无限可能。这种变革的影响是巨大的,大模型将渗透到千行百业,变革人机交互界面,影响人们获取和处理信息、学习和掌握知识的习惯,最终深刻影响行业格局。同时,B端大模型供给将长期呈现百花齐放的面貌,创造大量的商业价值。

大模型的算力消耗由三个部分组成:

第一部分是大模型的提供商和研究机构,将为各行业提供极具竞争力的通用基座模型或垂直模型;

第二部分是大量颇具技术能力的公司,一方面会保持自研自用的模型训练投入,另一方面也会调用若干商用模型,落地到业务的不同场景;

第三部分是以大模型应用为主的各行各业,他们会把大模型能力深入到诸多细分场景,在提升自身经营效率的同时,把大模型的能力渗透到我们生活的方方面面。

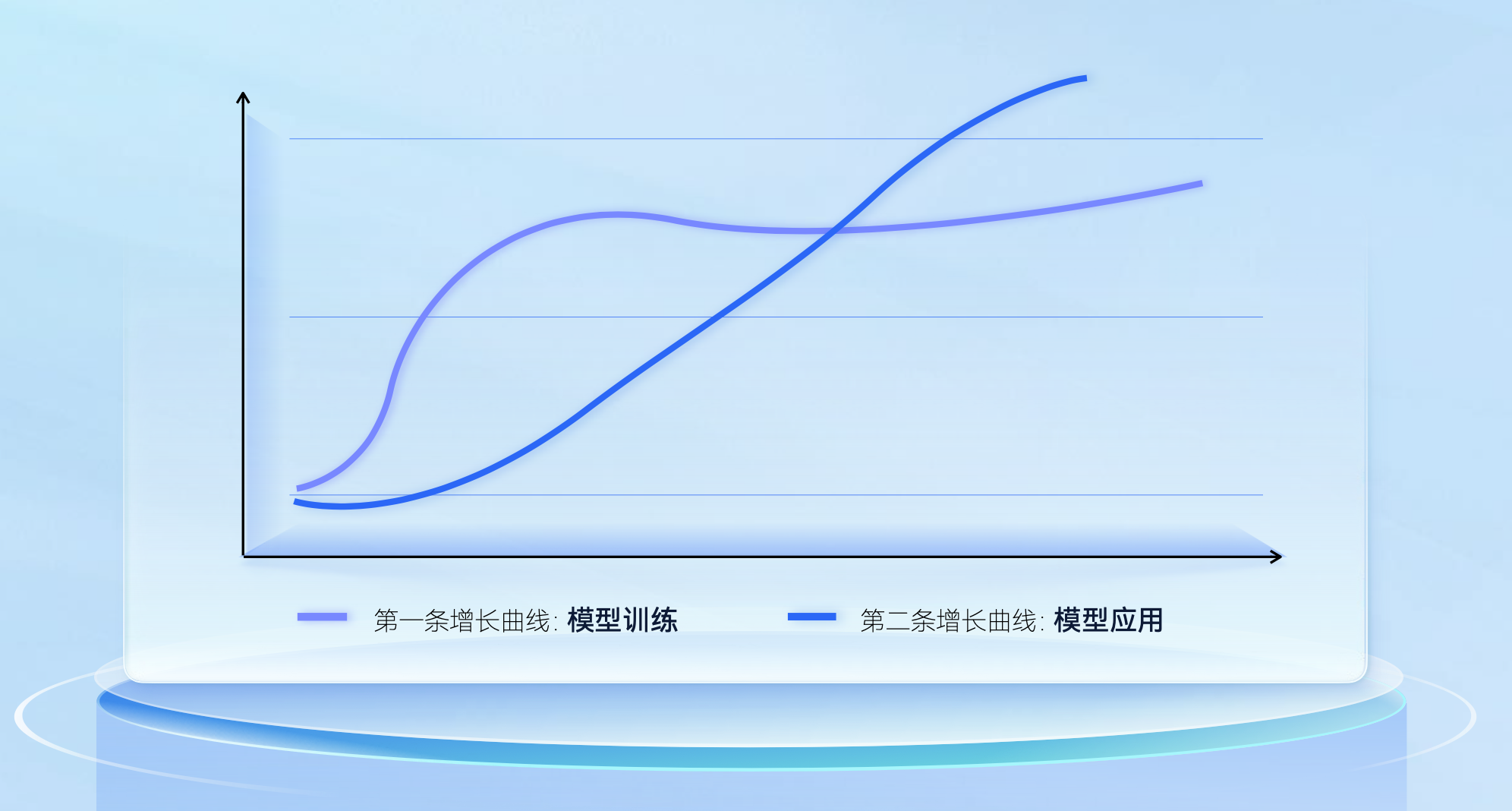

大模型即将出现第二条增长曲线

上面的曲线图体现了对未来趋势的判断,横坐标是时间,从今天开始向后展望2-3年,纵坐标是国内的机器学习算力消耗。今天,以预训练为代表的第一条增长曲线快速攀升,代表了大模型创业者勇攀高峰的决心和对前景的期待,这条曲线需要通过第二条曲线的持续攀升来转化现实。畅想一下,也许到了2024年的秋天之后,以推理为主的大模型应用消耗将超过届时预训练消耗60%,并且在2025年某个时刻超过预训练的整体算力消耗。

“火山方舟”加速大模型市场正向循环

大模型市场生机勃勃,火山引擎希望能够加速这个进程,推动大模型在千行百业更快形成生产力。火山引擎推出大模型服务平台“火山方舟”,致力于帮助千行百业更容易地获取模型,更放心地使用模型,更高效地打造应用, 在模型提供方和模型使用方之间促进研究、训练、应用、变现、反哺研究地正向循环。

模型提供方可以通过平台以更低的成本触达海量客户,用更小的代价在ToB市场规模化。基于严谨的安全互信机制,兼顾灵活性和安全性。同时,火山引擎技术团队将持续提供性能优化的方案,带来最具竞争力的性价比。

模型使用方可以通过统一的工作流对接多家模型提供方,为不同业务场景选择最合适的模型。此外,“火山方舟”和火山引擎机器学习平台是一个有机的整体,数据集管理、模型训练、模型迭代与大基座模型的应用被紧密融合和衔接在一起。此外,火山引擎的算法、解决方案和交付团队也将持续协助客户,把平台用好,做好大模型落地。

“火山方舟”由多个核心部分构成,平台的行动路线设计符合大模型应用的工作习惯,并融入了火山引擎对用好大模型的理解。

模型广场, 模型提供方提供了不同版本、不同尺寸的模型,客户可以直接与其交互,获得直观体验。也可直接调用推理API,接入生产环境。这是一条敏捷的短链路,适合进行快速分析和业务A/B实验,让算法工程师和业务团队不断缩短从新想法到试一试的距离。

模型评估, 用好大模型首先要确定业务需求,并为之设计一套可量化的评估指标。在不断对比、评估、试验的过程中,积累评估数据。快速迭代,为多样化的业务场景挑选不同的、最合适的模型。

模型精调, 对于一些要求较高的垂直场景,客户可能需要利用自有数据或领域的非公开数据进行持续训练,并且建设和积累自己的精调数据集,同一条精调数据集对多个基座模型同时发起精调任务,同时进行自动化评估,精调的效果和运行指标均能在平台实时跟踪。 对于精调良好的运用,小模型在特定工作上的表现可能接近通用大模型的水平,由此也可以进一步降低推理成本。

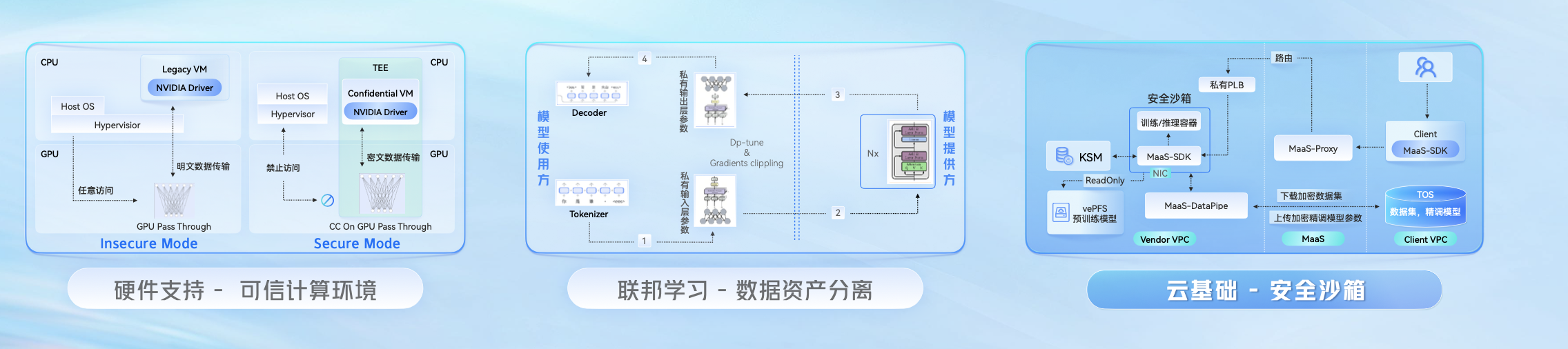

三类互信技术,促进互信共赢

大模型实践的模型提供方和使用方有可能是分离的,之前的CV/NLP模型以企业自产自销为主,但大的基座模型,包括语言、视频、音频模型等,并非每一个客户都能凭借自身力量做到最好,且由于大模型的训练成本高昂,对模型资产的保护变得迫切和重要。此外,模型客户与大模型的一切交互都需要进行严格保护。

火山引擎对数据资产的处理原则,是在双方数据资产汇聚的地方满足严格的可用、不可见要求,包括模型的查询服务和利用客户数据精调后的模型,当双方合作关系告一段落之后,这些将被就地销毁。火山引擎在促进双方互信共赢过程中发挥重要作用,并通过三类互信技术推动大模型进一步发展。

“火山方舟”三类互信技术推动大模型落地

安全沙箱, 通过计算隔离、存储隔离、加密、私有的逻辑通信链路以及共同的流量审计,确保安全沙箱只能向模型使用方传递response,杜绝任何人进入沙箱或从沙箱中向外泄露数据的可能性。

硬件支持, 未来将基于硬件的可信计算环境进行方案加固,其中既有结合CPU的TEE技术,也有基于英伟达H800、H100的可信计算技术。

联邦学习**,** 经过多年发展的联邦学习技术将在大模型领域发挥重要价值,其主要通过对数据资产的拆分来获取大模型提供方和使用方的信任。模型使用方和提供方之间,传递的是机器学习的中间结果。这一技术火山引擎还在与合作伙伴进行进一步的研究。

持续优化,推动大模型应用落地

在大模型时代,用云和上云将会为企业带来重要优势。火山引擎为大模型的推理提供了高可靠保障、企业级的负载均衡和容错能力。 随着平台的不断迭代,对大模型的资源供应将趋向弹性、动态和性价比,而火山引擎利用流量错峰、训推一体等手段,能够进一步降低推理的单位成本。同时,火山引擎还将与大模型提供方联合进行深度优化,分享共创诸多量化、batching、调度等优化技术。

当然,这些优化在推向市场前,已经利用众多内部场景打磨与改进。抖音集团内部已有十多个业务团队探索、接入、试用“火山方舟”,覆盖文本和图像生成、对话、代码辅助、信息检索、营销创意、电商、办公效率等场景。 当然,深度学习是一个纯粹、完整、紧凑的实践。 “火山方舟”和火山机器学习平台紧密地衔接在一起,这使得模型训练、编排、优化、迭代这些流程,与大模型的体验、评估、推理形成了一个整体。

让大模型具备行动能力是应用落地的重要环节。 吴迪表示,大语言模型将成为类似中央处理器的枢纽,火山引擎未来不仅能够提供优秀、丰富的CPU,还将把整个“主板”制造出来。

首先是插件,基于基座模型的理解能力和规划能力,配合适当的工具链,今天,很多大模型已经具备操作插件和接口的能力。“火山方舟”将提供大量插件,并且会为各插件配套一个数据集,来告诉不同基座模型如何正确地与之交互。

其次是领域模型的微服务网络,在未来通用基座模型将更好地完成多模态任务,但目前来看,领域模型和大语言模型将需要密切配合,以完成一些复杂工作。因此在“火山方舟”平台上将构建一个由领域模型组成的微服务网络,内置包括图像分割、语音识别等众多专业模型,供中央处理器随时调用。

技术在飞速发展, 模型和工具链层出不穷。 “火山方舟”希望能够帮助模型使用方做好核心重要的事情,以不变应万变,紧追时代趋势。 “火山方舟”也将努力帮助模型提供方更快地触达海量客户,降低规模化ToB过程中的开销和成本。同时, 信任和安全也是“火山方舟”密切关注的事情,一个可依赖的环境会促成更多合作,激发模型应用的创造力。最后,希望由于“火山方舟”的存在,大算力、大模型能够更早、更充分地渗透到各行各业, 塑造一个百花齐放的未来。